¿Quieres que la IA "piense antes de responder" como un humano? El modo Gemini Thinking es la última función de razonamiento profundo lanzada por Google, que permite al modelo mostrar su proceso completo de pensamiento antes de entregar una respuesta. En este artículo, explicaremos detalladamente cómo configurar correctamente el modo Gemini Thinking en dos de los clientes de IA más populares: Cherry Studio y Chatbox.

Valor central: Al terminar de leer este artículo, habrás aprendido a habilitar el modo de pensamiento de Gemini en Cherry Studio y Chatbox, visualizar el proceso de razonamiento del modelo y mejorar los resultados en tareas complejas.

Puntos clave del modo Gemini Thinking

El modo Gemini Thinking es una función de razonamiento profundo introducida por Google en los modelos de las series Gemini 2.5 y 3. A diferencia de una conversación convencional, el modo Thinking permite que el modelo realice un razonamiento interno antes de proporcionar la respuesta final, lo que mejora significativamente la precisión en tareas complejas.

| Punto clave | Descripción | Valor |

|---|---|---|

| Visualización del pensamiento | Muestra el proceso de razonamiento del modelo | Permite entender cómo la IA llega a sus conclusiones |

| Razonamiento mejorado | Razonamiento lógico en múltiples pasos | Ideal para resolver problemas matemáticos y de programación complejos |

| Profundidad controlable | Ajuste del presupuesto de tokens de pensamiento | Equilibra la velocidad de respuesta con la precisión |

| Compatibilidad de modelos | Disponible para toda la serie Gemini 2.5/3 | Flexibilidad para elegir según el escenario de uso |

Modelos compatibles con el modo Gemini Thinking

Actualmente, los modelos Gemini que soportan el modo Thinking son los siguientes:

| Nombre del modelo | ID del modelo | Parámetro de pensamiento | Comportamiento predeterminado |

|---|---|---|---|

| Gemini 3 Pro | gemini-3-pro-preview |

thinking_level | Pensamiento dinámico (HIGH) |

| Gemini 3 Flash | gemini-3-flash-preview |

thinking_level | Pensamiento dinámico (HIGH) |

| Gemini 2.5 Pro | gemini-2.5-pro |

thinking_budget | Dinámico (8192 tokens) |

| Gemini 2.5 Flash | gemini-2.5-flash |

thinking_budget | Dinámico (-1) |

| Gemini 2.5 Flash-Lite | gemini-2.5-flash-lite |

thinking_budget | Desactivado por defecto (0) |

🎯 Sugerencia técnica: En entornos de uso real, recomendamos utilizar la plataforma APIYI (apiyi.com) para llamar a los modelos Gemini Thinking de forma unificada. Esta plataforma ofrece una interfaz compatible con el formato de OpenAI, eliminando la necesidad de gestionar los complejos procesos de autenticación de la API de Google.

Detalle de los parámetros de la API del modo Gemini Thinking

Las diferentes versiones de los modelos Gemini utilizan distintos parámetros para controlar el pensamiento:

Serie Gemini 3 – Parámetro thinking_level

| Nivel | Descripción | Escenario de aplicación |

|---|---|---|

minimal |

Pensamiento mínimo | Preguntas y respuestas simples |

low |

Pensamiento bajo | Conversaciones cotidianas |

medium |

Pensamiento medio | Razonamiento general |

high |

Pensamiento profundo (predeterminado) | Tareas complejas |

Serie Gemini 2.5 – Parámetro thinking_budget

| Valor | Descripción | Escenario de aplicación |

|---|---|---|

0 |

Desactivar pensamiento | Respuesta rápida |

-1 |

Pensamiento dinámico (recomendado) | Ajuste automático |

128-32768 |

Número de tokens específico | Control de precisión |

Configuración del modo Gemini Thinking en Cherry Studio

Cherry Studio es un potente cliente de IA compatible con más de 300 modelos y diversos proveedores de IA. A continuación, te presentamos los pasos detallados para configurar el modo Gemini Thinking en Cherry Studio.

Paso 1: Agregar el proveedor de API de Gemini

- Abre Cherry Studio y ve a Configuración → Proveedores (Providers).

- Busca Gemini o Proveedor personalizado.

- Introduce la información de configuración de la API:

Dirección API: https://api.apiyi.com/v1

Clave API: Tu clave de APIYI

💡 Consejo de configuración: Al usar APIYI (apiyi.com) como dirección de API, obtendrás un acceso más estable y un formato de interfaz unificado.

Paso 2: Agregar los modelos Gemini Thinking

Haz clic en el botón "Gestionar" o "Añadir" en la parte inferior para agregar manualmente los siguientes modelos:

| Nombre del modelo a añadir | Descripción |

|---|---|

gemini-3-pro-preview |

Gemini 3 Pro (Versión Thinking) |

gemini-3-flash-preview |

Gemini 3 Flash (Versión Thinking) |

gemini-2.5-pro |

Gemini 2.5 Pro (Versión Thinking) |

gemini-2.5-flash |

Gemini 2.5 Flash (Versión Thinking) |

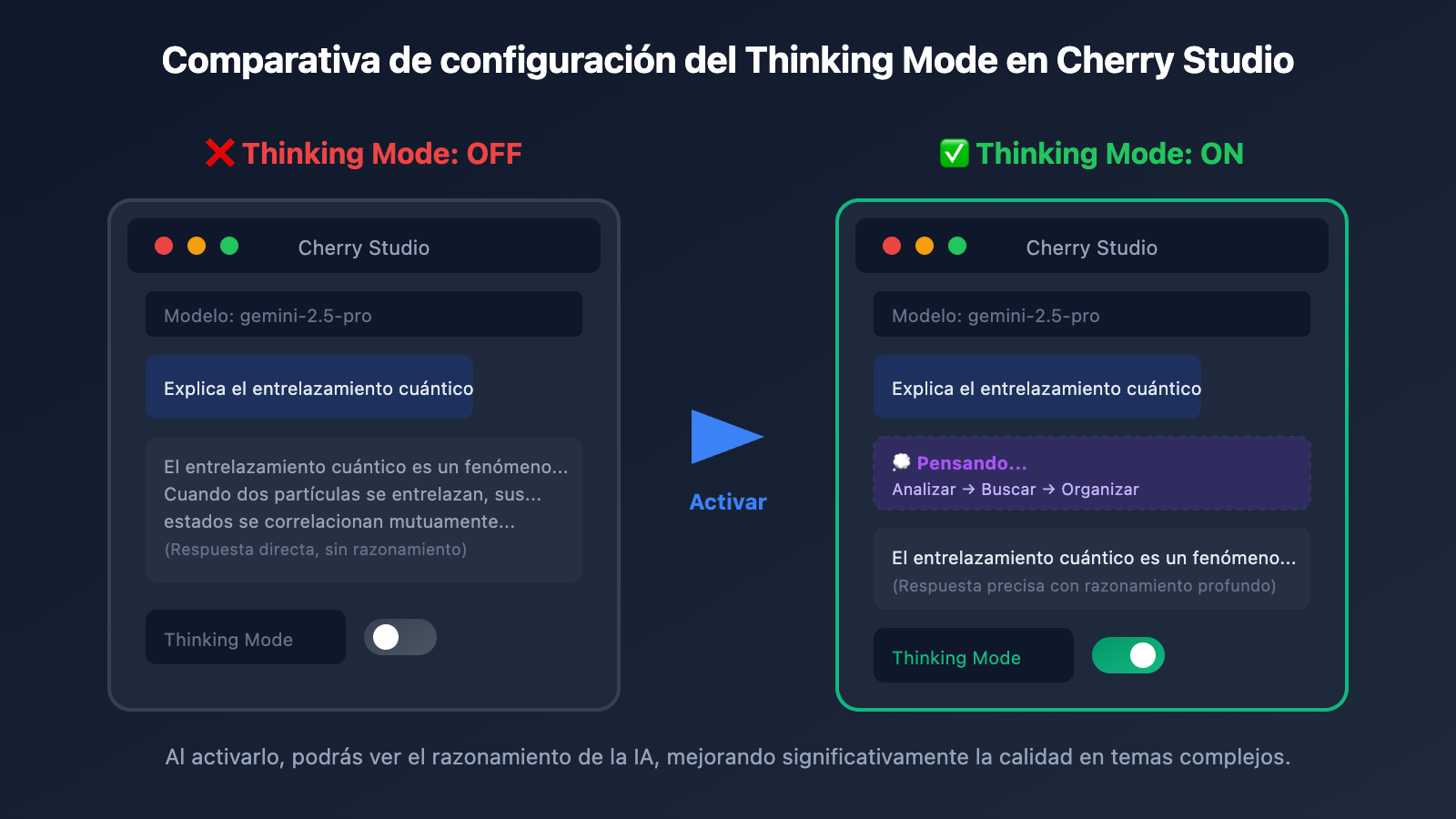

Paso 3: Activar el interruptor de Thinking Mode

En la interfaz de chat:

- Haz clic en el icono de configuración en la esquina superior derecha.

- Busca la opción Thinking Mode.

- Cambia el interruptor a ON.

Configuración de parámetros personalizados en Cherry Studio

Si el interruptor de la interfaz no surte efecto, deberás configurar manualmente los parámetros personalizados:

Para modelos Gemini 3:

{

"generationConfig": {

"thinkingConfig": {

"thinkingLevel": "high",

"includeThoughts": true

}

}

}

Para modelos Gemini 2.5:

{

"generationConfig": {

"thinkingConfig": {

"thinkingBudget": -1,

"includeThoughts": true

}

}

}

Pega la configuración JSON anterior en la sección de Parámetros personalizados (Custom Parameters) de Cherry Studio.

Ver explicación detallada de la captura de configuración

Pasos detallados de configuración:

- Abrir ajustes del modelo: Haz clic en el nombre del modelo en la parte superior del cuadro de diálogo.

- Entrar en ajustes avanzados: Desplázate hasta la sección de "Parámetros personalizados".

- Pegar el JSON: Copia la configuración JSON correspondiente al modelo que usas.

- Guardar y probar: Envía un mensaje para verificar que se muestra el proceso de pensamiento.

Solución de problemas comunes:

- Asegúrate de que el formato JSON sea correcto y no sobren comas.

- Confirma que el nombre del modelo coincida con la configuración.

- Verifica que tu clave API sea válida.

🚀 Inicio rápido: Te recomendamos usar la plataforma APIYI (apiyi.com) para obtener tu clave API. Es compatible con toda la serie de modelos Gemini y su configuración es mucho más sencilla.

Configuración del modo Gemini Thinking en Chatbox

Chatbox es otro cliente de escritorio de IA muy popular, con una interfaz sencilla y soporte multiplataforma. Aquí te explicamos cómo configurar el modo Gemini Thinking en Chatbox.

Paso 1: Configurar el proveedor de API

- Abre Chatbox y haz clic en Ajustes (o Configuración) en la esquina inferior izquierda.

- Selecciona Proveedor de modelo → Personalizado.

- Configura la información de la API:

Nombre: Gemini Thinking

Tipo de API: OpenAI Compatible

Host de la API: https://api.apiyi.com

Clave API: sk-your-apiyi-key

Paso 2: Seleccionar el modelo de razonamiento (Thinking)

En el selector de modelos, escribe o selecciona:

gemini-3-pro-preview– Máxima capacidad de razonamientogemini-2.5-pro– Equilibrio entre rendimiento y costogemini-2.5-flash– Respuesta rápida

Paso 3: Configurar parámetros de pensamiento

Chatbox permite configurar el modo de pensamiento a través de Extra Parameters (Parámetros adicionales):

{

"thinking_config": {

"thinking_level": "high"

}

}

O usa thinking_budget:

{

"thinking_config": {

"thinking_budget": 8192

}

}

Ajustes de visualización del proceso de pensamiento en Chatbox

Por defecto, Chatbox colapsa el proceso de pensamiento, pero puedes ajustar cómo se muestra:

| Opción | Función | Valor recomendado |

|---|---|---|

| Mostrar proceso de pensamiento | Expandir/colapsar contenido del pensamiento | Activado |

| Estilo del proceso | Bloque independiente/en línea | Bloque independiente |

| Colapso automático | Ocultar automáticamente pensamientos largos | Activado |

Ver ejemplo de código de configuración para Chatbox

# Configura Gemini Thinking usando el SDK de OpenAI

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

response = client.chat.completions.create(

model="gemini-2.5-pro",

messages=[

{"role": "user", "content": "Por favor, explica por qué 1+1=2"}

],

extra_body={

"thinking_config": {

"thinking_budget": 8192,

"include_thoughts": True

}

}

)

# Imprimir el proceso de pensamiento y la respuesta

print(response.choices[0].message.content)

Mejores prácticas para el modo Gemini Thinking

Configuración de la profundidad de pensamiento según el escenario

| Escenario de uso | Modelo recomendado | Configuración de pensamiento | Descripción |

|---|---|---|---|

| Demostración matemática | gemini-3-pro-preview | thinking_level: high | Requiere razonamiento riguroso |

| Depuración de código | gemini-2.5-pro | thinking_budget: 16384 | Análisis de lógica compleja |

| Preguntas y respuestas cotidianas | gemini-2.5-flash | thinking_budget: -1 | Adaptación dinámica |

| Respuesta rápida | gemini-2.5-flash-lite | thinking_budget: 0 | Desactivar pensamiento |

| Redacción de artículos | gemini-3-flash-preview | thinking_level: medium | Equilibrio entre creatividad y eficiencia |

Sugerencias de presupuesto de Tokens de Pensamiento (Thinking Tokens)

Problemas simples: 0-1024 tokens

Razonamiento general: 1024-4096 tokens

Tareas complejas: 4096-16384 tokens

Razonamiento extremo: 16384-32768 tokens

💡 Sugerencia de selección: La profundidad de pensamiento adecuada depende principalmente de la complejidad de la tarea. Recomendamos realizar pruebas reales en la plataforma APIYI (apiyi.com) para encontrar la configuración que mejor se adapte a tu caso. Esta plataforma soporta todos los modelos Gemini Thinking, lo que facilita comparar resultados rápidamente.

Comparativa: Modo Normal vs. Modo Thinking

| Dimensión de comparación | Modo Normal | Modo Thinking |

|---|---|---|

| Velocidad de respuesta | Rápida (1-3 seg) | Más lenta (3-10 seg) |

| Profundidad de razonamiento | Superficial | Profundo y multipaso |

| Consumo de tokens | Bajo | Medio-Alto |

| Precisión (tareas complejas) | 60-70% | 85-95% |

| Explicabilidad | Baja | Alta (se puede ver el pensamiento) |

| Escenarios de uso | Preguntas simples | Tareas de razonamiento complejo |

Preguntas frecuentes

Q1: ¿Por qué Cherry Studio no muestra el proceso de pensamiento tras activar el interruptor de Thinking Mode?

Este es un problema conocido. Es posible que el interruptor de la interfaz (UI) de algunos proveedores no surta efecto, por lo que es necesario añadir manualmente la configuración JSON en los «Parámetros personalizados»:

{

"generationConfig": {

"thinkingConfig": {

"thinkingLevel": "high",

"includeThoughts": true

}

}

}

Asegúrate de que includeThoughts esté configurado como true, ya que es el parámetro clave para mostrar el proceso de pensamiento. Al realizar llamadas a través de la plataforma APIYI apiyi.com, el retorno del resumen del pensamiento ya viene activado por defecto.

Q2: ¿Cuál es la diferencia entre los parámetros de Gemini 2.5 y Gemini 3?

Ambas series utilizan parámetros distintos para controlar el modo de pensamiento:

- Serie Gemini 3: Utiliza el parámetro

thinkingLevel, con los valores: minimal/low/medium/high. - Serie Gemini 2.5: Utiliza el parámetro

thinkingBudget, con un valor numérico entre 0 y 32768.

No se deben mezclar estos parámetros, de lo contrario la API devolverá un error. Se recomienda realizar las llamadas a través de la interfaz unificada de APIYI apiyi.com, donde la plataforma se encarga de gestionar automáticamente la compatibilidad de los parámetros.

Q3: ¿Cuánto consumo de tokens adicional genera el modo Thinking?

Los tokens de pensamiento (Thinking Tokens) se facturan por separado. Tomando como ejemplo Gemini 2.5 Pro:

- Presupuesto de pensamiento por defecto: 8192 tokens.

- Presupuesto de pensamiento máximo: 32768 tokens.

El consumo real depende de la complejidad de la tarea. Para preguntas sencillas, el modelo podría usar solo unos pocos cientos de tokens de pensamiento; para problemas complejos, podría agotar todo el presupuesto. Configurar thinkingBudget: -1 permite que el modelo se autorregule, lo cual es la opción con mejor relación calidad-precio.

Q4: ¿Cómo puedo obtener solo el resumen del pensamiento y no el proceso completo?

Al configurar includeThoughts: true en la llamada a la API, lo que se devuelve es un resumen del pensamiento en lugar de los tokens internos completos del proceso. El resumen es más conciso y adecuado para mostrarse en la interfaz de usuario. Por el momento, el proceso de pensamiento completo no está abierto al público.

Q5: ¿Qué tipo de tareas son más adecuadas para el modo Thinking?

El modo Thinking es especialmente útil para tareas que requieren un razonamiento de varios pasos:

- Demostraciones matemáticas y cálculos complejos.

- Depuración de código y diseño de algoritmos.

- Razonamiento lógico y análisis de problemas.

- Planificación estratégica y análisis de decisiones.

Para tareas sencillas como consultas de información, traducciones o resúmenes, no es necesario activar el modo Thinking, ya que solo aumentaría la latencia y el costo.

Resumen

El modo Gemini Thinking es una herramienta potente para potenciar la capacidad de razonamiento de los Modelos de Lenguaje Grande. A través de este tutorial de configuración, has aprendido a:

- Comprender los principios del modo Thinking: Dominar la diferencia entre los parámetros

thinking_levelythinking_budget. - Configuración en Cherry Studio: Activar el modo de pensamiento mediante el interruptor de la interfaz o mediante parámetros JSON personalizados.

- Configuración en Chatbox: Utilizar los "Extra Parameters" para configurar los parámetros de pensamiento.

- Mejores prácticas: Seleccionar la profundidad de pensamiento adecuada según la complejidad de la tarea.

Te recomendamos utilizar APIYI apiyi.com para validar rápidamente los efectos del modo Gemini Thinking. La plataforma ofrece una interfaz unificada compatible con OpenAI, soporte para todos los modelos de las series Gemini 2.5 y 3, una configuración más sencilla y un acceso más estable.

Referencias

-

Documentación oficial de Google Gemini Thinking: Descripción completa de los parámetros de la API

- Enlace:

ai.google.dev/gemini-api/docs/thinking

- Enlace:

-

Documentación oficial de Cherry Studio: Guía de configuración del cliente

- Enlace:

docs.cherry-ai.com

- Enlace:

-

Lista de modelos de Gemini: Lista de modelos compatibles con Thinking

- Enlace:

ai.google.dev/gemini-api/docs/models

- Enlace:

Autor: Equipo de APIYI

Soporte técnico: Para obtener la API de Gemini o realizar consultas técnicas, visita APIYI apiyi.com