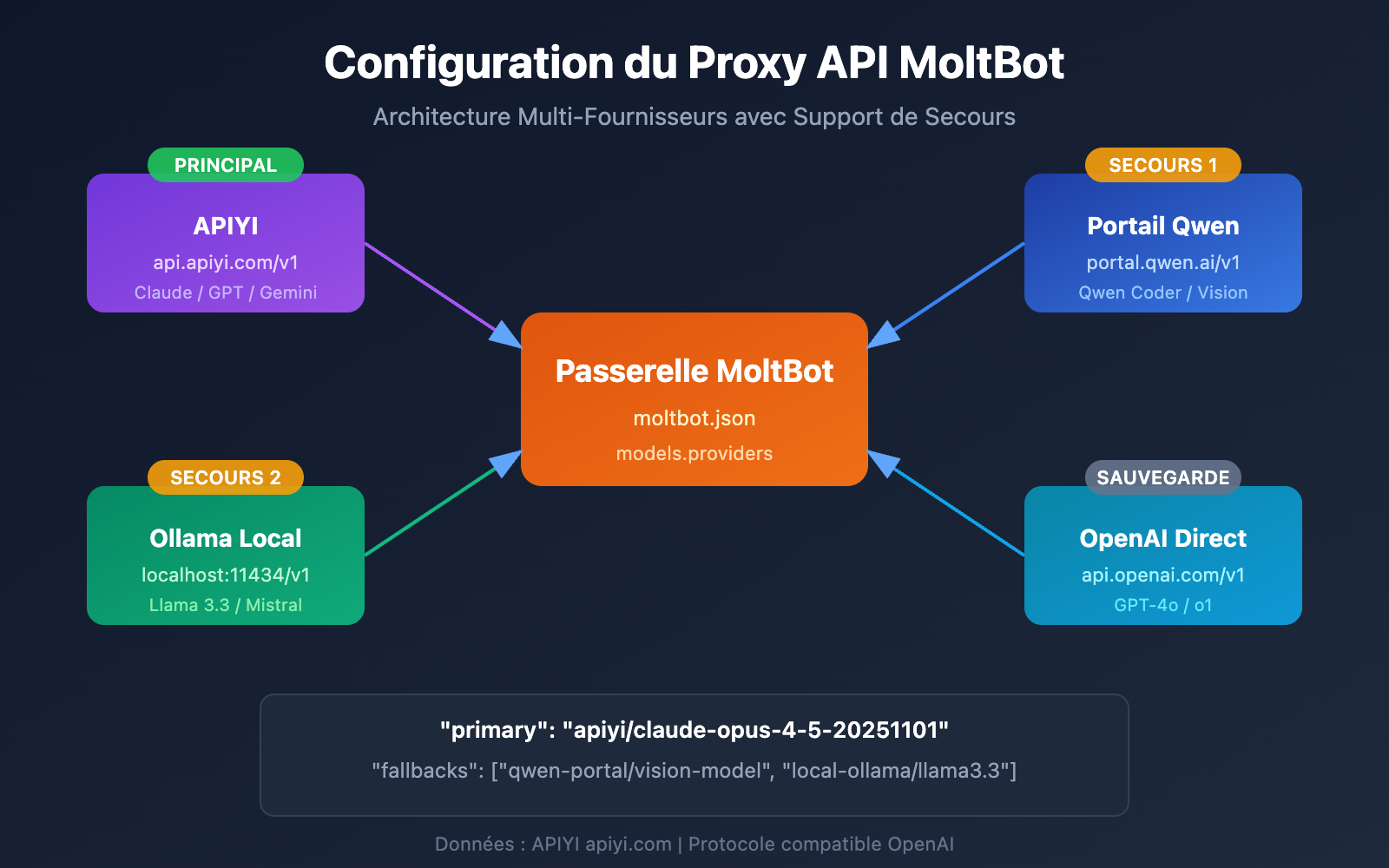

Vous souhaitez connecter MoltBot à Claude Opus 4.5 ou à d'autres grands modèles de langage, mais vous ne savez pas comment configurer le proxy API ? Cet article va vous guider pas à pas pour réussir la configuration multi-fournisseurs (Multi-Provider) de MoltBot. Vous apprendrez à connecter votre assistant IA à plusieurs services de modèles simultanément, tout en profitant du basculement intelligent et de la redondance.

Valeur ajoutée : En lisant cet article, vous maîtriserez la méthode de configuration models.providers de MoltBot. Vous saurez comment définir un modèle principal, des modèles de secours (fallback) et des alias de modèles pour créer un assistant IA stable et fiable.

Configuration du proxy API MoltBot : Analyse des concepts clés

MoltBot permet de se connecter à presque tous les services de grands modèles de langage via une API compatible OpenAI. Comprendre les concepts suivants est essentiel pour réussir votre configuration.

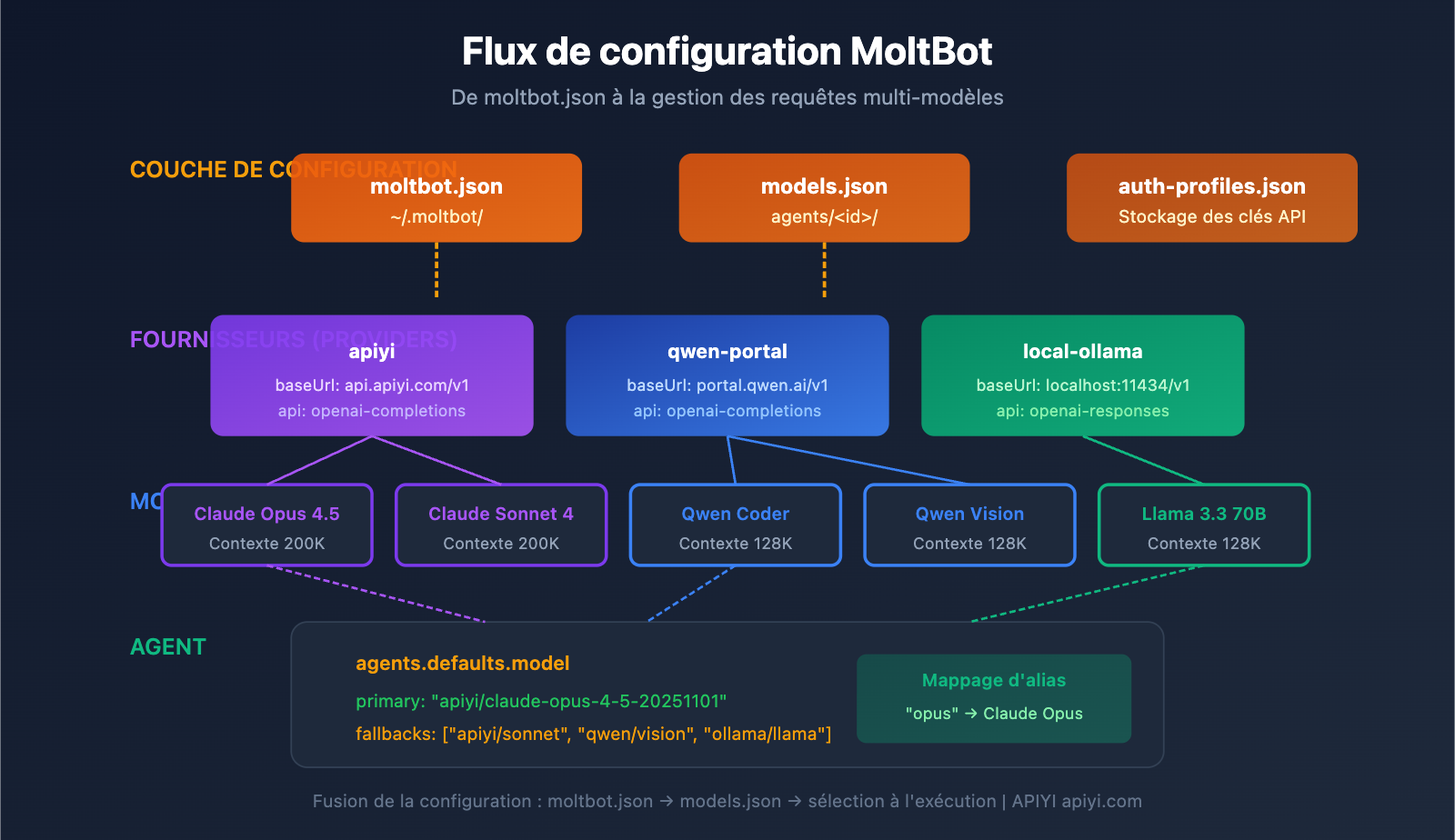

Système de fichiers de configuration de MoltBot

| Fichier de configuration | Emplacement | Utilisation |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

Point d'entrée de la configuration globale |

| models.json | ~/.moltbot/agents/<agentId>/ |

Configuration des modèles par Agent |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

Stockage des informations d'authentification |

Champs essentiels de la configuration Provider de MoltBot

Chaque configuration de fournisseur (Provider) contient les champs clés suivants :

| Champ | Type | Description | Obligatoire |

|---|---|---|---|

baseUrl |

string | Adresse du point de terminaison (endpoint) API | Oui |

apiKey |

string | Clé API (supporte les variables d'environnement) | Oui |

api |

string | Type de protocole API | Oui |

models |

array | Liste des modèles disponibles | Oui |

Explication des types de protocoles API

MoltBot supporte deux protocoles principaux compatibles OpenAI :

| Type de protocole | Description | Scénario d'utilisation |

|---|---|---|

openai-completions |

API Chat Completions standard | La plupart des services de proxy |

openai-responses |

API Responses (incluant l'appel d'outils) | Modèles locaux, scénarios avancés |

🎯 Conseil de configuration : La plupart des services de proxy API (comme APIYI apiyi.com) utilisent le protocole

openai-completions. Si vous utilisez une installation locale de LM Studio ou d'Ollama, vous devrez utiliseropenai-responses.

Configuration multi-Provider MoltBot : Exemple complet

Voici un exemple concret de configuration multi-provider, connectant simultanément les services APIYI et Qwen Portal :

Exemple complet de fichier de configuration

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

Détails de la structure de configuration

1. Section models.providers

C'est la partie centrale pour définir les services de proxy API :

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- ID du Provider (

apiyi) : Identifiant de service personnalisé, utilisé pour les références ultérieures. - baseUrl : Point de terminaison (endpoint) de l'API, doit impérativement se terminer par

/v1. - apiKey : Prend en charge la saisie directe de la clé ou l'utilisation de variables d'environnement via

${ENV_VAR}. - models : La liste des modèles pris en charge par ce fournisseur.

2. Section agents.defaults.model

Définit le modèle utilisé par défaut et la stratégie de secours (failover) :

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary : Le modèle principal, au format

provider-id/model-id. - fallbacks : Un tableau de modèles de secours. Le système bascule automatiquement dessus si le modèle principal échoue.

3. Section agents.defaults.models

Définit des alias pour les modèles, afin de faciliter le basculement rapide :

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

Une fois les alias configurés, vous pouvez utiliser la commande /model opus directement dans la conversation pour changer rapidement de modèle.

Configuration du proxy API MoltBot : tutoriel pas à pas

Étape 1 : Obtenir votre clé API

Avant de commencer la configuration, vous devez préparer votre clé API :

| Fournisseur | Comment l'obtenir | Modèles pris en charge |

|---|---|---|

| APIYI | S'inscrire sur apiyi.com | Séries Claude, GPT, Gemini, etc. |

| Qwen Portal | Visiter portal.qwen.ai | Modèles de la série Qwen |

| OpenAI | Visiter platform.openai.com | Série GPT |

| Anthropic | Visiter console.anthropic.com | Série Claude |

🚀 Démarrage rapide : Nous recommandons d'utiliser APIYI (apiyi.com) comme fournisseur principal. Une seule clé API suffit pour appeler les modèles majeurs comme Claude, GPT et Gemini, sans avoir à s'inscrire sur plusieurs plateformes.

Étape 2 : Configurer les variables d'environnement

Par mesure de sécurité, il est conseillé de stocker vos clés API dans des variables d'environnement :

# Linux/macOS - Ajouter à ~/.bashrc ou ~/.zshrc

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# Appliquer la configuration

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

Étape 3 : Éditer le fichier de configuration

Ouvrez ou créez le fichier de configuration MoltBot :

# Ouvrir le fichier de configuration

nano ~/.moltbot/moltbot.json

# Ou utiliser VS Code

code ~/.moltbot/moltbot.json

Copiez et collez la configuration suivante dans le fichier :

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

Étape 4 : Valider la configuration

Redémarrez MoltBot et vérifiez que la configuration est bien prise en compte :

# Redémarrer MoltBot

moltbot restart

# Vérifier la configuration actuelle des modèles

moltbot models list

# Tester un appel au modèle

moltbot chat "Bonjour, quel modèle es-tu ?"

Voir l’exemple complet d’une configuration multi-fournisseurs

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 Astuce de configuration : Utiliser

"mode": "merge"permet de conserver les configurations de modèles intégrées à MoltBot tout en ajoutant vos fournisseurs personnalisés. Ainsi, même si un service personnalisé est indisponible, le système peut revenir à la configuration par défaut.

Configuration des modèles MoltBot : détails des paramètres avancés

Champs complets d'une entrée de modèle

| Paramètre | Type | Requis | Description | Exemple |

|---|---|---|---|---|

id |

string | Oui | ID du modèle, utilisé lors des appels | claude-opus-4-5-20251101 |

name |

string | Oui | Nom d'affichage | Claude Opus 4.5 |

contextWindow |

number | Non | Taille de la fenêtre contextuelle | 200000 |

maxTokens |

number | Non | Nombre maximum de tokens en sortie | 32000 |

reasoning |

boolean | Non | Prise en charge du mode raisonnement | true |

input |

array | Non | Types d'entrées supportés | ["text", "image"] |

cost |

object | Non | Informations sur les coûts | {"input": 15, "output": 75} |

Configuration des paramètres du modèle (params)

Vous pouvez définir des paramètres par défaut pour chaque modèle dans agents.defaults.models :

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| Paramètre | Plage | Description |

|---|---|---|

temperature |

0-2 | Contrôle le caractère aléatoire de la sortie ; plus elle est basse, plus le résultat est déterministe |

maxTokens |

1-limite du modèle | Longueur maximale d'une seule sortie |

⚠️ Attention :

temperatureest un paramètre avancé. À moins que vous ne connaissiez les paramètres par défaut du modèle et que vous ayez réellement besoin de les ajuster, il est recommandé de ne pas y toucher.

Configuration de basculement (Fallback) MoltBot

Le mécanisme de Fallback est une fonctionnalité essentielle de MoltBot, garantissant que votre assistant IA reste toujours disponible.

Fonctionnement du Fallback

Requête utilisateur

↓

Modèle principal (primary)

↓ (Échec)

Modèle de secours 1 (fallbacks[0])

↓ (Échec)

Modèle de secours 2 (fallbacks[1])

↓ (Échec)

... Continuer les tentatives

Stratégies de configuration Fallback recommandées

| Stratégie | Exemple de configuration | Cas d'utilisation |

|---|---|---|

| Rétrogradation de gamme | Opus → Sonnet → Haiku | Maintenir la cohérence du style |

| Sauvegarde multiplateforme | Claude → GPT → Gemini | Disponibilité maximale |

| Optimisation des coûts | Opus → Modèle local | Contrôle des frais |

| Stratégie hybride | Cloud → Local → Secours Cloud | Approche globale |

Configuration recommandée :

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 Optimisation des coûts : En configurant le Fallback via APIYI (apiyi.com), vous pouvez basculer automatiquement entre plusieurs modèles tout en bénéficiant d'une facturation unifiée, ce qui facilite grandement la gestion des coûts.

Changement de modèle MoltBot : Astuces pratiques

Utiliser des alias pour un changement rapide

Une fois les alias configurés, vous pouvez changer de modèle à tout moment au cours d'une conversation :

Vous : /model opus

MoltBot : Passage au modèle Claude Opus 4.5

Vous : /model sonnet

MoltBot : Passage au modèle Claude Sonnet 4

Vous : /model qwen

MoltBot : Passage au modèle Qwen Coder

Assigner un modèle pour une tâche spécifique

Vous : /model gpt Aide-moi à analyser cette image

MoltBot : [Analyse de l'image en cours avec GPT-4o...]

Vous : /model opus Écris un article technique approfondi

MoltBot : [Rédaction en cours avec Claude Opus...]

Consulter l'état du modèle actuel

# Via la ligne de commande

moltbot models list

# Pendant une conversation

Vous : /model

MoltBot : Modèle actuel : apiyi/claude-opus-4-5-20251101 (alias : opus)

Configuration du proxy API MoltBot : Foire aux questions

Q1 : Que faire si le message « API Key invalid » s’affiche après la configuration ?

Il s'agit généralement d'un problème de configuration de la clé API. Vérifiez les points suivants :

- Confirmez que la variable d'environnement est correctement définie :

echo $APIYI_API_KEY - Vérifiez que le format de la clé API est correct (elle commence généralement par

sk-) - Assurez-vous que la clé API dispose d'un solde suffisant et des permissions nécessaires

- Si vous l'avez écrite directement dans le fichier de configuration, vérifiez qu'il n'y a pas d'espaces ou de sauts de ligne superflus

Le format des clés API obtenues via APIYI (apiyi.com) est sk-xxx, veillez à les copier intégralement.

Q2 : Comment utiliser simultanément des modèles locaux et des modèles cloud ?

L'utilisation de la configuration "mode": "merge" permet d'utiliser à la fois des modèles locaux et cloud :

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

De cette façon, si le modèle local n'est pas disponible, le système peut automatiquement basculer (Fallback) vers le service cloud.

Q3 : Que faire si la variable d’environnement ${VAR} ne fonctionne pas ?

Règles de remplacement des variables d'environnement de MoltBot :

- Ne correspond qu'aux lettres majuscules et aux tirets bas :

[A-Z_][A-Z0-9_]* - Le nom de la variable doit être entièrement en majuscules, comme

${APIYI_API_KEY} - Les noms de variables en minuscules comme

${apiKey}ne seront pas remplacés - Une variable d'environnement non définie entraînera une erreur de chargement de la configuration

Il est conseillé d'utiliser un nommage standard : APIYI_API_KEY, QWEN_API_KEY, TELEGRAM_BOT_TOKEN

Q4 : Comment utiliser différents modèles pour différentes tâches ?

C'est possible via imageModel et les alias :

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- Les tâches textuelles utilisent automatiquement le modèle

primary(Claude Opus) - Les tâches d'image utilisent automatiquement l'

imageModel(GPT-4o) - Vous pouvez également basculer manuellement avec la commande

/model vision

Q5 : Quels services compatibles avec OpenAI sont pris en charge ?

MoltBot prend en charge tous les services respectant les spécifications de l'API OpenAI :

| Type de service | Exemple | Recommandation |

|---|---|---|

| Proxy API | APIYI (apiyi.com) | Recommandé (accès unifié multi-modèles) |

| API Officielles | OpenAI, Anthropic, Google | Stabilité officielle |

| Déploiement local | Ollama, LM Studio, vLLM | Priorité à la confidentialité |

| Autres proxys | Groq, Together AI | Selon les besoins |

L'avantage d'APIYI (apiyi.com) est qu'une seule clé suffit pour appeler les modèles de plusieurs fournisseurs, sans avoir à s'inscrire séparément partout.

Configuration du proxy API MoltBot : Résumé et conseils

Grâce à cet article, vous maîtrisez désormais la méthode complète pour configurer un proxy API dans MoltBot :

- Comprendre la structure de configuration :

models.providersdéfinit les services,agents.defaultsdéfinit la stratégie d'utilisation. - Configurer plusieurs fournisseurs : Connectez plusieurs services API simultanément pour augmenter la disponibilité.

- Configurer le Fallback : Basculez automatiquement vers un modèle de secours en cas d'échec du modèle principal.

- Utiliser les alias : Changez rapidement de modèle via la commande

/model alias.

Conseils de bonnes pratiques

| Conseil | Explication |

|---|---|

| Utiliser des variables d'environnement | Ne stockez pas vos clés API en clair dans le fichier de configuration. |

| Configurer un Fallback | Définissez au moins 1 ou 2 modèles de secours. |

| Régler mode : merge | Conservez la configuration par défaut pour renforcer la compatibilité. |

| Unifier l'accès API | Utilisez APIYI pour simplifier la gestion multi-modèles. |

Nous vous recommandons d'utiliser APIYI (apiyi.com) comme principal service de proxy API. Cette plateforme offre un accès unifié aux modèles majeurs comme Claude, GPT et Gemini. La configuration est simple et supporte des modes de facturation flexibles, ce qui est particulièrement adapté au scénario de basculement multi-modèles de MoltBot.

Ressources

-

Documentation officielle de MoltBot – Models : Détails de la configuration des modèles

- Lien :

docs.molt.bot/concepts/models - Description : Guide officiel de configuration des modèles

- Lien :

-

Documentation officielle de MoltBot – Configuration : Référence complète de configuration

- Lien :

docs.molt.bot/gateway/configuration - Description : Détails de toutes les options de configuration

- Lien :

-

Documentation officielle de MoltBot – Model Providers : Configuration des fournisseurs

- Lien :

docs.molt.bot/concepts/model-providers - Description : Méthode de configuration des fournisseurs personnalisés

- Lien :

-

GitHub de MoltBot : Code source et discussions sur les issues

- Lien :

github.com/moltbot/moltbot - Description : Dernière version et retours sur les problèmes

- Lien :

Auteur de cet article : Équipe APIYI | Pour plus de partages techniques sur l'IA, visitez APIYI apiyi.com

Date de mise à jour : Janvier 2026