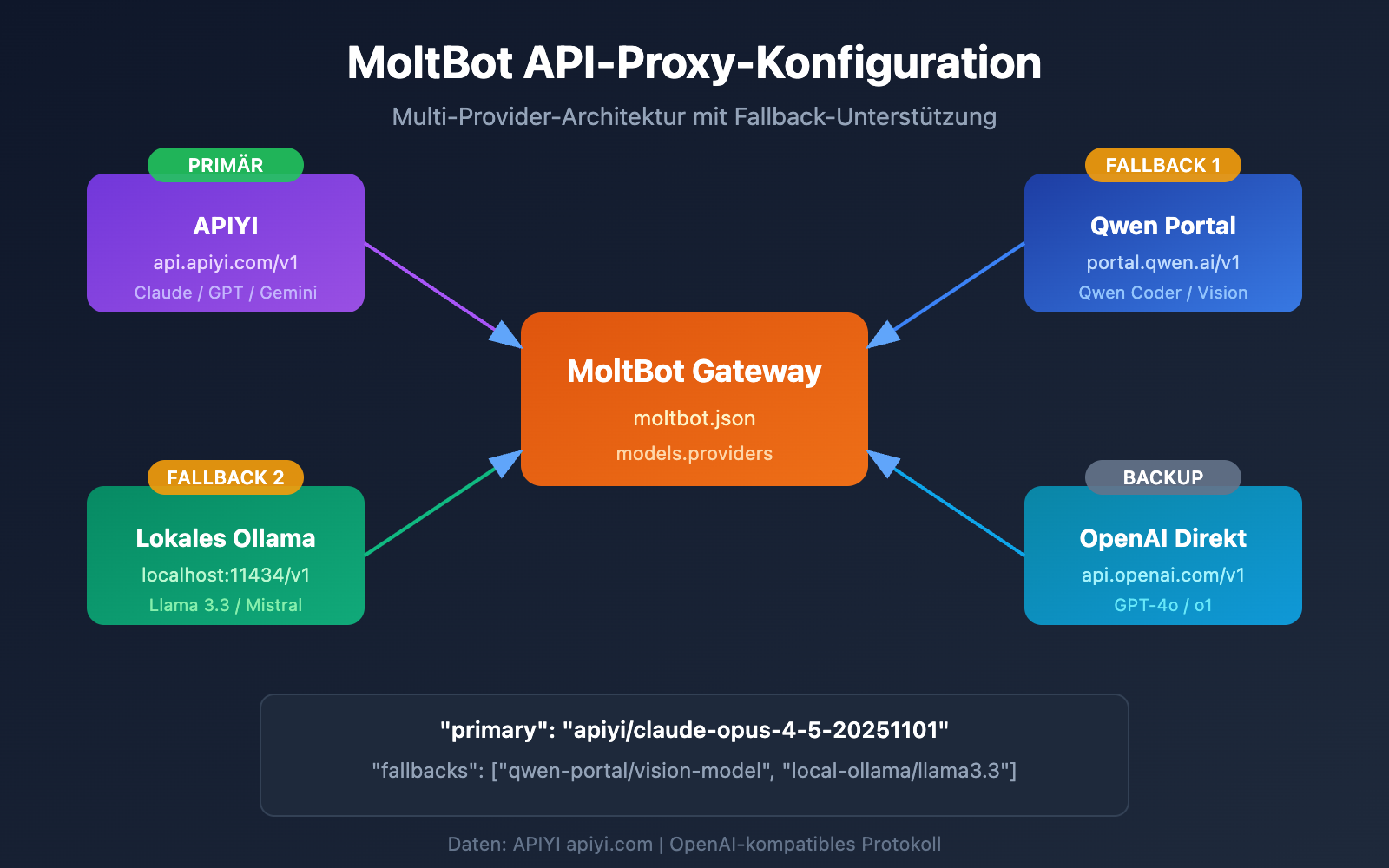

Möchten Sie MoltBot mit Claude Opus 4.5 oder anderen Großen Sprachmodellen verbinden, wissen aber nicht, wie Sie den API-Proxy konfigurieren sollen? In diesem Artikel zeige ich Ihnen Schritt für Schritt, wie Sie die MoltBot Multi-Provider-Konfiguration einrichten, damit Ihr AI-Assistent gleichzeitig auf mehrere Modelldienste zugreifen kann – für intelligentes Umschalten und Ausfallsicherheit.

Kernnutzen: Nach der Lektüre dieses Artikels werden Sie die models.providers-Konfiguration von MoltBot beherrschen. Sie lernen, Primärmodelle, Fallback-Modelle und Modell-Aliase einzurichten, um einen stabilen und zuverlässigen AI-Assistenten aufzubauen.

MoltBot API-Proxy-Konfiguration: Analyse der Kernkonzepte

MoltBot unterstützt die Anbindung an fast alle gängigen Großen Sprachmodelle über eine OpenAI-kompatible API. Das Verständnis der folgenden Kernkonzepte ist entscheidend für eine erfolgreiche Konfiguration.

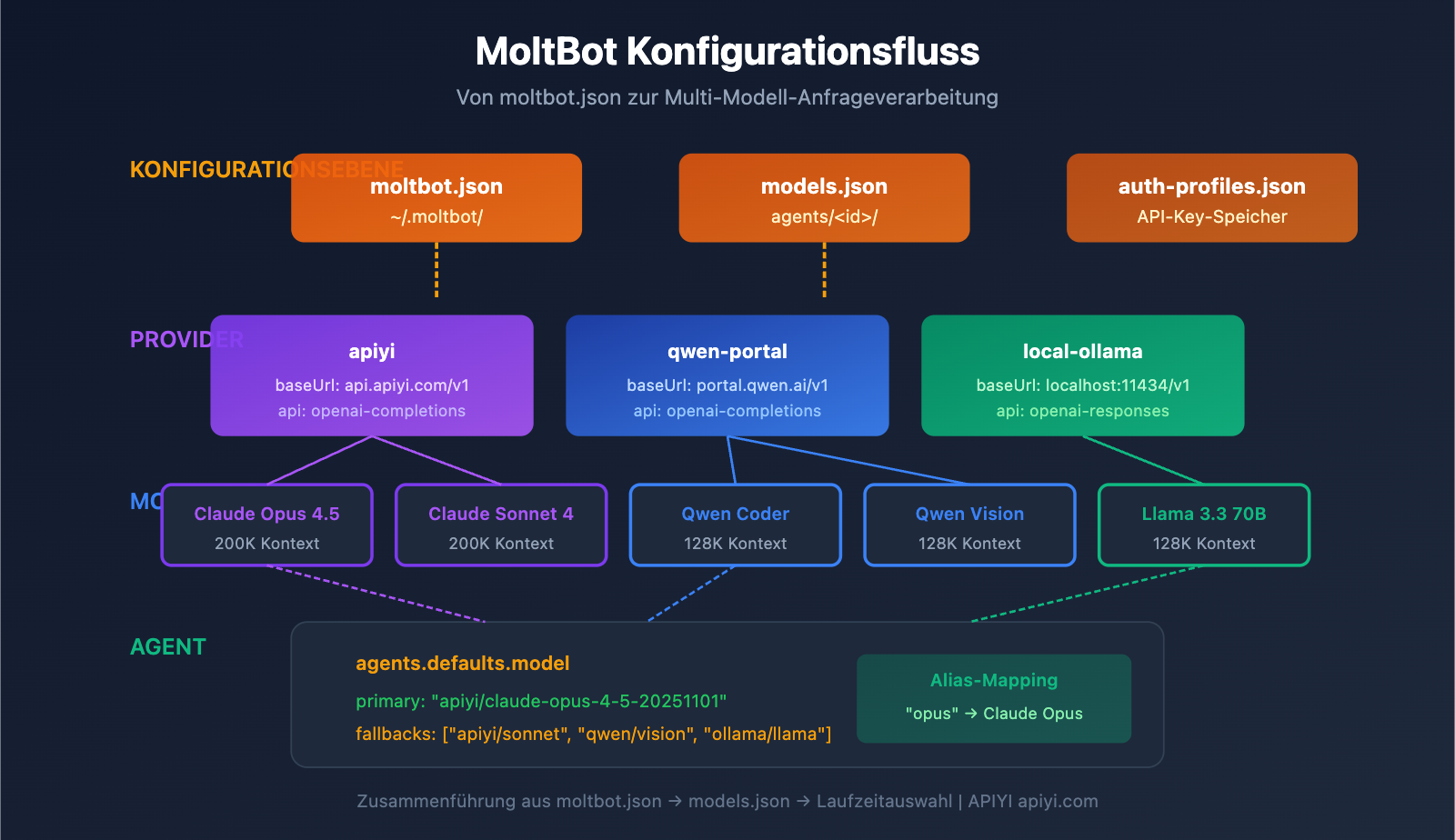

MoltBot Konfigurationssystem

| Konfigurationsdatei | Pfad | Verwendungszweck |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

Globaler Konfigurationseinstieg |

| models.json | ~/.moltbot/agents/<agentId>/ |

Modellkonfiguration auf Agent-Ebene |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

Speicherung von Authentifizierungsinformationen |

MoltBot Provider-Konfiguration: Kernfelder

Jede Provider-Konfiguration enthält die folgenden wichtigen Felder:

| Feld | Typ | Beschreibung | Erforderlich |

|---|---|---|---|

baseUrl |

string | API-Endpunkt-Adresse | Ja |

apiKey |

string | API-Key (unterstützt Umgebungsvariablen) | Ja |

api |

string | API-Protokolltyp | Ja |

models |

array | Liste der verfügbaren Modelle | Ja |

Erläuterung der API-Protokolltypen

MoltBot unterstützt zwei gängige OpenAI-kompatible Protokolle:

| Protokolltyp | Beschreibung | Anwendungsszenario |

|---|---|---|

openai-completions |

Standard Chat Completions API | Die meisten Proxy-Dienste |

openai-responses |

Responses API (inkl. Tool-Aufrufe) | Lokale Modelle, fortgeschrittene Szenarien |

🎯 Konfigurationsempfehlung: Die meisten API-Proxy-Dienste (wie APIYI apiyi.com) verwenden das

openai-completions-Protokoll. Wenn Sie ein lokal bereitgestelltes LM Studio oder Ollama verwenden, müssen Sieopenai-responsesnutzen.

Hier ist ein praxisnahes Beispiel für eine Multi-Provider-Konfiguration, die gleichzeitig die Dienste von APIYI und dem Qwen Portal einbindet:

Beispiel einer vollständigen Konfigurationsdatei

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

Details zur Konfigurationsstruktur

1. Der Bereich models.providers

Dies ist das Kernstück zur Definition der API-Proxy-Dienste:

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- Provider ID (

apiyi): Ein benutzerdefinierter Bezeichner für den Dienst, der später zur Referenzierung verwendet wird. - baseUrl: Der API-Endpunkt; dieser muss zwingend auf

/v1enden. - apiKey: Unterstützt die direkte Eingabe oder die Verwendung von

${ENV_VAR}Umgebungsvariablen. - models: Die Liste der von diesem Provider unterstützten Modelle.

2. Der Bereich agents.defaults.model

Hier werden das Standardmodell und die Failover-Strategie (Ausfallsicherung) definiert:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary: Das Hauptmodell im Format

provider-id/model-id. - fallbacks: Ein Array von Ersatzmodellen, auf die automatisch umgeschaltet wird, falls das Hauptmodell fehlschlägt.

3. Der Bereich agents.defaults.models

Definiert Modell-Aliase für einen schnellen Wechsel:

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

Nachdem Aliase konfiguriert wurden, können Sie im Chat den Befehl /model opus nutzen, um das Modell blitzschnell zu wechseln.

MoltBot API-Proxy-Konfiguration: Schritt-für-Schritt-Anleitung

Schritt 1: API-Key erhalten

Bevor Sie mit der Konfiguration beginnen, müssen Sie Ihre API-Keys bereithalten:

| Anbieter | Bezugsweg | Unterstützte Modelle |

|---|---|---|

| APIYI | Registrierung unter apiyi.com | Claude-Serie, GPT-Serie, Gemini usw. |

| Qwen Portal | Besuch von portal.qwen.ai | Qwen-Modellserie |

| OpenAI | Besuch von platform.openai.com | GPT-Serie |

| Anthropic | Besuch von console.anthropic.com | Claude-Serie |

🚀 Schnellstart: Es wird empfohlen, APIYI (apiyi.com) als Haupt-Provider zu verwenden. Mit einem einzigen API-Key können Sie gängige Modelle wie Claude, GPT und Gemini aufrufen, ohne sich auf mehreren Plattformen einzeln registrieren zu müssen.

Schritt 2: Umgebungsvariablen festlegen

Aus Sicherheitsgründen wird empfohlen, API-Keys in Umgebungsvariablen zu speichern:

# Linux/macOS - Zu ~/.bashrc oder ~/.zshrc hinzufügen

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# Konfiguration anwenden

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

Schritt 3: Konfigurationsdatei bearbeiten

Öffnen oder erstellen Sie die MoltBot-Konfigurationsdatei:

# Konfigurationsdatei öffnen

nano ~/.moltbot/moltbot.json

# Oder mit VS Code öffnen

code ~/.moltbot/moltbot.json

Kopieren Sie die folgende Konfiguration in die Datei:

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

Schritt 4: Konfiguration überprüfen

Starten Sie MoltBot neu und überprüfen Sie, ob die Konfiguration übernommen wurde:

# MoltBot neu starten

moltbot restart

# Aktuelle Modellkonfiguration prüfen

moltbot models list

# Modellaufruf testen

moltbot chat "Hallo, bitte sag mir, welches Modell du bist."

Vollständiges Beispiel für eine Konfiguration mit mehreren Providern anzeigen

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 Konfigurations-Tipp: Mit

"mode": "merge"können Sie die integrierten Modellkonfigurationen von MoltBot beibehalten und gleichzeitig Ihre eigenen Provider hinzufügen. So kann das System auf Standardkonfigurationen zurückgreifen, falls Ihre benutzerdefinierten Dienste nicht verfügbar sind.

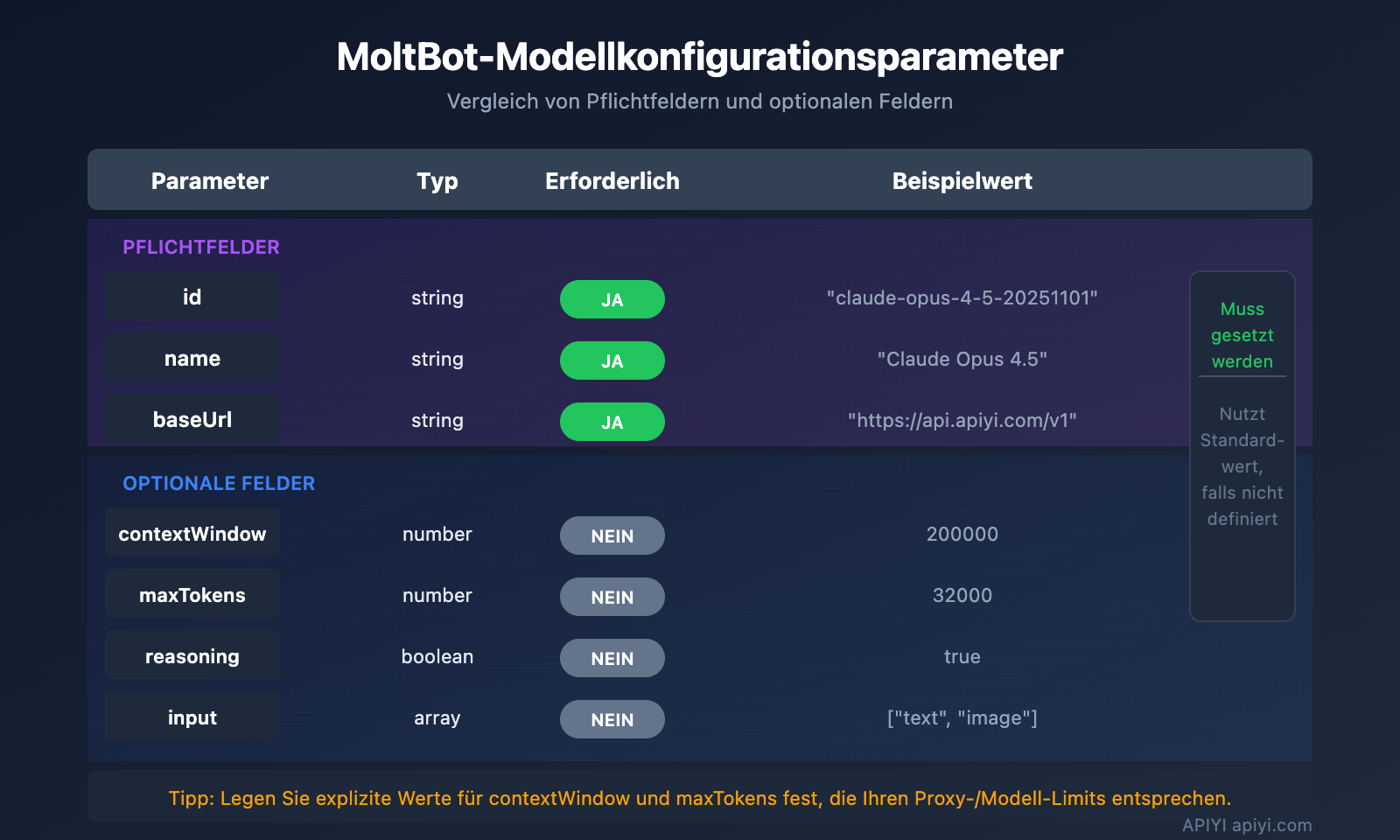

MoltBot-Modellkonfiguration: Fortgeschrittene Parameter im Detail

Vollständige Felder für Modelleinträge

| Parameter | Typ | Erforderlich | Beschreibung | Beispiel |

|---|---|---|---|---|

id |

string | Ja | Modell-ID, die beim Aufruf verwendet wird | claude-opus-4-5-20251101 |

name |

string | Ja | Anzeigename des Modells | Claude Opus 4.5 |

contextWindow |

number | Nein | Größe des Kontextfensters | 200000 |

maxTokens |

number | Nein | Maximale Anzahl an Ausgabe-Token | 32000 |

reasoning |

boolean | Nein | Gibt an, ob der Denkmodus unterstützt wird | true |

input |

array | Nein | Unterstützte Eingabetypen | ["text", "image"] |

cost |

object | Nein | Kosteninformationen | {"input": 15, "output": 75} |

Modellparameter-Konfiguration (params)

In agents.defaults.models können Sie für jedes Modell Standardparameter festlegen:

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| Parameter | Bereich | Beschreibung |

|---|---|---|

temperature |

0-2 | Steuert die Zufälligkeit der Ausgabe; niedrigere Werte sind deterministischer. |

maxTokens |

1 bis Modell-Limit | Maximale Ausgabelänge pro Antwort. |

⚠️ Hinweis:

temperatureist ein fortgeschrittener Parameter. Sofern Sie die Standardeinstellungen des Modells nicht genau kennen und eine Anpassung wirklich notwendig ist, wird empfohlen, diesen Wert nicht manuell zu setzen.

MoltBot Fallback-Konfiguration für Ausfallsicherheit

Der Fallback-Mechanismus ist eine wichtige Funktion von MoltBot, die sicherstellt, dass der KI-Assistent jederzeit verfügbar bleibt.

So funktioniert Fallback

Benutzeranfrage

↓

Primärmodell (primary)

↓ (Fehlgeschlagen)

Backup-Modell 1 (fallbacks[0])

↓ (Fehlgeschlagen)

Backup-Modell 2 (fallbacks[1])

↓ (Fehlgeschlagen)

...weitere Versuche

Empfohlene Fallback-Strategien

| Strategie | Konfigurationsbeispiel | Anwendungsszenario |

|---|---|---|

| Serieninternes Downgrade | Opus → Sonnet → Haiku | Konsistenz im Stil beibehalten |

| Plattformübergreifendes Backup | Claude → GPT → Gemini | Maximale Verfügbarkeit |

| Kostenoptimierung | Opus → Lokales Modell | Kostenkontrolle |

| Hybrid-Strategie | Cloud → Lokal → Cloud-Backup | Umfassende Abwägung |

Empfohlene Konfiguration:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 Kostenoptimierung: Durch die Konfiguration von Fallbacks über APIYI apiyi.com können Sie automatisch zwischen mehreren Modellen wechseln und gleichzeitig von einer einheitlichen Abrechnung profitieren, was die Kostenkontrolle erleichtert.

MoltBot Modellwechsel: Praxistipps

Schneller Wechsel durch Aliase

Sobald Aliase konfiguriert sind, können Sie das Modell jederzeit während eines Gesprächs wechseln:

Du: /model opus

MoltBot: Umgeschaltet auf Claude Opus 4.5

Du: /model sonnet

MoltBot: Umgeschaltet auf Claude Sonnet 4

Du: /model qwen

MoltBot: Umgeschaltet auf Qwen Coder

Modelle für spezifische Aufgaben zuweisen

Du: /model gpt hilf mir, dieses Bild zu analysieren

MoltBot: [Analysiere Bild mit GPT-4o...]

Du: /model opus schreibe einen tiefgehenden technischen Artikel

MoltBot: [Schreibe mit Claude Opus...]

Aktuellen Modellstatus anzeigen

# In der Kommandozeile anzeigen

moltbot models list

# Im Chat anzeigen

Du: /model

MoltBot: Aktuelles Modell: apiyi/claude-opus-4-5-20251101 (Alias: opus)

MoltBot API-Proxy-Konfiguration: Häufig gestellte Fragen (FAQ)

Q1: Was tun, wenn nach der Konfiguration „API Key invalid“ angezeigt wird?

Dies deutet in der Regel auf ein Problem bei der API-Key-Konfiguration hin. Prüfen Sie bitte folgende Punkte:

- Stellen Sie sicher, dass die Umgebungsvariable korrekt gesetzt ist:

echo $APIYI_API_KEY - Überprüfen Sie, ob das Format des API-Keys korrekt ist (beginnt normalerweise mit

sk-) - Vergewissern Sie sich, dass der API-Key über ausreichendes Guthaben und die nötigen Berechtigungen verfügt

- Falls Sie den Key direkt in die Konfigurationsdatei geschrieben haben, prüfen Sie ihn auf überflüssige Leerzeichen oder Zeilenumbrüche

Der über APIYI (apiyi.com) bezogene API-Key hat das Format sk-xxx. Bitte stellen Sie sicher, dass Sie ihn vollständig kopiert haben.

Q2: Wie verwende ich lokale und Cloud-Modelle gleichzeitig?

Mit der Konfiguration "mode": "merge" können Sie sowohl lokale als auch Cloud-Modelle parallel nutzen:

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

Auf diese Weise kann automatisch ein Fallback auf den Cloud-Dienst erfolgen, falls das lokale Modell nicht verfügbar ist.

Q3: Was tun, wenn die Umgebungsvariable ${VAR} nicht funktioniert?

Für die Ersetzung von Umgebungsvariablen in MoltBot gelten folgende Regeln:

- Es werden nur Großbuchstaben und Unterstriche erkannt:

[A-Z_][A-Z0-9_]* - Variablennamen müssen komplett großgeschrieben werden, z. B.

${APIYI_API_KEY} - Kleingeschriebene Variablennamen wie

${apiKey}werden nicht ersetzt - Nicht gesetzte Umgebungsvariablen führen zu Fehlern beim Laden der Konfiguration

Wir empfehlen die Verwendung von Standard-Benennungen: APIYI_API_KEY, QWEN_API_KEY, TELEGRAM_BOT_TOKEN

Q4: Wie verwende ich unterschiedliche Modelle für verschiedene Aufgaben?

Dies lässt sich über imageModel und Aliase realisieren:

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- Textaufgaben nutzen automatisch das Primary-Modell (Claude Opus)

- Bildaufgaben nutzen automatisch das

imageModel(GPT-4o) - Sie können auch manuell mit

/model visionwechseln

Q5: Welche OpenAI-kompatiblen Dienste werden unterstützt?

MoltBot unterstützt alle Dienste, die dem OpenAI API-Standard entsprechen:

| Diensttyp | Beispiel | Empfehlung |

|---|---|---|

| API-Proxy | APIYI (apiyi.com) | Empfohlen (Zentraler Zugriff auf viele Modelle) |

| Offizielle API | OpenAI, Anthropic, Google | Offiziell & Stabil |

| Lokale Bereitstellung | Ollama, LM Studio, vLLM | Fokus auf Datenschutz |

| Andere Proxys | Groq, Together AI | Nach Bedarf |

Der Vorteil von APIYI (apiyi.com) ist, dass ein einziger Key ausreicht, um Modelle verschiedener Anbieter aufzurufen, ohne sich überall separat registrieren zu müssen.

MoltBot API-Proxy-Konfiguration: Zusammenfassung und Empfehlungen

In diesem Artikel haben Sie die vollständige Methode zur Konfiguration von API-Proxys in MoltBot kennengelernt:

- Konfigurationsstruktur verstehen:

models.providersdefiniert die Dienste,agents.defaultsdefiniert die Nutzungsstrategie. - Mehrere Provider einrichten: Binden Sie mehrere API-Dienste gleichzeitig ein, um die Verfügbarkeit zu erhöhen.

- Fallback konfigurieren: Automatischer Wechsel auf ein Ersatzmodell, falls das Hauptmodell ausfällt.

- Aliase verwenden: Schneller Modellwechsel über den Befehl

/model alias.

Best-Practice-Empfehlungen

| Empfehlung | Erläuterung |

|---|---|

| Umgebungsvariablen nutzen | Speichern Sie API-Keys niemals im Klartext in der Konfigurationsdatei. |

| Fallback konfigurieren | Richten Sie mindestens 1-2 Ersatzmodelle ein. |

| mode: merge einstellen | Behalten Sie die Standardkonfiguration bei, um die Kompatibilität zu erhöhen. |

| Zentraler API-Zugang | Nutzen Sie APIYI, um die Verwaltung mehrerer Modelle zu vereinfachen. |

Wir empfehlen APIYI (apiyi.com) als primären API-Proxy-Dienst. Die Plattform bietet einen einheitlichen Zugang zu gängigen Modellen wie Claude, GPT und Gemini. Die Konfiguration ist einfach, die Abrechnung flexibel und sie eignet sich hervorragend für die Multi-Modell-Szenarien von MoltBot.

Referenzen

-

MoltBot Offizielle Dokumentation – Models: Detaillierte Modellkonfiguration

- Link:

docs.molt.bot/concepts/models - Beschreibung: Offizieller Leitfaden zur Modellkonfiguration

- Link:

-

MoltBot Offizielle Dokumentation – Configuration: Vollständige Konfigurationsreferenz

- Link:

docs.molt.bot/gateway/configuration - Beschreibung: Detaillierte Erläuterung aller Konfigurationsoptionen

- Link:

-

MoltBot Offizielle Dokumentation – Model Providers: Provider-Konfiguration

- Link:

docs.molt.bot/concepts/model-providers - Beschreibung: Methoden zur Konfiguration benutzerdefinierter Provider

- Link:

-

MoltBot GitHub: Quellcode und Issue-Diskussionen

- Link:

github.com/moltbot/moltbot - Beschreibung: Neueste Versionen und Feedback zu Problemen

- Link:

Autor dieses Artikels: APIYI Team | Für weiteren Austausch über KI-Technologie besuchen Sie gerne APIYI apiyi.com

Aktualisierungsdatum: Januar 2026