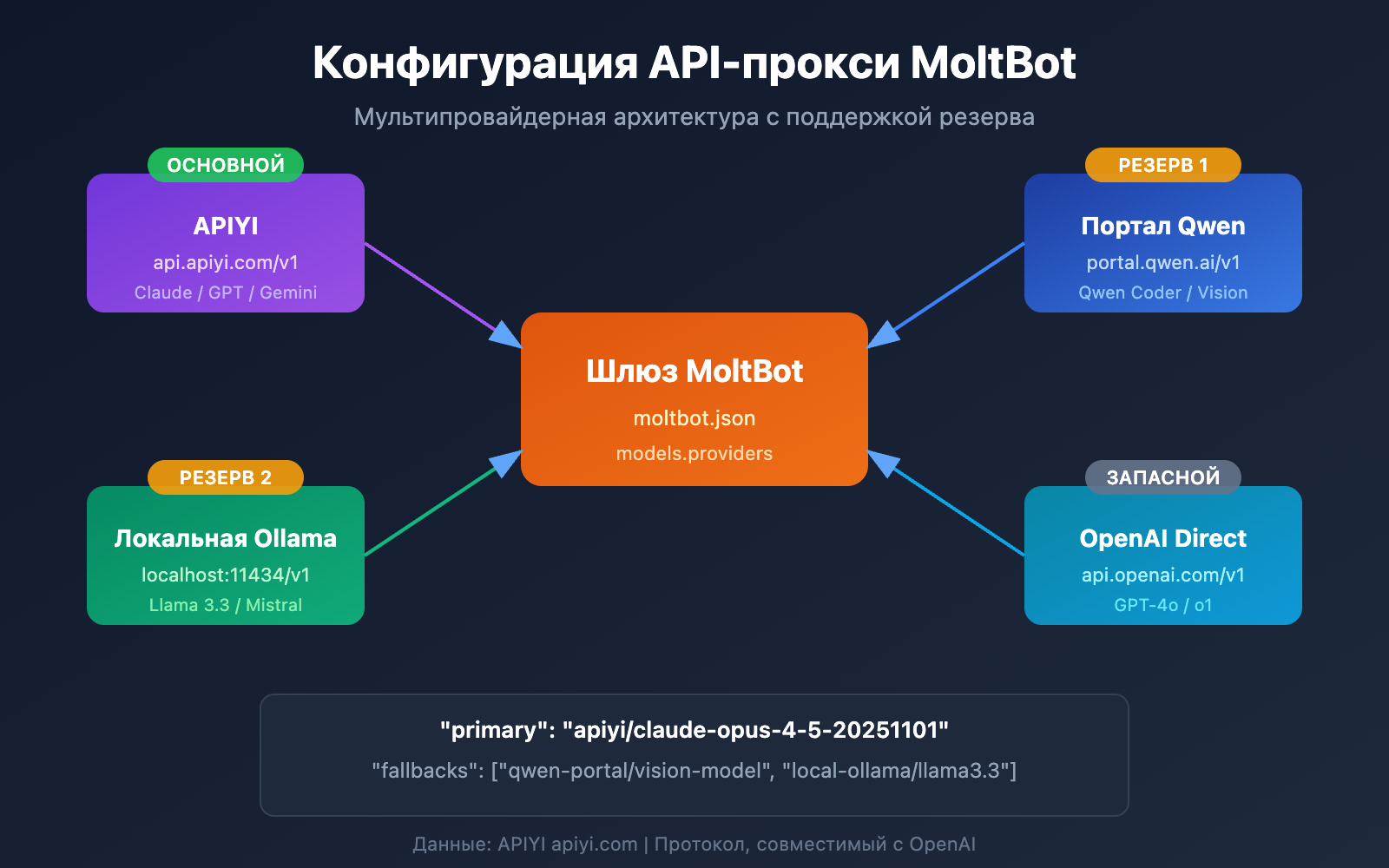

Хотите подключить MoltBot к Claude Opus 4.5 или другим большим языковым моделям, но не знаете, как настроить API-прокси? В этой статье мы пошагово разберем настройку нескольких провайдеров (Multi-Provider) в MoltBot. Это позволит вашему AI-помощнику работать с несколькими сервисами одновременно, обеспечивая умное переключение и отказоустойчивость.

Основная ценность: после прочтения вы освоите метод настройки models.providers в MoltBot, научитесь устанавливать основные и резервные модели, а также создавать алиасы моделей для создания стабильного и надежного AI-помощника.

Настройка API-прокси в MoltBot: разбор основных концепций

MoltBot поддерживает подключение практически ко всем популярным сервисам больших языковых моделей через API, совместимый с OpenAI. Понимание следующих концепций — ключ к успешной настройке.

Система конфигурационных файлов MoltBot

| Файл | Путь | Назначение |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

Глобальная точка входа в настройки |

| models.json | ~/.moltbot/agents/<agentId>/ |

Настройки моделей для конкретного Агента |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

Хранение данных аутентификации |

Основные поля конфигурации провайдера

Каждая конфигурация провайдера (Provider) содержит следующие ключевые поля:

| Поле | Тип | Описание | Обязательно |

|---|---|---|---|

baseUrl |

string | Адрес эндпоинта API | Да |

apiKey |

string | API-ключ (поддерживаются переменные окружения) | Да |

api |

string | Тип протокола API | Да |

models |

array | Список доступных моделей | Да |

Описание типов протоколов API

MoltBot поддерживает два основных протокола, совместимых с OpenAI:

| Тип протокола | Описание | Когда использовать |

|---|---|---|

openai-completions |

Стандартный Chat Completions API | Большинство прокси-сервисов |

openai-responses |

Responses API (с вызовом инструментов) | Локальные модели, сложные сценарии |

🎯 Совет по настройке: Большинство прокси-сервисов (например, APIYI apiyi.com) используют протокол

openai-completions. Если вы используете локально развернутые LM Studio или Ollama, вам понадобитсяopenai-responses.

Конфигурация нескольких провайдеров в MoltBot: полный пример

Ниже приведен пример реально работающей конфигурации с несколькими провайдерами, которая позволяет одновременно подключить сервисы APIYI и Qwen Portal:

Пример полного файла конфигурации

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

Подробный разбор структуры конфигурации

1. Раздел models.providers

Это ключевая часть, где определяются параметры подключения к API-прокси:

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- Provider ID (

apiyi): уникальный идентификатор сервиса, на который вы будете ссылаться в других частях конфига. - baseUrl: адрес API-энтрипоинта, обязательно должен заканчиваться на

/v1. - apiKey: ваш ключ API. Можно вписать напрямую или использовать переменную окружения в формате

${ENV_VAR}. - models: список моделей, которые поддерживает данный провайдер.

2. Раздел agents.defaults.model

Здесь настраивается модель по умолчанию и стратегия автоматического переключения при сбоях (容灾):

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary: основная модель, задается в формате

id-провайдера/id-модели. - fallbacks: массив резервных моделей. Если основная модель недоступна, MoltBot автоматически переключится на следующую в списке.

3. Раздел agents.defaults.models

Определение алиасов (псевдонимов) для быстрого переключения моделей:

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

После настройки алиасов вы сможете мгновенно сменить текущую модель прямо в чате с помощью команды /model opus.

Настройка прокси API для MoltBot: пошаговое руководство

Шаг 1: Получение API-ключа

Прежде чем приступать к настройке, вам нужно подготовить API-ключ:

| Провайдер | Как получить | Поддерживаемые модели |

|---|---|---|

| APIYI | Зарегистрируйтесь на apiyi.com | Вся серия Claude, вся серия GPT, Gemini и др. |

| Qwen Portal | Зайдите на portal.qwen.ai | Модели серии Qwen |

| OpenAI | Зайдите на platform.openai.com | Серия GPT |

| Anthropic | Зайдите на console.anthropic.com | Серия Claude |

🚀 Быстрый старт: Рекомендуем использовать APIYI (apiyi.com) в качестве основного провайдера. Один API-ключ позволит вам вызывать Claude, GPT, Gemini и другие популярные большие языковые модели без необходимости регистрации на нескольких платформах.

Шаг 2: Настройка переменных окружения

В целях безопасности советуем хранить API-ключи в переменных окружения:

# Linux/macOS - 添加到 ~/.bashrc 或 ~/.zshrc

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# 使配置生效

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

Шаг 3: Редактирование файла конфигурации

Откройте или создайте файл конфигурации MoltBot:

# 打开配置文件

nano ~/.moltbot/moltbot.json

# 或使用 VS Code

code ~/.moltbot/moltbot.json

Вставьте в файл следующие настройки:

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

Шаг 4: Проверка конфигурации

Перезапустите MoltBot и убедитесь, что настройки вступили в силу:

# 重启 MoltBot

moltbot restart

# 检查当前模型配置

moltbot models list

# 测试模型调用

moltbot chat "你好,请告诉我你是什么模型"

Посмотреть полный пример конфигурации с несколькими провайдерами

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 Совет по настройке: Используйте

"mode": "merge", чтобы сохранить встроенные конфигурации моделей MoltBot и одновременно добавить своих кастомных провайдеров. Таким образом, даже если ваш сторонний сервис будет недоступен, система сможет откатиться к настройкам по умолчанию.

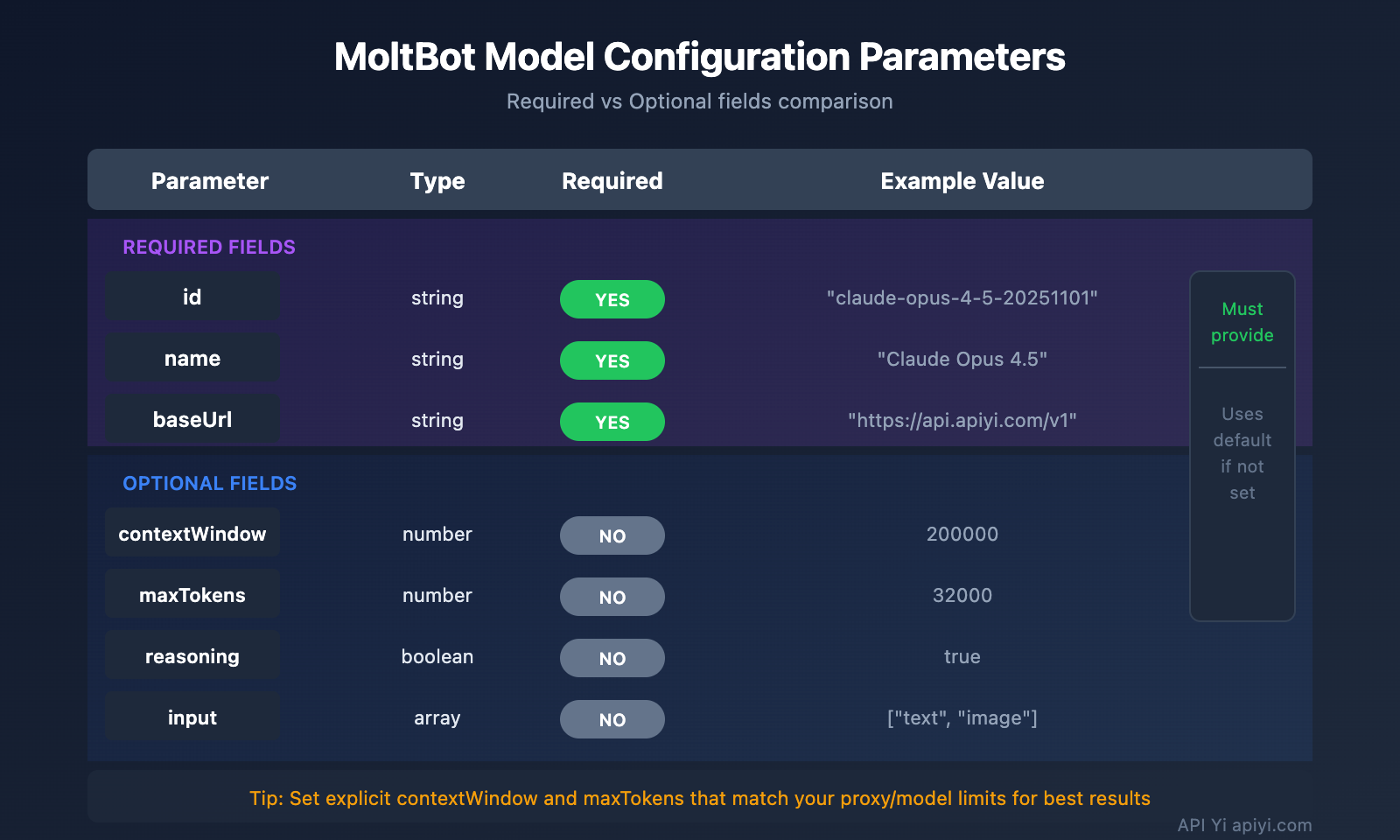

Конфигурация моделей MoltBot: подробный разбор продвинутых параметров

Полный список полей для записи модели

| Параметр | Тип | Обязательно | Описание | Пример |

|---|---|---|---|---|

id |

string | Да | ID модели, используется при вызове | claude-opus-4-5-20251101 |

name |

string | Да | Отображаемое имя | Claude Opus 4.5 |

contextWindow |

number | Нет | Размер контекстного окна | 200000 |

maxTokens |

number | Нет | Максимальное число токенов на выходе | 32000 |

reasoning |

boolean | Нет | Поддержка режима рассуждения | true |

input |

array | Нет | Поддерживаемые типы ввода | ["text", "image"] |

cost |

object | Нет | Информация о стоимости | {"input": 15, "output": 75} |

Конфигурация параметров модели (params)

В разделе agents.defaults.models вы можете установить параметры по умолчанию для каждой модели:

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| Параметр | Диапазон | Описание |

|---|---|---|

temperature |

0–2 | Контролирует случайность вывода: чем ниже значение, тем более детерминированным будет ответ |

maxTokens |

От 1 до лимита модели | Максимальная длина одного ответа |

⚠️ Внимание:

temperature— это продвинутый параметр. Не рекомендуем изменять его, если вы не уверены в стандартных настройках модели и у вас нет конкретной необходимости в корректировке.

Настройка Fallback (отказоустойчивости) в MoltBot

Механизм Fallback — это важная особенность MoltBot, которая гарантирует, что ваш ИИ-помощник всегда будет доступен, даже если основная модель даст сбой.

Как работает Fallback

Запрос пользователя

↓

Основная модель (primary)

↓ (Ошибка)

Резервная модель 1 (fallbacks[0])

↓ (Ошибка)

Резервная модель 2 (fallbacks[1])

↓ (Ошибка)

...продолжение попыток

Рекомендуемые стратегии настройки Fallback

| Стратегия | Пример конфигурации | Когда использовать |

|---|---|---|

| Даунгрейд внутри серии | Opus → Sonnet → Haiku | Для сохранения единого стиля ответов |

| Кросс-платформенный бэкап | Claude → GPT → Gemini | Для максимальной отказоустойчивости |

| Оптимизация затрат | Opus → Локальная модель | Для контроля расходов |

| Гибридная стратегия | Облако → Локально → Облачный резерв | Комплексный подход |

Пример рекомендуемой конфигурации:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 Оптимизация затрат: Настраивая Fallback через APIYI (apiyi.com), вы можете автоматически переключаться между различными моделями, сохраняя при этом единую систему биллинга. Это значительно упрощает контроль и управление расходами.

Переключение моделей в MoltBot: практические советы

Быстрое переключение с помощью псевдонимов (alias)

Если вы настроили псевдонимы, переключаться между моделями можно прямо в ходе диалога:

Вы: /model opus

MoltBot: Переключено на Claude Opus 4.5

Вы: /model sonnet

MoltBot: Переключено на Claude Sonnet 4

Вы: /model qwen

MoltBot: Переключено на Qwen Coder

Использование конкретной модели для определенных задач

Вы: /model gpt помоги мне проанализировать это изображение

MoltBot: [Анализ изображения с помощью GPT-4o...]

Вы: /model opus напиши глубокую техническую статью

MoltBot: [Написание статьи с помощью Claude Opus...]

Просмотр текущего статуса модели

# Просмотр через командную строку

moltbot models list

# Просмотр прямо в чате

Вы: /model

MoltBot: Текущая модель: apiyi/claude-opus-4-5-20251101 (псевдоним: opus)

Настройка API-прокси в MoltBot: Часто задаваемые вопросы

Q1: Что делать, если после настройки появляется ошибка «API Key invalid»?

Обычно это связано с неправильной конфигурацией API-ключа. Проверьте следующие моменты:

- Убедитесь, что переменная окружения установлена правильно:

echo $APIYI_API_KEY - Проверьте формат ключа (обычно он начинается с

sk-) - Подтвердите, что на балансе достаточно средств и у ключа есть нужные права

- Если вы прописываете ключ напрямую в конфиг, проверьте, нет ли лишних пробелов или переносов строк

Формат ключей, полученных через APIYI (apiyi.com), — sk-xxx. Убедитесь, что скопировали его полностью.

Q2: Как одновременно использовать локальные и облачные модели?

Используйте параметр "mode": "merge", чтобы объединить локальные и облачные модели в одном конфиге:

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

Так, если локальная модель будет недоступна, система сможет автоматически переключиться (Fallback) на облачный сервис.

Q3: Что делать, если переменная окружения ${VAR} не подгружается?

В MoltBot правила замены переменных окружения следующие:

- Поддерживаются только заглавные буквы и подчеркивания:

[A-Z_][A-Z0-9_]* - Имя переменной должно быть полностью в верхнем регистре, например

${APIYI_API_KEY} - Переменные в нижнем регистре, такие как

${apiKey}, заменяться не будут - Если переменная не задана, возникнет ошибка при загрузке конфигурации

Советуем использовать стандартные имена: APIYI_API_KEY, QWEN_API_KEY, TELEGRAM_BOT_TOKEN.

Q4: Как назначить разные модели для разных задач?

Это можно сделать через imageModel и алиасы (псевдонимы):

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- Для текстовых задач будет автоматически использоваться модель

primary(Claude Opus) - Для работы с изображениями включится

imageModel(GPT-4o) - Вы также можете переключиться вручную командой

/model vision

Q5: Какие OpenAI-совместимые сервисы поддерживаются?

MoltBot поддерживает любые сервисы, следующие спецификации OpenAI API:

| Тип сервиса | Пример | Рекомендация |

|---|---|---|

| API-прокси | APIYI (apiyi.com) | Рекомендуется (единый доступ к разным моделям) |

| Официальные API | OpenAI, Anthropic, Google | Официально и стабильно |

| Локальный запуск | Ollama, LM Studio, vLLM | Приоритет приватности |

| Другие провайдеры | Groq, Together AI | По необходимости |

Преимущество APIYI (apiyi.com) в том, что один ключ дает доступ сразу к множеству моделей разных вендоров без необходимости регистрироваться везде по отдельности.

Настройка API-прокси в MoltBot: Итоги и рекомендации

Теперь вы знаете все основные способы настройки прокси для MoltBot:

- Структура конфига:

models.providersопределяет сервисы, аagents.defaults— стратегию их использования. - Несколько провайдеров: Подключайте сразу несколько API-сервисов для повышения отказоустойчивости.

- Настройка Fallback: Настройте запасные модели на случай сбоя основной.

- Алиасы: Используйте

/model aliasдля быстрого переключения на лету.

Полезные советы

| Совет | Пояснение |

|---|---|

| Используйте переменные окружения | Не храните API-ключи в открытом виде внутри конфиг-файлов. |

| Настройте Fallback | Имейте в запасе хотя бы 1-2 альтернативные модели. |

| Ставьте mode: merge | Это сохранит стандартные настройки и улучшит совместимость. |

| Единая точка входа | Используйте APIYI, чтобы упростить управление пулом моделей. |

Мы рекомендуем использовать APIYI (apiyi.com) как основной прокси-сервис. Платформа предоставляет единый доступ к Claude, GPT, Gemini и другим популярным моделям, легко настраивается и предлагает гибкую тарификацию, что идеально подходит для сценариев MoltBot с частым переключением между моделями.

Справочные материалы

-

Официальная документация MoltBot — Models: подробное описание конфигурации моделей

- Ссылка:

docs.molt.bot/concepts/models - Описание: официальное руководство по настройке моделей.

- Ссылка:

-

Официальная документация MoltBot — Configuration: полный справочник по параметрам

- Ссылка:

docs.molt.bot/gateway/configuration - Описание: детальный разбор всех доступных опций конфигурации.

- Ссылка:

-

Официальная документация MoltBot — Model Providers: настройка провайдеров

- Ссылка:

docs.molt.bot/concepts/model-providers - Описание: способы настройки пользовательских провайдеров (Provider).

- Ссылка:

-

MoltBot на GitHub: исходный код и обсуждения

- Ссылка:

github.com/moltbot/moltbot - Описание: актуальные версии проекта и обратная связь через Issues.

- Ссылка:

Автор статьи: Команда APIYI | Больше материалов по технологиям ИИ на сайте APIYI apiyi.com

Дата обновления: январь 2026 г.