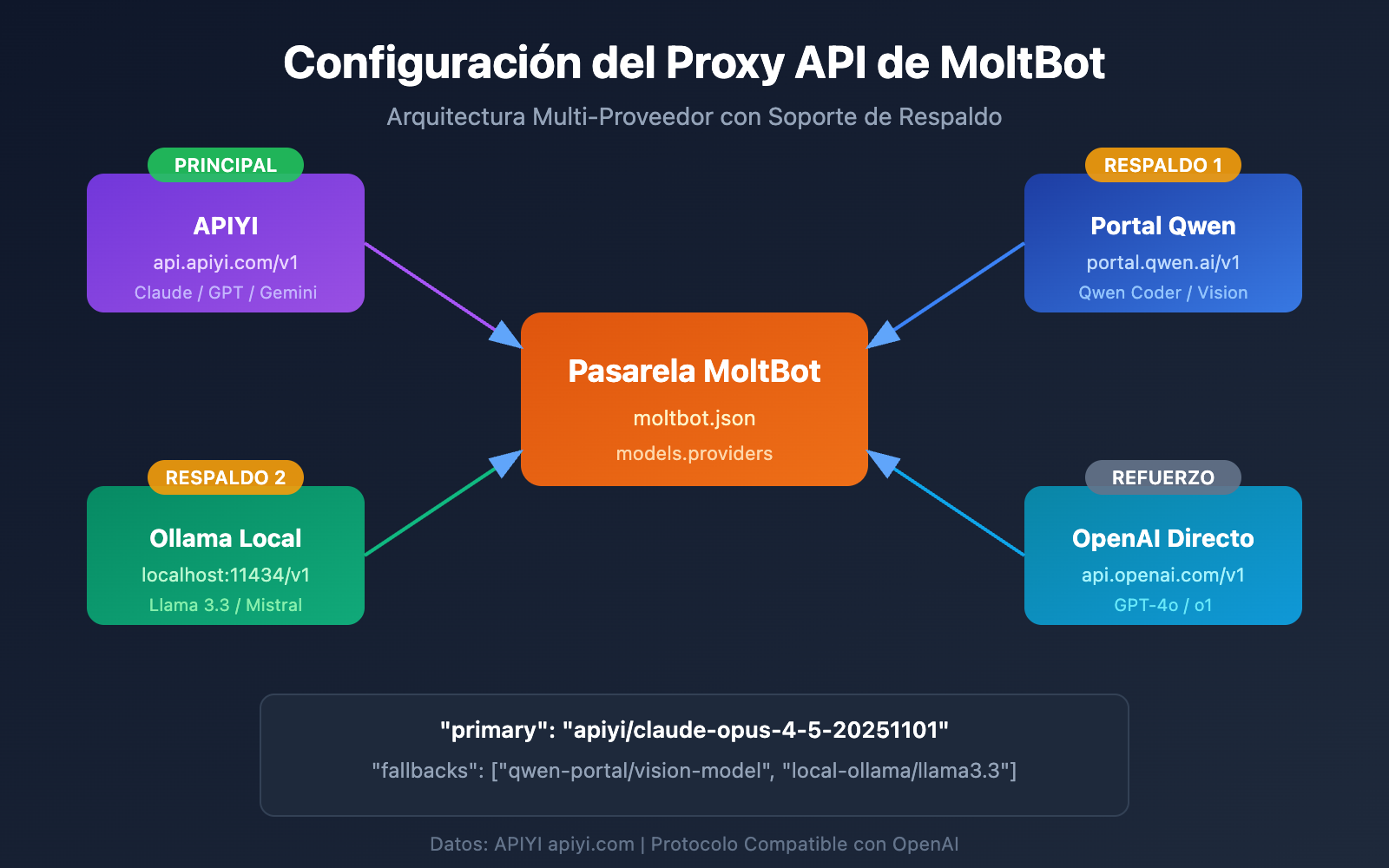

¿Quieres conectar MoltBot a Claude Opus 4.5 u otros modelos de lenguaje grandes, pero no sabes cómo configurar el proxy de la API? Este artículo te enseñará paso a paso cómo completar la configuración de múltiples proveedores (Multi-Provider) de MoltBot, permitiendo que tu asistente de IA se conecte a varios servicios de modelos simultáneamente para lograr un cambio inteligente y respaldo ante fallos (failover).

Valor central: Al terminar de leer, dominarás el método de configuración models.providers de MoltBot, aprenderás a establecer modelos principales, modelos de respaldo y alias de modelos para crear un asistente de IA estable y confiable.

Configuración del Proxy de API de MoltBot: Análisis de Conceptos Clave

MoltBot permite el acceso a casi todos los servicios de modelos de lenguaje grandes (LLM) convencionales a través de la API compatible con OpenAI. Entender los siguientes conceptos clave es fundamental para una configuración exitosa.

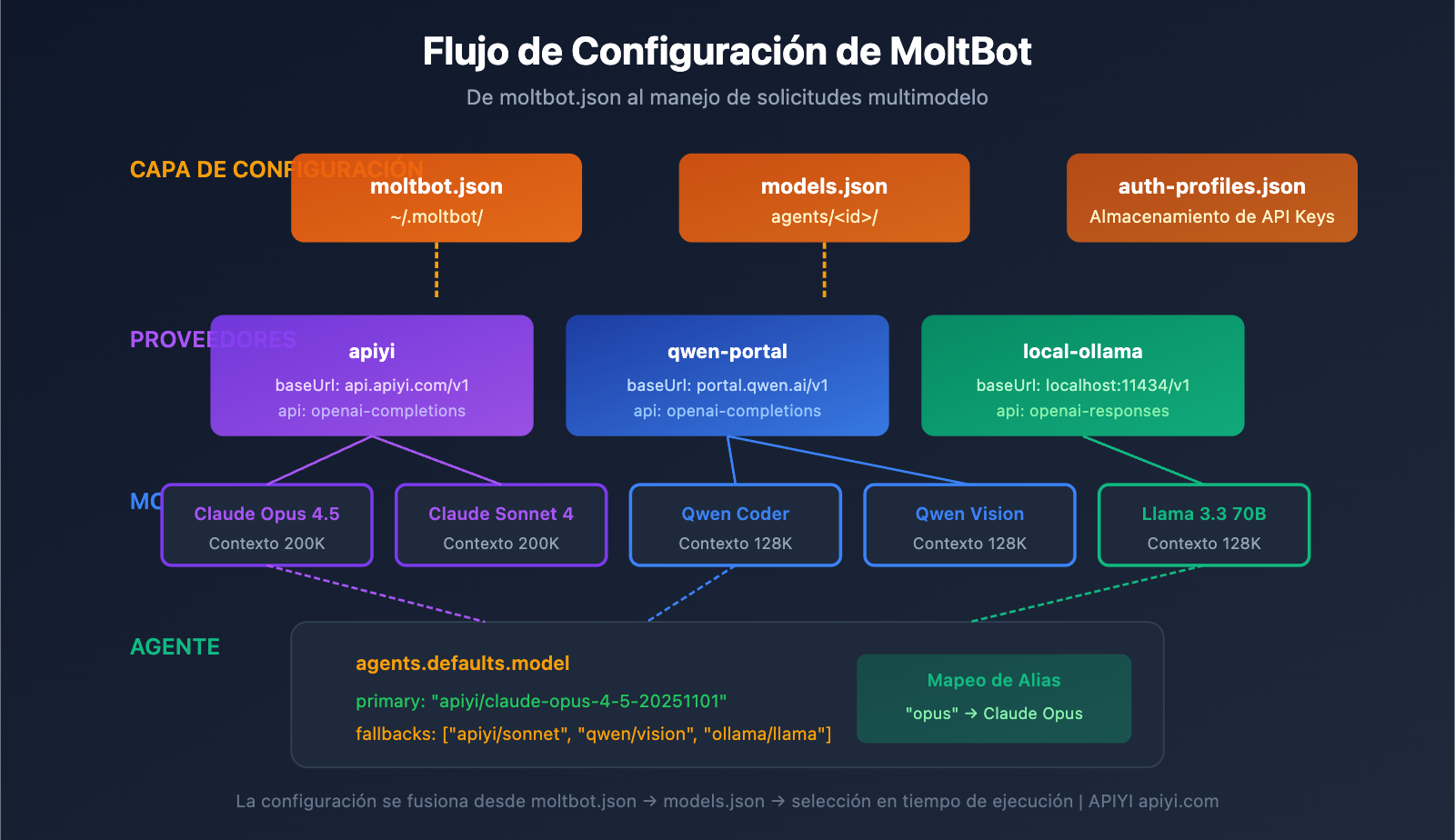

Sistema de archivos de configuración de MoltBot

| Archivo de configuración | Ubicación | Uso |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

Entrada de configuración global |

| models.json | ~/.moltbot/agents/<agentId>/ |

Configuración de modelo a nivel de Agent |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

Almacenamiento de información de autenticación |

Campos clave de la configuración de Proveedores de MoltBot

Cada configuración de Proveedor (Provider) contiene los siguientes campos clave:

| Campo | Tipo | Descripción | Obligatorio |

|---|---|---|---|

baseUrl |

string | Dirección del endpoint de la API | Sí |

apiKey |

string | Clave de API (admite variables de entorno) | Sí |

api |

string | Tipo de protocolo de API | Sí |

models |

array | Lista de modelos disponibles | Sí |

Descripción de los tipos de protocolo de API

MoltBot admite dos protocolos principales compatibles con OpenAI:

| Tipo de protocolo | Descripción | Escenarios de uso |

|---|---|---|

openai-completions |

API estándar de Chat Completions | La mayoría de los servicios de proxy |

openai-responses |

API de Responses (incluye llamadas a herramientas) | Modelos locales, escenarios avanzados |

🎯 Sugerencia de configuración: La mayoría de los servicios de proxy de API (como APIYI apiyi.com) utilizan el protocolo

openai-completions. Si estás utilizando una implementación local como LM Studio u Ollama, necesitarás usaropenai-responses.

Configuración Multi-Provider de MoltBot: Ejemplo completo

A continuación, presentamos un ejemplo real de configuración multi-provider que conecta simultáneamente los servicios de APIYI y Qwen Portal:

Ejemplo de archivo de configuración completo

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

Desglose de la estructura de configuración

1. Sección models.providers

Esta es la parte central donde se definen los servicios proxy de la API:

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- Provider ID (

apiyi): Identificador de servicio personalizado, se utiliza para referencias posteriores. - baseUrl: Punto de enlace (endpoint) de la API, debe terminar en

/v1. - apiKey: Permite introducirla directamente o usar variables de entorno tipo

${ENV_VAR}. - models: Lista de modelos compatibles con este proveedor.

2. Sección agents.defaults.model

Define el modelo predeterminado y la estrategia de recuperación ante fallos (failover):

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary: Modelo principal, con formato

provider-id/model-id. - fallbacks: Matriz de modelos de respaldo; el sistema cambia automáticamente si el modelo principal falla.

3. Sección agents.defaults.models

Define alias para los modelos, facilitando el cambio rápido:

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

Tras configurar los alias, puedes usar el comando /model opus en la conversación para cambiar de modelo rápidamente.

Configuración del proxy de API de MoltBot: tutorial paso a paso

Paso 1: Obtener la clave API (API Key)

Antes de realizar la configuración, necesitas tener preparadas tus claves API:

| Proveedor | Cómo obtenerla | Modelos compatibles |

|---|---|---|

| APIYI | Regístrate en apiyi.com | Series completas de Claude, GPT, Gemini, etc. |

| Qwen Portal | Visita portal.qwen.ai | Modelos de la serie Qwen |

| OpenAI | Visita platform.openai.com | Serie GPT |

| Anthropic | Visita console.anthropic.com | Serie Claude |

🚀 Inicio rápido: Se recomienda usar APIYI apiyi.com como proveedor principal. Una sola clave API te permite llamar a los modelos más importantes como Claude, GPT y Gemini, sin necesidad de registrarte en múltiples plataformas por separado.

Paso 2: Configurar las variables de entorno

Por motivos de seguridad, se recomienda utilizar variables de entorno para almacenar las claves API:

# Linux/macOS - añadir a ~/.bashrc o ~/.zshrc

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# Aplicar los cambios en la configuración

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

Paso 3: Editar el archivo de configuración

Abre o crea el archivo de configuración de MoltBot:

# Abrir el archivo de configuración

nano ~/.moltbot/moltbot.json

# O usar VS Code

code ~/.moltbot/moltbot.json

Pega la siguiente configuración en el archivo:

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

Paso 4: Verificar la configuración

Reinicia MoltBot y verifica si la configuración se ha aplicado correctamente:

# Reiniciar MoltBot

moltbot restart

# Comprobar la configuración de modelos actual

moltbot models list

# Probar la llamada al modelo

moltbot chat "Hola, por favor dime qué modelo eres"

Ver ejemplo completo de configuración multi-proveedor

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 Truco de configuración: El uso de

"mode": "merge"te permite conservar la configuración de modelos integrada de MoltBot mientras añades tus proveedores personalizados. De esta manera, si tus servicios personalizados no están disponibles, el sistema puede recurrir a la configuración predeterminada.

Configuración de modelos en MoltBot: parámetros avanzados detallados

Campos completos de la entrada de modelo

| Parámetro | Tipo | Obligatorio | Descripción | Ejemplo |

|---|---|---|---|---|

id |

string | Sí | ID del modelo, se usa al realizar llamadas | claude-opus-4-5-20251101 |

name |

string | Sí | Nombre para mostrar | Claude Opus 4.5 |

contextWindow |

number | No | Tamaño de la ventana de contexto | 200000 |

maxTokens |

number | No | Tokens máximos de salida | 32000 |

reasoning |

boolean | No | Indica si admite modo de razonamiento | true |

input |

array | No | Tipos de entrada admitidos | ["text", "image"] |

cost |

object | No | Información de costos | {"input": 15, "output": 75} |

Configuración de parámetros del modelo (params)

En agents.defaults.models puedes establecer parámetros predeterminados para cada modelo:

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| Parámetro | Rango | Descripción |

|---|---|---|

temperature |

0-2 | Controla la aleatoriedad de la salida; cuanto más bajo, más determinista |

maxTokens |

1-límite del modelo | Longitud máxima de salida por petición |

⚠️ Nota:

temperaturees un parámetro avanzado. A menos que conozcas la configuración predeterminada del modelo y realmente necesites ajustarla, se recomienda no modificarla.

Configuración de Fallback y Redundancia de MoltBot

El mecanismo de Fallback es una característica clave de MoltBot que garantiza que el asistente de IA esté siempre disponible.

Cómo funciona el Fallback

Petición del usuario

↓

Modelo principal (primary)

↓ (Fallo)

Modelo de respaldo 1 (fallbacks[0])

↓ (Fallo)

Modelo de respaldo 2 (fallbacks[1])

↓ (Fallo)

... seguir intentando

Estrategias recomendadas de configuración de Fallback

| Estrategia | Ejemplo de configuración | Escenario de uso |

|---|---|---|

| Degradación de la misma serie | Opus → Sonnet → Haiku | Mantener la consistencia del estilo |

| Respaldo multiplataforma | Claude → GPT → Gemini | Máxima disponibilidad |

| Optimización de costes | Opus → Modelo local | Controlar gastos |

| Estrategia mixta | Nube → Local → Respaldo en la nube | Enfoque integral |

Configuración recomendada:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 Optimización de costes: Al configurar el Fallback a través de APIYI (apiyi.com), puedes alternar automáticamente entre múltiples modelos mientras disfrutas de un sistema de facturación unificado, lo que facilita el control de costes.

Cambio de modelo en MoltBot: Consejos prácticos

Uso de alias para cambios rápidos

Una vez configurados los alias, puedes cambiar de modelo en cualquier momento durante la conversación:

Tú: /model opus

MoltBot: Se ha cambiado a Claude Opus 4.5

Tú: /model sonnet

MoltBot: Se ha cambiado a Claude Sonnet 4

Tú: /model qwen

MoltBot: Se ha cambiado a Qwen Coder

Especificar un modelo para tareas concretas

Tú: /model gpt ayúdame a analizar esta imagen

MoltBot: [Analizando imagen con GPT-4o...]

Tú: /model opus escribe un artículo técnico profundo

MoltBot: [Escribiendo con Claude Opus...]

Ver el estado actual del modelo

# Ver en la línea de comandos

moltbot models list

# Ver durante la conversación

Tú: /model

MoltBot: Modelo actual: apiyi/claude-opus-4-5-20251101 (alias: opus)

Configuración del proxy de API de MoltBot: Preguntas frecuentes

Q1: ¿Qué hacer si aparece el mensaje «API Key invalid» tras la configuración?

Esto suele ser un problema de configuración de la API Key. Verifica los siguientes puntos:

- Confirma que la variable de entorno esté configurada correctamente:

echo $APIYI_API_KEY - Comprueba que el formato de la API Key sea correcto (normalmente empieza con

sk-) - Confirma que la API Key tenga suficiente saldo y los permisos necesarios

- Si la escribiste directamente en el archivo de configuración, revisa si hay espacios o saltos de línea adicionales

El formato de la API Key obtenida a través de APIYI (apiyi.com) es sk-xxx; asegúrate de copiarla completa.

Q2: ¿Cómo usar modelos locales y en la nube al mismo tiempo?

Puedes usar la configuración "mode": "merge" para utilizar ambos simultáneamente:

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

De esta manera, si el modelo local no está disponible, el sistema puede realizar un Fallback automático al servicio en la nube.

Q3: ¿Qué hacer si la variable de entorno ${VAR} no funciona?

Reglas de sustitución de variables de entorno de MoltBot:

- Solo coinciden con letras mayúsculas y guiones bajos:

[A-Z_][A-Z0-9_]* - El nombre de la variable debe estar totalmente en mayúsculas, como

${APIYI_API_KEY} - Los nombres en minúsculas como

${apiKey}no serán reemplazados - Las variables de entorno no configuradas provocarán un error al cargar la configuración

Se recomienda usar una nomenclatura estándar: APIYI_API_KEY, QWEN_API_KEY, TELEGRAM_BOT_TOKEN

Q4: ¿Cómo usar diferentes modelos para distintas tareas?

Puedes lograrlo mediante imageModel y el uso de alias:

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- Las tareas de texto usarán automáticamente el modelo

primary(Claude Opus) - Las tareas de imagen usarán automáticamente el

imageModel(GPT-4o) - También puedes cambiar manualmente usando

/model vision

Q5: ¿Qué servicios compatibles con OpenAI son soportados?

MoltBot soporta todos los servicios que sigan la especificación de la API de OpenAI:

| Tipo de servicio | Ejemplo | Recomendación |

|---|---|---|

| Proxy de API | APIYI (apiyi.com) | Recomendado (acceso unificado a múltiples modelos) |

| API Oficial | OpenAI, Anthropic, Google | Oficial y estable |

| Despliegue local | Ollama, LM Studio, vLLM | Prioridad a la privacidad |

| Otros proxies | Groq, Together AI | Según necesidad |

La ventaja de APIYI (apiyi.com) es que con una sola Key puedes invocar modelos de varios proveedores sin tener que registrarte en cada uno por separado.

Configuración del proxy de API de MoltBot: Resumen y sugerencias

A través de este artículo, ya conoces los métodos completos para configurar el proxy de API en MoltBot:

- Entender la estructura:

models.providersdefine los servicios, yagents.defaultsdefine la estrategia de uso. - Configurar múltiples proveedores: Conecta varios servicios de API simultáneamente para mejorar la disponibilidad.

- Configurar Fallback: Cambia automáticamente a un modelo de respaldo si el modelo principal falla.

- Usar alias: Cambia rápidamente de modelo mediante

/model alias.

Sugerencias de mejores prácticas

| Sugerencia | Explicación |

|---|---|

| Usar variables de entorno | No guardes tus API Keys en texto plano dentro de los archivos de configuración. |

| Configurar Fallback | Establece al menos 1 o 2 modelos de respaldo. |

| Establecer mode: merge | Mantén la configuración por defecto para mejorar la compatibilidad. |

| Unificar el acceso a la API | Utiliza APIYI para simplificar la gestión de múltiples modelos. |

Recomendamos usar APIYI (apiyi.com) como tu servicio principal de proxy de API. Esta plataforma ofrece un acceso unificado a los principales modelos como Claude, GPT y Gemini, con una configuración sencilla y planes de facturación flexibles, lo que la hace ideal para los escenarios de cambio entre múltiples modelos de MoltBot.

Referencias

-

Documentación oficial de MoltBot – Models: Explicación detallada de la configuración de modelos

- Enlace:

docs.molt.bot/concepts/models - Descripción: Guía oficial de configuración de modelos

- Enlace:

-

Documentación oficial de MoltBot – Configuration: Referencia completa de configuración

- Enlace:

docs.molt.bot/gateway/configuration - Descripción: Detalle de todos los elementos de configuración

- Enlace:

-

Documentación oficial de MoltBot – Model Providers: Configuración de proveedores (Providers)

- Enlace:

docs.molt.bot/concepts/model-providers - Descripción: Método de configuración de proveedores personalizados

- Enlace:

-

GitHub de MoltBot: Código fuente y discusión de Issues

- Enlace:

github.com/moltbot/moltbot - Descripción: Última versión y reporte de problemas

- Enlace:

Autor de este artículo: APIYI Team | Para más contenido técnico sobre IA, visita APIYI apiyi.com

Fecha de actualización: enero de 2026