« Puis-je recharger mon compte Claude Developer Platform via un tiers ? » C'est une question que se posent souvent de nombreux développeurs. La réponse est : le rechargement par un tiers n'est pas recommandé, il existe de meilleures alternatives. Cet article analyse en détail les restrictions de la plateforme officielle de Claude et présente trois solutions optimales pour utiliser l'API Claude.

Valeur ajoutée : En lisant cet article, vous comprendrez les risques liés au rechargement tiers pour l'API Claude, vous maîtriserez des solutions d'appel d'API plus sûres et plus stables, et vous apprendrez à utiliser la fonction de Prompt Caching (mise en cache des invites) pour réduire vos coûts.

Pourquoi le rechargement tiers de l'API Claude n'est pas recommandé

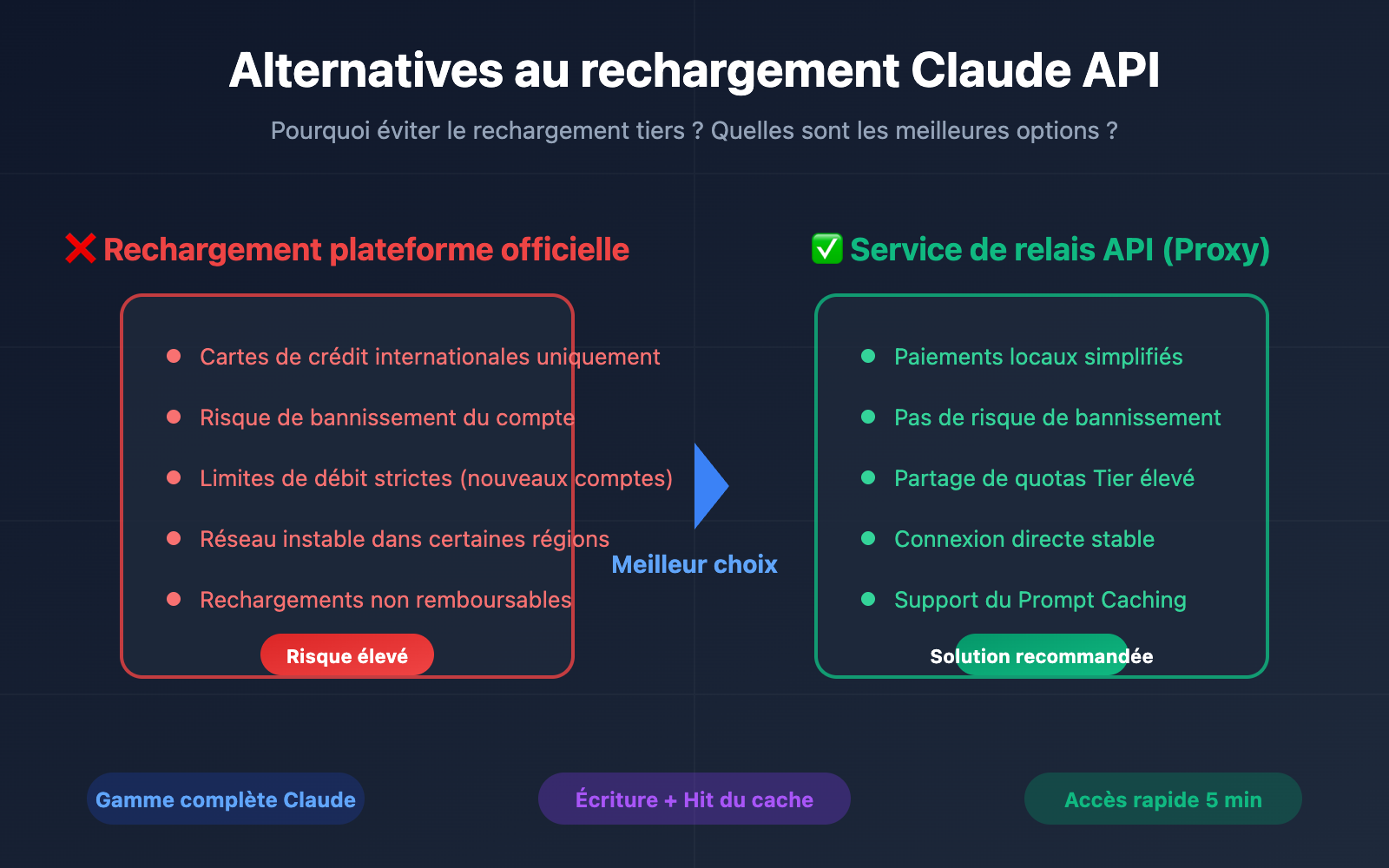

De nombreux développeurs envisagent de passer par des tiers pour recharger la plateforme officielle Claude (console.anthropic.com), mais cette méthode présente de multiples risques et limites.

| Type de problème | Description | Niveau d'impact |

|---|---|---|

| Restrictions de paiement | Cartes de crédit internationales uniquement (Visa/Mastercard) | Élevé |

| Risque de compte | Le compte rechargé via un tiers peut être banni | Très élevé |

| Limites de débit | Débit extrêmement bas pour le Tier 1 des nouveaux comptes | Élevé |

| Problèmes réseau | Connexion directe instable selon la zone géographique | Moyen |

| Coûts | Surcoût du service tiers + frais de change | Moyen |

Restrictions de paiement sur la plateforme officielle Claude

Selon les directives officielles d'Anthropic, l'API Claude utilise un modèle de crédits prépayés (Credits) :

- Modes de paiement acceptés : Visa, Mastercard, American Express, Discover.

- Devise de transaction : Uniquement le dollar américain (USD).

- Validité des crédits : Valables pendant 1 an après l'achat, non prolongeables.

- Politique de remboursement : Aucun rechargement n'est remboursable.

🚨 Alerte Risque : Le rechargement tiers consiste par essence à utiliser le compte ou le canal de paiement d'un tiers. Anthropic interdit explicitement le partage et la revente de comptes. En cas de détection d'anomalie, le compte est banni immédiatement et tous les crédits rechargés sont perdus.

Mécanisme officiel de limitation de débit de l'API Claude

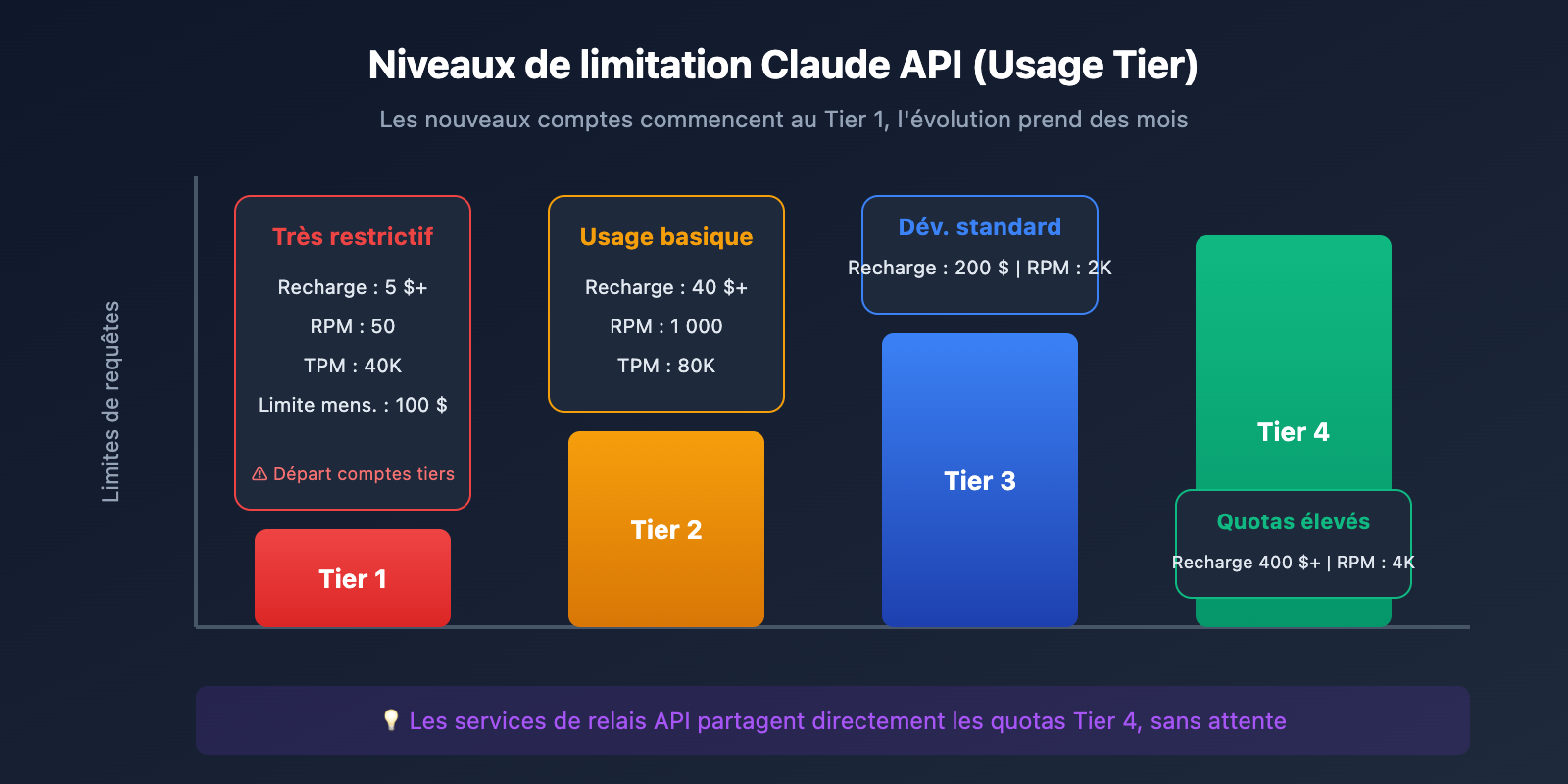

L'API Claude utilise un système de niveaux d'utilisation (Usage Tier). Tout nouveau compte commence au Tier 1 :

| Niveau | Exigence de recharge | Limite RPM | Limite TPM | Plafond mensuel |

|---|---|---|---|---|

| Tier 1 | 5 $ + | 50 | 40K | 100 $ |

| Tier 2 | 40 $ + | 1 000 | 80K | 500 $ |

| Tier 3 | 200 $ + | 2 000 | 160K | 1 000 $ |

| Tier 4 | 400 $ + | 4 000 | 400K | 5 000 $ |

Le problème : Même si le rechargement tiers réussit, un nouveau compte fera face à des limitations de débit très strictes, insuffisantes pour un développement normal. Passer aux niveaux supérieurs nécessite de consommer régulièrement pendant plusieurs mois, ce qui représente un coût temporel très élevé.

Comparaison de 3 alternatives à l'API Claude

Pour répondre aux besoins réels des développeurs, nous recommandons les trois alternatives suivantes :

| Solution | Avantages | Inconvénients | Scénarios recommandés |

|---|---|---|---|

| Service de relais API | Pas de carte de crédit requise, quotas élevés, support du cache | Nécessite de choisir un fournisseur fiable | Développeurs indépendants, PME |

| AWS Bedrock | Stabilité de niveau entreprise, conformité | Configuration complexe, coût élevé | Grandes entreprises |

| Google Vertex AI | Intégration à l'écosystème GCP | Nécessite un compte GCP | Équipes utilisant déjà GCP |

Solution 1 : Service de relais API (Recommandé)

Le service de relais API est actuellement la solution la plus adaptée pour les développeurs souhaitant s'affranchir des contraintes géographiques. Il permet d'appeler l'API Claude via des nœuds de relais conformes sans avoir à gérer les problèmes de paiement ou de réseau.

Avantages clés :

- Paiement simplifié : Supporte les méthodes de paiement locales (Alipay, WeChat, etc.).

- Pas de limitation de débit : Les fournisseurs ont déjà mis à niveau leurs comptes (Tier), partageant ainsi des quotas élevés.

- Réseau stable : Lignes d'accès optimisées pour une latence minimale.

- Fonctionnalités complètes : Supporte l'intégralité des fonctions comme le Prompt Caching et l'Extended Thinking.

🎯 Conseil technique : Nous recommandons d'utiliser la plateforme APIYI (apiyi.com) pour appeler l'API Claude. Elle propose une interface compatible avec le format OpenAI et supporte toute la gamme des modèles Claude, y compris la toute nouvelle fonction de cache (Prompt Caching).

Exemple d'intégration rapide :

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # Interface unifiée APIYI

)

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(response.choices[0].message.content)

Solution 2 : AWS Bedrock

Amazon Bedrock est le service d'IA managé d'AWS, supportant toute la gamme des modèles Claude.

Scénarios d'utilisation :

- Entreprises disposant déjà d'une infrastructure AWS.

- Projets ayant des exigences strictes en matière de conformité.

- Besoin d'une intégration profonde avec d'autres services AWS.

Points d'attention :

- Nécessite un compte AWS et une configuration spécifique.

- Tarification identique à celle d'Anthropic.

- Léger délai possible pour le déploiement des nouvelles fonctionnalités.

Solution 3 : Google Vertex AI

Vertex AI de Google Cloud permet également d'accéder aux modèles Claude.

Scénarios d'utilisation :

- Équipes utilisant déjà l'écosystème GCP.

- Besoin d'intégration avec les services Google Cloud.

Détails de la fonctionnalité Prompt Caching de l'API Claude

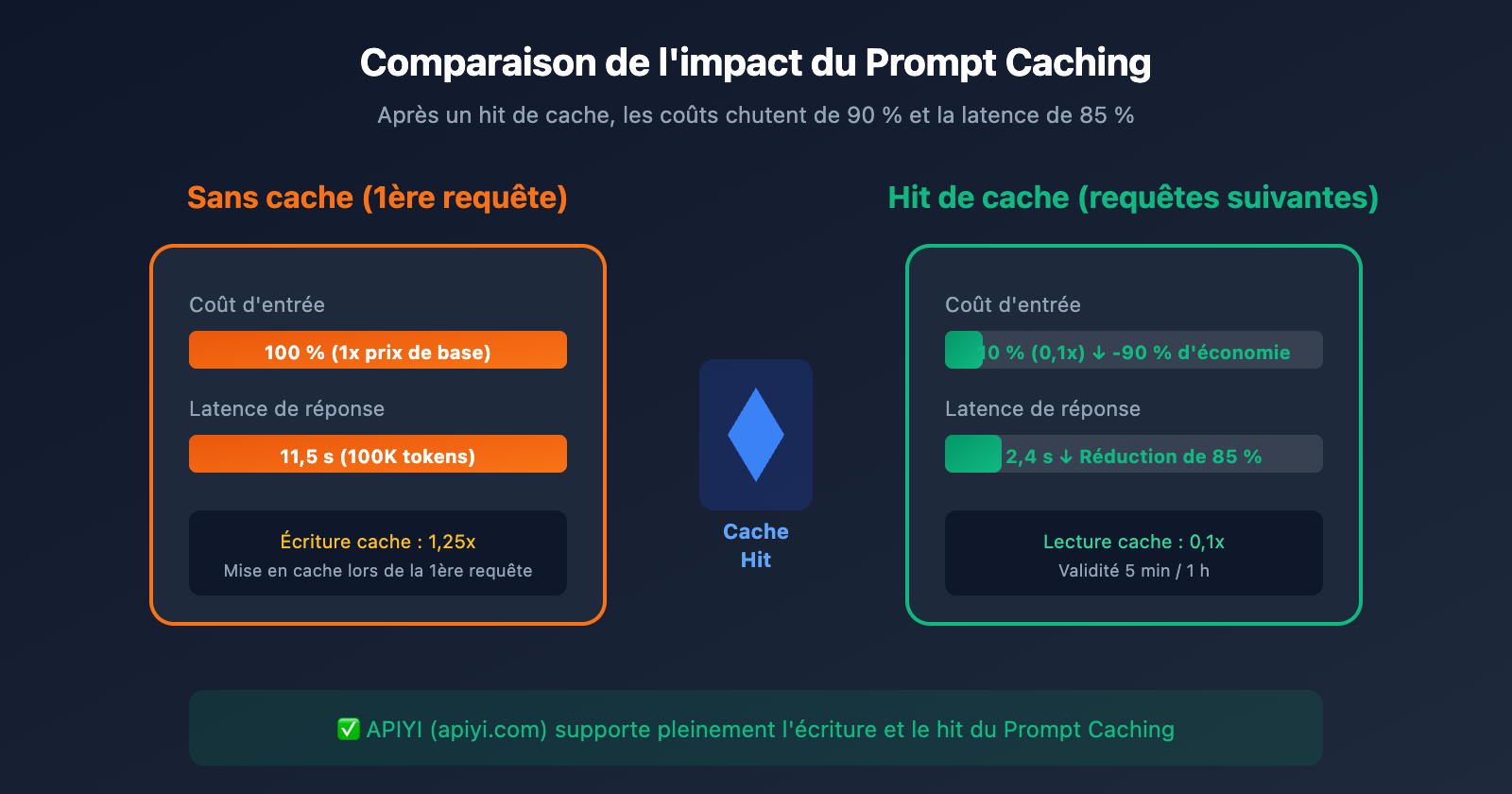

Le Prompt Caching est une fonctionnalité majeure de l'API Claude qui permet de réduire considérablement les coûts et la latence. Lors du choix d'une alternative, il est crucial de s'assurer que cette fonction est supportée.

Principes fondamentaux du Prompt Caching

| Concept | Description |

|---|---|

| Écriture cache | Lors de la première requête, le contenu de l'invite est écrit dans le cache. |

| Hit de cache | Les requêtes suivantes réutilisent le cache, réduisant drastiquement les coûts. |

| Durée du cache | 5 minutes (par défaut) ou 1 heure (étendu). |

| Token minimum | Au moins 1 024 tokens sont nécessaires pour activer le cache. |

Comparaison des tarifs Prompt Caching

| Type d'opération | Multiplicateur de prix | Description |

|---|---|---|

| Entrée normale | 1x | Prix de base |

| Écriture cache (5 min) | 1,25x | Un peu plus cher à la première écriture |

| Écriture cache (1 h) | 2x | Temps de cache prolongé |

| Lecture cache | 0,1x | Économie de 90 % |

Amélioration des performances : Les données officielles d'Anthropic montrent qu'avec le Prompt Caching :

- La latence est réduite jusqu'à 85 % (Scénario 100K tokens : 11,5s → 2,4s).

- Les coûts sont réduits jusqu'à 90 %.

Exemple de code utilisant le Prompt Caching

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # APIYI supporte le cache

)

# Invite système (qui sera mise en cache)

system_prompt = """

Tu es un assistant spécialisé en documentation technique. Voici le contenu du produit :

[Insérer ici un volume important de documentation, recommandé 1024+ tokens]

...

"""

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{

"role": "system",

"content": system_prompt,

# Définir le point d'arrêt du cache

"cache_control": {"type": "ephemeral"}

},

{"role": "user", "content": "Peux-tu résumer les fonctionnalités clés du document ?"}

]

)

# Vérifier l'état du cache

usage = response.usage

print(f"Écriture cache : {usage.cache_creation_input_tokens} tokens")

print(f"Hit de cache : {usage.cache_read_input_tokens} tokens")

Voir l’exemple complet de configuration du cache

import openai

from typing import List, Dict

class ClaudeCacheClient:

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

self.system_cache = None

def set_system_prompt(self, content: str):

"""Définit l'invite système avec cache"""

self.system_cache = {

"role": "system",

"content": content,

"cache_control": {"type": "ephemeral"}

}

def chat(self, user_message: str) -> str:

"""Envoie un message en réutilisant automatiquement le cache"""

messages = []

if self.system_cache:

messages.append(self.system_cache)

messages.append({"role": "user", "content": user_message})

response = self.client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=messages

)

# Afficher les statistiques du cache

usage = response.usage

if hasattr(usage, 'cache_read_input_tokens'):

hit_rate = usage.cache_read_input_tokens / (

usage.cache_read_input_tokens +

usage.cache_creation_input_tokens + 1

) * 100

print(f"Taux de hit du cache : {hit_rate:.1f}%")

return response.choices[0].message.content

# Exemple d'utilisation

client = ClaudeCacheClient("sk-your-apiyi-key")

client.set_system_prompt("Tu es un assistant technique..." * 100) # Texte long

# Les appels successifs réutiliseront le cache

print(client.chat("Question 1"))

print(client.chat("Question 2")) # Hit de cache, coût réduit de 90 %

💡 Conseil de choix : La plateforme APIYI (apiyi.com) supporte intégralement la fonction Claude Prompt Caching, incluant l'écriture et la lecture du cache. Aucune configuration complexe n'est requise : utilisez l'interface standard pour profiter immédiatement des optimisations de coût et de performance.

Prise en main rapide de la solution de relais API Claude

Étape 1 : Obtenir votre clé API

- Rendez-vous sur APIYI (apiyi.com) pour créer un compte.

- Accédez à la console pour générer une clé API.

- Rechargez votre solde (prend en charge Alipay et WeChat).

Étape 2 : Configurer l'environnement de développement

Environnement Python :

pip install openai

Configuration des variables d'environnement :

export OPENAI_API_KEY="sk-your-apiyi-key"

export OPENAI_BASE_URL="https://api.apiyi.com/v1"

Étape 3 : Tester la connexion à l'API

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1"

)

# 测试 Claude Sonnet 4

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[{"role": "user", "content": "你好,请介绍一下你自己"}],

max_tokens=500

)

print(response.choices[0].message.content)

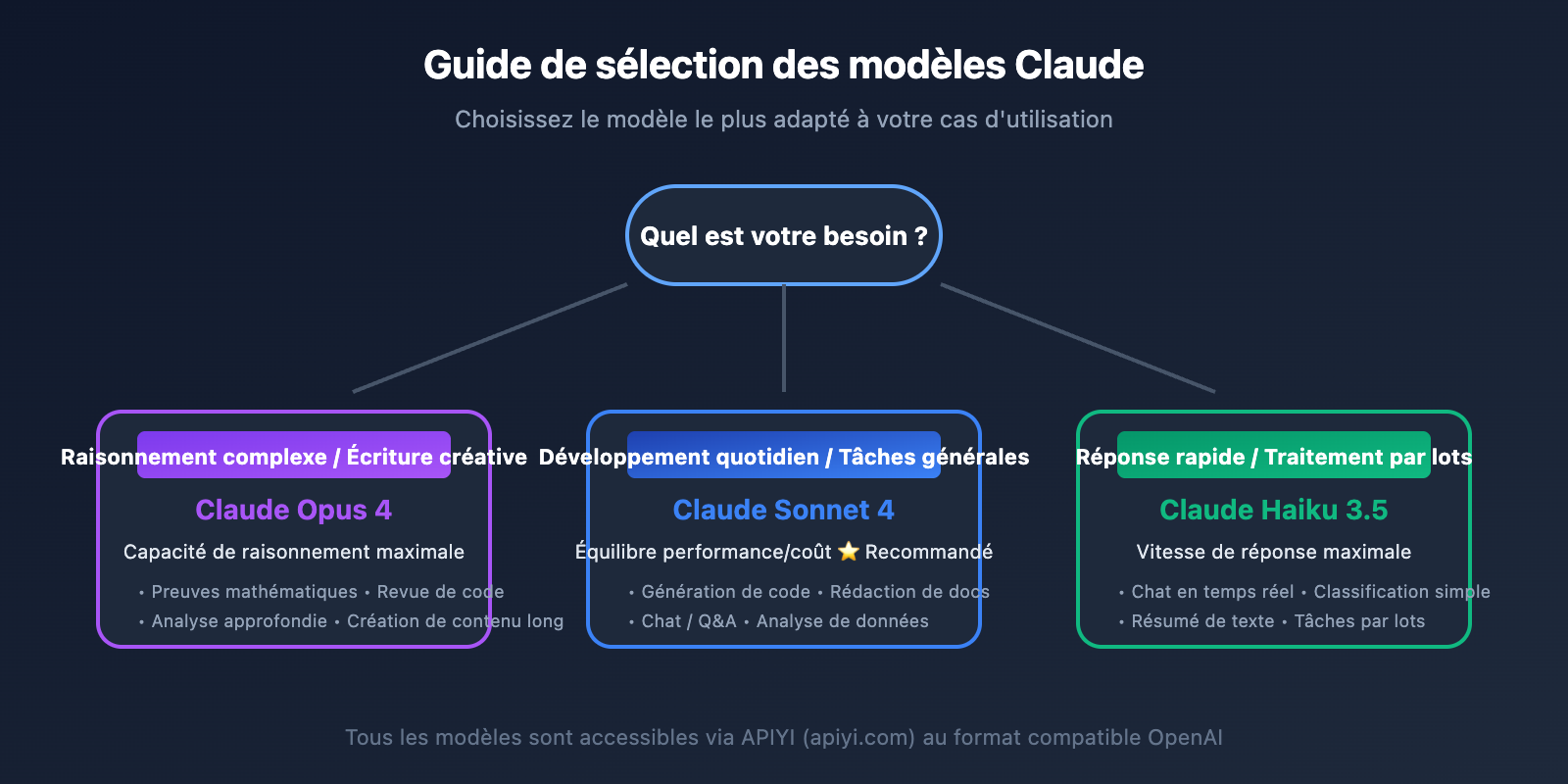

Liste des modèles Claude supportés

| Nom du modèle | ID du modèle | Caractéristiques | Plateformes disponibles |

|---|---|---|---|

| Claude Opus 4 | claude-opus-4-20250514 | Meilleure capacité de raisonnement | APIYI apiyi.com |

| Claude Sonnet 4 | claude-sonnet-4-20250514 | Équilibre performance et coût | APIYI apiyi.com |

| Claude Haiku 3.5 | claude-3-5-haiku-20241022 | Réponse rapide | APIYI apiyi.com |

| Claude Sonnet 3.5 | claude-3-5-sonnet-20241022 | Version classique stable | APIYI apiyi.com |

Comparaison détaillée : Plateforme officielle vs Solution de relais

| Critères de comparaison | Plateforme officielle Claude | Solution de relais API |

|---|---|---|

| Moyens de paiement | Carte bancaire internationale | Alipay / WeChat |

| Accès réseau | Nécessite un proxy | Connexion directe |

| Limites de débit | Restrictions par paliers (Tiers) | Quotas élevés partagés |

| Risque lié au compte | Risque de bannissement via recharge tierce | Sans risque |

| Fonctionnalités | Complètes | Complètes (Prompt Caching inclus) |

| Support technique | Tickets en anglais | Service client en chinois |

| Facturation | Prépaiement | Paiement à l'usage |

| Difficulté de prise en main | Complexe | Simple |

Questions Fréquentes

Q1 : Le rechargement tiers (代充) pour l’API Claude est-il vraiment déconseillé ?

C'est effectivement déconseillé. Le rechargement via un tiers pose plusieurs problèmes majeurs :

- Sécurité du compte : Anthropic détecte les connexions et les comportements de paiement suspects. Le risque de bannissement pour les comptes rechargés par des tiers est extrêmement élevé.

- Limites de débit (Rate Limiting) : Même si le rechargement réussit, les restrictions du Tier 1 pour les nouveaux comptes sont très strictes, ce qui rend l'utilisation normale difficile.

- Risque financier : Une fois le compte banni, le montant rechargé ne peut pas être récupéré.

En passant par un service de relais officiel comme APIYI (apiyi.com), vous évitez ces problèmes tout en bénéficiant de quotas plus élevés et d'un service plus stable.

Q2 : Est-ce que les services de relais supportent le Prompt Caching ?

Oui. APIYI (apiyi.com) supporte intégralement la fonctionnalité de Cache d'invite (Prompt Caching) de Claude, incluant :

- Cache standard de 5 minutes

- Cache étendu d'une heure

- Statistiques d'écriture et de succès (hit) du cache

- Jusqu'à 90 % d'économie sur les coûts

L'utilisation est identique à l'API officielle : il suffit d'ajouter le paramètre cache_control dans vos messages.

Q3 : La latence d’un service de relais est-elle plus élevée que l’officielle ?

En pratique, la latence d'un service de relais de qualité est quasiment identique à celle de l'officiel, et parfois même plus rapide. Pourquoi ?

- Le fournisseur de relais déploie des nœuds optimisés dans plusieurs régions.

- La connexion directe (sans avoir besoin de VPN/Proxy supplémentaire) réduit la latence réseau.

- Les comptes de Tier supérieur bénéficient d'une priorité de traitement plus élevée.

Nous vous recommandons de faire un test comparatif pour choisir la solution offrant la latence la plus faible.

Q4 : Comment garantir la sécurité des données ?

Lors du choix d'un fournisseur de relais, faites attention aux points suivants :

- Consultez la politique de confidentialité et les explications sur le traitement des données du fournisseur.

- Vérifiez que la transmission est sécurisée via HTTPS.

- Renseignez-vous sur la politique de conservation des journaux (logs).

- Pour les données ultra-sensibles, envisagez un pré-traitement local.

APIYI (apiyi.com) s'engage à ne pas stocker les données de conversation des utilisateurs, ne conservant que les journaux nécessaires à la facturation.

Q5 : Quel est le prix du relais par rapport aux tarifs officiels ?

Les services de relais proposent généralement des prix identiques ou légèrement inférieurs aux tarifs officiels, tout en vous épargnant :

- Les frais de transaction par carte bancaire internationale.

- Les pertes liées au taux de change.

- Les coûts des outils de proxy/VPN.

Tout calcul fait, le coût réel d'utilisation d'un service de relais est souvent moins élevé.

Conclusion

Le rechargement tiers de l'API Claude présente des risques de bannissement, des limites de débit strictes et des difficultés de paiement. Ce n'est pas la solution idéale pour les développeurs. La méthode recommandée est d'utiliser un service de relais API sérieux :

- Paiement facilité : Supporte les méthodes de paiement locales, sans besoin de carte de crédit internationale.

- Quotas élevés : Partage de quotas Tier élevés, sans soucis de limitation de vitesse.

- Fonctionnalités complètes : Supporte l'écriture et le succès du Cache d'invite.

- Stable et fiable : Connexion directe et support technique en français/chinois.

Nous vous recommandons d'utiliser APIYI (apiyi.com) pour accéder rapidement à l'API Claude. La plateforme supporte toute la gamme des modèles Claude, est totalement compatible avec les fonctions officielles, et l'intégration se fait en moins de 5 minutes.

Références

-

Facturation de l'API Anthropic : Règles d'utilisation des crédits prépayés de l'API Claude

- Lien :

support.claude.com/en/articles/8977456-how-do-i-pay-for-my-claude-api-usage

- Lien :

-

Documentation sur les limites de débit de l'API Claude : Explication officielle des niveaux d'utilisation (Usage Tiers)

- Lien :

docs.claude.com/en/api/rate-limits

- Lien :

-

Documentation sur le Prompt Caching : Guide d'utilisation de la fonction de mise en cache

- Lien :

docs.claude.com/en/docs/build-with-claude/prompt-caching

- Lien :

Auteur : Équipe APIYI

Support technique : Pour obtenir de l'aide sur l'intégration de l'API Claude, visitez APIYI sur apiyi.com