「¿Se puede recargar la plataforma de desarrolladores de Claude?」 Esta es una pregunta que muchos desarrolladores se hacen con frecuencia. La respuesta es: no se recomienda la recarga mediante terceros, existen mejores alternativas. En este artículo, analizaremos en detalle las restricciones de la plataforma oficial de Claude y presentaremos 3 opciones superiores para utilizar la API de Claude.

Valor principal: Al terminar de leer, conocerás los riesgos de las recargas de terceros para la API de Claude, dominarás soluciones de llamada a la API más seguras y estables, y aprenderás a usar la función de Prompt Caching (almacenamiento en caché de indicaciones) para reducir costes.

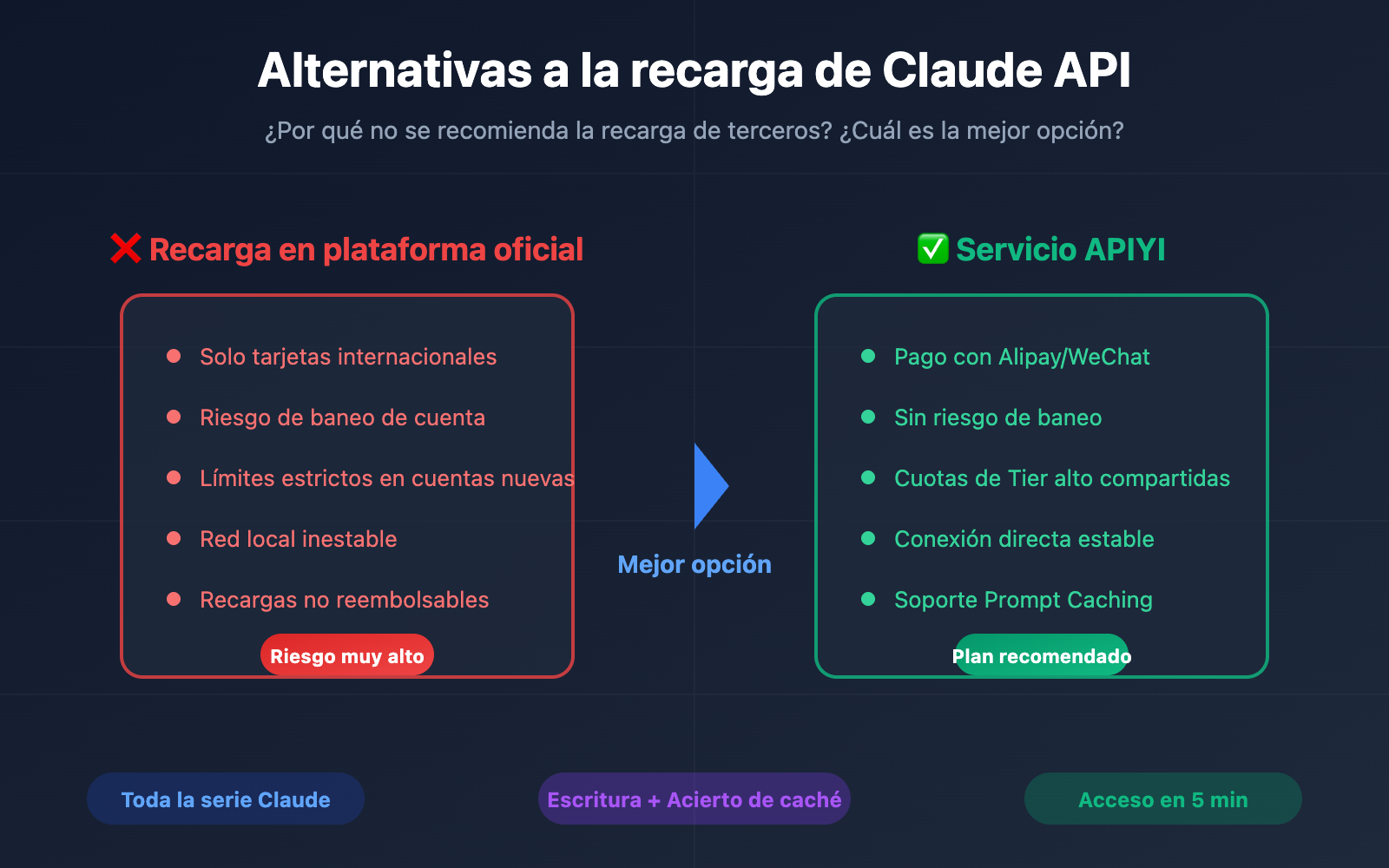

Por qué no se recomienda la recarga de terceros para Claude API

Muchos desarrolladores intentan utilizar la plataforma oficial de desarrolladores de Claude (console.anthropic.com) mediante recargas de terceros, pero este método conlleva múltiples riesgos y limitaciones.

| Tipo de problema | Manifestación específica | Nivel de impacto |

|---|---|---|

| Restricción de pago | Solo tarjetas internacionales (Visa/Mastercard) | Alto |

| Riesgo de cuenta | Las cuentas recargadas por terceros pueden ser baneadas | Muy alto |

| Límite de velocidad | Los límites del Tier 1 para cuentas nuevas son ínfimos | Alto |

| Problemas de red | La conexión directa desde ciertas regiones es inestable | Medio |

| Problemas de coste | Sobreprecio de terceros + comisiones por cambio de divisa | Medio |

Restricciones de pago en la plataforma oficial de Claude

Según las especificaciones oficiales de Anthropic, la API de Claude utiliza un modelo de créditos prepagados:

- Métodos de pago admitidos: Visa, Mastercard, American Express, Discover.

- Moneda de transacción: Solo se admite el dólar estadounidense (USD).

- Validez de los créditos: Válidos durante 1 año tras la compra, no prorrogables.

- Política de reembolsos: Todas las recargas son no reembolsables.

🚨 Aviso de riesgo: La recarga por terceros implica esencialmente el uso de cuentas o canales de pago ajenos. Anthropic prohíbe explícitamente el uso compartido y la reventa de cuentas. Si se detecta una anomalía, la cuenta será bloqueada de inmediato y se perderán todos los créditos recargados.

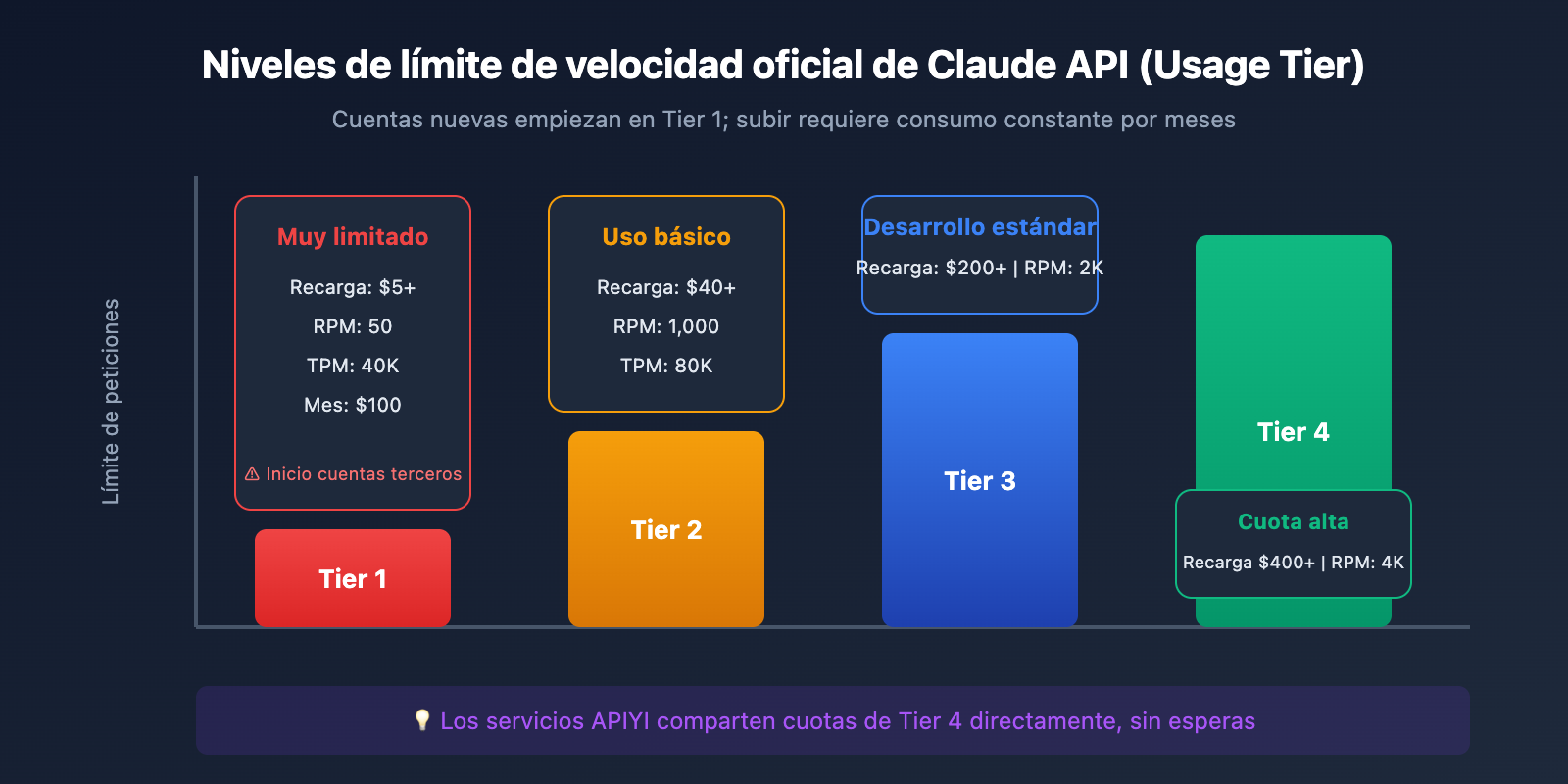

Mecanismo oficial de límite de velocidad de Claude API

La API de Claude utiliza un sistema de niveles de uso (Usage Tier); las cuentas nuevas comienzan en el Tier 1:

| Nivel | Requisito de recarga | Límite RPM | Límite TPM | Límite mensual |

|---|---|---|---|---|

| Tier 1 | $5+ | 50 | 40K | $100 |

| Tier 2 | $40+ | 1,000 | 80K | $500 |

| Tier 3 | $200+ | 2,000 | 160K | $1,000 |

| Tier 4 | $400+ | 4,000 | 400K | $5,000 |

El problema: Incluso si la recarga de terceros tiene éxito, las cuentas nuevas se enfrentan a límites de velocidad muy estrictos que no cubren las necesidades de un desarrollo normal. Subir de nivel requiere un consumo constante durante meses, lo que supone un coste de tiempo altísimo.

3 alternativas a la API de Claude: Comparativa

Para cubrir las necesidades reales de los desarrolladores, recomendamos las siguientes 3 alternativas:

| Solución | Ventajas | Desventajas | Escenarios recomendados |

|---|---|---|---|

| Servicio de intermediación (Proxy API) | Sin necesidad de tarjeta de crédito, cuotas altas, soporte para caché | Requiere elegir un proveedor confiable | Desarrolladores individuales, PYMES |

| AWS Bedrock | Estabilidad empresarial, cumplimiento normativo | Configuración compleja, costes más elevados | Grandes empresas |

| Google Vertex AI | Integración con el ecosistema GCP | Requiere cuenta de GCP | Equipos que ya utilizan GCP |

Opción 1: Servicio de intermediación API (Recomendado)

Los servicios de intermediación o Proxy API son actualmente la opción más adecuada para muchos desarrolladores. Permiten llamar a la API de Claude a través de nodos optimizados sin tener que gestionar problemas de pago internacionales o restricciones de red.

Ventajas principales:

- Facilidad de pago: Soporta métodos de pago locales (como Alipay o WeChat).

- Sin límites de velocidad: Los proveedores suelen haber completado la actualización de niveles (Tier), compartiendo cuotas elevadas.

- Red estable: Líneas de acceso optimizadas para una conexión más rápida.

- Funcionalidad completa: Soporta todas las características como Prompt Caching, Extended Thinking, etc.

🎯 Sugerencia técnica: Recomendamos llamar a la API de Claude a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece una interfaz compatible con el formato de OpenAI y soporta toda la serie de modelos Claude, incluyendo la función más reciente de Prompt Caching.

Ejemplo de acceso rápido:

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{"role": "user", "content": "¡Hola, Claude!"}

]

)

print(response.choices[0].message.content)

Opción 2: AWS Bedrock

Amazon Bedrock es el servicio de IA gestionado de AWS que soporta toda la serie de modelos Claude.

Escenarios de uso:

- Empresas que ya cuentan con infraestructura en AWS.

- Proyectos con requisitos estrictos de cumplimiento y seguridad.

- Necesidad de una integración profunda con otros servicios de AWS.

Puntos a tener en cuenta:

- Requiere una cuenta de AWS y configuración de permisos.

- Los precios son idénticos a los oficiales de Anthropic.

- Algunas funciones nuevas pueden tardar un poco más en estar disponibles.

Opción 3: Google Vertex AI

Vertex AI de Google Cloud también ofrece acceso a los modelos de Claude.

Escenarios de uso:

- Equipos que ya operan dentro del ecosistema de GCP.

- Necesidad de integración con servicios de Google Cloud.

Detalles de la función de caché de indicaciones (Prompt Caching) de la API de Claude

El Prompt Caching es una función vital de la API de Claude que puede reducir significativamente tanto los costes como la latencia. Al elegir una alternativa, es crucial asegurarse de que sea compatible con esta característica.

Principios básicos de Prompt Caching

| Concepto | Explicación |

|---|---|

| Escritura en caché | En la primera solicitud, el contenido de la indicación se escribe en la caché. |

| Acierto de caché | Las solicitudes posteriores reutilizan la caché, reduciendo drásticamente los costes. |

| Duración de la caché | 5 minutos (por defecto) o 1 hora (extendida). |

| Tokens mínimos | Se requieren al menos 1.024 tokens para activar la caché. |

Comparativa de precios de Prompt Caching

| Tipo de operación | Multiplicador de precio | Explicación |

|---|---|---|

| Entrada normal | 1x | Precio base |

| Escritura en caché (5 min) | 1.25x | Ligeramente más caro en la primera escritura |

| Escritura en caché (1 h) | 2x | Para tiempos de caché prolongados |

| Lectura de caché | 0.1x | Ahorro del 90% en costes |

Mejora del rendimiento: Según datos oficiales de Anthropic, al activar Prompt Caching:

- La latencia se reduce hasta un 85% (en un escenario de 100K tokens: de 11,5s a 2,4s).

- El coste se reduce hasta un 90%.

Ejemplo de código usando Prompt Caching

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # APIYI soporta la función de caché

)

# Indicación del sistema (será guardada en caché)

system_prompt = """

Eres un asistente experto en documentación técnica. Aquí tienes el contenido del producto:

[Colocar aquí gran cantidad de texto, se recomiendan más de 1024 tokens]

...

"""

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{

"role": "system",

"content": system_prompt,

# Marcar el punto de interrupción de la caché

"cache_control": {"type": "ephemeral"}

},

{"role": "user", "content": "Por favor, resume las funciones principales del documento."}

]

)

# Comprobar el estado de la caché

usage = response.usage

print(f"Escritura en caché: {usage.cache_creation_input_tokens} tokens")

print(f"Acierto de caché: {usage.cache_read_input_tokens} tokens")

Ver ejemplo completo de configuración de caché

import openai

from typing import List, Dict

class ClaudeCacheClient:

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

self.system_cache = None

def set_system_prompt(self, content: str):

"""Configura la indicación del sistema con caché"""

self.system_cache = {

"role": "system",

"content": content,

"cache_control": {"type": "ephemeral"}

}

def chat(self, user_message: str) -> str:

"""Envía un mensaje reutilizando la caché automáticamente"""

messages = []

if self.system_cache:

messages.append(self.system_cache)

messages.append({"role": "user", "content": user_message})

response = self.client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=messages

)

# Imprimir estadísticas de caché

usage = response.usage

if hasattr(usage, 'cache_read_input_tokens'):

total_cache_tokens = (

usage.cache_read_input_tokens +

usage.cache_creation_input_tokens + 1

)

hit_rate = (usage.cache_read_input_tokens / total_cache_tokens) * 100

print(f"Tasa de acierto de caché: {hit_rate:.1f}%")

return response.choices[0].message.content

# Ejemplo de uso

client = ClaudeCacheClient("sk-your-apiyi-key")

client.set_system_prompt("Eres un asistente técnico..." * 100) # Texto largo

# Las llamadas sucesivas reutilizarán la caché

print(client.chat("Pregunta 1"))

print(client.chat("Pregunta 2")) # Acierto de caché, el coste baja un 90%

💡 Consejo de elección: La plataforma APIYI (apiyi.com) soporta íntegramente la función de Prompt Caching de Claude, incluyendo tanto la escritura como el acierto. No requiere configuraciones adicionales; puedes disfrutar de las optimizaciones de coste y rendimiento usando la interfaz estándar.

Guía rápida de inicio para la solución de retransmisión de la API de Claude

Paso 1: Obtener la clave API (API Key)

- Visita APIYI apiyi.com y registra una cuenta.

- Accede al panel de control para crear tu API Key.

- Recarga tu saldo (compatible con Alipay y WeChat).

Paso 2: Configurar el entorno de desarrollo

Entorno de Python:

pip install openai

Configuración de variables de entorno:

export OPENAI_API_KEY="sk-tu-clave-apiyi"

export OPENAI_BASE_URL="https://api.apiyi.com/v1"

Paso 3: Probar la conexión de la API

import openai

client = openai.OpenAI(

api_key="sk-tu-clave-apiyi",

base_url="https://api.apiyi.com/v1"

)

# Probar Claude Sonnet 4

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[{"role": "user", "content": "Hola, por favor preséntate"}],

max_tokens=500

)

print(response.choices[0].message.content)

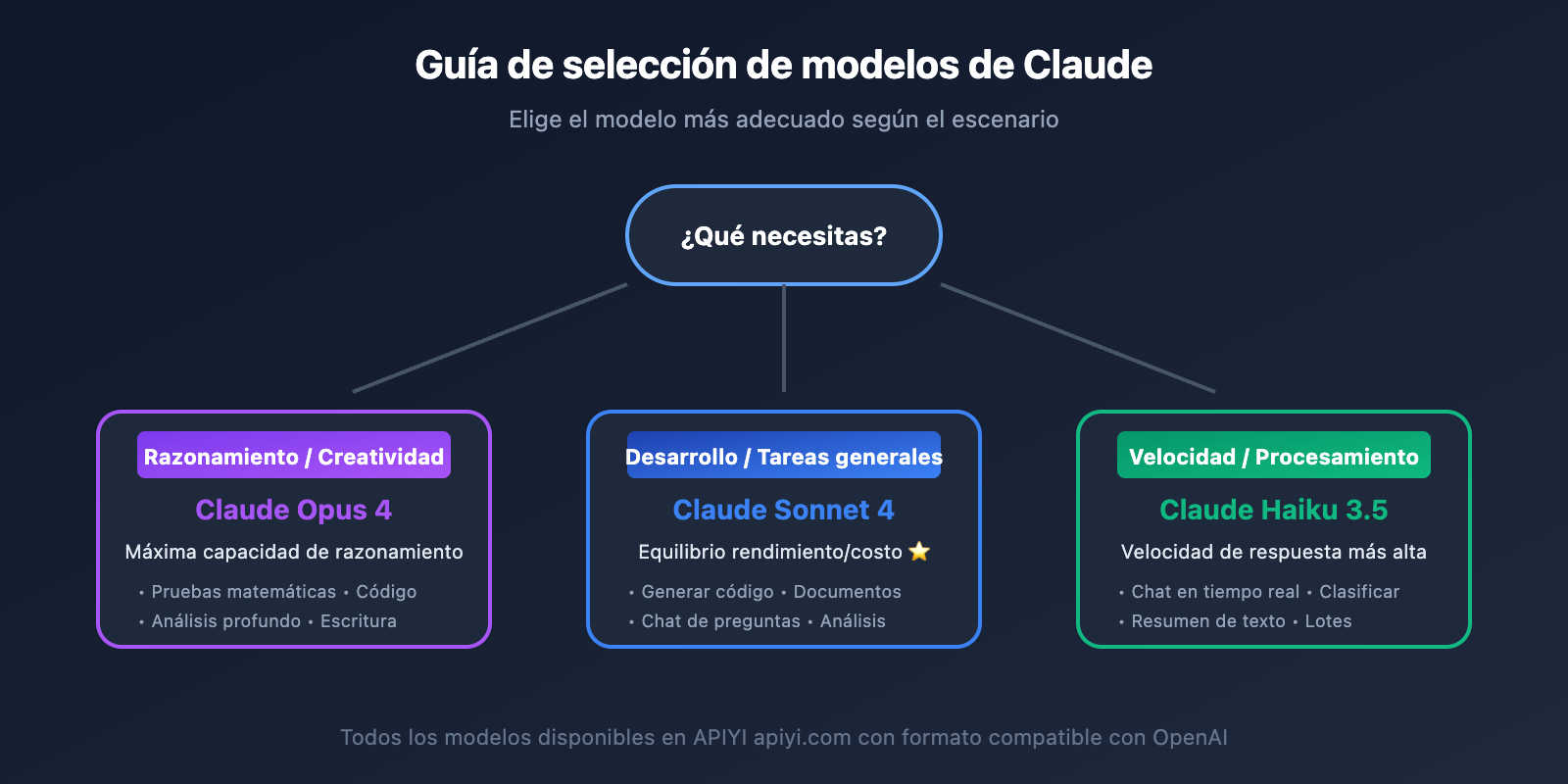

Lista de modelos de Claude compatibles

| Nombre del modelo | ID del modelo | Características | Plataformas disponibles |

|---|---|---|---|

| Claude Opus 4 | claude-opus-4-20250514 | Máxima capacidad de razonamiento | APIYI apiyi.com |

| Claude Sonnet 4 | claude-sonnet-4-20250514 | Equilibrio entre rendimiento y costo | APIYI apiyi.com |

| Claude Haiku 3.5 | claude-3-5-haiku-20241022 | Respuesta rápida | APIYI apiyi.com |

| Claude Sonnet 3.5 | claude-3-5-sonnet-20241022 | Versión clásica estable | APIYI apiyi.com |

Comparativa detallada: Plataforma oficial vs. Solución de retransmisión

| Dimensión de comparativa | Plataforma oficial de Claude | Solución de retransmisión API |

|---|---|---|

| Método de pago | Tarjeta de crédito internacional | Alipay/WeChat |

| Acceso a la red | Requiere proxy | Conexión directa (China/Global) |

| Mecanismo de límite | Límites por niveles (Tier) | Cuota alta compartida |

| Riesgo de la cuenta | Posible baneo por recargas externas | Sin riesgo |

| Soporte de funciones | Completo | Completo (incluye caché) |

| Soporte técnico | Tickets en inglés | Atención al cliente en chino |

| Método de facturación | Pre-recarga | Pago por uso |

| Dificultad de inicio | Compleja | Sencilla |

Preguntas frecuentes

P1: ¿Realmente no funciona el servicio de recarga (代充) para la API de Claude?

Definitivamente no es recomendable. El uso de servicios de recarga de terceros presenta varios problemas críticos:

- Seguridad de la cuenta: Anthropic detecta inicios de sesión y comportamientos de pago inusuales; el riesgo de que bloqueen una cuenta recargada por terceros es extremadamente alto.

- Problemas de límites de velocidad: Incluso si la recarga tiene éxito, las restricciones del Tier 1 para cuentas nuevas son muy estrictas, lo que dificulta un uso normal.

- Riesgo financiero: Una vez que la cuenta es bloqueada, el saldo recargado no se puede recuperar.

A través de servicios puente oficiales como APIYI (apiyi.com), puedes evitar estos problemas y disfrutar de cuotas más altas y un servicio más estable.

P2: ¿Los servicios puente son compatibles con el Prompt Caching?

Sí. APIYI (apiyi.com) ofrece soporte completo para la función de Prompt Caching de Claude, incluyendo:

- Caché estándar de 5 minutos.

- Caché extendido de 1 hora.

- Estadísticas de escritura y aciertos (hits) de caché.

- Ahorro de costes de hasta un 90%.

El modo de uso es idéntico al de la API oficial; solo necesitas añadir el parámetro cache_control en tus mensajes.

P3: ¿La latencia de los servicios puente es mayor que la oficial?

En la práctica, la latencia de un buen servicio puente es básicamente la misma que la oficial e, incluso, a veces es más rápida. Esto se debe a:

- Los proveedores de servicios puente despliegan nodos optimizados en múltiples regiones.

- La conexión directa desde tu región evita la latencia adicional que suelen introducir los proxies o VPNs.

- Los niveles de Tier superiores disfrutan de una mayor prioridad de procesamiento.

Te sugerimos realizar una prueba comparativa real para elegir la opción con menor latencia.

P4: ¿Cómo se garantiza la seguridad de los datos?

Al elegir un proveedor de servicios puente serio, presta atención a los siguientes puntos:

- Revisa la política de privacidad y las declaraciones de manejo de datos del proveedor.

- Confirma que sea compatible con la transmisión cifrada mediante HTTPS.

- Infórmate sobre la política de retención de registros (logs).

- Para datos altamente sensibles, considera realizar un preprocesamiento local.

APIYI (apiyi.com) se compromete a no almacenar los datos de las conversaciones de los usuarios, manteniendo únicamente los registros necesarios para la facturación.

P5: ¿Cómo es el precio de los servicios puente en comparación con el oficial?

Los servicios puente suelen tener precios similares a los oficiales o incluso ofrecen ligeros descuentos, eliminando además:

- Comisiones por transacciones con tarjetas de crédito internacionales.

- Pérdidas por conversión de divisas.

- Costes de herramientas de proxy o VPN.

Haciendo un cálculo integral, el coste real de usar un servicio puente suele ser menor.

Resumen

Recargar la API de Claude a través de terceros conlleva riesgos de cuenta, límites de velocidad estrictos y dificultades en el pago, por lo que no es la opción ideal para desarrolladores que buscan estabilidad. La solución más recomendada es utilizar un servicio puente de API profesional como APIYI:

- Pago sencillo: Compatible con métodos de pago locales, sin necesidad de tarjetas de crédito internacionales.

- Límites altos: Comparte las cuotas de Tiers superiores, eliminando las preocupaciones por los límites de velocidad.

- Funcionalidad completa: Soporte para escritura y aciertos de Prompt Caching.

- Estable y confiable: Conexión directa y soporte técnico en tu idioma.

Te recomendamos acceder rápidamente a la API de Claude a través de APIYI (apiyi.com). La plataforma es compatible con toda la serie de modelos de Claude, mantiene total compatibilidad con las funciones oficiales y permite completar la integración en apenas 5 minutos.

Referencias

-

Facturación de la API de Anthropic: Reglas de uso para el saldo prepagado de la API de Claude

- Enlace:

support.claude.com/en/articles/8977456-how-do-i-pay-for-my-claude-api-usage

- Enlace:

-

Documentación de límites de velocidad de la API de Claude: Explicación oficial de los niveles de uso (Usage Tiers)

- Enlace:

docs.claude.com/en/api/rate-limits

- Enlace:

-

Documentación de Prompt Caching: Guía de uso de la función de caché

- Enlace:

docs.claude.com/en/docs/build-with-claude/prompt-caching

- Enlace:

Autor: Equipo de APIYI

Soporte técnico: Si necesitas ayuda con la integración de la API de Claude, visita APIYI en apiyi.com