想让 MoltBot 接入 Claude Opus 4.5 或其他大模型,却不知道如何配置 API 代理? 本文将手把手教你完成 MoltBot 多 Provider 配置,让你的 AI 助手同时接入多个模型服务,实现智能切换和容灾备份。

核心价值: 读完本文,你将掌握 MoltBot 的 models.providers 配置方法,学会设置主模型、备用模型和模型别名,打造稳定可靠的 AI 助手。

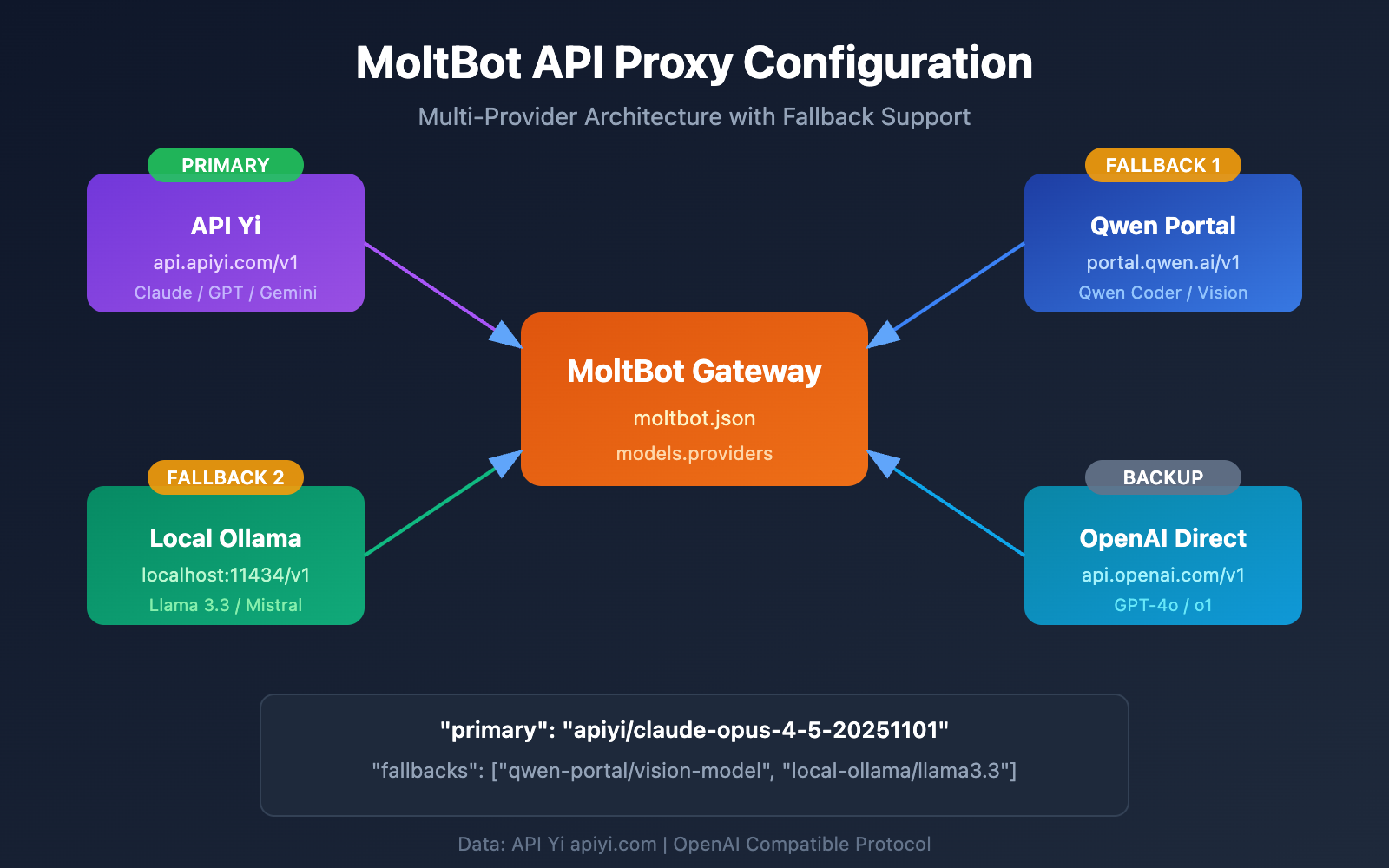

MoltBot API 代理配置: 核心概念解析

MoltBot 支持通过 OpenAI Compatible API 接入几乎所有主流大模型服务。理解以下核心概念,是配置成功的关键。

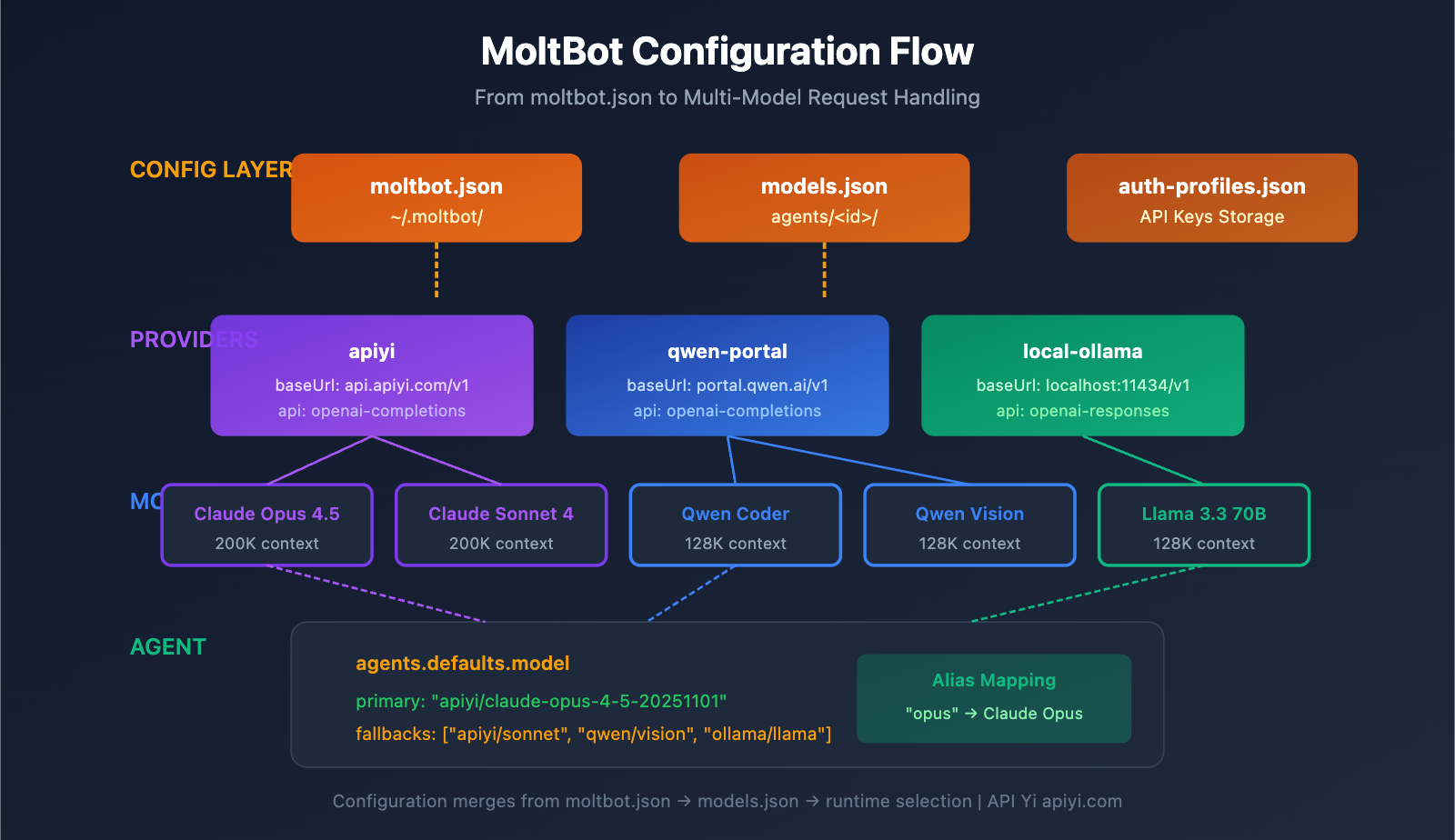

MoltBot 配置文件体系

| 配置文件 | 位置 | 用途 |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

全局配置入口 |

| models.json | ~/.moltbot/agents/<agentId>/ |

Agent 级模型配置 |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

认证信息存储 |

MoltBot Provider 配置核心字段

每个 Provider 配置包含以下关键字段:

| 字段 | 类型 | 说明 | 必填 |

|---|---|---|---|

baseUrl |

string | API 端点地址 | 是 |

apiKey |

string | API 密钥 (支持环境变量) | 是 |

api |

string | API 协议类型 | 是 |

models |

array | 可用模型列表 | 是 |

API 协议类型说明

MoltBot 支持两种主流的 OpenAI 兼容协议:

| 协议类型 | 说明 | 适用场景 |

|---|---|---|

openai-completions |

标准 Chat Completions API | 大多数代理服务 |

openai-responses |

Responses API (含工具调用) | 本地模型、高级场景 |

🎯 配置建议: 大多数 API 代理服务 (如 API易 apiyi.com) 使用

openai-completions协议。如果你使用的是本地部署的 LM Studio 或 Ollama,则需要使用openai-responses。

MoltBot 多 Provider 配置: 完整示例

下面是一个实际可用的多 Provider 配置示例,同时接入 API易 和 Qwen Portal 两个服务:

完整配置文件示例

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

配置结构详解

1. models.providers 部分

这是定义 API 代理服务的核心部分:

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- Provider ID (

apiyi): 自定义的服务标识,后续引用时使用 - baseUrl: API 端点,必须以

/v1结尾 - apiKey: 支持直接填写或使用

${ENV_VAR}环境变量 - models: 该 Provider 支持的模型列表

2. agents.defaults.model 部分

定义默认使用的模型和容灾策略:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary: 主模型,格式为

provider-id/model-id - fallbacks: 备用模型数组,主模型失败时自动切换

3. agents.defaults.models 部分

定义模型别名,方便快速切换:

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

配置别名后,可以在对话中使用 /model opus 快速切换模型。

MoltBot API 代理配置: 分步教程

第一步: 获取 API Key

在配置之前,你需要准备好 API Key:

| 服务商 | 获取方式 | 支持模型 |

|---|---|---|

| API易 | 访问 apiyi.com 注册获取 | Claude 全系列、GPT 全系列、Gemini 等 |

| Qwen Portal | 访问 portal.qwen.ai | Qwen 系列模型 |

| OpenAI | 访问 platform.openai.com | GPT 系列 |

| Anthropic | 访问 console.anthropic.com | Claude 系列 |

🚀 快速开始: 推荐使用 API易 apiyi.com 作为主要 Provider,一个 API Key 即可调用 Claude、GPT、Gemini 等主流模型,无需分别注册多个平台。

第二步: 设置环境变量

为了安全起见,建议使用环境变量存储 API Key:

# Linux/macOS - 添加到 ~/.bashrc 或 ~/.zshrc

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# 使配置生效

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

第三步: 编辑配置文件

打开或创建 MoltBot 配置文件:

# 打开配置文件

nano ~/.moltbot/moltbot.json

# 或使用 VS Code

code ~/.moltbot/moltbot.json

将以下配置粘贴到文件中:

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

第四步: 验证配置

重启 MoltBot 并验证配置是否生效:

# 重启 MoltBot

moltbot restart

# 检查当前模型配置

moltbot models list

# 测试模型调用

moltbot chat "你好,请告诉我你是什么模型"

查看完整的多 Provider 配置示例

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 配置技巧: 使用

"mode": "merge"可以保留 MoltBot 内置的模型配置,同时添加你的自定义 Provider。这样即使自定义服务不可用,也能回退到默认配置。

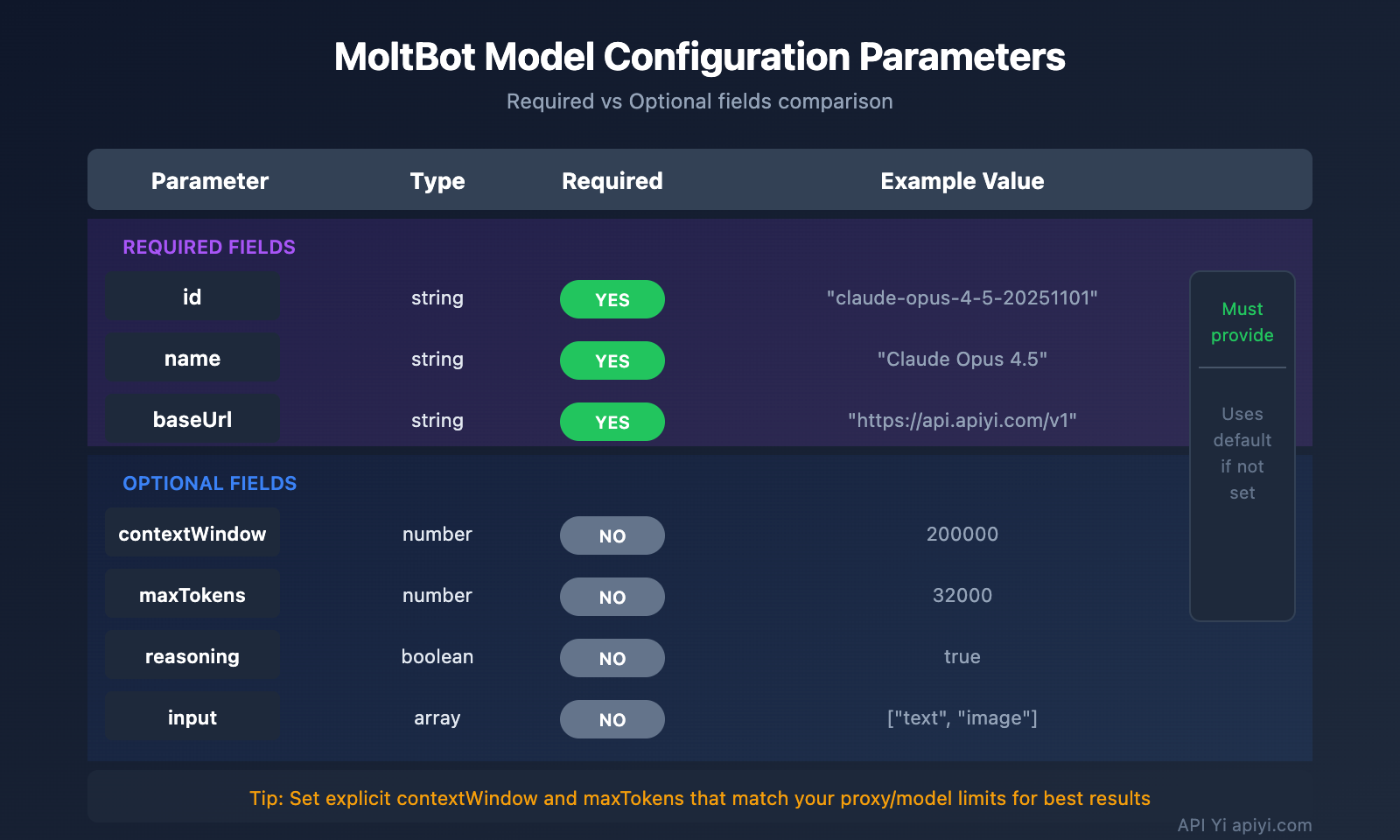

MoltBot 模型配置: 高级参数详解

模型条目完整字段

| 参数 | 类型 | 必填 | 说明 | 示例 |

|---|---|---|---|---|

id |

string | 是 | 模型 ID,调用时使用 | claude-opus-4-5-20251101 |

name |

string | 是 | 显示名称 | Claude Opus 4.5 |

contextWindow |

number | 否 | 上下文窗口大小 | 200000 |

maxTokens |

number | 否 | 最大输出 Token | 32000 |

reasoning |

boolean | 否 | 是否支持推理模式 | true |

input |

array | 否 | 支持的输入类型 | ["text", "image"] |

cost |

object | 否 | 费用信息 | {"input": 15, "output": 75} |

模型参数配置 (params)

在 agents.defaults.models 中可以为每个模型设置默认参数:

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| 参数 | 范围 | 说明 |

|---|---|---|

temperature |

0-2 | 控制输出随机性,越低越确定 |

maxTokens |

1-模型上限 | 单次最大输出长度 |

⚠️ 注意:

temperature是高级参数,除非你了解模型的默认设置并确实需要调整,否则建议不要设置。

MoltBot Fallback 容灾配置

Fallback 机制是 MoltBot 的重要特性,确保 AI 助手始终可用。

Fallback 工作原理

用户请求

↓

主模型 (primary)

↓ (失败)

备用模型 1 (fallbacks[0])

↓ (失败)

备用模型 2 (fallbacks[1])

↓ (失败)

...继续尝试

推荐的 Fallback 配置策略

| 策略 | 配置示例 | 适用场景 |

|---|---|---|

| 同系列降级 | Opus → Sonnet → Haiku | 保持风格一致 |

| 跨平台备份 | Claude → GPT → Gemini | 最大可用性 |

| 成本优化 | Opus → 本地模型 | 控制费用 |

| 混合策略 | 云端 → 本地 → 云端备用 | 综合考虑 |

推荐配置:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 成本优化: 通过 API易 apiyi.com 配置 Fallback,可以在多个模型间自动切换,同时享受统一的计费方式,便于成本管控。

MoltBot 模型切换: 实战技巧

使用别名快速切换

配置别名后,可以在对话中随时切换模型:

你: /model opus

MoltBot: 已切换到 Claude Opus 4.5

你: /model sonnet

MoltBot: 已切换到 Claude Sonnet 4

你: /model qwen

MoltBot: 已切换到 Qwen Coder

为特定任务指定模型

你: /model gpt 帮我分析这张图片

MoltBot: [使用 GPT-4o 分析图片...]

你: /model opus 写一篇深度技术文章

MoltBot: [使用 Claude Opus 写作...]

查看当前模型状态

# 命令行查看

moltbot models list

# 对话中查看

你: /model

MoltBot: 当前模型: apiyi/claude-opus-4-5-20251101 (alias: opus)

MoltBot API 代理配置: 常见问题

Q1: 配置后提示 “API Key invalid” 怎么办?

这通常是 API Key 配置问题。检查以下几点:

- 确认环境变量已正确设置:

echo $APIYI_API_KEY - 检查 API Key 格式是否正确 (通常以

sk-开头) - 确认 API Key 有足够的余额和权限

- 如果直接写在配置文件,检查是否有多余的空格或换行

通过 API易 apiyi.com 获取的 API Key 格式为 sk-xxx,请确保完整复制。

Q2: 如何同时使用本地模型和云端模型?

使用 "mode": "merge" 配置可以同时使用本地和云端模型:

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

这样当本地模型不可用时,可以自动 Fallback 到云端服务。

Q3: 环境变量 ${VAR} 不生效怎么办?

MoltBot 的环境变量替换规则:

- 只匹配大写字母和下划线:

[A-Z_][A-Z0-9_]* - 变量名必须全大写,如

${APIYI_API_KEY} - 小写变量名

${apiKey}不会被替换 - 未设置的环境变量会导致配置加载报错

建议使用标准命名: APIYI_API_KEY、QWEN_API_KEY、TELEGRAM_BOT_TOKEN

Q4: 如何为不同任务使用不同模型?

可以通过 imageModel 和别名实现:

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- 文本任务自动使用 primary 模型 (Claude Opus)

- 图像任务自动使用 imageModel (GPT-4o)

- 也可以用

/model vision手动切换

Q5: 支持哪些 OpenAI Compatible 服务?

MoltBot 支持所有遵循 OpenAI API 规范的服务:

| 服务类型 | 示例 | 推荐程度 |

|---|---|---|

| API 代理 | API易 apiyi.com | 推荐 (多模型统一接入) |

| 官方 API | OpenAI, Anthropic, Google | 官方稳定 |

| 本地部署 | Ollama, LM Studio, vLLM | 隐私优先 |

| 其他代理 | Groq, Together AI | 按需选择 |

API易 apiyi.com 的优势是一个 Key 即可调用多家模型,无需分别注册。

MoltBot API 代理配置: 总结与建议

通过本文,你已经掌握了 MoltBot 配置 API 代理的完整方法:

- 理解配置结构:

models.providers定义服务,agents.defaults定义使用策略 - 设置多 Provider: 同时接入多个 API 服务,提高可用性

- 配置 Fallback: 主模型失败时自动切换到备用模型

- 使用别名: 通过

/model alias快速切换模型

最佳实践建议

| 建议 | 说明 |

|---|---|

| 使用环境变量 | 不要在配置文件中明文存储 API Key |

| 配置 Fallback | 至少设置 1-2 个备用模型 |

| 设置 mode: merge | 保留默认配置,增强兼容性 |

| 统一 API 入口 | 使用 API易 简化多模型管理 |

推荐通过 API易 apiyi.com 作为主要的 API 代理服务,该平台提供 Claude、GPT、Gemini 等主流模型的统一接入,配置简单且支持灵活的计费方式,特别适合 MoltBot 的多模型切换场景。

参考资料

-

MoltBot 官方文档 – Models: 模型配置详解

- 链接:

docs.molt.bot/concepts/models - 说明: 官方模型配置指南

- 链接:

-

MoltBot 官方文档 – Configuration: 完整配置参考

- 链接:

docs.molt.bot/gateway/configuration - 说明: 所有配置项详解

- 链接:

-

MoltBot 官方文档 – Model Providers: Provider 配置

- 链接:

docs.molt.bot/concepts/model-providers - 说明: 自定义 Provider 配置方法

- 链接:

-

MoltBot GitHub: 源码和 Issue 讨论

- 链接:

github.com/moltbot/moltbot - 说明: 最新版本和问题反馈

- 链接:

本文作者: APIYI Team | 更多 AI 技术分享欢迎访问 API易 apiyi.com

更新日期: 2026 年 1 月