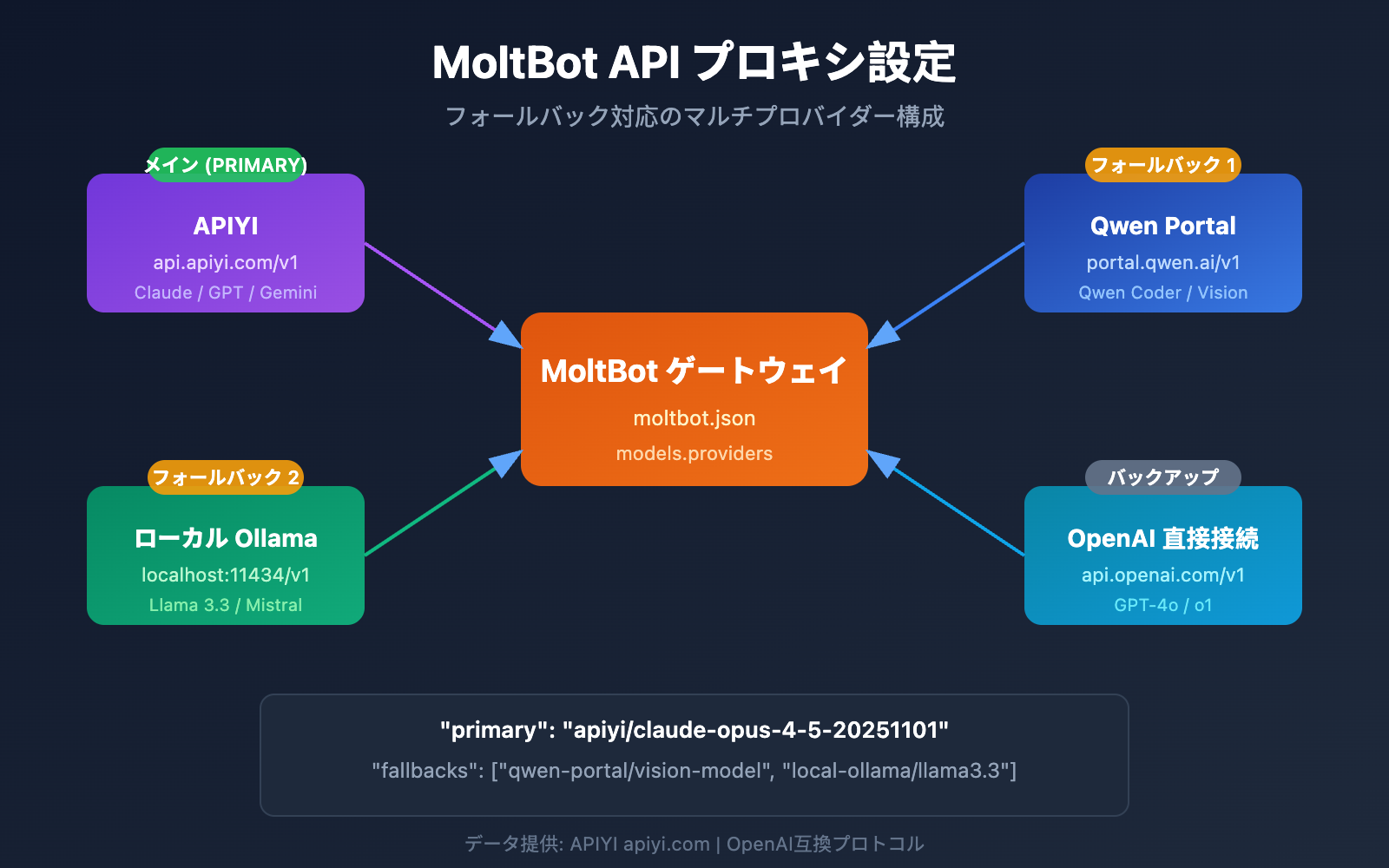

MoltBotで Claude Opus 4.5 やその他の大規模言語モデルを使いたいけれど、APIプロキシの設定方法がわからないとお困りではありませんか?この記事では、MoltBotのマルチプロバイダー(Multi-Provider)設定について、ステップバイステップで解説します。複数のモデルサービスを同時に連携させ、スマートな切り替えや障害時のバックアップを実現しましょう。

核となるメリット: この記事を読み終える頃には、MoltBotの models.providers の設定方法をマスターし、メインモデル、バックアップモデル、モデルエイリアスの設定ができるようになります。これにより、安定して信頼性の高いAIアシスタントを構築できます。

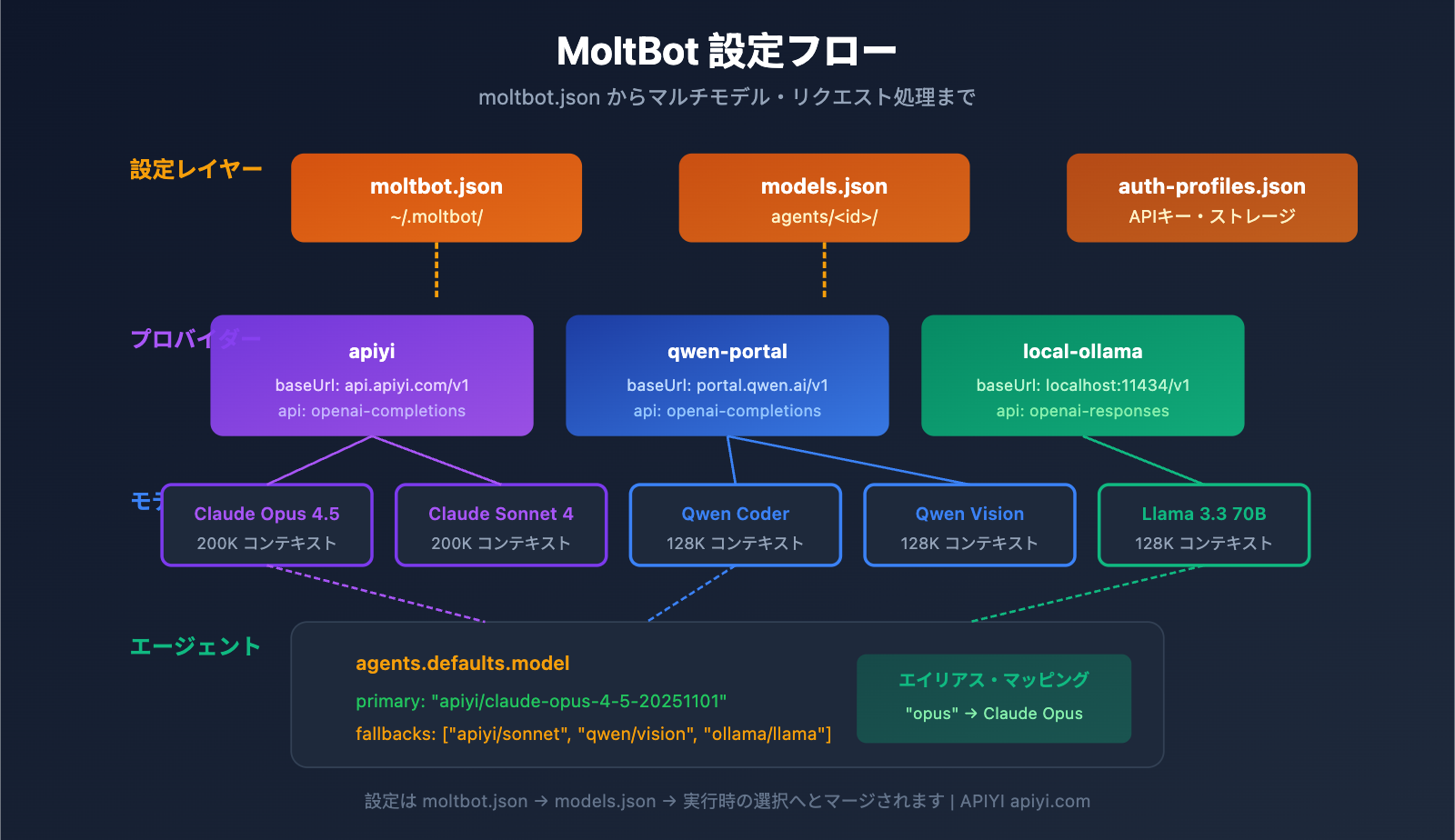

MoltBot API プロキシ設定:コア概念の解説

MoltBot は、OpenAI Compatible API を通じて、ほぼすべての主要な大規模言語モデルサービスへの接続をサポートしています。設定を成功させるためには、以下のコア概念を理解することが重要です。

MoltBot 設定ファイル体系

| 設定ファイル | パス | 用途 |

|---|---|---|

| moltbot.json | ~/.moltbot/ |

グローバル設定のエントリポイント |

| models.json | ~/.moltbot/agents/<agentId>/ |

エージェント単位のモデル設定 |

| auth-profiles.json | ~/.moltbot/agents/<agentId>/ |

認証情報の保存 |

MoltBot Provider 設定の主要フィールド

各 Provider 設定には、以下の重要なフィールドが含まれます。

| フィールド | 型 | 説明 | 必須 |

|---|---|---|---|

baseUrl |

string | API エンドポイントのアドレス | はい |

apiKey |

string | API キー(環境変数に対応) | はい |

api |

string | API プロトコルの種類 | はい |

models |

array | 利用可能なモデルのリスト | はい |

API プロトコル種別の説明

MoltBot は、主に2つの OpenAI 互換プロトコルをサポートしています。

| プロトコル種別 | 説明 | 推奨される利用シーン |

|---|---|---|

openai-completions |

標準的な Chat Completions API | ほとんどのプロキシサービス |

openai-responses |

Responses API(ツール呼び出しを含む) | ローカルモデル、高度なユースケース |

🎯 設定のアドバイス: ほとんどの API プロキシサービス(APIYI など)は

openai-completionsプロトコルを使用します。LM Studio や Ollama などのローカル環境を使用している場合は、openai-responsesを使用する必要があります。

MoltBot マルチプロバイダー設定:完全な例

以下は、APIYI と Qwen Portal の 2 つのサービスに同時に接続する、実際に利用可能なマルチプロバイダー設定の例です。

構成ファイルの完全な例

{

"models": {

"providers": {

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "coder-model", "name": "Qwen Coder", "contextWindow": 128000 },

{ "id": "vision-model", "name": "Qwen Vision", "contextWindow": 128000 }

]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{ "id": "claude-opus-4-5-20251101", "name": "Claude Opus 4.5", "contextWindow": 200000 },

{ "id": "claude-sonnet-4-20250514", "name": "Claude Sonnet 4", "contextWindow": 200000 },

{ "id": "gpt-4o", "name": "GPT-4o", "contextWindow": 128000 }

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

},

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/claude-sonnet-4-20250514": { "alias": "sonnet" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

}

}

}

設定構造の詳細解説

1. models.providers セクション

これは API プロキシサービスを定義するコア部分です。

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

- プロバイダー ID (

apiyi): カスタムサービス識別子。後の参照に使用されます。 - baseUrl: API エンドポイント。

/v1で終わる必要があります。 - apiKey: 直接入力、または

${ENV_VAR}環境変数の使用をサポートしています。 - models: このプロバイダーがサポートするモデルのリストです。

2. agents.defaults.model セクション

デフォルトで使用するモデルとフォールバック(障害耐性)戦略を定義します。

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": ["qwen-portal/vision-model"]

}

- primary: メインモデル。形式は

provider-id/model-idです。 - fallbacks: 予備モデルの配列。メインモデルが失敗した時に自動的に切り替わります。

3. agents.defaults.models セクション

モデルのエイリアス(別名)を定義し、素早い切り替えを可能にします。

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"qwen-portal/coder-model": { "alias": "qwen" }

}

エイリアスを設定すると、会話の中で /model opus を使って素早くモデルを切り替えることができます。

MoltBot API プロキシ設定:ステップバイステップチュートリアル

ステップ 1:API キーの取得

設定を始める前に、API キーを準備する必要があります。

| サービスプロバイダー | 取得方法 | 対応モデル |

|---|---|---|

| APIYI | apiyi.com にアクセスして登録・取得 | Claude 全シリーズ、GPT 全シリーズ、Gemini など |

| Qwen Portal | portal.qwen.ai にアクセス | Qwen シリーズモデル |

| OpenAI | platform.openai.com にアクセス | GPT シリーズ |

| Anthropic | console.anthropic.com にアクセス | Claude シリーズ |

🚀 クイックスタート: メインプロバイダーとして APIYI (apiyi.com) の使用をお勧めします。1 つの API キーで Claude、GPT、Gemini などの主要なモデルを呼び出すことができ、複数のプラットフォームに個別に登録する必要がありません。

ステップ 2:環境変数の設定

セキュリティのため、API キーは環境変数に保存することをお勧めします。

# Linux/macOS - ~/.bashrc または ~/.zshrc に追加

export APIYI_API_KEY="sk-your-apiyi-key"

export QWEN_API_KEY="your-qwen-key"

export TELEGRAM_BOT_TOKEN="your-telegram-token"

# 設定を反映させる

source ~/.bashrc

# Windows PowerShell

$env:APIYI_API_KEY = "sk-your-apiyi-key"

$env:QWEN_API_KEY = "your-qwen-key"

$env:TELEGRAM_BOT_TOKEN = "your-telegram-token"

ステップ 3:設定ファイルの編集

MoltBot の設定ファイルを開くか作成します。

# 設定ファイルを開く

nano ~/.moltbot/moltbot.json

# または VS Code で開く

code ~/.moltbot/moltbot.json

以下の設定をファイルに貼り付けてください。

{

"models": {

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

}

}

}

}

ステップ 4:設定の確認

MoltBot を再起動し、設定が反映されているか確認します。

# MoltBot を再起動

moltbot restart

# 現在のモデル設定を確認

moltbot models list

# モデルの呼び出しテスト

moltbot chat "こんにちは。あなたがどのモデルか教えてください"

マルチプロバイダー設定の完全な例を表示

{

"models": {

"mode": "merge",

"providers": {

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "claude-opus-4-5-20251101",

"name": "Claude Opus 4.5",

"contextWindow": 200000,

"maxTokens": 32000

},

{

"id": "claude-sonnet-4-20250514",

"name": "Claude Sonnet 4",

"contextWindow": 200000,

"maxTokens": 64000

},

{

"id": "gpt-4o",

"name": "GPT-4o",

"contextWindow": 128000,

"maxTokens": 16384

},

{

"id": "gemini-2.5-pro",

"name": "Gemini 2.5 Pro",

"contextWindow": 1000000,

"maxTokens": 65536

}

]

},

"qwen-portal": {

"baseUrl": "https://portal.qwen.ai/v1",

"apiKey": "${QWEN_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "coder-model",

"name": "Qwen Coder",

"contextWindow": 128000

},

{

"id": "vision-model",

"name": "Qwen Vision",

"contextWindow": 128000

}

]

},

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [

{

"id": "llama3.3:70b",

"name": "Llama 3.3 70B",

"contextWindow": 128000

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"qwen-portal/vision-model",

"local-ollama/llama3.3:70b"

]

},

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": { "temperature": 0.7 }

},

"apiyi/claude-sonnet-4-20250514": {

"alias": "sonnet",

"params": { "temperature": 0.5 }

},

"apiyi/gpt-4o": {

"alias": "gpt"

},

"qwen-portal/coder-model": {

"alias": "qwen"

},

"local-ollama/llama3.3:70b": {

"alias": "llama"

}

},

"imageModel": "apiyi/gpt-4o"

}

},

"channels": {

"telegram": {

"enabled": true,

"botToken": "${TELEGRAM_BOT_TOKEN}"

},

"discord": {

"enabled": false,

"token": "${DISCORD_BOT_TOKEN}"

}

}

}

💡 設定のヒント:

"mode": "merge"を使用すると、MoltBot 内蔵のモデル設定を保持したまま、独自のカスタムプロバイダーを追加できます。これにより、カスタムサービスが利用できない場合でもデフォルト設定にフォールバックできます。

MoltBot モデル設定:高度なパラメータ詳細

モデル項目の全フィールド

| パラメータ | 型 | 必須 | 説明 | 設定例 |

|---|---|---|---|---|

id |

string | はい | モデル ID。呼び出し時に使用します。 | claude-opus-4-5-20251101 |

name |

string | はい | 表示名 | Claude Opus 4.5 |

contextWindow |

number | いいえ | コンテキストウィンドウサイズ | 200000 |

maxTokens |

number | いいえ | 最大出力トークン数 | 32000 |

reasoning |

boolean | いいえ | 推論モードをサポートするかどうか | true |

input |

array | いいえ | サポートされている入力タイプ | ["text", "image"] |

cost |

object | いいえ | 料金情報 | {"input": 15, "output": 75} |

モデルパラメータ設定 (params)

agents.defaults.models では、各モデルのデフォルトパラメータを設定できます。

"models": {

"apiyi/claude-opus-4-5-20251101": {

"alias": "opus",

"params": {

"temperature": 0.7,

"maxTokens": 16000

}

}

}

| パラメータ | 範囲 | 説明 |

|---|---|---|

temperature |

0-2 | 出力のランダム性を制御します。値が低いほど確定的になります。 |

maxTokens |

1-モデル上限 | 1 回の呼び出しでの最大出力長 |

⚠️ 注意:

temperatureは高度なパラメータです。モデルのデフォルト設定を理解しており、調整が必要な場合を除き、設定しないことをお勧めします。

MoltBot Fallback 障害対策(フェイルオーバー)設定

Fallback(フォールバック)機能は、AI アシスタントが常に利用可能な状態を維持するための MoltBot の重要な機能です。

Fallback の仕組み

ユーザーのリクエスト

↓

メインモデル (primary)

↓ (失敗)

バックアップモデル 1 (fallbacks[0])

↓ (失敗)

バックアップモデル 2 (fallbacks[1])

↓ (失敗)

...試行を継続

推奨される Fallback 設定戦略

| 戦略 | 設定例 | 適用シーン |

|---|---|---|

| 同シリーズ内での降格 | Opus → Sonnet → Haiku | 一貫した応答スタイルを維持したい場合 |

| クロスプラットフォーム・バックアップ | Claude → GPT → Gemini | 最大限の可用性を確保したい場合 |

| コスト最適化 | Opus → ローカルモデル | 費用を抑えたい場合 |

| ハイブリッド戦略 | クラウド → ローカル → クラウド(予備) | 総合的なバランスを考慮する場合 |

推奨設定例:

"model": {

"primary": "apiyi/claude-opus-4-5-20251101",

"fallbacks": [

"apiyi/claude-sonnet-4-20250514",

"apiyi/gpt-4o",

"qwen-portal/vision-model"

]

}

💰 コスト最適化: APIYI (apiyi.com) を通じて Fallback を設定することで、複数のモデル間を自動で切り替えながら、統一された課金方式を利用できるため、コスト管理が容易になります。

MoltBot モデル切り替え:実践テクニック

エイリアスを使用した素早い切り替え

エイリアスを設定しておくと、会話の中でいつでもモデルを切り替えることができます。

あなた: /model opus

MoltBot: Claude Opus 4.5 に切り替えました

あなた: /model sonnet

MoltBot: Claude Sonnet 4 に切り替えました

あなた: /model qwen

MoltBot: Qwen Coder に切り替えました

特定のタスクにモデルを指定する

あなた: /model gpt この画像を分析してください

MoltBot: [GPT-4o を使用して画像を分析中...]

あなた: /model opus 深掘りした技術記事を書いてください

MoltBot: [Claude Opus を使用して執筆中...]

現在のモデルの状態を確認する

# コマンドラインで確認

moltbot models list

# 会話の中で確認

あなた: /model

MoltBot: 現在のモデル: apiyi/claude-opus-4-5-20251101 (alias: opus)

MoltBot API プロキシ設定: よくある質問

Q1: 設定後に「API Key invalid」と表示された場合はどうすればいいですか?

これは通常、APIキーの設定に関する問題です。以下の点を確認してください。

- 環境変数が正しく設定されているか確認する:

echo $APIYI_API_KEY - APIキーの形式が正しいか確認する(通常は

sk-で始まります) - APIキーに十分な残高と権限があるか確認する

- 設定ファイルに直接記述している場合、余計なスペースや改行が含まれていないか確認する

APIYI(apiyi.com)で取得した APIキーの形式は sk-xxx です。コピーする際は、漏れがないよう注意してください。

Q2: ローカルモデルとクラウドモデルを同時に使用するには?

"mode": "merge" 設定を使用することで、ローカルとクラウドのモデルを併用できます。

{

"models": {

"mode": "merge",

"providers": {

"local-ollama": {

"baseUrl": "http://localhost:11434/v1",

"apiKey": "ollama-local",

"api": "openai-responses",

"models": [...]

},

"apiyi": {

"baseUrl": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"api": "openai-completions",

"models": [...]

}

}

}

}

これにより、ローカルモデルが利用できない場合に、自動的にクラウドサービスへフォールバック(代替)させることが可能です。

Q3: 環境変数 ${VAR} が反映されない場合は?

MoltBot の環境変数置換ルールは以下の通りです。

- 大文字の英字とアンダースコアのみにマッチします:

[A-Z_][A-Z0-9_]* - 変数名はすべて大文字である必要があります(例:

${APIYI_API_KEY}) - 小文字の変数名(

${apiKey}など)は置換されません - 設定されていない環境変数があると、設定の読み込み時にエラーが発生します

推奨される標準的な命名: APIYI_API_KEY、QWEN_API_KEY、TELEGRAM_BOT_TOKEN

Q4: タスクごとに異なるモデルを使い分けるには?

imageModel とエイリアス(別名)設定を使用することで実現できます。

"agents": {

"defaults": {

"model": {

"primary": "apiyi/claude-opus-4-5-20251101"

},

"imageModel": "apiyi/gpt-4o",

"models": {

"apiyi/claude-opus-4-5-20251101": { "alias": "opus" },

"apiyi/gpt-4o": { "alias": "vision" }

}

}

}

- テキストタスクは自動的に primary モデル(Claude Opus)を使用します

- 画像タスクは自動的に imageModel(GPT-4o)を使用します

/model visionのように手動で切り替えることも可能です

Q5: OpenAI互換のどのサービスをサポートしていますか?

MoltBot は、OpenAI API 仕様に準拠したすべてのサービスをサポートしています。

| サービスタイプ | 例 | 推奨度 |

|---|---|---|

| API プロキシ | APIYI (apiyi.com) | 推奨 (複数モデルを統合管理可能) |

| 公式 API | OpenAI, Anthropic, Google | 公式ならではの安定性 |

| ローカルデプロイ | Ollama, LM Studio, vLLM | プライバシー優先 |

| その他のプロキシ | Groq, Together AI | 必要に応じて選択 |

APIYI(apiyi.com)の利点は、1つのキーで複数の大規模言語モデルを呼び出せるため、個別に登録する手間が省けることです。

MoltBot API プロキシ設定: まとめと推奨事項

この記事を通じて、MoltBot で API プロキシを設定する完全な方法をマスターしました。

- 設定構造の理解:

models.providersでサービスを定義し、agents.defaultsで使用戦略を定義します。 - 複数プロバイダーの設定: 複数の API サービスを同時に導入し、可用性を高めます。

- フォールバックの設定: メインモデルが失敗した際に、予備モデルへ自動で切り替えます。

- エイリアスの活用:

/model aliasコマンドでモデルを素早く切り替えます。

ベストプラクティス

| 推奨事項 | 説明 |

|---|---|

| 環境変数を使用する | 設定ファイルに API キーをプレーンテキストで保存しないでください |

| フォールバックを設定する | 最低でも1〜2個の予備モデルを設定しておきましょう |

| mode: merge を設定する | デフォルト設定を維持し、互換性を高めます |

| API 入口を統一する | APIYI を使用して複数モデルの管理を簡素化します |

主要な API プロキシサービスとして APIYI(apiyi.com)の利用をお勧めします。このプラットフォームは Claude、GPT、Gemini などの主要モデルへの統一的なアクセスを提供しており、設定が簡単で柔軟な課金体系に対応しているため、MoltBot のマルチモデル切り替えシーンに最適です。

参考資料

-

MoltBot 公式ドキュメント – Models: モデル設定の詳細

- リンク:

docs.molt.bot/concepts/models - 説明: 公式モデル設定ガイド

- リンク:

-

MoltBot 公式ドキュメント – Configuration: 完全な設定リファレンス

- リンク:

docs.molt.bot/gateway/configuration - 説明: すべての設定項目の詳細解説

- リンク:

-

MoltBot 公式ドキュメント – Model Providers: プロバイダーの設定

- リンク:

docs.molt.bot/concepts/model-providers - 説明: カスタムプロバイダーの設定方法

- リンク:

-

MoltBot GitHub: ソースコードと Issue での議論

- リンク:

github.com/moltbot/moltbot - 説明: 最新バージョンとフィードバック

- リンク:

本文執筆: APIYI Team | さらなる AI 技術の共有については、APIYI apiyi.com をご覧ください。

更新日: 2026年1月