Al usar Nano Banana Pro para la edición de imágenes, encontrarse con el error IMAGE_SAFETY es un problema que confunde a muchos desarrolladores. En este artículo, analizaremos en profundidad los 5 grandes mecanismos de protección de menores de Nano Banana Pro para ayudarte a entender por qué el sistema rechaza procesar imágenes que contienen presuntos menores de edad.

Valor principal: Al terminar de leer, tendrás una visión completa del sistema de protección infantil de Nano Banana Pro, comprenderás qué activa el error IMAGE_SAFETY y dominarás las mejores prácticas para el uso legítimo de la API de edición de imágenes.

Puntos clave de los mecanismos de protección de menores de Nano Banana Pro

Antes de profundizar en los detalles técnicos, echemos un vistazo a la arquitectura central del mecanismo de seguridad infantil de Nano Banana Pro.

| Nivel de protección | Medios técnicos | Objetivo de protección | Momento de activación |

|---|---|---|---|

| Capa 1 | Detección por coincidencia de hash | Identificar contenido CSAM conocido | Al subir la imagen |

| Capa 2 | Clasificador de IA | Identificar indicaciones que busquen CSAE | Al analizar la solicitud |

| Capa 3 | Filtrado de seguridad de contenido | Bloquear ediciones que involucren menores | Durante la ejecución |

| Capa 4 | Purificación de datos de entrenamiento | Eliminar contenido problemático de raíz | Durante el entrenamiento del modelo |

| Capa 5 | Pruebas previas al lanzamiento | Garantizar estándares de seguridad infantil | Al lanzar una versión |

Principios fundamentales de la protección infantil en Nano Banana Pro

Nano Banana Pro adopta el concepto de Safety by Design (Seguridad por Diseño), un estándar de la industria desarrollado por Google en colaboración con organizaciones de protección infantil como Thorn y All Tech Is Human.

Los principios básicos de protección incluyen:

- Política de tolerancia cero: El contenido relacionado con el abuso o la explotación sexual infantil siempre se bloquea y no se puede omitir mediante ningún ajuste de parámetros.

- Identificación proactiva: El sistema detecta activamente contenido que pueda involucrar a menores, en lugar de responder de forma pasiva.

- Verificación múltiple: Los mecanismos de seguridad de varios niveles trabajan en conjunto para asegurar que no haya vulnerabilidades.

- Actualización continua: Los modelos de seguridad se iteran constantemente para hacer frente a nuevas amenazas.

🎯 Sugerencia técnica: En el desarrollo real, comprender estos mecanismos de protección ayuda a diseñar flujos de aplicación más conformes a las normas. Recomendamos realizar pruebas de llamadas a la API a través de la plataforma APIYI (apiyi.com), que ofrece documentación detallada sobre códigos de error y soporte técnico.

Análisis profundo del error IMAGE_SAFETY

Cuando Nano Banana Pro detecta que una imagen contiene presuntos menores de edad, devuelve un error IMAGE_SAFETY. Analicemos este mecanismo en profundidad.

Detalle de las condiciones de activación del error IMAGE_SAFETY

| Tipo de error | Condición de activación | Código de error | ¿Se puede evitar? |

|---|---|---|---|

| PROHIBITED_CONTENT | Se detectó un hash de CSAM conocido | 400 | No |

| IMAGE_SAFETY | La imagen contiene presuntos menores | 400 | No |

| SAFETY_BLOCK | La indicación incluye contenido relacionado con menores | 400 | No |

| CONTENT_FILTER | Activación combinada de múltiples reglas de seguridad | 400 | No |

Principios técnicos del error IMAGE_SAFETY

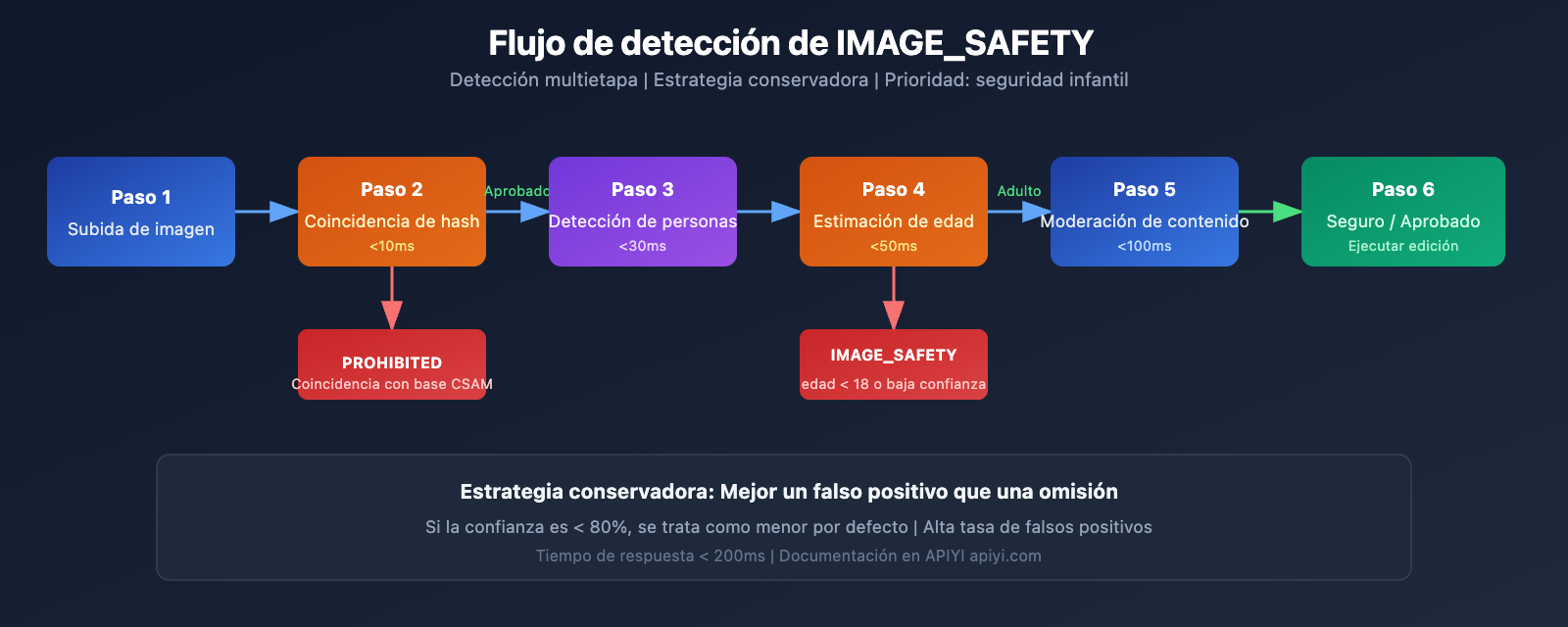

El sistema de detección IMAGE_SAFETY de Nano Banana Pro utiliza tecnología de análisis multimodal:

1. Análisis de rasgos faciales

El sistema analiza los rasgos faciales de las personas en la imagen para evaluar si podrían ser menores de edad:

# Ejemplo de pseudocódigo: Flujo de detección de IMAGE_SAFETY

def check_image_safety(image_data):

"""

Representación de la lógica de detección de IMAGE_SAFETY en Nano Banana Pro.

Nota: Este es un flujo simplificado; la implementación real es más compleja.

"""

# Paso 1: Detección por coincidencia de hash

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# Paso 2: Detección de personas

persons = detect_persons(image_data)

# Paso 3: Estimación de edad

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# Estrategia conservadora: Mejor un falso positivo que una omisión

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. Principio de estrategia conservadora

Para garantizar la seguridad infantil, el sistema adopta una estrategia conservadora:

- Cuando la confianza en el juicio de edad es insuficiente, se trata como menor por defecto.

- Cualquier escena que pueda involucrar a menores será bloqueada.

- La tasa de falsos positivos es preferiblemente alta; proteger la seguridad infantil es la prioridad número uno.

Escenarios comunes del error IMAGE_SAFETY

Según los comentarios de la comunidad de desarrolladores, los siguientes escenarios son los que más activan el error IMAGE_SAFETY:

| Escenario | Causa de activación | Sugerencia de solución |

|---|---|---|

| Edición de fotos familiares | La imagen contiene niños | Eliminar a los niños antes de editar |

| Procesamiento de escenas escolares | Puede contener estudiantes | Usar fondos sin personas |

| Retoque de rostros jóvenes | Juicio de edad conservador | Confirmar que el sujeto es adulto |

| Estilo cartoon/anime | La IA lo confunde con niños reales | Usar estilos claramente no realistas |

| Restauración de fotos históricas | Hay menores en la foto | Seleccionar solo las partes con adultos |

💡 Sugerencia: Al diseñar funciones de edición de imágenes, se recomienda informar a los usuarios sobre estas limitaciones de antemano. A través de la plataforma APIYI (apiyi.com) puedes obtener la lista completa de códigos de error y sugerencias de manejo.

Análisis completo de la tecnología de protección contra CSAM

La protección contra CSAM (Material de Abuso Sexual Infantil) es un componente central del sistema de seguridad de Nano Banana Pro.

Arquitectura tecnológica de protección contra CSAM

Nano Banana Pro utiliza tecnología de protección contra CSAM líder en la industria:

1. Tecnología de coincidencia de hashes

# Ejemplo: Lógica de detección por coincidencia de hashes

import hashlib

def compute_perceptual_hash(image):

"""

Calcula el hash perceptivo de la imagen

Se usa para coincidir con bases de datos de CSAM conocidas

"""

# Ajustar tamaño y color de la imagen

normalized = normalize_image(image)

# Calcular hash perceptivo

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

Comprobar si coincide con CSAM conocido

"""

# Coincidencia difusa, permite ciertas variantes

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. Tecnología de clasificadores de IA

Los clasificadores de IA están entrenados específicamente para identificar:

- Peticiones de CSAE (Abuso o Explotación Sexual Infantil).

- Intentos de solicitudes variantes que buscan evadir la detección de seguridad.

- Patrones sospechosos en combinaciones de texto e imagen.

3. Sinergia de protección multinivel

| Nivel de detección | Implementación técnica | Objetivo de detección | Tiempo de respuesta |

|---|---|---|---|

| Capa de entrada | Coincidencia de hashes | Contenido infractor conocido | < 10ms |

| Capa de comprensión | Clasificador de IA | Reconocimiento de intención | < 50ms |

| Capa de ejecución | Filtro de contenido | Auditoría de salida | < 100ms |

| Capa de monitoreo | Análisis de comportamiento | Patrones anómalos | Tiempo real |

Colaboración y estándares de la industria

El sistema de protección contra CSAM de Nano Banana Pro colabora con diversas organizaciones del sector:

- Thorn: Organización tecnológica contra la explotación infantil.

- All Tech Is Human: Organización de iniciativa ética tecnológica.

- NCMEC: Centro Nacional para Niños Desaparecidos y Explotados (EE. UU.).

- Tech Coalition: Alianza de empresas tecnológicas contra el CSAM.

🔒 Nota de seguridad: Los informes del NCMEC muestran que se han confirmado más de 7,000 casos de CSAM relacionados con GAI (IA generativa) en dos años. Las estrictas protecciones de Nano Banana Pro son una medida necesaria para enfrentar esta grave situación.

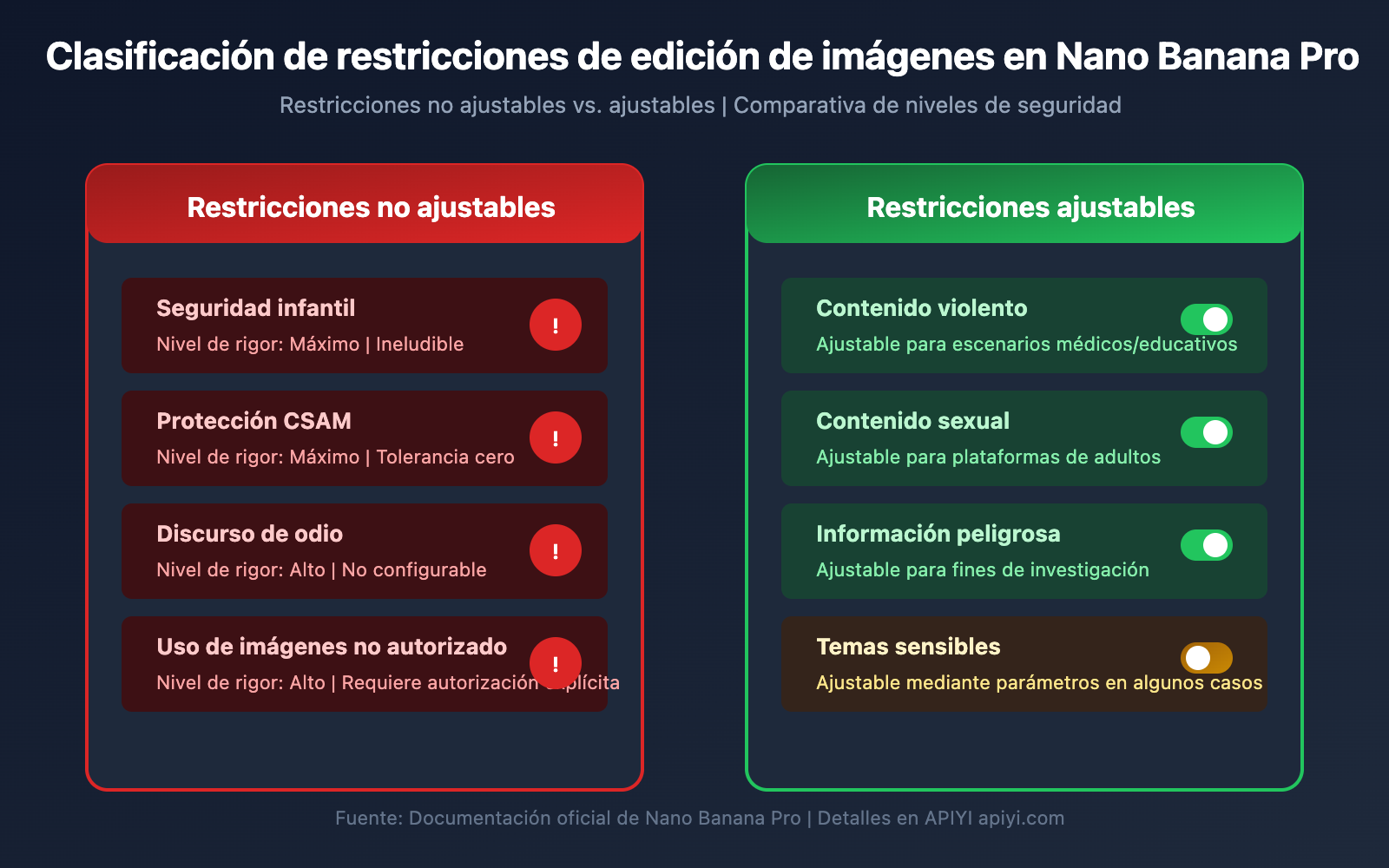

Lista completa de restricciones de edición de imágenes en Nano Banana Pro

Además de la protección de menores, Nano Banana Pro cuenta con otras restricciones en la edición de imágenes.

Clasificación de restricciones de edición de imágenes

| Categoría de restricción | Nivel de rigor | ¿Es ajustable? | Escenarios aplicables |

|---|---|---|---|

| Seguridad infantil | Máximo | No | Todos los escenarios |

| Protección CSAM | Máximo | No | Todos los escenarios |

| Contenido violento | Alto | Parcialmente | Médico, educativo |

| Contenido sexual | Alto | Parcialmente | Plataformas de adultos |

| Información peligrosa | Medio | Parcialmente | Fines de investigación |

| Discurso de odio | Alto | No | Todos los escenarios |

Protecciones centrales no ajustables

Nano Banana Pro establece claramente que las siguientes categorías de daño siempre están bloqueadas y no pueden modificarse mediante ningún parámetro o ajuste de la API:

-

Contenido relacionado con CSAM

- Se prohíbe generar cualquier contenido relacionado con el abuso sexual infantil.

- Se prohíbe el uso de IA para generar contenido inapropiado que involucre a menores.

- Las entradas de CSAM se marcarán como

PROHIBITED_CONTENT.

-

Uso de imágenes sin consentimiento

- Se prohíbe el uso no autorizado de imágenes de terceros.

- Se prohíbe el "deepfake" de rostros de otras personas.

- Se requiere autorización explícita cuando se trate de personas reales.

-

Contenido de explotación infantil

- Se prohíbe cualquier forma de generación de contenido de explotación infantil.

- Incluye, entre otros, explotación sexual, explotación laboral, etc.

- Abarca imágenes de menores tanto reales como ficticios.

Instrucciones de configuración de parámetros de seguridad

Aunque la protección central de seguridad infantil no es ajustable, Nano Banana Pro ofrece opciones de configuración para otros parámetros de seguridad:

from openai import OpenAI

# Inicializar el cliente

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Usando la interfaz unificada de APIYI

)

# Ejemplo de solicitud de edición de imagen

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="Cambiar el color de fondo a azul",

# Parámetros de seguridad (Nota: lo relacionado con seguridad infantil no es ajustable)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# Los siguientes ajustes no tienen efecto en seguridad infantil, siempre al nivel máximo

# "child_safety": No configurable

}

)

Ver el código completo de configuración de seguridad

"""

Ejemplo de configuración de seguridad completa de Nano Banana Pro

Demuestra parámetros de seguridad configurables y no configurables

"""

from openai import OpenAI

import base64

# Inicializar el cliente

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Usando la interfaz unificada de APIYI

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

Función de edición de imagen segura

Incluye manejo de errores completo

"""

try:

# Leer la imagen

with open(image_path, "rb") as f:

image_data = f.read()

# Enviar solicitud de edición

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# Manejar error de IMAGE_SAFETY

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "La imagen parece contener a un menor, no se puede procesar",

"suggestion": "Por favor, use imágenes que solo contengan adultos"

}

# Manejar error de PROHIBITED_CONTENT

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "Se detectó contenido prohibido",

"suggestion": "Por favor, verifique que el contenido de la imagen cumpla con las normas"

}

# Otros errores

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# Ejemplo de uso

result = safe_image_edit("photo.jpg", "Cambiar el fondo a una playa")

if result["success"]:

print(f"Edición exitosa: {result['url']}")

else:

print(f"Error en la edición: {result['message']}")

print(f"Sugerencia: {result.get('suggestion', 'Por favor, intente de nuevo')}")

🚀 Inicio rápido: Se recomienda utilizar la plataforma APIYI (apiyi.com) para experimentar rápidamente con Nano Banana Pro. Esta plataforma ofrece interfaces API listas para usar, sin configuraciones complejas y con documentación detallada para el manejo de errores.

Mejores prácticas para el uso conforme de Nano Banana Pro

Una vez comprendidos los mecanismos de seguridad, veamos cómo utilizar Nano Banana Pro de forma conforme a las normativas.

Lista de verificación previa al desarrollo

Antes de integrar Nano Banana Pro en tu aplicación, confirma los siguientes puntos:

| Ítem de verificación | Necesidad | Método de verificación | Sugerencia de cumplimiento |

|---|---|---|---|

| Verificación de edad del usuario | Obligatorio | Verificar al registrarse | Restricción para mayores de 18 años |

| Confirmación del origen de la imagen | Obligatorio | Protocolo de carga | Exigir que el usuario confirme los derechos de autor |

| Limitación de escenarios de uso | Recomendado | Diseño de funciones | Informar claramente sobre las limitaciones de uso |

| Mecanismo de manejo de errores | Obligatorio | Implementación de código | Mostrar avisos amigables al usuario |

| Proceso de moderación de contenido | Recomendado | Sistema de backend | Implementar un mecanismo de revisión humana |

Mejores prácticas para avisos al usuario

Para evitar confusiones, te recomendamos añadir los siguientes avisos en tu aplicación:

Aviso de carga:

Aviso: Para proteger la seguridad de los menores, las imágenes que contengan figuras infantiles no podrán ser editadas.

Por favor, asegúrate de que todas las personas en la imagen cargada sean adultas.

Aviso de error:

Lo sentimos, no se puede procesar esta imagen.

Motivo: El sistema detectó que la imagen podría contener figuras de menores de edad.

Sugerencia: Utiliza imágenes que solo contengan adultos o elimina la parte de la imagen con menores e inténtalo de nuevo.

Sugerencias de diseño de la aplicación

-

Definir claramente los escenarios de uso

- Explica en la documentación del producto que no se admite el procesamiento de fotos de niños.

- Incluye cláusulas relacionadas en los términos y condiciones para el usuario.

-

Optimizar la experiencia del usuario

- Proporciona mensajes de error amigables.

- Explica el motivo de la restricción en lugar de mostrar solo un código de error.

- Ofrece sugerencias alternativas viables.

-

Preparación de documentación de cumplimiento

- Conserva los registros (logs) de las llamadas a la API.

- Registra los casos en los que se activan los filtros de seguridad.

- Establece un mecanismo para reportar situaciones anómalas.

💰 Optimización de costes: Para proyectos que requieren llamadas frecuentes a la API de edición de imágenes, considera usar la plataforma APIYI (apiyi.com). Esta plataforma ofrece métodos de facturación flexibles y precios más competitivos, ideales para equipos pequeños, medianos y desarrolladores individuales.

Preguntas frecuentes

P1: ¿Por qué una foto de alguien que es claramente adulto activa el error IMAGE_SAFETY?

Nano Banana Pro utiliza una estrategia conservadora para determinar la edad. Cuando el sistema no tiene suficiente confianza en su estimación, opta por tratar la imagen como si fuera de un menor para garantizar la seguridad.

Las posibles causas incluyen:

- Rasgos faciales muy juveniles (como una "cara de bebé").

- La iluminación o el ángulo de la foto dificultan la evaluación.

- Efectos de filtros de estilo cartoon o anime.

Se recomienda usar fotos que muestren claramente los rasgos faciales. A través de la plataforma APIYI (apiyi.com), puedes obtener información de diagnóstico de errores más detallada.

P2: ¿Se puede solucionar el error IMAGE_SAFETY ajustando los parámetros?

No. Las protecciones relacionadas con la seguridad infantil son mecanismos centrales de Nano Banana Pro y pertenecen a una categoría de protección no ajustable.

Este es un estándar de la industria desarrollado por Google en colaboración con organizaciones de protección infantil. Ningún parámetro o configuración de la API puede saltarse esta restricción. No es un error (bug), sino un diseño de seguridad intencionado.

Si necesitas procesar una gran cantidad de imágenes, te sugerimos realizar un filtrado previo y verificar la conformidad de las imágenes usando el saldo de prueba de la plataforma APIYI (apiyi.com).

P3: ¿Cómo puedo saber si una imagen activará las restricciones de seguridad?

Te recomendamos realizar una detección previa antes del procesamiento oficial:

- Confirma que no haya figuras de menores evidentes en la imagen.

- Evita usar escenarios comunes para niños, como escuelas o parques infantiles.

- Prueba primero con una versión de vista previa en baja resolución.

- Establece un proceso de revisión interna para filtrar imágenes sensibles.

P4: ¿La detección de CSAM puede dar falsos positivos con contenido normal?

La tecnología de coincidencia de hashes se dirige a bases de datos de CSAM conocidas, por lo que la tasa de falsos positivos es extremadamente baja. Sin embargo, la determinación de la edad por IA sí puede presentar errores de juicio.

Si estás seguro de que el contenido de la imagen cumple con las normas pero sigue siendo rechazado, probablemente se deba a la estrategia conservadora de estimación de edad. El sistema está diseñado para preferir rechazar por error contenido normal antes que dejar pasar cualquier situación que pueda involucrar a menores.

P5: ¿Existen restricciones al usar personajes de anime o virtuales?

Sí, los mecanismos de protección de Nano Banana Pro se aplican de igual forma a personajes de anime, ilustraciones y personajes virtuales.

Si un personaje virtual presenta la apariencia de un menor, también activará la restricción IMAGE_SAFETY. Se recomienda usar personajes virtuales que sean claramente adultos o evitar operaciones de edición que involucren personas.

Resumen y sugerencias

Los 5 principales mecanismos de protección de menores de Nano Banana Pro reflejan la alta prioridad que la industria de la IA otorga a la seguridad infantil:

| Punto clave | Descripción |

|---|---|

| Principio fundamental | Safety by Design: la seguridad infantil está por encima de todo |

| Arquitectura técnica | Protección multicapa con detección de hash, clasificadores de IA y filtrado de contenido |

| Infranqueable | Las restricciones de seguridad infantil no se pueden omitir mediante ningún ajuste de parámetros |

| Estándares de la industria | Desarrollado en colaboración con organizaciones como Thorn y NCMEC |

| Sugerencias de cumplimiento | Informar claramente a los usuarios sobre las limitaciones y ofrecer mensajes de error amigables |

Recomendaciones de acción

- Desarrolladores: Prever la lógica de manejo para las restricciones de seguridad en el diseño de la aplicación.

- Gerentes de Producto (PM): Integrar las restricciones de seguridad infantil en la planificación de las funciones del producto.

- Personal de Operaciones: Preparar guiones de respuesta estándar para las consultas de los usuarios.

Te recomendamos probar rápidamente las diversas funciones de Nano Banana Pro a través de APIYI (apiyi.com) para comprender mejor los límites de seguridad reales.

Referencias:

-

Google AI Safety Policies: Documentación oficial sobre políticas de seguridad.

- Enlace:

ai.google.dev/gemini-api/docs/safety-policies

- Enlace:

-

Thorn – Safety by Design: Iniciativa tecnológica para la seguridad infantil.

- Enlace:

thorn.org/safety-by-design

- Enlace:

-

NCMEC Reports: Informes del Centro Nacional para Niños Desaparecidos y Explotados.

- Enlace:

missingkids.org/gethelpnow/csam-reports

- Enlace:

📝 Autor: APIYI Team | 🌐 Intercambio técnico: apiyi.com

Este artículo ha sido organizado y publicado por el equipo técnico de APIYI. Si tienes alguna duda, te invitamos a visitar APIYI (apiyi.com) para obtener soporte técnico.