Nano Banana Pro を使用して画像編集を行う際、IMAGE_SAFETY エラーに遭遇して困惑する開発者は少なくありません。この記事では、Nano Banana Pro の「5 つの未成年者保護メカニズム」を深く掘り下げ、なぜ未成年者と思われる画像が含まれる場合にシステムが処理を拒否するのかを解説します。

この記事のポイント: 読み終える頃には、Nano Banana Pro の児童安全保護体系を包括的に理解し、IMAGE_SAFETY エラーのトリガーメカニズムを把握した上で、画像編集 API をコンプライアンスに則って使用するためのベストプラクティスを習得できるでしょう。

Nano Banana Pro 未成年者保護メカニズムの核心ポイント

技術的な詳細に入る前に、まずは Nano Banana Pro の児童安全メカニズムの全体像を把握しましょう。

| 保護レイヤー | 技術的手法 | 保護対象・目的 | トリガーのタイミング |

|---|---|---|---|

| 第 1 層 | ハッシュマッチング検出 | 既知の CSAM コンテンツの識別 | 画像アップロード時 |

| 第 2 層 | AI 分類器 | CSAE を求めるプロンプトの識別 | リクエスト解析時 |

| 第 3 層 | コンテンツ安全フィルタ | 未成年者が関わる編集のブロック | 処理実行時 |

| 第 4 層 | 学習データのクレンジング | 根本から問題のあるコンテンツを排除 | モデル学習時 |

| 第 5 層 | リリース前テスト | 児童安全基準の遵守を確保 | バージョンリリース時 |

Nano Banana Pro 児童安全保護の核心原則

Nano Banana Pro は、Google が Thorn や All Tech Is Human といった児童保護団体と協力して策定した業界標準である Safety by Design(設計段階からの安全確保)の理念を採用しています。

主な保護原則は以下の通りです:

- ゼロトレランス(不寛容)ポリシー: 児童の性的虐待や搾取に関連するコンテンツは常にブロックされ、いかなるパラメータ調整によっても回避することはできません。

- 能動的な識別: システムは、受動的に反応するのではなく、未成年者が関与する可能性のあるコンテンツを能動的に検出します。

- 多重検証: 多層的な安全メカニズムが連携して動作し、脆弱性がないことを確実にします。

- 継続的なアップデート: 安全モデルは常に反復され、新しい脅威に対応し続けます。

🎯 技術的なアドバイス: 実際の開発において、これらの保護メカニズムを理解することは、よりコンプライアンスに則ったアプリケーションフローを設計するのに役立ちます。詳細なエラーコードのドキュメントや技術サポートを提供している APIYI (apiyi.com) プラットフォームを通じて、API の呼び出しテストを行うことをお勧めします。

IMAGE_SAFETY エラーの徹底解説

Nano Banana Pro が画像内に未成年者の疑いがある人物を検出すると、IMAGE_SAFETY エラーを返します。このメカニズムについて詳しく分析していきましょう。

IMAGE_SAFETY エラーのトリガー条件の詳細

| エラーの種類 | トリガー条件 | エラーコード | 回避の可否 |

|---|---|---|---|

| PROHIBITED_CONTENT | 既知の CSAM(児童性的虐待コンテンツ)ハッシュを検出 | 400 | 不可 |

| IMAGE_SAFETY | 画像に未成年者の疑いがある人物が含まれる | 400 | 不可 |

| SAFETY_BLOCK | プロンプトに未成年者関連の内容が含まれる | 400 | 不可 |

| CONTENT_FILTER | 複数の安全ルールが組み合わさってトリガー | 400 | 不可 |

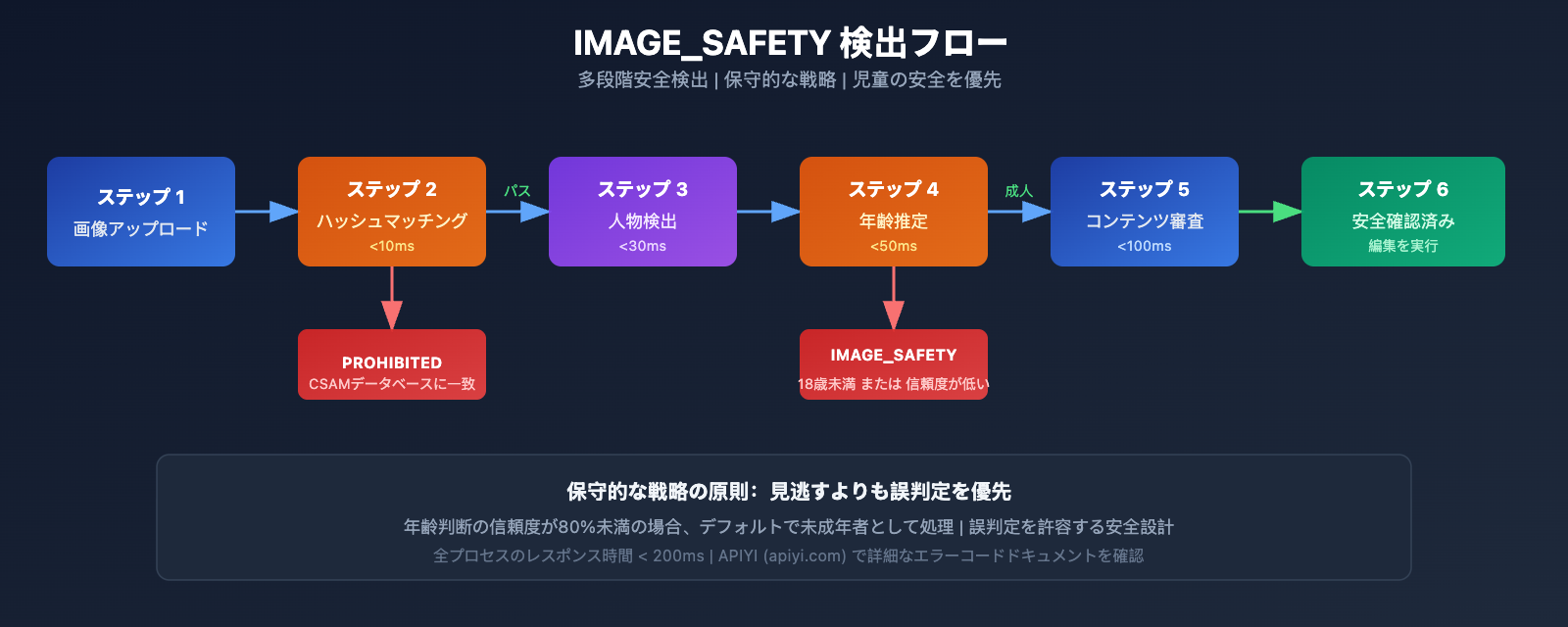

IMAGE_SAFETY エラーの技術的原理

Nano Banana Pro の IMAGE_SAFETY 検出システムは、マルチモーダル分析技術を採用しています。

1. 顔の特徴分析

システムは画像内の人物の顔の特徴を分析し、未成年者である可能性を評価します。

# 疑似コード例:IMAGE_SAFETY 検出フロー

def check_image_safety(image_data):

"""

Nano Banana Pro IMAGE_SAFETY 検出ロジックの例

注意:これは簡略化されたフロー説明であり、実際の構成はより複雑です

"""

# ステップ1:ハッシュマッチング検出

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# ステップ2:人物検出

persons = detect_persons(image_data)

# ステップ3:年齢推定

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# 保守的な戦略:見逃すよりも誤判定を優先

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. 保守的な戦略の原則

児童の安全を確保するため、システムは保守的な戦略を採用しています。

- 年齢判断の信頼度が不足している場合、デフォルトで未成年者として処理されます。

- 未成年者が関与する可能性のあるあらゆるシーンがブロックされます。

- 誤判定率は低く抑えるよりも高く設定されており、児童の安全保護を最優先事項としています。

よくある IMAGE_SAFETY エラーのシナリオ

開発者コミュニティからのフィードバックに基づくと、以下のシナリオで IMAGE_SAFETY エラーが最も発生しやすくなっています。

| シナリオ | トリガーの原因 | 解決策の提案 |

|---|---|---|

| 家族写真の編集 | 画像に子供が含まれている | 子供を除外してから編集する |

| 学校シーンの処理 | 学生が含まれている可能性 | 人物のいない背景を使用する |

| 若い顔立ちのレタッチ | 年齢判断が保守的 | 被写体が成人であることを確認する |

| カートゥーン・アニメスタイル | AI が実在の子供と誤認 | 明らかに非現実的なスタイルを使用する |

| 古い写真の修復 | 写真に未成年者が写っている | 成人のみが写っている部分を選択する |

💡 アドバイス: 画像編集機能を設計する際は、あらかじめユーザーにこれらの制限を通知することをお勧めします。APIYI (apiyi.com) プラットフォームでは、完全なエラーコードリストと対処法を確認できます。

CSAM 保護技術の完全解説

CSAM(児童性的虐待コンテンツ)保護は、Nano Banana Proのセキュリティ体系における中核的な構成要素です。

CSAM 保護技術のアーキテクチャ

Nano Banana Proは、業界をリードするCSAM保護技術を採用しています。

1. ハッシュマッチング技術

# 例:ハッシュマッチング検出ロジック

import hashlib

def compute_perceptual_hash(image):

"""

画像の知覚ハッシュを計算し、

既知のCSAMデータベースとの照合に使用します

"""

# 画像のサイズと色を調整

normalized = normalize_image(image)

# 知覚ハッシュを計算

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

既知のCSAMと一致するかどうかを確認します

"""

# 曖昧一致(ファジーマッチング)、一定のバリエーションを許容

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. AI 分類器技術

AI 分類器は、以下の識別を専門としてトレーニングされています。

- CSAE(児童の性的虐待または搾取)を求めるプロンプト

- セキュリティ検出の回避を試みる変則的なリクエスト

- 疑わしい画像とテキストの組み合わせパターン

3. 多層的な保護の連携

| 検出レイヤー | 技術実装 | 検出対象 | 応答時間 |

|---|---|---|---|

| 入力レイヤー | ハッシュマッチング | 既知の違反コンテンツ | < 10ms |

| 理解レイヤー | AI 分類器 | 意図の識別 | < 50ms |

| 実行レイヤー | コンテンツフィルタ | 出力の検閲 | < 100ms |

| 監視レイヤー | 行動分析 | 異常パターン | リアルタイム |

業界との連携と標準

Nano Banana ProのCSAM保護体系は、複数の業界団体と協力しています。

- Thorn: 児童搾取対策技術組織

- All Tech Is Human: テクノロジー倫理イニシアチブ組織

- NCMEC: 全米行方不明・被搾取児童センター

- Tech Coalition: テクノロジー企業による対CSAM連合

🔒 セキュリティに関する注記: NCMECの報告によると、2年間で7,000件以上のGAI(生成AI)関連のCSAM事例が確認されています。Nano Banana Proの厳格な保護は、この深刻な状況に対応するための不可欠な措置です。

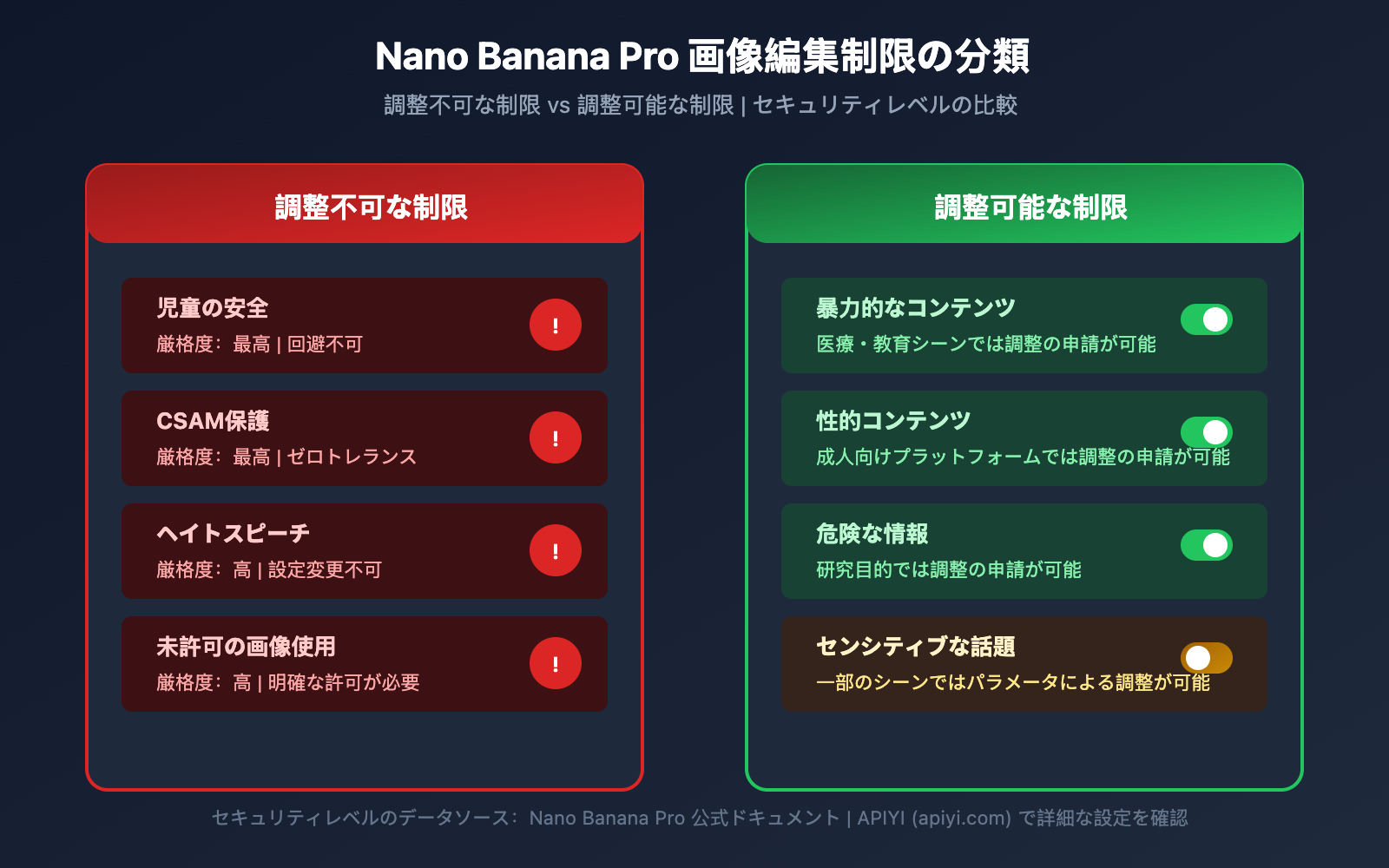

Nano Banana Pro 画像編集制限の完全リスト

未成年者保護以外にも、Nano Banana Proにはいくつかの画像編集制限があります。

画像編集制限の分類

| 制限カテゴリ | 厳格度 | 調整の可否 | 適用シーン |

|---|---|---|---|

| 児童の安全 | 最高 | いいえ | すべてのシーン |

| CSAM保護 | 最高 | いいえ | すべてのシーン |

| 暴力的なコンテンツ | 高 | 一部調整可能 | 医療、教育 |

| 性的コンテンツ | 高 | 一部調整可能 | 成人向けプラットフォーム |

| 危険な情報 | 中 | 一部調整可能 | 研究目的 |

| ヘイトスピーチ | 高 | いいえ | すべてのシーン |

調整不可能なコア保護

Nano Banana Proは、以下の有害カテゴリは常にブロックされ、いかなるAPIパラメータや設定でも調整できないことを明確に規定しています。

-

CSAM関連コンテンツ

- 児童性的虐待に関連するいかなるコンテンツの生成も禁止

- AIを使用して未成年者が関与する不適切なコンテンツを生成することを禁止

- CSAM入力は

PROHIBITED_CONTENTとしてフラグが立てられます

-

同意のない画像の使用

- 他人の画像を無断で使用することを禁止

- 他人の顔をディープフェイクすることを禁止

- 実在の人物が関与する場合は、明確な許可が必要です

-

児童搾取コンテンツ

- いかなる形式の児童搾取コンテンツの生成も禁止

- 性的搾取、労働搾取などを含みますが、これらに限定されません

- 実在および架空の未成年者のイメージを網羅します

セキュリティパラメータの設定説明

コアとなる児童の安全保護は調整不可能ですが、Nano Banana Proはその他のセキュリティパラメータの設定オプションを提供しています。

from openai import OpenAI

# クライアントの初期化

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYIの統合インターフェースを使用

)

# 画像編集リクエストの例

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="背景色を青に変更",

# セキュリティパラメータ(注意:児童の安全に関する項目は調整不可)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# 以下の設定は児童の安全には適用されず、常に最高レベルが維持されます

# "child_safety": 設定不可

}

)

完全なセキュリティ設定コードを表示

"""

Nano Banana Pro 完全なセキュリティ設定の例

設定可能および設定不可能なセキュリティパラメータのデモ

"""

from openai import OpenAI

import base64

# クライアントの初期化

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYIの統合インターフェースを使用

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

安全な画像編集関数

完全なエラーハンドリングを含む

"""

try:

# 画像を読み込む

with open(image_path, "rb") as f:

image_data = f.read()

# 編集リクエストを送信

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# IMAGE_SAFETYエラーの処理

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "画像に未成年者の疑いがあるため、処理できません",

"suggestion": "成人(大人)のみが含まれる画像を使用してください"

}

# PROHIBITED_CONTENTエラーの処理

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "禁止コンテンツが検出されました",

"suggestion": "画像の内容が規約に準拠しているか確認してください"

}

# その他のエラー

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# 使用例

result = safe_image_edit("photo.jpg", "背景をビーチに変更")

if result["success"]:

print(f"編集成功: {result['url']}")

else:

print(f"編集失敗: {result['message']}")

print(f"アドバイス: {result.get('suggestion', '再試行してください')}")

🚀 クイックスタート: Nano Banana Proをすぐに体験するには、APIYI(apiyi.com)プラットフォームの使用をお勧めします。このプラットフォームは、複雑な設定なしですぐに使えるAPIインターフェースを提供しており、充実したエラーハンドリングドキュメントも備えています。

Nano Banana Pro コンプライアンス遵守のためのベストプラクティス

安全メカニズムを理解したところで、Nano Banana Pro をコンプライアンスに則って適切に使用するための方法を学びましょう。

開発前チェックリスト

Nano Banana Pro をアプリケーションに統合する前に、以下の事項を確認してください。

| チェック項目 | 必要性 | 確認方法 | コンプライアンス上のアドバイス |

|---|---|---|---|

| ユーザーの年齢確認 | 必須 | 登録時に検証 | 18歳以上の制限 |

| 画像ソースの確認 | 必須 | アップロード利用規約 | ユーザーに著作権の確認を要求 |

| 利用シーンの限定 | 推奨 | 機能設計 | 用途制限を明確に通知 |

| エラーハンドリング | 必須 | コード実装 | ユーザーへの適切なフィードバック |

| コンテンツ審査フロー | 推奨 | 管理システム | 有人による再確認メカニズム |

ユーザー向けプロンプトのベストプラクティス

ユーザーの混乱を避けるため、アプリケーション内に以下のヒントを追加することをお勧めします。

アップロード時のヒント:

【お知らせ】未成年者の安全を守るため、お子様の姿が含まれる画像は編集処理を行うことができません。

アップロードする画像内の人物がすべて成人であることをご確認ください。

エラー発生時のヒント:

申し訳ありません。この画像は処理できません。

理由:画像内に未成年者の姿が含まれている可能性があることをシステムが検出しました。

解決策:成人の方のみが写っている画像を使用するか、未成年者の部分を除去してから再度お試しください。

アプリケーション設計のアドバイス

-

利用シーンの明確化

- 製品ドキュメント内で、子供の写真の処理には対応していないことを明記する。

- ユーザー利用規約に関連条項を含める。

-

ユーザーエクスペリエンス(UX)の最適化

- わかりやすいエラーメッセージを提供する。

- 単にエラーコードを表示するのではなく、制限の理由を説明する。

- 実行可能な代替案を提示する。

-

コンプライアンス文書の準備

- API 呼び出しログを保存する。

- セーフティフィルタのトリガー状況を記録する。

- 異常事態の報告メカニズムを構築する。

💰 コストの最適化: 画像編集 API を頻繁に呼び出す必要があるプロジェクトでは、APIYI (apiyi.com) プラットフォーム経由での利用を検討してみてください。このプラットフォームは柔軟な課金方式とよりお得な価格を提供しており、中小規模のチームや個人開発者に最適です。

よくある質問(FAQ)

Q1: 明らかに成人の写真なのに IMAGE_SAFETY が発生するのはなぜですか?

Nano Banana Pro は、年齢判断において保守的な戦略を採用しています。システムが年齢を判断する際の確信度が不足している場合、安全を確保するためにデフォルトで未成年として処理されます。

トリガーとなる可能性のある原因:

- 若々しい顔立ち(いわゆるベビーフェイス)

- 写真のライティングや角度による誤判定

- カートゥーンやアニメ調のフィルター効果

顔の特徴がはっきりとわかる写真を使用することをお勧めします。APIYI (apiyi.com) プラットフォームを利用することで、より詳細なエラー診断情報を取得できる場合があります。

Q2: IMAGE_SAFETY エラーはパラメータを調整することで解決できますか?

いいえ、解決できません。児童の安全に関する保護は Nano Banana Pro のコアとなる安全メカニズムであり、調整不可能な保護カテゴリに属します。

これは Google が児童保護団体と協力して策定した業界標準であり、いかなる API パラメータや設定によってもこの制限を回避することはできません。これはバグではなく、意図された安全設計です。

大量の画像を処理する必要がある場合は、事前にプレスクリーニングを行うか、APIYI (apiyi.com) プラットフォームのテストクレジットを使用して画像の適合性を検証することをお勧めします。

Q3: 画像が安全制限に抵触するかどうかを判断するにはどうすればよいですか?

正式な処理の前に、以下のプリチェックを行うことをお勧めします。

- 画像内に明らかな未成年者の姿がないことを確認する。

- 学校や遊園地など、子供がよくいるシーンの使用を避ける。

- 低解像度のプレビュー版で先にテストする。

- センシティブな画像をフィルタリングするための内部審査フローを構築する。

Q4: CSAM 検出で正常なコンテンツが誤検知されることはありますか?

ハッシュマッチング技術は既知の CSAM データベースを対象としているため、誤検知率は極めて低いです。ただし、AI による年齢判断では誤判定が生じる可能性があります。

画像の内容が規約に準拠していると確信があるにもかかわらず拒否される場合は、年齢判断の保守的な戦略が原因である可能性があります。システムは、未成年者が関与する可能性を一切見逃さないよう、正常なコンテンツであっても疑わしきは拒否するように設計されています。

Q5: アニメやバーチャルキャラクターの使用も制限されますか?

はい、Nano Banana Pro の保護メカニズムは、アニメ、イラスト、バーチャルキャラクターにも同様に適用されます。

バーチャルキャラクターが未成年者の姿として表現されている場合、同様に IMAGE_SAFETY の制限がかかります。明らかに成人であるバーチャルキャラクターを使用するか、人物が関わる編集操作を避けることをお勧めします。

まとめと提言

Nano Banana Pro の 5 つの主要な未成年者保護メカニズムは、AI 業界がいかに子供の安全を重視しているかを体現しています。

| キーポイント | 説明 |

|---|---|

| 核心原則 | Safety by Design(設計段階からの安全確保)、子供の安全を何よりも優先 |

| 技術アーキテクチャ | ハッシュ検出 + AI 分類器 + コンテンツフィルタリングによる多層防御 |

| 回避不可 | 子供の安全制限は、いかなるパラメータ調整によっても回避できません |

| 業界標準 | Thorn や NCMEC などの組織と協力して策定 |

| 運用のヒント | ユーザーに制限を明確に伝え、親切なエラーメッセージを提供 |

アクションプラン

- 開発者: アプリケーション設計において、安全制限の処理ロジックをあらかじめ組み込んでおく。

- プロダクトマネージャー: 子供の安全制限を製品機能のロードマップや計画に含める。

- 運営担当者: ユーザーからの問い合わせに対する標準的な回答(トークスクリプト)を用意する。

APIYI (apiyi.com) を通じて Nano Banana Pro の各機能を素早くテストし、実際の安全境界を把握することをお勧めします。

参考資料:

-

Google AI Safety Policies: 公式安全ポリシー・ドキュメント

- リンク:

ai.google.dev/gemini-api/docs/safety-policies

- リンク:

-

Thorn – Safety by Design: 子供の安全に関する技術イニシアチブ

- リンク:

thorn.org/safety-by-design

- リンク:

-

NCMEC Reports: 行方不明・被搾取児童のための全米センター(NCMEC)レポート

- リンク:

missingkids.org/gethelpnow/csam-reports

- リンク:

📝 著者: APIYI Team | 🌐 技術交流: apiyi.com

本文は APIYI 技術チームによって作成・公開されました。ご不明な点がございましたら、APIYI (apiyi.com) までお気軽にお問い合わせください。