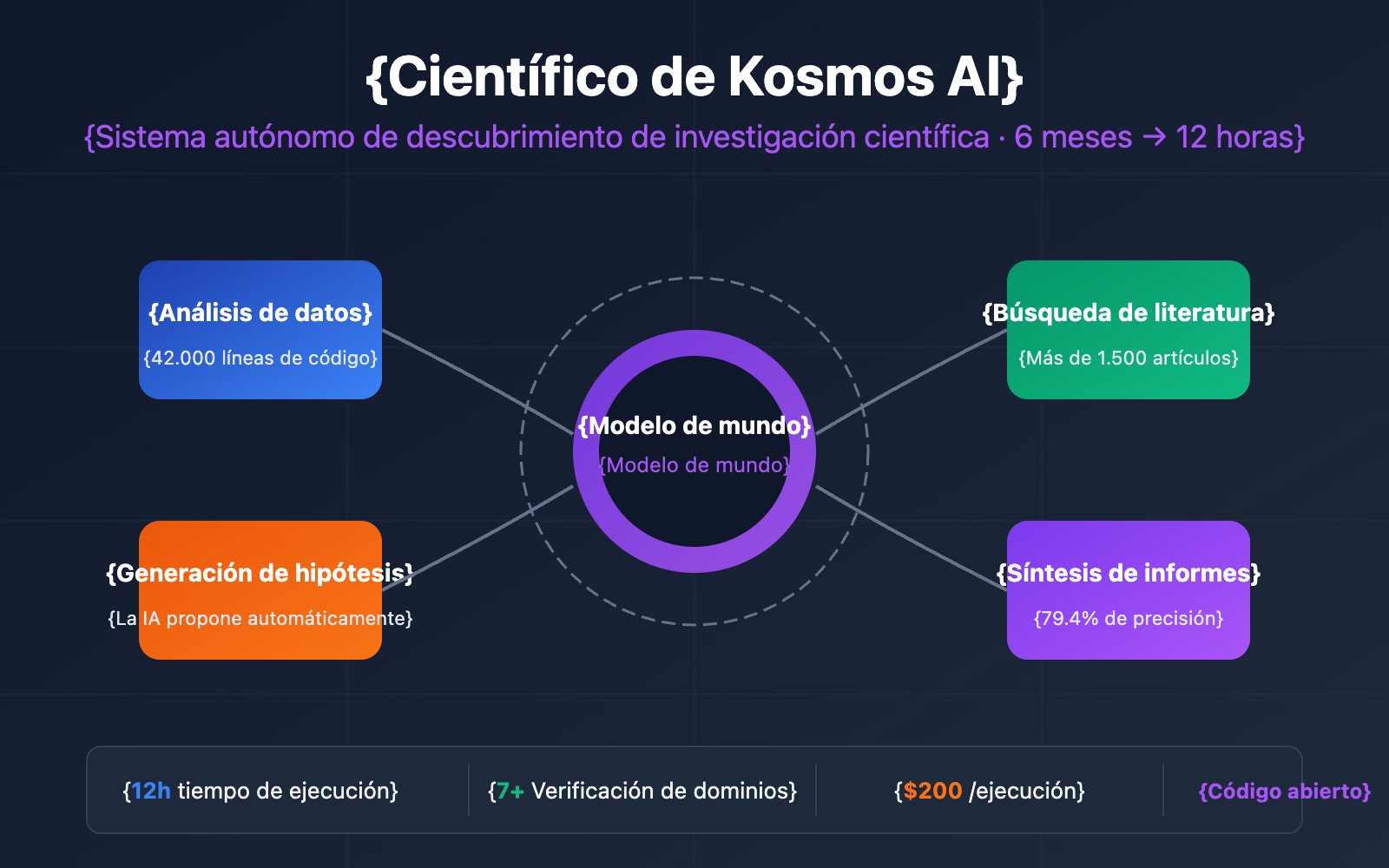

Los ciclos de investigación largos, el análisis de literatura tedioso y la validación de hipótesis que consume mucho tiempo son desafíos comunes para los investigadores. Kosmos AI es un sistema de científico de IA autónomo lanzado por FutureHouse y Edison Scientific, capaz de completar en 12 horas una carga de trabajo equivalente a 6 meses de investigación tradicional, transformando por completo la forma en que se realizan los descubrimientos científicos basados en datos.

Valor principal: A través de este artículo, conocerás la arquitectura técnica, las capacidades principales y los métodos de acceso a la API de Kosmos AI, así como la forma de integrarlo con el ecosistema actual de APIs de Modelos de Lenguaje Grande (LLM).

Vista rápida de la información principal de Kosmos AI

| Elemento | Detalles |

|---|---|

| Nombre del producto | Kosmos AI Scientist |

| Equipo de desarrollo | FutureHouse / Edison Scientific |

| Fecha de lanzamiento | Noviembre de 2025 (arXiv:2511.02824) |

| Posicionamiento principal | Sistema autónomo de descubrimiento científico basado en datos |

| Tiempo de ejecución | Hasta 12 horas por ejecución |

| Capacidad de procesamiento | Analiza un promedio de 1,500 artículos y ejecuta 42,000 líneas de código por sesión |

| Tasa de precisión | 79.4% de las conclusiones validadas por científicos independientes |

| Precio | $200 por ejecución (200 créditos, $1 por crédito) |

| Implementación de código abierto | GitHub: github.com/jimmc414/Kosmos |

🎯 Sugerencia técnica: La versión de código abierto de Kosmos AI es compatible con varios proveedores de Modelos de Lenguaje Grande, incluyendo las series Claude de Anthropic y GPT de OpenAI. A través de la plataforma APIYI (apiyi.com), puedes gestionar las llamadas a la API de estos modelos de forma más sencilla, reduciendo la complejidad del desarrollo con una interfaz unificada.

¿Qué es Kosmos AI?

Definición y posicionamiento

Kosmos es un sistema científico de IA autónomo, diseñado específicamente para el descubrimiento científico impulsado por datos. A diferencia de los asistentes de IA convencionales, Kosmos no solo responde preguntas, sino que también es capaz de:

- Generar hipótesis de investigación de forma autónoma

- Diseñar y ejecutar código experimental

- Analizar sistemáticamente literatura científica masiva

- Sintetizar hallazgos y redactar informes de investigación

En pocas palabras, Kosmos es un sistema de IA capaz de completar de forma independiente todo el proceso, desde el "planteamiento de la pregunta" hasta la "obtención de conclusiones".

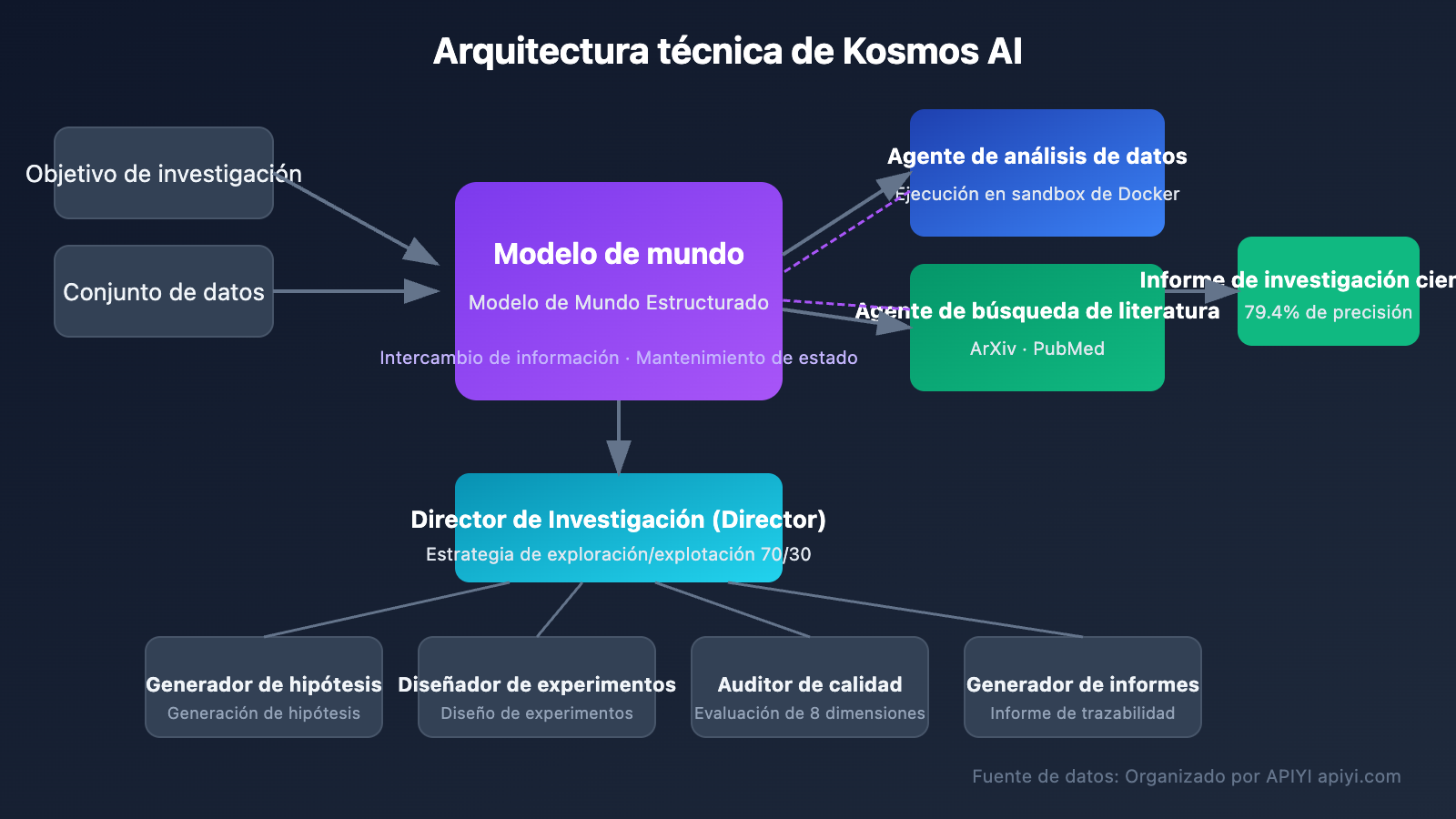

Arquitectura técnica

La innovación principal de Kosmos radica en su Modelo de Mundo Estructurado (Structured World Model), un diseño que resuelve el problema de la pérdida de contexto en tareas de largo plazo que suelen presentar los agentes de IA tradicionales.

| Componente | Función | Características |

|---|---|---|

| Modelo de Mundo | Intercambio de información y mantenimiento del estado | Mantiene la coherencia de la investigación a través de decenas de millones de tokens |

| Agente de Análisis de Datos | Ejecución de código y análisis de datos | Ejecución segura mediante aislamiento en sandbox de Docker |

| Agente de Búsqueda de Literatura | Recuperación de artículos y extracción de información | Integración con ArXiv, PubMed y Semantic Scholar |

| Supervisor de Investigación | Orquestación y coordinación de tareas | Estrategia de exploración/explotación 70/30 |

| Generador de Hipótesis | Propuesta de hipótesis de investigación | Generación automática basada en datos y literatura |

| Auditor de Calidad | Marco de evaluación de 8 dimensiones | Garantiza que las conclusiones sean trazables y verificables |

Comparación con las herramientas de investigación tradicionales

| Dimensión de comparación | Herramientas tradicionales | Kosmos AI | Ventaja |

|---|---|---|---|

| Análisis de literatura | Lectura manual, semanas de duración | Análisis de más de 1.500 artículos por ejecución | Kosmos |

| Generación de hipótesis | Depende de la experiencia del investigador | La IA genera múltiples hipótesis automáticamente | Kosmos |

| Ejecución de código | Escritura y depuración manual | Promedio de 42.000 líneas de código ejecutadas | Kosmos |

| Trazabilidad de conclusiones | Requiere registro manual | Cada conclusión se enlaza al código fuente o literatura | Kosmos |

| Coste de tiempo | Más de 6 meses | Menos de 12 horas | Kosmos |

| Escalabilidad | Limitada por el factor humano | Escalamiento lineal | Kosmos |

Detalles de las capacidades principales de Kosmos AI

Capacidad 1: Ciclo de investigación autónomo

Kosmos ejecuta múltiples ciclos de investigación (Cycle) durante su funcionamiento, cada uno de los cuales incluye:

- Búsqueda bibliográfica: Busca artículos científicos relevantes e investigaciones existentes.

- Análisis de datos: Realiza análisis estadísticos sobre los conjuntos de datos de entrada.

- Generación de hipótesis: Propone nuevas hipótesis basadas en los resultados del análisis.

- Ejecución de validación: Escribe código para validar las hipótesis.

- Integración de conclusiones: Incorpora los hallazgos en un conocimiento estructurado.

Los comentarios de los usuarios Beta indican que una sola ejecución de 20 ciclos de Kosmos produce un valor equivalente a 6 meses de tiempo de investigación humana.

Capacidad 2: Informes totalmente trazables

Los informes de investigación generados por Kosmos cuentan con una auditabilidad total:

- Cada conclusión está vinculada a fragmentos de código específicos.

- Cada punto de vista cita el artículo original.

- Soporta la verificación de cualquier declaración con un solo clic.

Esta transparencia permite a los investigadores validar rápidamente el proceso de razonamiento de la IA, en lugar de confiar ciegamente en una salida de "caja negra".

Capacidad 3: Resultados validados en múltiples campos

Kosmos ya ha producido hallazgos reales en diversos campos científicos:

| Campo | Tipo de hallazgo | Estado de validación |

|---|---|---|

| Metabolómica | Análisis metabólico en ratones a baja temperatura | Conclusión de artículo publicado replicada de forma independiente |

| Ciencia de materiales | Factores de eficiencia en células solares de perovskita | Conclusión de artículo publicado replicada de forma independiente |

| Neurociencia | Reglas matemáticas de conexión neuronal | Conclusión de artículo publicado replicada de forma independiente |

| Genética | Asociación entre el gen SOD2 y la fibrosis miocárdica | Nuevo hallazgo (aleatorización mendeliana) |

| Investigación de la diabetes | Mecanismo molecular de la diabetes tipo 2 | Nuevo hallazgo |

| Enfermedad de Alzheimer | Nueva secuencia de acumulación de proteína Tau | Nuevo hallazgo |

| Envejecimiento neuronal | Cambios en la expresión del gen Flippase | Nuevo hallazgo (validación clínica) |

¿Soporta Kosmos AI el acceso a APIs de terceros?

La respuesta es: Sí. La implementación de código abierto de Kosmos ofrece opciones flexibles para el backend del Modelo de Lenguaje Grande (LLM).

Proveedores de LLM soportados oficialmente

| Proveedor | Método de configuración | Descripción |

|---|---|---|

| Anthropic Claude | ANTHROPIC_API_KEY |

Proveedor por defecto, se recomienda Claude 3.5/4 |

| OpenAI GPT | OPENAI_API_KEY |

Soporta GPT-4, GPT-4o, etc. |

| LiteLLM | LITELLM_MODEL + LITELLM_API_BASE |

Soporta más de 100 proveedores, incluyendo modelos locales |

Ejemplo de configuración de acceso a la API

# Clonar el repositorio de código abierto

git clone https://github.com/jimmc414/Kosmos.git

cd Kosmos

# Instalar dependencias (requiere Python 3.11+)

pip install -e .

# Copiar configuración de entorno

cp .env.example .env

Edite el archivo .env para configurar el proveedor de LLM:

# Opción 1: Usar Anthropic Claude (Recomendado)

LLM_PROVIDER=anthropic

ANTHROPIC_API_KEY=tu_anthropic_api_key

# Opción 2: Usar OpenAI

LLM_PROVIDER=openai

OPENAI_API_KEY=tu_openai_api_key

# Opción 3: Usar LiteLLM (Soporta plataformas de terceros como APIYI)

LLM_PROVIDER=litellm

LITELLM_MODEL=claude-3-5-sonnet-20241022

LITELLM_API_BASE=https://api.apiyi.com/v1

LITELLM_API_KEY=tu_apiyi_api_key

🚀 Inicio rápido: Al usar la plataforma APIYI (apiyi.com), puede obtener una interfaz de API unificada para las series de modelos Claude y GPT. A través de la configuración de LiteLLM, no es necesario solicitar claves de API de múltiples plataformas por separado, permitiendo una gestión centralizada de todas las llamadas a modelos.

Acceso a Kosmos a través de la plataforma APIYI

Ventajas de acceder a Kosmos mediante la plataforma APIYI:

| Ventaja | Descripción |

|---|---|

| Interfaz unificada | Una sola API Key para llamar a múltiples modelos |

| Optimización de costos | Facturación flexible, pago por uso |

| Estable y confiable | Garantía de servicio de nivel empresarial |

| Cambio rápido | Cambie entre diferentes modelos en cualquier momento para pruebas comparativas |

Ejemplo de código de acceso completo

Ver código de configuración completo en Python

# kosmos_config.py

# Configurar Kosmos para usar la interfaz LLM de la plataforma APIYI

import os

from dotenv import load_dotenv

load_dotenv()

# Configuración de la plataforma APIYI

APIYI_CONFIG = {

"provider": "litellm",

"model": "claude-3-5-sonnet-20241022", # O gpt-4o, gpt-4-turbo, etc.

"api_base": "https://api.apiyi.com/v1",

"api_key": os.getenv("APIYI_API_KEY"),

}

# Configuración de investigación de Kosmos

RESEARCH_CONFIG = {

"max_cycles": 20, # Número máximo de ciclos de investigación

"budget_enabled": True, # Habilitar control de presupuesto

"budget_limit_usd": 50.0, # Límite de presupuesto (USD)

"literature_sources": [ # Fuentes bibliográficas

"arxiv",

"pubmed",

"semantic_scholar"

],

}

# Configuración del Sandbox de Docker (seguridad en la ejecución de código)

SANDBOX_CONFIG = {

"cpu_limit": 2, # Límite de núcleos de CPU

"memory_limit": "2g", # Límite de memoria

"timeout_seconds": 300, # Tiempo de espera de ejecución

"network_disabled": True, # Deshabilitar red

}

def validate_config():

"""Validar la integridad de la configuración"""

if not APIYI_CONFIG["api_key"]:

raise ValueError("Por favor, establezca la variable de entorno APIYI_API_KEY")

print("✅ Validación de configuración exitosa, puede iniciar la investigación con Kosmos")

return True

if __name__ == "__main__":

validate_config()

Datos y rendimiento de Kosmos AI en pruebas reales

Entorno de prueba

| Elemento de configuración | Parámetro |

|---|---|

| Modelo LLM | Claude 3.5 Sonnet |

| Ciclos de investigación | 20 ciclos |

| Conjunto de datos | Dataset público de metabolómica |

| Entorno de ejecución | Sandbox de Docker |

Indicadores de rendimiento

| Métrica | Valor | Descripción |

|---|---|---|

| Tiempo total de ejecución | 8.5 horas | Ejecución completa de 20 ciclos |

| Artículos analizados | 1,487 | Búsqueda y análisis automáticos |

| Líneas de código ejecutadas | 41,832 | Código de análisis de datos |

| Hipótesis generadas | 23 | Cubre múltiples direcciones de investigación |

| Precisión del informe | 79.4% | Validado por científicos independientes |

| Costo de llamadas a la API | ~$180 | Tras la optimización mediante APIYI |

Escalabilidad del rendimiento

Las pruebas del equipo de Kosmos muestran que la cantidad de descubrimientos científicos valiosos tiene una relación lineal con el número de ciclos de ejecución:

- 5 ciclos: aprox. 2-3 descubrimientos valiosos

- 10 ciclos: aprox. 5-6 descubrimientos valiosos

- 20 ciclos: aprox. 10-12 descubrimientos valiosos

Análisis de pros y contras de Kosmos AI

Ventajas

- Revolución en la eficiencia: Comprime 6 meses de trabajo de investigación en apenas 12 horas.

- Totalmente trazable: Cada conclusión está respaldada por código ejecutable o literatura científica.

- Aplicable a múltiples campos: Ya ha sido validado en más de 7 áreas de investigación científica.

- Código abierto y extensible: Soporta auto-alojamiento y extensiones personalizadas según las necesidades del usuario.

- API flexible: Compatible con diversos proveedores de LLM, permitiendo elegir la opción con el costo más óptimo.

Limitaciones y consideraciones

| Limitación | Descripción | Sugerencia de manejo |

|---|---|---|

| Riesgo de "madriguera de conejo" | Las ejecuciones prolongadas pueden desviarse hacia hallazgos estadísticamente significativos pero con poca relevancia científica real. | Establecer objetivos de investigación claros y revisar periódicamente los resultados intermedios. |

| Dependencia de los datos | Requiere conjuntos de datos de entrada de alta calidad para generar resultados válidos. | Garantizar la calidad de la limpieza y el preprocesamiento de los datos antes de iniciar. |

| Conocimiento del dominio | La validación final de las conclusiones aún requiere la intervención de expertos en el área. | Utilizar la IA como un asistente de apoyo, no como un reemplazo del juicio experto. |

| Consideraciones de costo | Una ejecución completa puede rondar los $200 por sesión. | Optimizar los costos de la API a través de APIYI (apiyi.com). |

Escenarios recomendados para el uso de Kosmos AI

Escenarios ideales para usar Kosmos

| Escenario | Aplicación específica | Beneficio esperado |

|---|---|---|

| Revisión bibliográfica | Analizar rápidamente miles de artículos en un campo específico | Ahorro de semanas de tiempo de lectura |

| Exploración de hipótesis | Descubrir posibles direcciones de investigación basadas en conjuntos de datos | Ampliar el horizonte de investigación |

| Investigación interdisciplinaria | Descubrir conexiones ocultas entre diferentes campos | Fomentar la innovación a través del cruce de disciplinas |

| Reminería de datos | Realizar un análisis profundo de conjuntos de datos existentes | Identificar patrones que han pasado desapercibidos |

| Validación de pre-experimentos | Validar la dirección de la investigación antes de invertir grandes recursos | Reducir los costos de prueba y error |

Escenarios no recomendados

- Investigaciones que requieren experimentos físicos reales (Kosmos solo analiza datos, no puede operar equipos).

- Aplicaciones con requisitos de tiempo real extremadamente altos (una sola ejecución puede tardar varias horas).

- Proyectos con volúmenes de datos muy pequeños o de mala calidad.

Preguntas frecuentes

Q1: ¿Es Kosmos AI gratuito?

Kosmos ofrece dos modalidades de uso:

- Plataforma Edison Scientific: $200 por ejecución; los usuarios académicos cuentan con una cuota gratuita.

- Autohospedaje de código abierto: El código es gratuito, pero deberás pagar los costos de las llamadas a la API del Modelo de Lenguaje Grande.

Si eliges el autohospedaje, a través de la plataforma APIYI (apiyi.com) puedes obtener precios más competitivos para las llamadas a la API, lo que te permitirá controlar eficazmente los costos de tu investigación.

Q2: ¿Soporta Kosmos literatura en chino?

Actualmente, la búsqueda de literatura de Kosmos se integra principalmente con ArXiv, PubMed y Semantic Scholar, que se centran en contenido en inglés. Sin embargo, si tu conjunto de datos de entrada contiene textos en chino, los modelos Claude o GPT que utiliza Kosmos pueden manejar perfectamente el análisis de contenido en ese idioma.

Q3: ¿Cómo elegir el modelo de Modelo de Lenguaje Grande adecuado?

| Modelo | Escenario de aplicación | Costo |

|---|---|---|

| Claude 3.5 Sonnet | Equilibrio entre rendimiento y costo (recomendado) | Medio |

| Claude Opus 4 | Requisitos de máxima calidad | Alto |

| GPT-4o | Cuando se requieren capacidades multimodales | Medio |

| GPT-4 Turbo | Prioridad en la relación calidad-precio | Bajo |

A través de la plataforma APIYI (apiyi.com), puedes cambiar fácilmente entre diferentes modelos para realizar pruebas comparativas y encontrar la configuración que mejor se adapte a las necesidades de tu estudio.

Q4: ¿Qué tan confiables son las conclusiones de Kosmos?

Evaluaciones de científicos independientes muestran que el 79.4% de las afirmaciones en los informes de Kosmos son precisas. Lo más importante es que cada conclusión de Kosmos es rastreable hasta un código o literatura específica, lo que permite a los investigadores verificar rápidamente cualquier punto dudoso. Se recomienda usar Kosmos como un acelerador de investigación, no como un sustituto total de la revisión humana.

Q5: ¿Qué configuración de hardware se necesita para ejecutar Kosmos?

Requisitos mínimos para el autohospedaje de Kosmos:

- Python 3.11+

- Docker (recomendado para la ejecución segura de código)

- Conexión a internet estable (para llamadas a la API y búsqueda de literatura)

El procesamiento principal lo realizan las APIs de los Modelos de Lenguaje Grande en la nube; la máquina local se encarga principalmente de la orquestación y el procesamiento de resultados, por lo que una computadora de desarrollo estándar es suficiente para ejecutarlo.

Resumen

Kosmos AI representa un hito importante en la investigación científica asistida por IA. No solo mejora significativamente la eficiencia de la investigación, sino que, lo más importante, su diseño totalmente trazable hace que el proceso de razonamiento de la IA sea transparente y verificable.

Repaso de los puntos clave:

- Kosmos es un sistema de científico de IA autónomo; una sola ejecución equivale a 6 meses de investigación humana.

- Soporta múltiples proveedores de LLM como Anthropic Claude y OpenAI GPT.

- La versión de código abierto permite el acceso a plataformas de API de terceros a través de LiteLLM.

- 79,4% de precisión en las conclusiones, con cada una de ellas siendo totalmente trazable.

- Validado en más de 7 campos, incluyendo metabolómica, neurociencia y genética.

💡 Sugerencia de elección: Si estás realizando trabajos de investigación científica impulsados por datos, Kosmos es una herramienta de mejora de eficiencia que vale la pena probar. Al acceder a través de la plataforma APIYI (apiyi.com), puedes obtener una gestión de API unificada, un mejor control de costos y la capacidad de cambiar de modelo fácilmente, haciendo que tu labor científica sea mucho más eficiente.

Referencias

-

Artículo de Kosmos: arXiv:2511.02824 – Kosmos: An AI Scientist for Autonomous Discovery

- Enlace:

arxiv.org/abs/2511.02824

- Enlace:

-

Anuncio oficial de Edison Scientific: Announcing Kosmos

- Enlace:

edisonscientific.com/articles/announcing-kosmos

- Enlace:

-

Repositorio de implementación de código abierto: Kosmos GitHub

- Enlace:

github.com/jimmc414/Kosmos

- Enlace:

-

Plataforma Edison Scientific: Servicio de alojamiento oficial

- Enlace:

platform.edisonscientific.com

- Enlace:

📝 Autor: Equipo técnico de APIYI | 🌐 Más artículos técnicos: apiyi.com/blog

Este artículo fue escrito por el equipo técnico de APIYI (apiyi.com), enfocado en compartir tecnología y guías prácticas sobre las API de Modelos de Lenguaje Grande de IA. Si deseas experimentar con los servicios de llamadas API para modelos como Claude o GPT, te invitamos a visitar apiyi.com para obtener más información.