Ao usar o Nano Banana Pro para edição de imagens, encontrar o erro IMAGE_SAFETY é um problema que confunde muitos desenvolvedores. Este artigo analisará em profundidade os 5 grandes mecanismos de proteção de menores do Nano Banana Pro, ajudando você a entender por que imagens que supostamente contêm menores de idade são rejeitadas pelo sistema.

Valor central: Ao ler este artigo, você terá uma compreensão completa do sistema de proteção de segurança infantil do Nano Banana Pro, entenderá o mecanismo de ativação do erro IMAGE_SAFETY e dominará as melhores práticas para o uso em conformidade da API de edição de imagens.

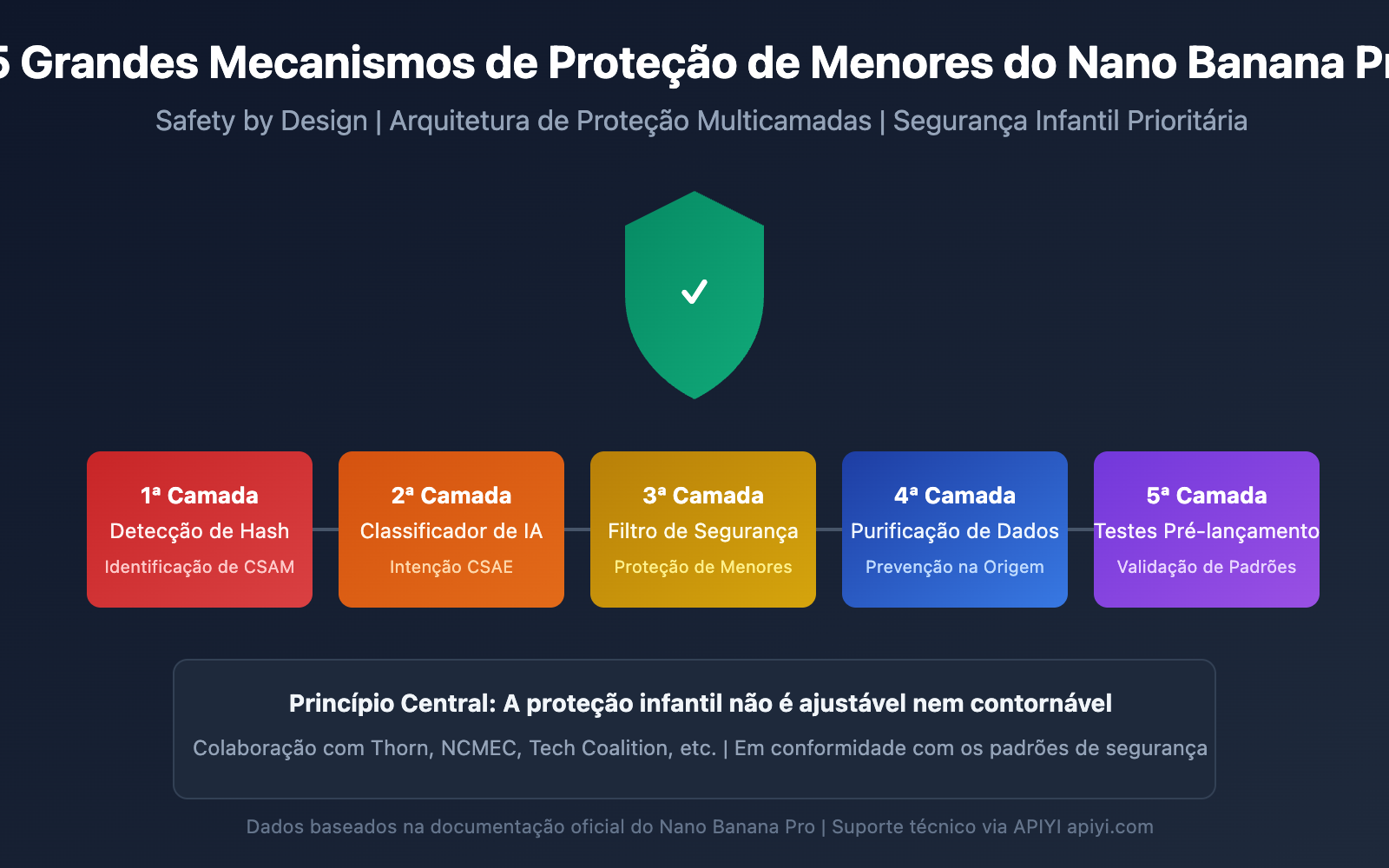

Principais Pontos do Mecanismo de Proteção de Menores do Nano Banana Pro

Antes de mergulharmos nos detalhes técnicos, vamos entender a arquitetura central do mecanismo de segurança infantil do Nano Banana Pro.

| Nível de Proteção | Meios Técnicos | Objetivo de Proteção | Momento de Ativação |

|---|---|---|---|

| 1ª Camada | Detecção de correspondência de hash | Identificar conteúdo CSAM conhecido | No upload da imagem |

| 2ª Camada | Classificador de IA | Identificar solicitações de busca CSAE | Na análise da requisição |

| 3ª Camada | Filtragem de segurança de conteúdo | Impedir edições que envolvam menores | Durante a execução do processamento |

| 4ª Camada | Purificação de dados de treinamento | Eliminar conteúdo problemático na origem | No treinamento do modelo |

| 5ª Camada | Testes pré-lançamento | Garantir padrões de segurança infantil | No lançamento da versão |

Princípios Centrais da Proteção de Segurança Infantil do Nano Banana Pro

O Nano Banana Pro adota o conceito de design Safety by Design, que é um padrão da indústria desenvolvido pelo Google em colaboração com organizações de proteção infantil como Thorn e All Tech Is Human.

Os princípios centrais de proteção incluem:

- Política de Tolerância Zero: Conteúdos relacionados ao abuso ou exploração sexual infantil são sempre bloqueados e não podem ser ajustados por nenhum parâmetro.

- Identificação Proativa: O sistema detecta ativamente conteúdos que possam envolver menores, em vez de apenas responder passivamente.

- Verificação Múltipla: Mecanismos de segurança em várias camadas trabalham em conjunto para garantir que não haja brechas.

- Atualização Contínua: Os modelos de segurança são iterados continuamente para lidar com novas ameaças.

🎯 Sugestão técnica: Na prática do desenvolvimento, entender esses mecanismos ajuda a projetar fluxos de aplicação mais conformes. Recomendamos realizar testes de chamada de API através da plataforma APIYI apiyi.com, que oferece documentação detalhada de códigos de erro e suporte técnico.

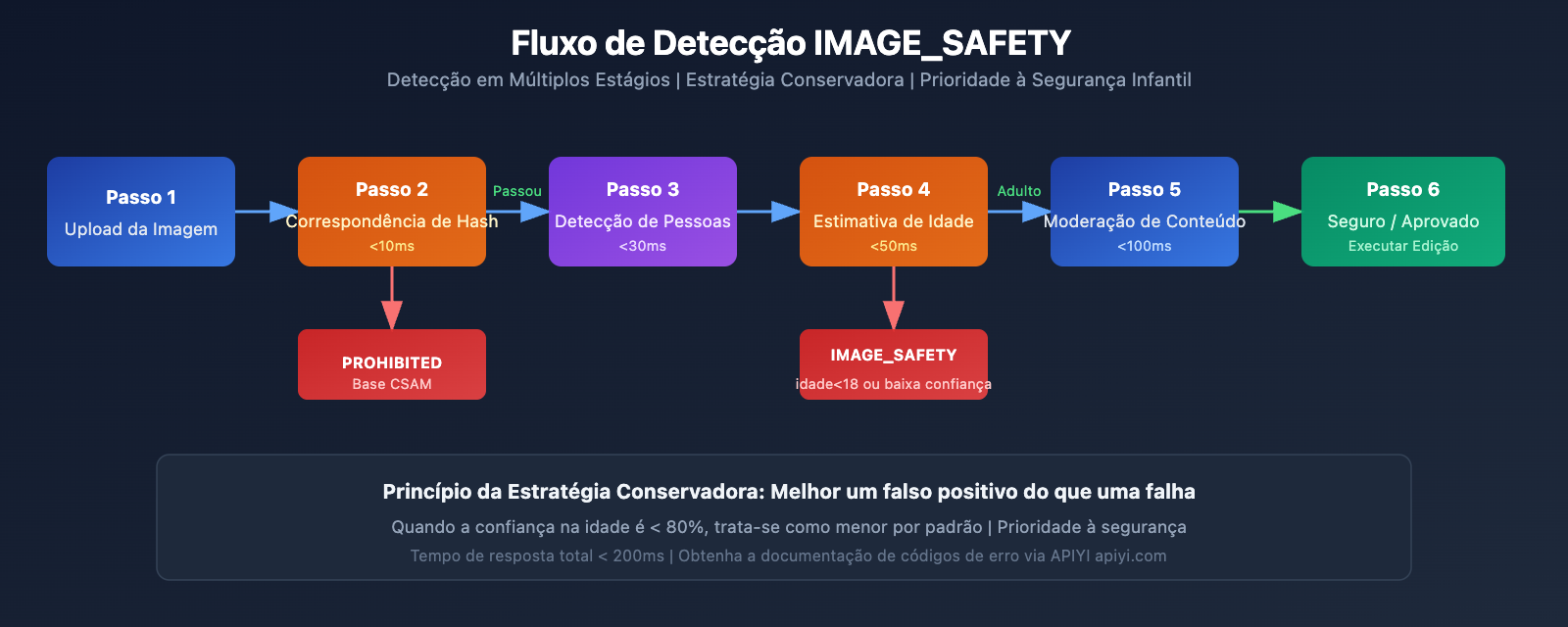

Análise Profunda do Erro IMAGE_SAFETY

Quando o Nano Banana Pro detecta que uma imagem contém suspeita de menores de idade, ele retorna o erro IMAGE_SAFETY. Vamos analisar esse mecanismo a fundo.

Detalhamento das Condições de Acionamento do Erro IMAGE_SAFETY

| Tipo de Erro | Condição de Acionamento | Código de Erro | É contornável? |

|---|---|---|---|

| PROHIBITED_CONTENT | Detectado hash de CSAM conhecido | 400 | Não |

| IMAGE_SAFETY | Imagem contém suspeita de menores de idade | 400 | Não |

| SAFETY_BLOCK | O comando envolve conteúdo relacionado a menores | 400 | Não |

| CONTENT_FILTER | Acionamento combinado de múltiplas regras de segurança | 400 | Não |

Princípios Técnicos do Erro IMAGE_SAFETY

O sistema de detecção IMAGE_SAFETY do Nano Banana Pro utiliza tecnologia de análise multimodal:

1. Análise de Características Faciais

O sistema analisa as características faciais das pessoas na imagem para avaliar se podem ser menores de idade:

# Exemplo de pseudocódigo: Fluxo de detecção IMAGE_SAFETY

def check_image_safety(image_data):

"""

Exemplo da lógica de detecção IMAGE_SAFETY do Nano Banana Pro

Nota: Esta é uma explicação simplificada do fluxo; a implementação real é mais complexa.

"""

# Passo 1: Detecção de correspondência de hash

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# Passo 2: Detecção de pessoas

persons = detect_persons(image_data)

# Passo 3: Estimativa de idade

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# Estratégia conservadora: Melhor um falso positivo do que uma falha de detecção

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. Princípios da Estratégia Conservadora

Para garantir a segurança infantil, o sistema adota uma postura conservadora:

- Quando a confiança no julgamento da idade é insuficiente, o sistema trata como menor de idade por padrão.

- Qualquer cenário que possa envolver menores de idade será bloqueado.

- A taxa de falso positivo é preferencialmente alta; proteger a segurança infantil é a prioridade número um.

Cenários Comuns de Erro IMAGE_SAFETY

De acordo com o feedback da comunidade de desenvolvedores, os seguintes cenários são os que mais frequentemente ativam o erro IMAGE_SAFETY:

| Cenário | Motivo do Acionamento | Sugestão de Solução |

|---|---|---|

| Edição de fotos de família | Contém crianças na imagem | Remova as crianças antes de editar |

| Processamento de cenas escolares | Pode conter estudantes | Use fundos sem pessoas |

| Retoque de rostos jovens | Julgamento de idade conservador | Confirme que o sujeito fotografado é maior de idade |

| Estilo Cartoon/Anime | IA confunde com crianças reais | Use estilos claramente não realistas |

| Restauração de fotos históricas | Há menores na foto | Selecione apenas as partes que contêm adultos |

💡 Sugestão: Ao projetar funções de edição de imagem, recomendamos informar os usuários sobre essas restrições antecipadamente. Através da plataforma APIYI (apiyi.com), você pode obter a lista completa de códigos de erro e sugestões de tratamento.

Análise Completa da Tecnologia de Proteção CSAM

A proteção CSAM (Material de Abuso Sexual Infantil) é um componente central do ecossistema de segurança do Nano Banana Pro.

Arquitetura da Tecnologia de Proteção CSAM

O Nano Banana Pro utiliza tecnologias de proteção CSAM líderes do setor:

1. Tecnologia de Correspondência de Hash

# Exemplo: Lógica de detecção por correspondência de hash

import hashlib

def compute_perceptual_hash(image):

"""

Calcula o hash perceptual da imagem.

Usado para comparar com bancos de dados CSAM conhecidos.

"""

# Ajusta o tamanho e a cor da imagem

normalized = normalize_image(image)

# Calcula o hash perceptual

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

Verifica se há correspondência com CSAM conhecido

"""

# Correspondência difusa, permitindo certas variações

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. Tecnologia de Classificadores de IA

Os classificadores de IA são treinados especificamente para identificar:

- Solicitações de busca de CSAE (Abuso ou Exploração Sexual Infantil)

- Variações de solicitações que tentam burlar a detecção de segurança

- Padrões suspeitos de combinação de imagem e texto

3. Colaboração de Proteção em Múltiplas Camadas

| Nível de Detecção | Implementação Técnica | Alvo da Detecção | Tempo de Resposta |

|---|---|---|---|

| Camada de Entrada | Correspondência de Hash | Conteúdo infrator conhecido | < 10ms |

| Camada de Compreensão | Classificador de IA | Reconhecimento de intenção | < 50ms |

| Camada de Execução | Filtro de conteúdo | Auditoria de saída | < 100ms |

| Camada de Monitoramento | Análise de comportamento | Padrões anômalos | Tempo real |

Cooperação e Padrões da Indústria

O sistema de proteção CSAM do Nano Banana Pro colabora com diversas organizações do setor:

- Thorn: Organização de tecnologia contra a exploração infantil.

- All Tech Is Human: Organização de iniciativa de ética tecnológica.

- NCMEC: Centro Nacional para Crianças Desaparecidas e Exploradas (EUA).

- Tech Coalition: Aliança de empresas de tecnologia contra o CSAM.

🔒 Nota de Segurança: Relatórios do NCMEC mostram que, em dois anos, foram confirmados mais de 7.000 casos de CSAM relacionados à GAI (IA Generativa). As proteções rigorosas do Nano Banana Pro são medidas necessárias para enfrentar essa situação grave.

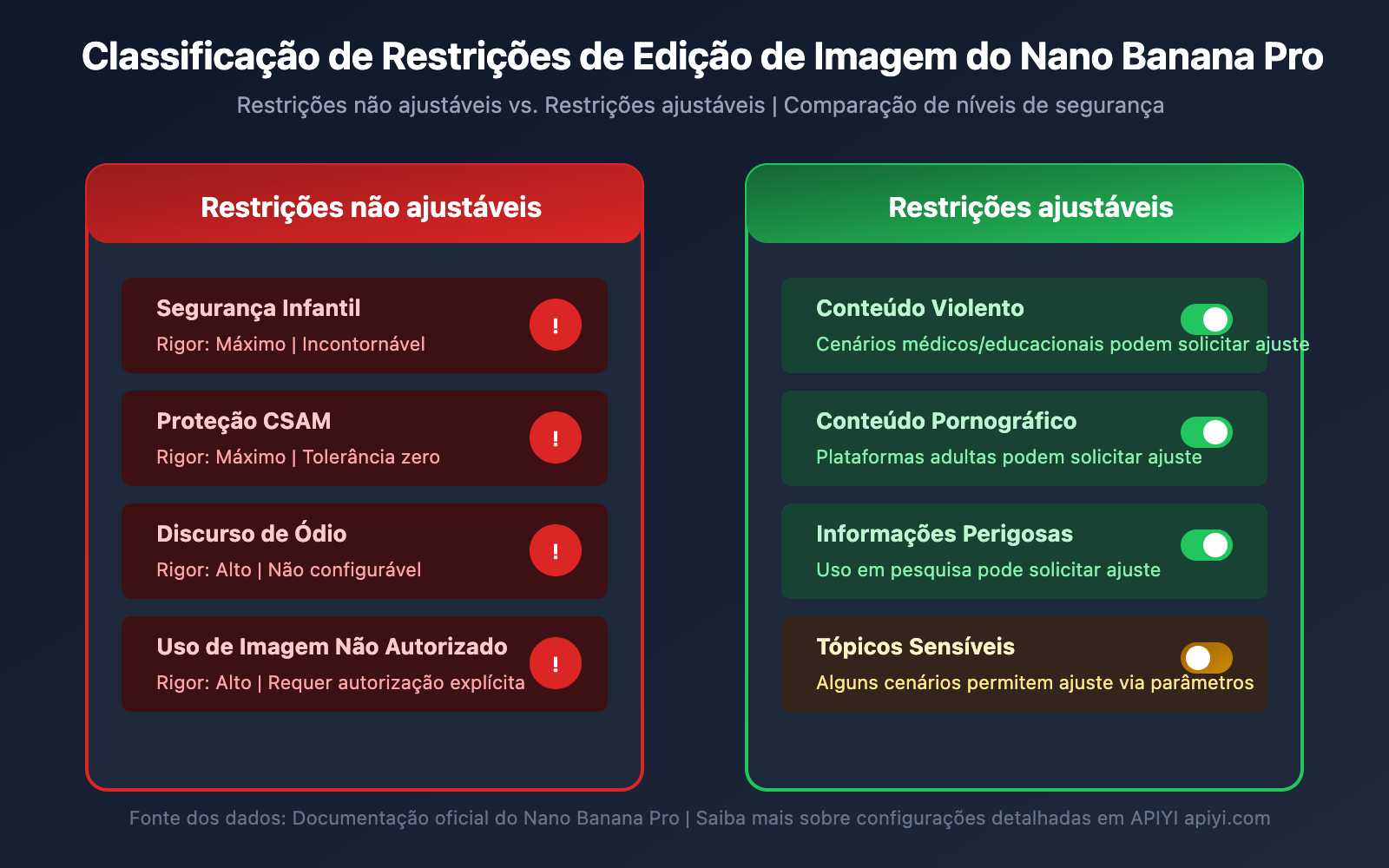

Lista Completa de Restrições de Edição de Imagem do Nano Banana Pro

Além da proteção de menores, o Nano Banana Pro possui outras restrições de edição de imagem.

Classificação de Restrições de Edição de Imagem

| Categoria de Restrição | Nível de Rigor | Ajustável? | Cenário Aplicável |

|---|---|---|---|

| Segurança Infantil | Máximo | Não | Todos os cenários |

| Proteção CSAM | Máximo | Não | Todos os cenários |

| Conteúdo Violento | Alto | Parcialmente | Médico, Educacional |

| Conteúdo Pornográfico | Alto | Parcialmente | Plataformas adultas |

| Informações Perigosas | Médio | Parcialmente | Fins de pesquisa |

| Discurso de Ódio | Alto | Não | Todos os cenários |

Proteções Centrais Não Ajustáveis

O Nano Banana Pro estabelece claramente que as seguintes categorias de danos são sempre bloqueadas e não podem ser ajustadas por nenhum parâmetro ou configuração de API:

-

Conteúdo relacionado a CSAM

- Proibido gerar qualquer conteúdo relacionado ao abuso sexual infantil.

- Proibido usar IA para gerar conteúdo impróprio envolvendo menores de idade.

- Entradas CSAM serão marcadas como

PROHIBITED_CONTENT.

-

Uso de imagem sem consentimento

- Proibido o uso não autorizado de imagens de terceiros.

- Proibido realizar deepfakes de rostos de outras pessoas.

- O envolvimento de pessoas reais requer autorização explícita.

-

Conteúdo de exploração infantil

- Proibida a geração de qualquer forma de conteúdo de exploração infantil.

- Inclui, mas não se limita a, exploração sexual, exploração laboral, etc.

- Abrange imagens de menores reais e fictícios.

Instruções de Configuração de Parâmetros de Segurança

Embora as proteções centrais de segurança infantil não sejam ajustáveis, o Nano Banana Pro oferece opções de configuração para outros parâmetros de segurança:

from openai import OpenAI

# Inicializa o cliente

client = OpenAI(

api_key="SUA_CHAVE_API",

base_url="https://api.apiyi.com/v1" # Usando a interface unificada da APIYI

)

# Exemplo de solicitação de edição de imagem

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="Mudar a cor do fundo para azul",

# Parâmetros de segurança (Nota: itens de segurança infantil não são ajustáveis)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# As seguintes configurações não afetam a segurança infantil, que permanece sempre no nível máximo

# "child_safety": não configurável

}

)

Ver o código completo de configuração de segurança

"""

Exemplo de configuração de segurança completa do Nano Banana Pro

Demonstra parâmetros configuráveis e não configuráveis

"""

from openai import OpenAI

import base64

# Inicializa o cliente

client = OpenAI(

api_key="SUA_CHAVE_API",

base_url="https://api.apiyi.com/v1" # Usando a interface unificada da APIYI

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

Função de edição de imagem segura

Inclui tratamento de erros completo

"""

try:

# Lê a imagem

with open(image_path, "rb") as f:

image_data = f.read()

# Envia a solicitação de edição

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# Trata erros de IMAGE_SAFETY

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "A imagem contém suspeita de menores de idade, impossível processar",

"suggestion": "Por favor, use imagens contendo apenas adultos"

}

# Trata erros de PROHIBITED_CONTENT

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "Conteúdo proibido detectado",

"suggestion": "Por favor, verifique se o conteúdo da imagem está em conformidade"

}

# Outros erros

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# Exemplo de uso

result = safe_image_edit("foto.jpg", "Mudar o fundo para uma praia")

if result["success"]:

print(f"Edição bem-sucedida: {result['url']}")

else:

print(f"Falha na edição: {result['message']}")

print(f"Sugestão: {result.get('suggestion', 'Tente novamente')}")

🚀 Começo Rápido: Recomendamos usar a plataforma APIYI (apiyi.com) para experimentar o Nano Banana Pro rapidamente. A plataforma oferece interfaces de API prontas para uso, sem necessidade de configurações complexas, e possui documentação completa para tratamento de erros.

Melhores Práticas para o Uso em Conformidade do Nano Banana Pro

Depois de entender os mecanismos de segurança, vamos aprender como utilizar o Nano Banana Pro de forma correta e em conformidade com as normas.

Checklist Pré-desenvolvimento

Antes de integrar o Nano Banana Pro ao seu aplicativo, confirme os seguintes pontos:

| Item de Verificação | Necessidade | Método de Verificação | Sugestão de Conformidade |

|---|---|---|---|

| Verificação de idade do usuário | Obrigatório | Validar no cadastro | Restrição 18+ |

| Confirmação da origem da imagem | Obrigatório | Termos de upload | Exigir que o usuário confirme os direitos autorais |

| Limitação de cenários de uso | Recomendado | Design de funcionalidades | Informar claramente as restrições de uso |

| Mecanismo de tratamento de erros | Obrigatório | Implementação de código | Exibir mensagens amigáveis ao usuário |

| Fluxo de moderação de conteúdo | Recomendado | Sistema de back-end | Mecanismo de revisão humana |

Melhores Práticas para Mensagens ao Usuário

Para evitar confusão por parte do usuário, sugerimos adicionar os seguintes avisos no seu aplicativo:

Aviso de Upload:

Lembrete: Para proteger a segurança de menores de idade, imagens que contenham figuras de crianças não poderão ser editadas ou processadas.

Certifique-se de que todas as pessoas na imagem enviada sejam adultas.

Mensagem de Erro:

Desculpe, esta imagem não pode ser processada.

Motivo: O sistema detectou que a imagem pode conter a figura de um menor de idade.

Sugestão: Por favor, use imagens que contenham apenas adultos ou remova a parte da imagem que contém o menor e tente novamente.

Sugestões de Design do Aplicativo

-

Defina Claramente os Cenários de Uso

- Indique na documentação do produto que o processamento de fotos de crianças não é suportado.

- Inclua cláusulas relacionadas nos termos de uso do usuário.

-

Otimize a Experiência do Usuário

- Ofereça mensagens de erro amigáveis.

- Explique o motivo da restrição em vez de apenas exibir um código de erro.

- Dê sugestões de alternativas viáveis.

-

Preparação de Documentação de Conformidade

- Mantenha logs das chamadas de API.

- Registre as ocorrências de ativação dos filtros de segurança.

- Estabeleça um mecanismo de reporte para situações anômalas.

💰 Otimização de Custos: Para projetos que exigem chamadas frequentes à API de edição de imagem, considere utilizar a plataforma APIYI (apiyi.com). Ela oferece formas flexíveis de faturamento e preços mais competitivos, sendo ideal para pequenas e médias equipes, além de desenvolvedores independentes.

Perguntas Frequentes

P1: Por que fotos que são claramente de adultos ativam o IMAGE_SAFETY?

O Nano Banana Pro adota uma estratégia conservadora para o julgamento de idade. Quando o sistema não tem um nível de confiança alto o suficiente na avaliação da idade, ele trata a imagem como sendo de um menor por padrão para garantir a segurança.

Possíveis causas incluem:

- Traços faciais rejuvenescidos (como "rosto de bebê").

- Iluminação ou ângulo da foto que dificultam o julgamento.

- Efeitos de filtro no estilo cartoon ou anime.

Recomendamos o uso de fotos que mostrem claramente as características faciais. Através da plataforma APIYI (apiyi.com), você pode obter informações de diagnóstico de erro mais detalhadas.

P2: O erro IMAGE_SAFETY pode ser resolvido ajustando parâmetros?

Não. As proteções relacionadas à segurança infantil são mecanismos centrais de segurança do Nano Banana Pro e pertencem a uma categoria de proteção não ajustável.

Este é um padrão da indústria estabelecido pelo Google em colaboração com organizações de proteção à criança. Nenhum parâmetro ou configuração de API pode contornar essa restrição. Isso não é um bug, mas sim um design de segurança intencional.

Se precisar processar um grande volume de imagens, sugerimos realizar uma pré-seleção e validar a conformidade das imagens usando os créditos de teste da plataforma APIYI (apiyi.com).

P3: Como saber se uma imagem vai ativar as restrições de segurança?

Sugerimos realizar uma pré-detecção antes do processamento oficial:

- Confirme se não há figuras óbvias de menores na imagem.

- Evite usar cenários comuns a crianças, como escolas ou parquinhos.

- Teste primeiro com uma versão de visualização em baixa resolução.

- Estabeleça um fluxo de revisão interna para filtrar imagens sensíveis.

P4: A detecção de CSAM pode gerar falsos positivos em conteúdos normais?

A tecnologia de correspondência de hash (hash matching) é direcionada a bancos de dados conhecidos de CSAM, e a taxa de falsos positivos é extremamente baixa. No entanto, o julgamento de idade por IA pode apresentar erros de avaliação.

Se você tiver certeza de que o conteúdo da imagem está em conformidade, mas ela ainda for rejeitada, provavelmente é devido à estratégia conservadora de julgamento de idade. O sistema foi projetado para preferir rejeitar erroneamente um conteúdo normal do que deixar passar qualquer situação que possa envolver menores.

P5: O uso de personagens de anime ou virtuais sofre restrições?

Sim, os mecanismos de proteção do Nano Banana Pro também se aplicam a animes, ilustrações e personagens virtuais.

Se um personagem virtual for apresentado com a aparência de um menor de idade, ele também ativará a restrição IMAGE_SAFETY. Recomendamos o uso de personagens virtuais que sejam claramente adultos ou evitar operações de edição que envolvam figuras humanas.

Resumo e Recomendações

Os 5 principais mecanismos de proteção de menores do Nano Banana Pro refletem a alta prioridade que a indústria de IA dá à segurança infantil:

| Ponto-chave | Descrição |

|---|---|

| Princípio Central | Safety by Design (Segurança por Design), a segurança infantil acima de tudo |

| Arquitetura Técnica | Detecção de hash + classificadores de IA + filtragem de conteúdo em múltiplas camadas |

| Inviolável | As restrições de segurança infantil não podem ser contornadas por nenhum ajuste de parâmetro |

| Padrões da Indústria | Desenvolvido em colaboração com organizações como Thorn e NCMEC |

| Sugestão de Conformidade | Informar claramente as limitações aos usuários e fornecer mensagens de erro amigáveis |

Sugestões de Ação

- Desenvolvedores: Reservem a lógica de tratamento para restrições de segurança no design da aplicação.

- Gerentes de Produto: Incluam as restrições de segurança infantil no planejamento das funcionalidades do produto.

- Equipe de Operações: Preparem roteiros de resposta padrão para consultas de usuários.

Recomendamos testar rapidamente as funcionalidades do Nano Banana Pro através da APIYI (apiyi.com) para entender os limites reais de segurança.

Referências:

-

Google AI Safety Policies: Documentação oficial de políticas de segurança

- Link:

ai.google.dev/gemini-api/docs/safety-policies

- Link:

-

Thorn – Safety by Design: Iniciativa de tecnologia para segurança infantil

- Link:

thorn.org/safety-by-design

- Link:

-

NCMEC Reports: Relatórios do Centro Nacional para Crianças Desaparecidas e Exploradas

- Link:

missingkids.org/gethelpnow/csam-reports

- Link:

📝 Autor: APIYI Team | 🌐 Comunidade Técnica: apiyi.com

Este artigo foi organizado e publicado pela equipe técnica da APIYI. Em caso de dúvidas, visite a APIYI (apiyi.com) para obter suporte técnico.