Lors de l'utilisation de Nano Banana Pro pour l'édition d'images, rencontrer une erreur IMAGE_SAFETY est un problème qui déroute de nombreux développeurs. Cet article analyse en profondeur les 5 grands mécanismes de protection des mineurs de Nano Banana Pro pour vous aider à comprendre pourquoi les images contenant des mineurs présumés sont refusées par le système.

Valeur ajoutée : En lisant cet article, vous aurez une vision complète du système de protection de l'enfance de Nano Banana Pro, vous comprendrez les mécanismes de déclenchement de l'erreur IMAGE_SAFETY et vous maîtriserez les meilleures pratiques pour une utilisation conforme de l'API d'édition d'images.

Points clés des mécanismes de protection des mineurs de Nano Banana Pro

Avant de plonger dans les détails techniques, comprenons l'architecture de base du mécanisme de sécurité enfant de Nano Banana Pro.

| Niveau de protection | Moyens techniques | Objectif de protection | Moment du déclenchement |

|---|---|---|---|

| Niveau 1 | Correspondance de hachage | Identifier le contenu CSAM connu | Lors de l'upload de l'image |

| Niveau 2 | Classificateur d'IA | Identifier les invites de type CSAE | Lors de l'analyse de la requête |

| Niveau 3 | Filtrage de sécurité | Bloquer l'édition impliquant des mineurs | Lors de l'exécution du traitement |

| Niveau 4 | Purification des données | Éliminer le contenu problématique à la source | Lors de l'entraînement du modèle |

| Niveau 5 | Tests pré-déploiement | Garantir les normes de sécurité enfant | Lors de la sortie de version |

Principes fondamentaux de la protection de l'enfance de Nano Banana Pro

Nano Banana Pro adopte le concept de Safety by Design (sécurité dès la conception), une norme industrielle établie par Google en collaboration avec des organisations de protection de l'enfance telles que Thorn et All Tech Is Human.

Les principes de protection fondamentaux incluent :

- Politique de tolérance zéro : Le contenu lié à l'abus sexuel ou à l'exploitation d'enfants est systématiquement bloqué et ne peut être contourné par aucun paramètre.

- Identification proactive : Le système détecte activement les contenus susceptibles d'impliquer des mineurs, plutôt que de réagir passivement.

- Vérification multiple : Des mécanismes de sécurité à plusieurs niveaux travaillent de concert pour garantir l'absence de failles.

- Mises à jour continues : Les modèles de sécurité sont itérés en permanence pour faire face aux nouvelles menaces.

🎯 Conseil technique : Dans le développement réel, comprendre ces mécanismes de protection aide à concevoir des flux d'application plus conformes. Nous vous recommandons d'effectuer vos tests d'appel API via la plateforme APIYI (apiyi.com), qui fournit une documentation détaillée sur les codes d'erreur et un support technique.

Analyse approfondie de l'erreur IMAGE_SAFETY

Lorsque Nano Banana Pro détecte une image contenant potentiellement des mineurs, il renvoie une erreur IMAGE_SAFETY. Analysons ce mécanisme en détail.

Détails des conditions de déclenchement de l'erreur IMAGE_SAFETY

| Type d'erreur | Condition de déclenchement | Code d'erreur | Contournable ? |

|---|---|---|---|

| PROHIBITED_CONTENT | Détection d'un hash CSAM connu | 400 | Non |

| IMAGE_SAFETY | L'image contient des mineurs présumés | 400 | Non |

| SAFETY_BLOCK | L'invite concerne du contenu lié aux mineurs | 400 | Non |

| CONTENT_FILTER | Déclenchement combiné de plusieurs règles de sécurité | 400 | Non |

Principes techniques de l'erreur IMAGE_SAFETY

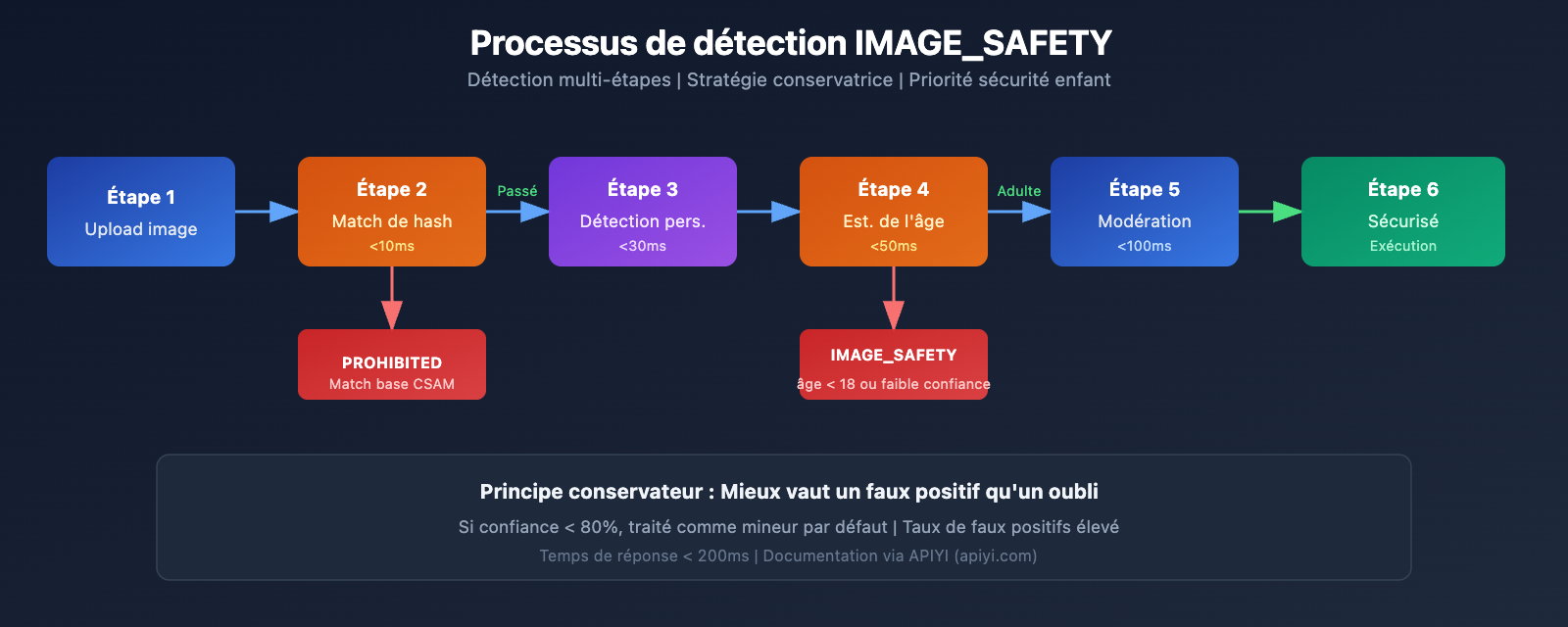

Le système de détection IMAGE_SAFETY de Nano Banana Pro utilise une technologie d'analyse multimodale :

1. Analyse des traits du visage

Le système analyse les traits du visage des personnes présentes sur l'image pour évaluer si elles sont susceptibles d'être mineures :

# Exemple de pseudo-code : Processus de détection IMAGE_SAFETY

def check_image_safety(image_data):

"""

Illustration de la logique de détection IMAGE_SAFETY de Nano Banana Pro

Note : Il s'agit d'une explication simplifiée, l'implémentation réelle est plus complexe

"""

# Étape 1 : Détection par correspondance de hash

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# Étape 2 : Détection de personnes

persons = detect_persons(image_data)

# Étape 3 : Estimation de l'âge

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# Stratégie conservatrice : mieux vaut un faux positif qu'un oubli

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. Principes de la stratégie conservatrice

Pour garantir la sécurité des enfants, le système adopte une approche prudente :

- Lorsque l'indice de confiance de l'estimation de l'âge est insuffisant, le sujet est traité par défaut comme un mineur.

- Toute scène susceptible d'impliquer des mineurs sera bloquée.

- Le taux de faux positifs est délibérément élevé ; la protection des enfants est la priorité absolue.

Scénarios courants d'erreur IMAGE_SAFETY

D'après les retours de la communauté des développeurs, les scénarios suivants sont les plus susceptibles de déclencher une erreur IMAGE_SAFETY :

| Scénario | Cause | Suggestion |

|---|---|---|

| Édition de photos de famille | L'image contient des enfants | Retirer les enfants avant l'édition |

| Traitement de scènes scolaires | Peut contenir des étudiants | Utiliser un arrière-plan sans personnages |

| Retouche de visages jeunes | Jugement d'âge conservateur | Confirmer que le sujet est majeur |

| Style cartoon / anime | L'IA confond avec de vrais enfants | Utiliser un style nettement non réaliste |

| Restauration de photos historiques | Présence de mineurs sur la photo | Sélectionner uniquement les parties avec des adultes |

💡 Conseils de conception : Lors de la conception de fonctionnalités d'édition d'images, il est conseillé d'informer les utilisateurs de ces limitations à l'avance. La plateforme APIYI (apiyi.com) permet d'accéder à la liste complète des codes d'erreur et aux conseils de traitement.

Analyse complète de la technologie de protection contre les CSAM

La protection contre les CSAM (Child Sexual Abuse Material – Matériel d'abus sexuel sur mineur) est une composante centrale du système de sécurité de Nano Banana Pro.

Architecture technique de protection contre les CSAM

Nano Banana Pro utilise des technologies de protection contre les CSAM de pointe dans l'industrie :

1. Technologie de hachage (Hash matching)

# Exemple : Logique de détection par correspondance de hachage

import hashlib

def compute_perceptual_hash(image):

"""

Calcule le hachage perceptuel de l'image

Utilisé pour la correspondance avec les bases de données CSAM connues

"""

# Redimensionnement et normalisation des couleurs

normalized = normalize_image(image)

# Calcul du hachage perceptuel

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

Vérifie la correspondance avec des CSAM connus

"""

# Correspondance floue, permettant certaines variantes

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. Technologie de classificateur IA

Les classificateurs IA sont spécifiquement entraînés pour identifier :

- Les invites cherchant du contenu CSAE (Child Sexual Abuse or Exploitation).

- Les tentatives de contournement des détections de sécurité via des variantes de requêtes.

- Les modèles suspects de combinaisons texte-image.

3. Synergie de protection multi-niveaux

| Niveau de détection | Mise en œuvre technique | Cible de détection | Temps de réponse |

|---|---|---|---|

| Couche d'entrée | Correspondance de hachage | Contenu illégal connu | < 10ms |

| Couche de compréhension | Classificateur IA | Identification de l'intention | < 50ms |

| Couche d'exécution | Filtre de contenu | Modération de la sortie | < 100ms |

| Couche de surveillance | Analyse comportementale | Modèles anormaux | Temps réel |

Collaboration et normes de l'industrie

Le système de protection contre les CSAM de Nano Banana Pro collabore avec plusieurs organisations sectorielles :

- Thorn : Organisation technologique de lutte contre l'exploitation des enfants.

- All Tech Is Human : Organisation d'initiative sur l'éthique technologique.

- NCMEC : Centre national pour les enfants disparus et exploités (États-Unis).

- Tech Coalition : Alliance d'entreprises technologiques contre les CSAM.

🔒 Note de sécurité : Les rapports du NCMEC indiquent que plus de 7 000 cas de CSAM liés à l'IA générative (GAI) ont été confirmés en deux ans. Les protections strictes de Nano Banana Pro sont une mesure nécessaire pour faire face à cette situation critique.

Liste complète des restrictions d'édition d'image Nano Banana Pro

En plus de la protection des mineurs, Nano Banana Pro impose d'autres restrictions sur l'édition d'images.

Classification des restrictions d'édition d'image

| Catégorie de restriction | Sévérité | Ajustable | Scénarios d'application |

|---|---|---|---|

| Sécurité des enfants | Maximale | Non | Tous les scénarios |

| Protection CSAM | Maximale | Non | Tous les scénarios |

| Contenu violent | Haute | Partiellement | Médical, Éducation |

| Contenu pornographique | Haute | Partiellement | Plateformes adultes |

| Infos dangereuses | Moyenne | Partiellement | Recherche |

| Discours de haine | Haute | Non | Tous les scénarios |

Protections de base non ajustables

Nano Banana Pro stipule clairement que les catégories de dommages suivantes sont systématiquement bloquées et ne peuvent être modifiées par aucun paramètre ou réglage d'API :

-

Contenu lié aux CSAM

- Interdiction de générer tout contenu lié à l'abus sexuel d'enfants.

- Interdiction d'utiliser l'IA pour générer du contenu inapproprié impliquant des mineurs.

- Les entrées CSAM sont marquées comme

PROHIBITED_CONTENT.

-

Utilisation d'images sans consentement

- Interdiction d'utiliser les images d'autrui sans autorisation.

- Interdiction de créer des "deepfakes" de visages de tiers.

- Une autorisation explicite est requise pour les personnes réelles.

-

Contenu d'exploitation d'enfants

- Interdiction de toute forme de génération de contenu d'exploitation d'enfants.

- Inclut, sans s'y limiter, l'exploitation sexuelle, le travail forcé, etc.

- Couvre les représentations de mineurs réels et fictifs.

Instructions de configuration des paramètres de sécurité

Bien que les protections de base pour la sécurité des enfants ne soient pas ajustables, Nano Banana Pro propose des options de configuration pour d'autres paramètres de sécurité :

from openai import OpenAI

# Initialisation du client

client = OpenAI(

api_key="VOTRE_CLE_API",

base_url="https://api.apiyi.com/v1" # Utilisation de l'interface unifiée APIYI

)

# Exemple de requête d'édition d'image

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="Changer la couleur de l'arrière-plan en bleu",

# Paramètres de sécurité (Note : la sécurité des enfants n'est pas ajustable)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# Le réglage suivant est inefficace pour la sécurité des enfants, toujours au niveau max

# "child_safety": non configurable

}

)

Voir le code de configuration de sécurité complet

"""

Exemple de configuration de sécurité complète Nano Banana Pro

Démonstration des paramètres de sécurité configurables et non configurables

"""

from openai import OpenAI

import base64

# Initialisation du client

client = OpenAI(

api_key="VOTRE_CLE_API",

base_url="https://api.apiyi.com/v1" # Utilisation de l'interface unifiée APIYI

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

Fonction d'édition d'image sécurisée

Inclut une gestion complète des erreurs

"""

try:

# Lecture de l'image

with open(image_path, "rb") as f:

image_data = f.read()

# Envoi de la requête d'édition

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# Gestion de l'erreur IMAGE_SAFETY

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "L'image semble contenir un mineur, traitement impossible",

"suggestion": "Veuillez utiliser une image contenant uniquement des adultes"

}

# Gestion de l'erreur PROHIBITED_CONTENT

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "Contenu interdit détecté",

"suggestion": "Veuillez vérifier la conformité du contenu de l'image"

}

# Autres erreurs

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# Exemple d'utilisation

result = safe_image_edit("photo.jpg", "Changer l'arrière-plan pour une plage")

if result["success"]:

print(f"Édition réussie : {result['url']}")

else:

print(f"Échec de l'édition : {result['message']}")

print(f"Suggestion : {result.get('suggestion', 'Veuillez réessayer')}")

🚀 Démarrage rapide : Il est recommandé d'utiliser la plateforme APIYI (apiyi.com) pour tester rapidement Nano Banana Pro. Cette plateforme fournit des interfaces API prêtes à l'emploi, sans configuration complexe, avec une documentation complète sur la gestion des erreurs.

Bonnes pratiques pour une utilisation conforme de Nano Banana Pro

Maintenant que nous avons compris les mécanismes de sécurité, voyons comment utiliser Nano Banana Pro en toute conformité.

Liste de contrôle avant le développement

Avant d'intégrer Nano Banana Pro à votre application, veuillez vérifier les points suivants :

| Élément de contrôle | Nécessité | Méthode de vérification | Conseil de conformité |

|---|---|---|---|

| Vérification de l'âge de l'utilisateur | Obligatoire | Vérification à l'inscription | Limite de 18 ans et plus |

| Confirmation de la source de l'image | Obligatoire | Accord d'upload | Demander à l'utilisateur de confirmer les droits d'auteur |

| Limitation des scénarios d'utilisation | Conseillé | Conception des fonctionnalités | Informer clairement des limites d'utilisation |

| Mécanisme de gestion des erreurs | Obligatoire | Implémentation du code | Messages conviviaux pour l'utilisateur |

| Processus de modération du contenu | Conseillé | Système back-office | Mécanisme de double vérification humaine |

Bonnes pratiques pour les messages utilisateur

Pour éviter toute confusion de la part de vos utilisateurs, nous vous conseillons d'ajouter les messages suivants dans votre application :

Message d'upload :

Conseil : Pour protéger la sécurité des mineurs, les images contenant des visages d'enfants ne pourront pas être modifiées.

Veuillez vous assurer que toutes les personnes présentes sur l'image sont majeures.

Message d'erreur :

Désolé, cette image ne peut pas être traitée.

Raison : Le système a détecté que l'image pourrait contenir des mineurs.

Suggestion : Veuillez utiliser des images ne contenant que des adultes, ou réessayez après avoir retiré les parties de l'image représentant des mineurs.

Conseils de conception d'application

-

Définir clairement les scénarios d'utilisation

- Précisez dans la documentation produit que le traitement des photos d'enfants n'est pas pris en charge.

- Incluez des clauses pertinentes dans vos conditions d'utilisation.

-

Optimiser l'expérience utilisateur

- Proposez des messages d'erreur conviviaux.

- Expliquez la raison de la restriction plutôt que d'afficher un simple code d'erreur.

- Donnez des alternatives réalisables.

-

Préparation de la documentation de conformité

- Conservez les journaux d'appels API.

- Enregistrez les cas de déclenchement du filtrage de sécurité.

- Établissez un mécanisme de signalement des anomalies.

💰 Optimisation des coûts : Pour les projets nécessitant des appels fréquents à l'API d'édition d'images, vous pouvez envisager de passer par la plateforme APIYI (apiyi.com). Elle propose des modes de facturation flexibles et des tarifs plus avantageux, parfaits pour les petites et moyennes équipes ainsi que les développeurs indépendants.

Questions fréquentes

Q1 : Pourquoi des photos d’adultes évidents déclenchent-elles parfois IMAGE_SAFETY ?

Nano Banana Pro adopte une stratégie conservatrice pour l'estimation de l'âge. Si le système n'est pas assez confiant dans son jugement, il traitera l'image comme celle d'un mineur par défaut pour garantir la sécurité.

Les causes possibles incluent :

- Des traits du visage très jeunes (type "baby face").

- Un éclairage ou un angle de vue qui fausse le jugement.

- Des filtres de style dessin animé ou anime.

Nous vous conseillons d'utiliser des photos montrant clairement les traits du visage. Via la plateforme APIYI (apiyi.com), vous pouvez obtenir des informations de diagnostic d'erreur plus détaillées.

Q2 : L’erreur IMAGE_SAFETY peut-elle être résolue en ajustant les paramètres ?

Non. La protection liée à la sécurité des enfants est un mécanisme de sécurité central de Nano Banana Pro et appartient à une catégorie de protection non ajustable.

C'est une norme industrielle établie par Google en collaboration avec des organisations de protection de l'enfance. Aucun paramètre ou configuration d'API ne peut contourner cette restriction. Ce n'est pas un bug, mais une conception de sécurité intentionnelle.

Si vous devez traiter un grand volume d'images, nous vous conseillons d'effectuer un pré-filtrage et de vérifier la conformité des images via les crédits de test de la plateforme APIYI (apiyi.com).

Q3 : Comment savoir si une image va déclencher les restrictions de sécurité ?

Nous recommandons d'effectuer un pré-contrôle avant le traitement officiel :

- Confirmez qu'il n'y a pas de mineurs évidents sur l'image.

- Évitez les scènes typiquement liées à l'enfance (écoles, parcs d'attractions, etc.).

- Testez d'abord avec une version basse résolution.

- Établissez un processus de modération interne pour filtrer les images sensibles.

Q4 : La détection CSAM peut-elle générer des faux positifs sur du contenu normal ?

La technologie de hachage (hash matching) cible des bases de données CSAM connues, le taux de faux positifs est donc extrêmement bas. Cependant, l'estimation de l'âge par l'IA peut comporter des erreurs de jugement.

Si vous êtes certain que le contenu est conforme mais qu'il est rejeté, cela est probablement dû à la stratégie conservatrice d'estimation de l'âge. Le système est conçu pour rejeter par erreur un contenu normal plutôt que de laisser passer une situation impliquant potentiellement un mineur.

Q5 : L’utilisation de personnages d’anime ou virtuels est-elle restreinte ?

Oui, les mécanismes de protection de Nano Banana Pro s'appliquent également aux dessins animés, aux illustrations et aux personnages virtuels.

Si un personnage virtuel est représenté sous les traits d'un mineur, cela déclenchera également la restriction IMAGE_SAFETY. Nous vous conseillons d'utiliser des personnages virtuels manifestement adultes ou d'éviter les opérations d'édition impliquant des personnages.

Résumé et recommandations

Les 5 grands mécanismes de protection des mineurs de Nano Banana Pro illustrent l'importance capitale accordée à la sécurité des enfants dans le secteur de l'IA :

| Point clé | Description |

|---|---|

| Principe fondamental | Safety by Design, la sécurité des enfants passe avant tout |

| Architecture technique | Détection de hachage + classificateurs IA + filtrage de contenu (protection multicouche) |

| Incontournable | Les restrictions de sécurité pour enfants ne peuvent être contournées par aucun ajustement de paramètre |

| Normes de l'industrie | Élaborées en collaboration avec des organisations comme Thorn et le NCMEC |

| Conseils de conformité | Informer clairement les utilisateurs des restrictions et fournir des messages d'erreur conviviaux |

Conseils d'action

- Développeurs : Prévoir une logique de gestion des restrictions de sécurité dès la conception de l'application.

- Chefs de produit : Intégrer les restrictions de sécurité pour enfants dans la planification des fonctionnalités du produit.

- Équipes opérationnelles : Préparer des scripts de réponse standardisés pour répondre aux questions des utilisateurs.

Nous vous recommandons de tester rapidement les différentes fonctionnalités de Nano Banana Pro via APIYI (apiyi.com) pour mieux appréhender les limites de sécurité réelles.

Ressources complémentaires :

-

Google AI Safety Policies : Documentation officielle sur les politiques de sécurité

- Lien :

ai.google.dev/gemini-api/docs/safety-policies

- Lien :

-

Thorn – Safety by Design : Initiative technologique pour la sécurité des enfants

- Lien :

thorn.org/safety-by-design

- Lien :

-

NCMEC Reports : Rapports du Centre national pour les enfants disparus et exploités

- Lien :

missingkids.org/gethelpnow/csam-reports

- Lien :

📝 Auteur : Équipe APIYI | 🌐 Échanges techniques : apiyi.com

Cet article a été préparé et publié par l'équipe technique d'APIYI. Si vous avez des questions, n'hésitez pas à visiter APIYI (apiyi.com) pour obtenir du support technique.