Saat menggunakan Nano Banana Pro untuk mengedit gambar, menemui error IMAGE_SAFETY adalah masalah yang sering membingungkan banyak pengembang. Artikel ini akan mengupas tuntas 5 mekanisme perlindungan anak di bawah umur dari Nano Banana Pro untuk membantu Anda memahami mengapa gambar yang diduga berisi anak di bawah umur ditolak oleh sistem.

Nilai Inti: Setelah membaca artikel ini, Anda akan memahami sepenuhnya sistem perlindungan keamanan anak di Nano Banana Pro, memahami mekanisme pemicu error IMAGE_SAFETY, dan menguasai praktik terbaik dalam menggunakan API pengeditan gambar secara patuh.

Poin Utama Mekanisme Perlindungan Anak di Bawah Umur Nano Banana Pro

Sebelum mendalami detail teknisnya, mari kita pahami arsitektur inti dari mekanisme keamanan anak di Nano Banana Pro.

| Tingkat Perlindungan | Metode Teknis | Target Perlindungan | Waktu Pemicuan |

|---|---|---|---|

| Lapisan 1 | Deteksi Pencocokan Hash | Mengidentifikasi konten CSAM yang diketahui | Saat unggah gambar |

| Lapisan 2 | Klasifikasi AI | Mengidentifikasi petunjuk pencarian CSAE | Saat penguraian permintaan |

| Lapisan 3 | Filter Keamanan Konten | Memblokir pengeditan yang melibatkan anak di bawah umur | Saat eksekusi pemrosesan |

| Lapisan 4 | Pembersihan Data Pelatihan | Menghilangkan konten bermasalah dari sumbernya | Saat pelatihan model |

| Lapisan 5 | Pengujian Sebelum Rilis | Memastikan standar keamanan anak | Saat rilis versi |

Prinsip Inti Perlindungan Keamanan Anak Nano Banana Pro

Nano Banana Pro mengadopsi konsep desain Safety by Design, yang merupakan standar industri yang dikembangkan oleh Google bekerja sama dengan organisasi perlindungan anak seperti Thorn dan All Tech Is Human.

Prinsip perlindungan inti meliputi:

- Kebijakan Nol Toleransi: Konten yang terkait dengan pelecehan seksual atau eksploitasi anak akan selalu diblokir dan tidak dapat diubah melalui parameter apa pun.

- Identifikasi Proaktif: Sistem secara aktif mendeteksi konten yang mungkin melibatkan anak di bawah umur, bukan sekadar merespons secara pasif.

- Verifikasi Ganda: Mekanisme keamanan berlapis bekerja secara sinergis untuk memastikan tidak ada celah.

- Pembaruan Berkelanjutan: Model keamanan terus diperbarui untuk menghadapi ancaman jenis baru.

🎯 Saran Teknis: Dalam pengembangan praktis, memahami mekanisme perlindungan ini membantu Anda merancang alur aplikasi yang lebih patuh. Kami menyarankan untuk melakukan pengujian panggilan API melalui platform APIYI apiyi.com, yang menyediakan dokumentasi kode error yang mendetail dan dukungan teknis.

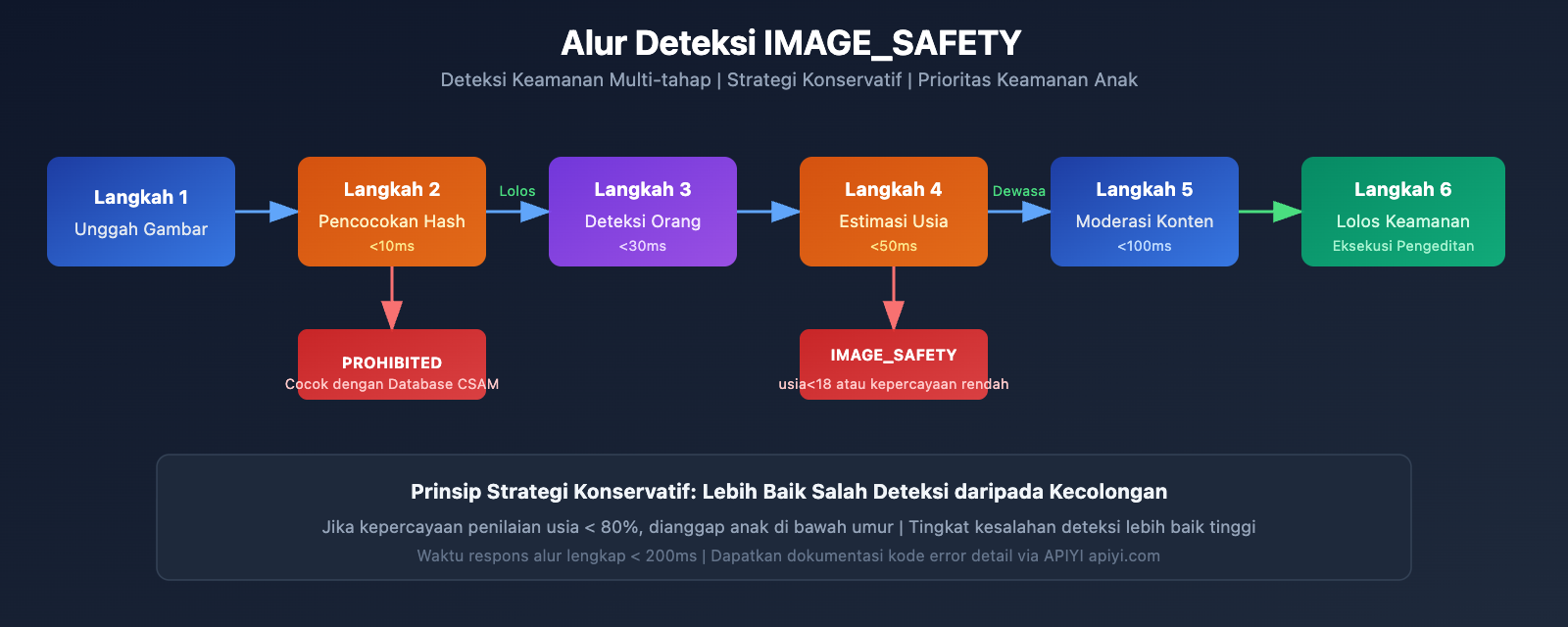

Analisis Mendalam Error IMAGE_SAFETY

Saat Nano Banana Pro mendeteksi adanya dugaan anak di bawah umur dalam gambar, sistem akan mengembalikan error IMAGE_SAFETY. Mari kita bedah mekanisme ini lebih dalam.

Detail Kondisi Pemicu Error IMAGE_SAFETY

| Tipe Error | Kondisi Pemicu | Kode Error | Bisa Dihindari? |

|---|---|---|---|

| PROHIBITED_CONTENT | Terdeteksi hash CSAM yang dikenal | 400 | Tidak |

| IMAGE_SAFETY | Gambar mengandung dugaan anak di bawah umur | 400 | Tidak |

| SAFETY_BLOCK | Petunjuk melibatkan konten terkait anak di bawah umur | 400 | Tidak |

| CONTENT_FILTER | Kombinasi memicu beberapa aturan keamanan | 400 | Tidak |

Prinsip Teknis Error IMAGE_SAFETY

Sistem deteksi IMAGE_SAFETY pada Nano Banana Pro menggunakan teknologi analisis multimodal:

1. Analisis Fitur Wajah

Sistem akan menganalisis fitur wajah orang dalam gambar untuk mengevaluasi apakah mereka kemungkinan adalah anak di bawah umur:

# Ilustrasi pseudocode: Alur deteksi IMAGE_SAFETY

def check_image_safety(image_data):

"""

Ilustrasi logika deteksi IMAGE_SAFETY Nano Banana Pro

Catatan: Ini adalah penjelasan alur yang disederhanakan, implementasi aslinya lebih kompleks

"""

# Langkah 1: Deteksi pencocokan hash

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# Langkah 2: Deteksi orang

persons = detect_persons(image_data)

# Langkah 3: Estimasi usia

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# Strategi konservatif: Lebih baik salah deteksi daripada kecolongan

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. Prinsip Strategi Konservatif

Untuk memastikan keamanan anak-anak, sistem menerapkan strategi konservatif:

- Jika tingkat kepercayaan penilaian usia kurang, sistem akan menganggapnya sebagai anak di bawah umur secara default.

- Skenario apa pun yang berpotensi melibatkan anak di bawah umur akan diblokir.

- Tingkat kesalahan deteksi (false positive) lebih baik tinggi daripada rendah; melindungi keamanan anak adalah prioritas utama.

Skenario Umum Error IMAGE_SAFETY

Berdasarkan masukan dari komunitas pengembang, skenario berikut paling sering memicu error IMAGE_SAFETY:

| Skenario | Penyebab Pemicu | Saran Solusi |

|---|---|---|

| Pengeditan foto keluarga | Gambar mengandung anak-anak | Hapus anak-anak sebelum mengedit |

| Pemrosesan skenario sekolah | Mungkin mengandung siswa | Gunakan latar belakang tanpa orang |

| Retouching wajah muda | Penilaian usia yang konservatif | Pastikan subjek sudah dewasa |

| Gaya kartun/anime | AI salah mengira sebagai anak sungguhan | Gunakan gaya yang jelas-jelas tidak nyata |

| Restorasi foto sejarah | Ada anak di bawah umur dalam foto | Pilih bagian yang hanya berisi orang dewasa |

💡 Saran: Saat merancang fitur pengeditan gambar, sebaiknya beri tahu pengguna tentang batasan ini sebelumnya. Melalui platform APIYI apiyi.com, Anda bisa mendapatkan daftar lengkap kode error dan saran penanganannya.

Analisis Lengkap Teknologi Perlindungan CSAM

Perlindungan CSAM (Child Sexual Abuse Material) adalah komponen inti dari sistem keamanan Nano Banana Pro.

Arsitektur Teknologi Perlindungan CSAM

Nano Banana Pro menggunakan teknologi perlindungan CSAM yang terdepan di industri:

1. Teknologi Pencocokan Hash

# Contoh: Logika deteksi pencocokan hash

import hashlib

def compute_perceptual_hash(image):

"""

Menghitung hash perseptual gambar

Digunakan untuk mencocokkan dengan database CSAM yang diketahui

"""

# Menyesuaikan ukuran dan warna gambar

normalized = normalize_image(image)

# Menghitung hash perseptual

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

Memeriksa apakah cocok dengan CSAM yang diketahui

"""

# Pencocokan samar, mengizinkan variasi tertentu

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. Teknologi Klasifikasi AI

Klasifikator AI dilatih secara khusus untuk mengidentifikasi:

- Petunjuk pencarian CSAE (Child Sexual Abuse or Exploitation)

- Permintaan variasi yang mencoba melewati deteksi keamanan

- Pola kombinasi teks dan gambar yang mencurigakan

3. Sinergi Perlindungan Multi-level

| Level Deteksi | Implementasi Teknologi | Target Deteksi | Waktu Respons |

|---|---|---|---|

| Lapisan Input | Pencocokan Hash | Konten pelanggaran yang diketahui | < 10ms |

| Lapisan Pemahaman | Klasifikator AI | Identifikasi niat | < 50ms |

| Lapisan Eksekusi | Filter Konten | Audit output | < 100ms |

| Lapisan Pemantauan | Analisis Perilaku | Pola anomali | Real-time |

Kerja Sama dan Standar Industri

Sistem perlindungan CSAM Nano Banana Pro bekerja sama dengan berbagai organisasi industri:

- Thorn: Organisasi teknologi anti-eksploitasi anak

- All Tech Is Human: Organisasi inisiatif etika teknologi

- NCMEC: National Center for Missing & Exploited Children (Pusat Nasional untuk Anak Hilang & Dieksploitasi)

- Tech Coalition: Aliansi perusahaan teknologi anti-CSAM

🔒 Catatan Keamanan: Laporan NCMEC menunjukkan bahwa lebih dari 7.000 kasus CSAM terkait GAI (Generative AI) telah dikonfirmasi dalam dua tahun terakhir. Perlindungan ketat Nano Banana Pro adalah langkah yang sangat diperlukan untuk menghadapi situasi serius ini.

Daftar Lengkap Batasan Pengeditan Gambar Nano Banana Pro

Selain perlindungan anak di bawah umur, Nano Banana Pro juga memiliki batasan pengeditan gambar lainnya.

Klasifikasi Batasan Pengeditan Gambar

| Kategori Batasan | Tingkat Ketat | Dapat Diubah? | Skenario Penggunaan |

|---|---|---|---|

| Keamanan Anak | Tertinggi | Tidak | Semua skenario |

| Perlindungan CSAM | Tertinggi | Tidak | Semua skenario |

| Konten Kekerasan | Tinggi | Sebagian | Medis, Edukasi |

| Konten Pornografi | Tinggi | Sebagian | Platform Dewasa |

| Informasi Berbahaya | Menengah | Sebagian | Tujuan Riset |

| Ujaran Kebencian | Tinggi | Tidak | Semua skenario |

Perlindungan Inti yang Tidak Dapat Diubah

Nano Banana Pro menetapkan dengan jelas bahwa kategori bahaya berikut akan selalu diblokir dan tidak dapat diubah melalui parameter API atau pengaturan apa pun:

-

Konten Terkait CSAM

- Dilarang menghasilkan konten apa pun yang terkait dengan pelecehan seksual anak.

- Dilarang menggunakan AI untuk menghasilkan konten tidak pantas yang melibatkan anak di bawah umur.

- Input CSAM akan ditandai sebagai PROHIBITED_CONTENT.

-

Penggunaan Gambar Tanpa Izin

- Dilarang menggunakan gambar orang lain tanpa otorisasi.

- Dilarang melakukan deepfake pada wajah orang lain.

- Penggunaan yang melibatkan tokoh nyata memerlukan izin yang jelas.

-

Konten Eksploitasi Anak

- Dilarang menghasilkan segala bentuk konten eksploitasi anak.

- Termasuk namun tidak terbatas pada eksploitasi seksual, eksploitasi tenaga kerja, dll.

- Mencakup citra anak di bawah umur baik yang nyata maupun fiktif.

Penjelasan Konfigurasi Parameter Keamanan

Meskipun perlindungan inti keamanan anak tidak dapat diubah, Nano Banana Pro menyediakan opsi konfigurasi untuk parameter keamanan lainnya:

from openai import OpenAI

# Inisialisasi klien

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Menggunakan antarmuka terpadu APIYI

)

# Contoh permintaan pengeditan gambar

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="Ubah warna latar belakang menjadi biru",

# Parameter keamanan (Catatan: Terkait keamanan anak tidak dapat diubah)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# Pengaturan berikut tidak berlaku untuk keamanan anak, selalu di tingkat tertinggi

# "child_safety": Tidak dapat dikonfigurasi

}

)

Lihat kode konfigurasi keamanan lengkap

"""

Contoh Konfigurasi Keamanan Lengkap Nano Banana Pro

Mendemonstrasikan parameter keamanan yang dapat dan tidak dapat dikonfigurasi

"""

from openai import OpenAI

import base64

# Inisialisasi klien

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Menggunakan antarmuka terpadu APIYI

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

Fungsi pengeditan gambar yang aman

Termasuk penanganan kesalahan lengkap

"""

try:

# Membaca gambar

with open(image_path, "rb") as f:

image_data = f.read()

# Mengirim permintaan pengeditan

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# Menangani kesalahan IMAGE_SAFETY

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "Gambar diduga mengandung anak di bawah umur, tidak dapat diproses",

"suggestion": "Harap gunakan gambar yang hanya berisi orang dewasa"

}

# Menangani kesalahan PROHIBITED_CONTENT

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "Konten terlarang terdeteksi",

"suggestion": "Harap periksa apakah konten gambar sudah sesuai aturan"

}

# Kesalahan lainnya

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# Contoh penggunaan

result = safe_image_edit("photo.jpg", "Ubah latar belakang menjadi pantai")

if result["success"]:

print(f"Edit berhasil: {result['url']}")

else:

print(f"Edit gagal: {result['message']}")

print(f"Saran: {result.get('suggestion', 'Silakan coba lagi')}")

🚀 Mulai Cepat: Direkomendasikan menggunakan platform APIYI apiyi.com untuk mencoba Nano Banana Pro dengan cepat. Platform ini menyediakan antarmuka API yang siap pakai tanpa konfigurasi rumit, serta dokumentasi penanganan kesalahan yang lengkap.

Praktik Terbaik Penggunaan Nano Banana Pro yang Patuh

Setelah memahami mekanisme keamanan, mari kita pelajari cara menggunakan Nano Banana Pro secara patuh (compliant).

Daftar Periksa Sebelum Pengembangan

Sebelum mengintegrasikan Nano Banana Pro ke dalam aplikasi Anda, pastikan hal-hal berikut:

| Item Pemeriksaan | Keperluan | Metode Pemeriksaan | Saran Kepatuhan |

|---|---|---|---|

| Verifikasi Usia Pengguna | Wajib | Verifikasi saat pendaftaran | Batasan 18+ |

| Konfirmasi Sumber Gambar | Wajib | Protokol unggahan | Minta pengguna mengonfirmasi hak cipta |

| Batasan Skenario Penggunaan | Disarankan | Desain fitur | Informasikan batasan penggunaan dengan jelas |

| Mekanisme Penanganan Kesalahan | Wajib | Implementasi kode | Berikan petunjuk yang ramah kepada pengguna |

| Proses Moderasi Konten | Disarankan | Sistem backend | Mekanisme peninjauan manual |

Praktik Terbaik Petunjuk Pengguna

Untuk menghindari kebingungan pengguna, disarankan untuk menambahkan petunjuk berikut dalam aplikasi Anda:

Petunjuk Unggahan:

Tips: Untuk melindungi keamanan anak di bawah umur, gambar yang mengandung sosok anak-anak tidak dapat diedit.

Pastikan semua orang dalam gambar yang diunggah adalah orang dewasa.

Petunjuk Kesalahan:

Maaf, gambar ini tidak dapat diproses.

Alasan: Sistem mendeteksi bahwa gambar mungkin mengandung sosok anak di bawah umur.

Saran: Gunakan gambar yang hanya berisi orang dewasa, atau hapus bagian anak di bawah umur dari gambar lalu coba lagi.

Saran Desain Aplikasi

-

Perjelas Skenario Penggunaan

- Jelaskan dalam dokumentasi produk bahwa pengeditan foto anak-anak tidak didukung.

- Sertakan klausul terkait dalam perjanjian pengguna.

-

Optimalkan Pengalaman Pengguna

- Berikan pesan kesalahan yang ramah.

- Jelaskan alasan pembatasan alih-alih hanya menampilkan kode error.

- Berikan saran alternatif yang memungkinkan.

-

Persiapan Dokumentasi Kepatuhan

- Simpan log panggilan API.

- Catat kondisi yang memicu filter keamanan.

- Bangun mekanisme pelaporan untuk situasi yang tidak normal.

💰 Optimasi Biaya: Untuk proyek yang memerlukan pemanggilan API pengeditan gambar secara sering, Anda dapat mempertimbangkan untuk menggunakan platform APIYI apiyi.com. Platform ini menawarkan metode penagihan yang fleksibel dan harga yang lebih terjangkau, sangat cocok untuk tim kecil maupun pengembang individu.

Pertanyaan Umum (FAQ)

Q1: Mengapa foto yang jelas-jelas orang dewasa juga memicu IMAGE_SAFETY?

Nano Banana Pro menggunakan strategi konservatif dalam penilaian usia. Ketika sistem memiliki tingkat kepercayaan yang rendah terhadap penilaian usia, sistem akan secara otomatis menganggapnya sebagai anak di bawah umur untuk memastikan keamanan.

Penyebab yang mungkin memicu hal ini antara lain:

- Fitur wajah yang tampak sangat muda (seperti baby face).

- Pencahayaan atau sudut foto yang membuat penilaian menjadi tidak akurat.

- Efek filter bergaya kartun atau anime.

Disarankan untuk menggunakan foto yang menampilkan fitur wajah dengan jelas. Melalui platform APIYI apiyi.com, Anda bisa mendapatkan informasi diagnosis kesalahan yang lebih mendetail.

Q2: Apakah kesalahan IMAGE_SAFETY bisa diatasi dengan menyesuaikan parameter?

Tidak bisa. Perlindungan terkait keamanan anak adalah mekanisme keamanan inti dari Nano Banana Pro dan termasuk dalam kategori perlindungan yang tidak dapat disesuaikan.

Ini adalah standar industri yang ditetapkan oleh Google bekerja sama dengan organisasi perlindungan anak. Tidak ada parameter atau konfigurasi API apa pun yang dapat melewati batasan ini. Ini bukan bug, melainkan desain keamanan yang disengaja.

Jika Anda perlu memproses gambar dalam jumlah besar, disarankan untuk melakukan penyaringan awal terlebih dahulu dan menggunakan kuota pengujian dari platform APIYI apiyi.com untuk memverifikasi kepatuhan gambar.

Q3: Bagaimana cara mengetahui apakah sebuah gambar akan memicu batasan keamanan?

Disarankan untuk melakukan deteksi awal sebelum pemrosesan resmi:

- Pastikan tidak ada sosok anak di bawah umur yang jelas dalam gambar.

- Hindari penggunaan latar belakang umum anak-anak seperti sekolah atau taman bermain.

- Gunakan versi pratinjau resolusi rendah untuk pengujian terlebih dahulu.

- Bangun proses peninjauan internal untuk menyaring gambar yang sensitif.

Q4: Apakah deteksi CSAM bisa salah melaporkan konten normal?

Teknologi pencocokan hash ditujukan pada basis data CSAM yang sudah diketahui, sehingga tingkat kesalahan pelaporan sangat rendah. Namun, penilaian usia oleh AI mungkin saja mengalami kesalahan penilaian.

Jika Anda yakin konten gambar sudah patuh namun tetap ditolak, kemungkinan besar disebabkan oleh strategi konservatif dalam penilaian usia. Desain sistem lebih memilih untuk salah menolak konten normal daripada melewatkan situasi apa pun yang mungkin melibatkan anak di bawah umur.

Q5: Apakah penggunaan karakter anime atau virtual juga akan dibatasi?

Ya, mekanisme perlindungan Nano Banana Pro juga berlaku untuk anime, ilustrasi, dan karakter virtual.

Jika karakter virtual ditampilkan sebagai sosok anak di bawah umur, hal itu juga akan memicu batasan IMAGE_SAFETY. Disarankan untuk menggunakan karakter virtual yang jelas-jelas dewasa atau menghindari operasi pengeditan yang melibatkan karakter manusia.

Kesimpulan dan Rekomendasi

5 mekanisme perlindungan anak di bawah umur pada Nano Banana Pro mencerminkan betapa tingginya prioritas industri AI terhadap keamanan anak-anak:

| Poin Kunci | Penjelasan |

|---|---|

| Prinsip Inti | Safety by Design, keamanan anak di atas segalanya |

| Arsitektur Teknologi | Deteksi hash + klasifikasi AI + perlindungan berlapis filter konten |

| Tidak Bisa Dilewati | Batasan keamanan anak tidak dapat diubah melalui parameter apa pun |

| Standar Industri | Disusun bekerja sama dengan organisasi seperti Thorn dan NCMEC |

| Saran Kepatuhan | Beri tahu pengguna secara jelas tentang batasan dan berikan pesan kesalahan yang ramah |

Saran Tindakan

- Developer: Siapkan logika penanganan batasan keamanan dalam desain aplikasi.

- Product Manager: Masukkan batasan keamanan anak ke dalam perencanaan fitur produk.

- Tim Operasional: Siapkan skrip jawaban standar untuk menangani pertanyaan pengguna terkait hal ini.

Kami merekomendasikan untuk mencoba berbagai fitur Nano Banana Pro melalui APIYI apiyi.com guna memahami batasan keamanan yang sebenarnya secara cepat.

Referensi:

-

Google AI Safety Policies: Dokumen kebijakan keamanan resmi

- Link:

ai.google.dev/gemini-api/docs/safety-policies

- Link:

-

Thorn – Safety by Design: Inisiatif teknologi keamanan anak

- Link:

thorn.org/safety-by-design

- Link:

-

NCMEC Reports: Laporan Pusat Nasional untuk Anak Hilang dan Dieksploitasi

- Link:

missingkids.org/gethelpnow/csam-reports

- Link:

📝 Penulis: APIYI Team | 🌐 Diskusi Teknologi: apiyi.com

Artikel ini disusun dan diterbitkan oleh tim teknis APIYI. Jika ada pertanyaan, silakan kunjungi APIYI apiyi.com untuk mendapatkan dukungan teknis.