عند استخدام Nano Banana Pro لتحرير الصور، يواجه العديد من المطورين ارتباكاً بسبب خطأ IMAGE_SAFETY. في هذا المقال، سنقوم بتحليل متعمق لآليات حماية القاصرين الخمس في Nano Banana Pro، لمساعدتك على فهم سبب رفض النظام لمعالجة الصور التي يُشتبه في احتوائها على قاصرين.

القيمة الجوهرية: بعد قراءة هذا المقال، ستكتسب فهماً شاملاً لنظام حماية سلامة الأطفال في Nano Banana Pro، وتفهم آليات تفعيل خطأ IMAGE_SAFETY، وتتقن أفضل الممارسات للاستخدام المتوافق لواجهات برمجة تطبيقات (API) تحرير الصور.

النقاط المحورية لآليات حماية القاصرين في Nano Banana Pro

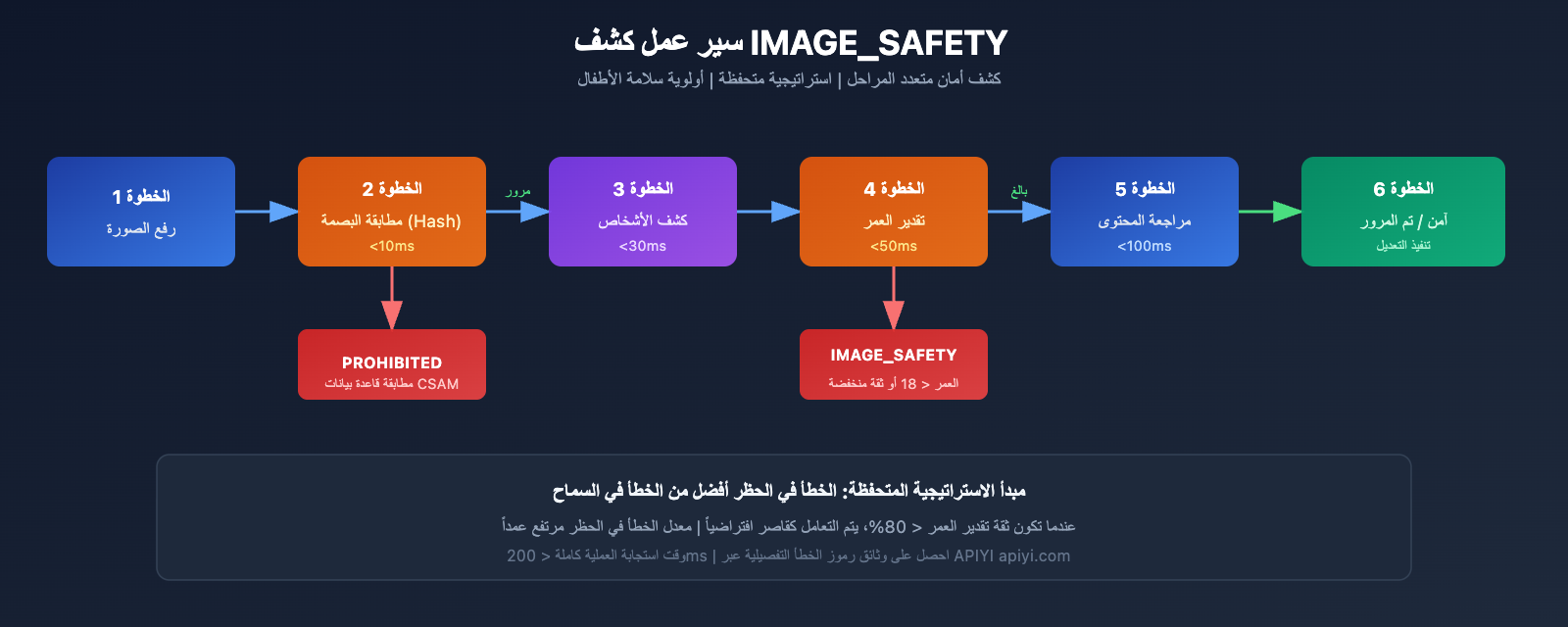

قبل الخوض في التفاصيل التقنية، دعونا نتعرف أولاً على البنية الأساسية لآليات سلامة الأطفال في Nano Banana Pro.

| مستوى الحماية | الوسيلة التقنية | هدف الحماية | وقت التفعيل |

|---|---|---|---|

| الطبقة الأولى | كشف مطابقة الهاش | التعرف على محتوى CSAM المعروف | عند رفع الصورة |

| الطبقة الثانية | مصنف الذكاء الاصطناعي | التعرف على موجهات البحث عن CSAE | عند تحليل الطلب |

| الطبقة الثالثة | تصفية أمان المحتوى | منع التعديلات المتعلقة بالقاصرين | عند تنفيذ المعالجة |

| الطبقة الرابعة | تنقية بيانات التدريب | منع المحتوى الإشكالي من المصدر | أثناء تدريب النموذج |

| الطبقة الخامسة | اختبار ما قبل الإصدار | ضمان معايير سلامة الأطفال | عند إصدار النسخة |

المبادئ الأساسية لحماية سلامة الأطفال في Nano Banana Pro

يعتمد Nano Banana Pro مفهوم الأمان بالتصميم (Safety by Design)، وهو معيار صناعي تم تطويره بالتعاون بين Google ومنظمات حماية الأطفال مثل Thorn وAll Tech Is Human.

تشمل مبادئ الحماية الأساسية ما يلي:

- سياسة عدم التسامح مطلقاً: يتم دائماً حظر المحتوى المتعلق بالاعتداء الجنسي على الأطفال أو استغلالهم، ولا يمكن تجاوز ذلك عبر أي تعديل في المعلمات.

- التعرف الاستباقي: يقوم النظام بالكشف النشط عن المحتوى الذي قد يخص القاصرين، بدلاً من مجرد الاستجابة السلبية.

- التحقق المتعدد: تعمل آليات الأمان متعددة المستويات بشكل تآزري لضمان عدم وجود ثغرات.

- التحديث المستمر: يتم تطوير نماذج الأمان باستمرار لمواجهة التهديدات الجديدة.

🎯 نصيحة تقنية: في عملية التطوير الفعلية، يساعد فهم آليات الحماية هذه في تصميم سير عمل أكثر توافقاً. نوصي بإجراء اختبارات استدعاء واجهة برمجة التطبيقات عبر منصة APIYI (apiyi.com)، حيث توفر المنصة وثائق مفصلة لأكواد الخطأ ودعماً فنياً متخصصاً.

تحليل عميق لخطأ IMAGE_SAFETY

عندما يكتشف Nano Banana Pro أن الصورة تحتوي على شخص يُشتبه في أنه قاصر، فإنه يُرجع خطأ IMAGE_SAFETY. دعونا نحلل هذه الآلية بعمق.

تفاصيل شروط تفعيل خطأ IMAGE_SAFETY

| نوع الخطأ | شرط التفعيل | رمز الخطأ | هل يمكن تجنبه؟ |

|---|---|---|---|

| PROHIBITED_CONTENT | تم اكتشاف بصمة (Hash) معروفة لمواد الاعتداء الجنسي على الأطفال (CSAM) | 400 | لا |

| IMAGE_SAFETY | الصورة تحتوي على شخص يُشتبه في أنه قاصر | 400 | لا |

| SAFETY_BLOCK | الموجه (Prompt) يتضمن محتوى متعلقاً بالقاصرين | 400 | لا |

| CONTENT_FILTER | تفعيل مجموعة من قواعد الأمان المتعددة | 400 | لا |

المبادئ التقنية لخطأ IMAGE_SAFETY

يعتمد نظام كشف IMAGE_SAFETY في Nano Banana Pro على تقنية التحليل متعدد الوسائط (Multimodal Analysis):

1. تحليل ملامح الوجه

يقوم النظام بتحليل ملامح وجه الأشخاص في الصورة لتقييم ما إذا كان من المحتمل أن يكونوا قاصرين:

# تمثيل برمجي زائف: سير عمل كشف IMAGE_SAFETY

def check_image_safety(image_data):

"""

توضيح منطق كشف IMAGE_SAFETY في Nano Banana Pro

ملاحظة: هذا توضيح مبسط للعملية، التنفيذ الفعلي أكثر تعقيداً

"""

# الخطوة الأولى: كشف مطابقة البصمة (Hash)

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# الخطوة الثانية: كشف الأشخاص

persons = detect_persons(image_data)

# الخطوة الثالثة: تقدير العمر

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# استراتيجية متحفظة: الخطأ في الحظر أفضل من الخطأ في السماح

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. مبدأ الاستراتيجية المتحفظة

لضمان سلامة الأطفال، يتبع النظام استراتيجية متحفظة:

- عندما تكون درجة الثقة في تقدير العمر غير كافية، يتم التعامل مع الشخص كقاصر بشكل افتراضي.

- يتم حظر أي مشهد قد يتعلق بالقاصرين.

- معدل الخطأ في الحظر (False Positives) مقبول ليكون مرتفعاً، فحماية الأطفال هي الأولوية القصوى.

سيناريوهات خطأ IMAGE_SAFETY الشائعة

بناءً على تعليقات مجتمع المطورين، فإن السيناريوهات التالية هي الأكثر عرضة لتفعيل خطأ IMAGE_SAFETY:

| السيناريو | سبب التفعيل | اقتراح الحل |

|---|---|---|

| تحرير الصور العائلية | الصورة تحتوي على أطفال | قم بإزالة الأطفال قبل التحرير |

| معالجة مشاهد مدرسية | قد تحتوي على طلاب | استخدم خلفيات خالية من الأشخاص |

| تجميل الوجوه الشابة | تقدير العمر متحفظ | تأكد من أن الشخص المصور بالغ |

| نمط الكرتون/الأنمي | الذكاء الاصطناعي يخطئ ويعتبرهم أطفالاً حقيقيين | استخدم أنماطاً غير واقعية بشكل واضح |

| ترميم الصور التاريخية | توجد قاصرون في الصورة | اختر الأجزاء التي تحتوي على بالغين فقط |

💡 نصيحة: عند تصميم ميزات تحرير الصور، يُنصح بإبلاغ المستخدمين بهذه القيود مسبقاً. يمكنك الحصول على القائمة الكاملة لرموز الخطأ واقتراحات المعالجة عبر منصة APIYI apiyi.com.

تحليل كامل لتقنيات حماية CSAM

تُعد حماية CSAM (مواد الاعتداء الجنسي على الأطفال) جزءاً محورياً في منظومة الأمان الخاصة بـ Nano Banana Pro.

بنية تقنيات حماية CSAM

يعتمد Nano Banana Pro تقنيات حماية CSAM رائدة في الصناعة:

1. تقنية مطابقة الهاش (Hash Matching)

# مثال: منطق كشف مطابقة الهاش

import hashlib

def compute_perceptual_hash(image):

"""

حساب الهاش الإدراكي للصورة

يُستخدم للمطابقة مع قواعد بيانات CSAM المعروفة

"""

# ضبط حجم الصورة وألوانها

normalized = normalize_image(image)

# حساب الهاش الإدراكي

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

التحقق من المطابقة مع CSAM المعروف

"""

# مطابقة غامضة، تسمح ببعض الاختلافات

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. تقنية مصنف الذكاء الاصطناعي (AI Classifier)

تم تدريب مصنفات الذكاء الاصطناعي خصيصاً للتعرف على:

- طلبات CSAE (الاعتداء الجنسي على الأطفال أو استغلالهم).

- محاولات التحايل على كشف الأمان عبر طلبات متغيرة.

- أنماط دمج النصوص والصور المشبوهة.

3. تنسيق الحماية متعددة الطبقات

| طبقة الكشف | التنفيذ التقني | هدف الكشف | وقت الاستجابة |

|---|---|---|---|

| طبقة الإدخال | مطابقة الهاش | المحتوى المخالف المعروف | < 10ms |

| طبقة الفهم | مصنف الذكاء الاصطناعي | التعرف على النوايا | < 50ms |

| طبقة التنفيذ | فلتر المحتوى | مراجعة المخرجات | < 100ms |

| طبقة المراقبة | تحليل السلوك | الأنماط غير الطبيعية | في الوقت الفعلي |

التعاون الصناعي والمعايير

تتعاون منظومة حماية CSAM في Nano Banana Pro مع العديد من المنظمات الصناعية:

- Thorn: منظمة تقنية لمكافحة استغلال الأطفال.

- All Tech Is Human: منظمة مبادرات أخلاقيات التكنولوجيا.

- NCMEC: المركز الوطني للأطفال المفقودين والمُستغلين (الولايات المتحدة).

- Tech Coalition: تحالف شركات التكنولوجيا لمكافحة CSAM.

🔒 ملاحظة أمنية: تشير تقارير NCMEC إلى أنه تم تأكيد أكثر من 7,000 حالة CSAM متعلقة بالذكاء الاصطناعي التوليدي (GAI) خلال عامين. وتُعد الحماية الصارمة في Nano Banana Pro إجراءً ضرورياً لمواجهة هذا الوضع الخطير.

القائمة الكاملة لقيود تحرير الصور في Nano Banana Pro

بالإضافة إلى حماية القاصرين، هناك قيود أخرى على تحرير الصور في Nano Banana Pro.

تصنيف قيود تحرير الصور

| فئة القيد | مستوى الصرامة | هل هو قابل للتعديل؟ | حالات الاستخدام |

|---|---|---|---|

| سلامة الأطفال | الأقصى | لا | جميع الحالات |

| حماية CSAM | الأقصى | لا | جميع الحالات |

| محتوى عنيف | عالٍ | نعم (جزئياً) | طبي، تعليمي |

| محتوى إباحي | عالٍ | نعم (جزئياً) | منصات البالغين |

| معلومات خطيرة | متوسط | نعم (جزئياً) | أغراض البحث |

| خطاب الكراهية | عالٍ | لا | جميع الحالات |

الحماية الجوهرية غير القابلة للتعديل

ينص Nano Banana Pro بوضوح على أن فئات الضرر التالية يتم حظرها دائماً، ولا يمكن تعديلها عبر أي معلمات API أو إعدادات:

-

المحتوى المتعلق بـ CSAM

- يُحظر توليد أي محتوى يتعلق بالاعتداء الجنسي على الأطفال.

- يُحظر استخدام الذكاء الاصطناعي لتوليد محتوى غير لائق يتضمن قاصرين.

- سيتم وسم مدخلات CSAM كـ

PROHIBITED_CONTENT(محتوى محظور).

-

استخدام الصور دون موافقة

- يُحظر استخدام صور الآخرين دون تصريح.

- يُحظر إجراء "تزييف عميق" (Deepfake) لوجوه الآخرين.

- يتطلب الأمر تفويضاً صريحاً عند التعامل مع شخصيات حقيقية.

-

محتوى استغلال الأطفال

- يُحظر توليد أي شكل من أشكال محتوى استغلال الأطفال.

- يشمل ذلك، على سبيل المثال لا الحصر، الاستغلال الجنسي، استغلال العمالة، إلخ.

- يغطي صور القاصرين الحقيقيين والخياليين.

شرح تكوين معلمات الأمان

بينما لا يمكن تعديل الحماية الجوهرية لسلامة الأطفال، يوفر Nano Banana Pro خيارات لتكوين معلمات أمان أخرى:

from openai import OpenAI

# تهيئة العميل

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # استخدام واجهة APIYI الموحدة

)

# مثال على طلب تحرير صورة

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="تغيير لون الخلفية إلى الأزرق",

# معلمات الأمان (ملاحظة: لا يمكن تعديل ما يتعلق بسلامة الأطفال)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# الإعدادات التالية غير فعالة لسلامة الأطفال، فهي دائماً في أعلى مستوى

# "child_safety": غير قابل للتكوين

}

)

عرض كود تكوين الأمان الكامل

"""

مثال كامل لتكوين الأمان في Nano Banana Pro

يوضح معلمات الأمان القابلة وغير القابلة للتكوين

"""

from openai import OpenAI

import base64

# تهيئة العميل

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # استخدام واجهة APIYI الموحدة

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

دالة تحرير صور آمنة

تتضمن معالجة كاملة للأخطاء

"""

try:

# قراءة الصورة

with open(image_path, "rb") as f:

image_data = f.read()

# إرسال طلب التحرير

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# معالجة خطأ IMAGE_SAFETY

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "الصورة تحتوي على قاصرين مشتبه بهم، لا يمكن معالجتها",

"suggestion": "يرجى استخدام صور تحتوي على بالغين فقط"

}

# معالجة خطأ PROHIBITED_CONTENT

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "تم اكتشاف محتوى محظور",

"suggestion": "يرجى التحقق من امتثال محتوى الصورة"

}

# أخطاء أخرى

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# مثال على الاستخدام

result = safe_image_edit("photo.jpg", "حول الخلفية إلى شاطئ")

if result["success"]:

print(f"تم التحرير بنجاح: {result['url']}")

else:

print(f"فشل التحرير: {result['message']}")

print(f"اقتراح: {result.get('suggestion', 'يرجى المحاولة مرة أخرى')}")

🚀 ابدأ بسرعة: نوصي باستخدام منصة APIYI (apiyi.com) لتجربة Nano Banana Pro بسرعة. توفر المنصة واجهات API جاهزة للاستخدام دون الحاجة لتكوينات معقدة، مع وثائق شاملة لمعالجة الأخطاء.

أفضل الممارسات للاستخدام المتوافق مع Nano Banana Pro

بعد أن تعرفنا على آليات الأمان، دعنا نتعلم كيفية استخدام Nano Banana Pro بشكل متوافق وآمن.

قائمة التحقق قبل التطوير

قبل دمج Nano Banana Pro في تطبيقك، يرجى التأكد من النقاط التالية:

| عنصر التحقق | الضرورة | طريقة التحقق | توصية الامتثال |

|---|---|---|---|

| التحقق من عمر المستخدم | إلزامي | التحقق عند التسجيل | قصر الاستخدام على سن 18+ |

| تأكيد مصدر الصورة | إلزامي | اتفاقية الرفع | مطالبة المستخدم بتأكيد حقوق الملكية |

| تحديد سيناريوهات الاستخدام | موصى به | تصميم الوظائف | إبلاغ المستخدم بوضوح بقيود الاستخدام |

| آلية معالجة الأخطاء | إلزامي | تنفيذ الكود | تقديم تنبيهات ودية للمستخدم |

| عملية مراجعة المحتوى | موصى به | نظام خلفي | آلية مراجعة بشرية |

أفضل الممارسات لتنبيهات المستخدم

لتجنب ارتباك المستخدم، نوصي بإضافة التنبيهات التالية في تطبيقك:

تنبيه عند الرفع:

تنبيه لطيف: لحماية سلامة القاصرين، لن يتم معالجة الصور التي تحتوي على صور أطفال.

يرجى التأكد من أن جميع الأشخاص في الصور المرفوعة هم من البالغين.

تنبيه عند الخطأ:

عذراً، لا يمكن معالجة هذه الصورة.

السبب: اكتشف النظام أن الصورة قد تحتوي على صور لقاصرين.

اقتراح: يرجى استخدام صور تحتوي على بالغين فقط، أو إزالة أجزاء القاصرين من الصورة ثم المحاولة مرة أخرى.

مقترحات لتصميم التطبيق

-

توضيح سيناريوهات الاستخدام

- وضح في وثائق المنتج أن معالجة صور الأطفال غير مدعومة.

- تضمين البنود ذات الصلة في اتفاقية المستخدم.

-

تحسين تجربة المستخدم

- تقديم رسائل خطأ ودية.

- شرح سبب القيود بدلاً من عرض رمز خطأ فقط.

- تقديم اقتراحات بديلة قابلة للتنفيذ.

-

إعداد وثائق الامتثال

- الاحتفاظ بسجلات استدعاء الـ API.

- تسجيل حالات تفعيل فلاتر الأمان.

- إنشاء آلية للإبلاغ عن الحالات الاستثنائية.

💰 تحسين التكلفة: بالنسبة للمشاريع التي تتطلب استدعاءات متكررة لـ API تحرير الصور، يمكنك التفكير في استخدام منصة APIYI (apiyi.com)، حيث توفر المنصة طرق دفع مرنة وأسعاراً أكثر تنافسية، مما يجعلها مناسبة للفرق المتوسطة والصغيرة والمطورين الأفراد.

الأسئلة الشائعة

س1: لماذا تظهر رسالة IMAGE_SAFETY لصور هي بوضوح لأشخاص بالغين؟

تعتمد Nano Banana Pro استراتيجية محافظة في تقدير العمر. عندما لا تكون ثقة النظام في تقدير العمر كافية، فإنه سيعتبر الصورة لقاصر افتراضياً لضمان الأمان.

الأسباب المحتملة تشمل:

- ملامح وجه تبدو أصغر سناً (مثل "وجه الطفل").

- إضاءة الصورة أو زاوية التصوير التي تؤدي لتقدير غير دقيق.

- تأثيرات الفلاتر بأسلوب الكرتون أو الأنمي.

نوصي باستخدام صور تظهر ملامح الوجه بوضوح. ومن خلال منصة APIYI (apiyi.com)، يمكنك الحصول على معلومات تشخيصية أكثر تفصيلاً حول الأخطاء.

س2: هل يمكن حل خطأ IMAGE_SAFETY عن طريق تعديل المعلمات (Parameters)؟

لا يمكن ذلك. الحماية المتعلقة بسلامة الأطفال هي آلية أمان أساسية في Nano Banana Pro، وتندرج تحت فئات الحماية غير القابلة للتعديل.

هذا معيار صناعي تم وضعه بالتعاون بين Google ومنظمات حماية الطفل، ولا يمكن لأي معلمة أو تكوين في الـ API تجاوز هذا القيد. هذا ليس خطأً برمجياً (Bug)، بل هو تصميم أمني متعمد.

إذا كنت بحاجة لمعالجة كميات كبيرة من الصور، نوصي بإجراء فحص مسبق واستخدام رصيد الاختبار في منصة APIYI (apiyi.com) للتحقق من توافق الصور.

س3: كيف يمكنني معرفة ما إذا كانت الصورة ستفعل قيود الأمان؟

نوصي بإجراء فحص مسبق قبل المعالجة الرسمية:

- التأكد من عدم وجود صور واضحة لقاصرين في الصورة.

- تجنب استخدام مشاهد شائعة للأطفال مثل المدارس أو الملاعب.

- اختبار نسخة منخفضة الدقة للمعاينة أولاً.

- إنشاء عملية مراجعة داخلية لتصفية الصور الحساسة.

س4: هل يمكن أن تعطي تقنية فحص CSAM نتائج خاطئة للمحتوى العادي؟

تعتمد تقنية مطابقة الهاش (Hash Matching) على قواعد بيانات CSAM معروفة، ونسبة الخطأ فيها منخفضة جداً. ومع ذلك، قد يحدث خطأ في تقدير العمر بواسطة الذكاء الاصطناعي.

إذا كنت متأكداً من أن محتوى الصورة متوافق ومع ذلك تم رفضه، فقد يكون ذلك بسبب الاستراتيجية المحافظة في تقدير العمر. تصميم النظام يفضل رفض محتوى عادي بالخطأ على السماح بمرور أي حالة قد تتعلق بالقاصرين.

س5: هل تنطبق القيود على شخصيات الأنمي أو الشخصيات الافتراضية؟

نعم، آليات الحماية في Nano Banana Pro تنطبق أيضاً على الأنمي، الرسوم التوضيحية، والشخصيات الافتراضية.

إذا ظهرت الشخصية الافتراضية بمظهر قاصر، فستؤدي أيضاً إلى تفعيل قيود IMAGE_SAFETY. نوصي باستخدام شخصيات افتراضية تبدو بالغة بوضوح، أو تجنب عمليات التحرير التي تتضمن شخصيات.

الخلاصة والتوصيات

تعكس آليات حماية القاصرين الخمس الرئيسية في Nano Banana Pro الاهتمام البالغ الذي يوليه قطاع الذكاء الاصطناعي لسلامة الأطفال:

| النقطة الجوهرية | الوصف |

|---|---|

| المبدأ الأساسي | الأمان بالتصميم (Safety by Design)، سلامة الأطفال فوق كل اعتبار |

| البنية التقنية | كشف التجزئة (Hash Detection) + مصنفات الذكاء الاصطناعي + حماية متعددة الطبقات لتصفية المحتوى |

| غير قابلة للتجاوز | لا يمكن تعديل قيود سلامة الأطفال عبر أي معلمات (Parameters) |

| معايير القطاع | تم تطويرها بالتعاون مع منظمات مثل Thorn وNCMEC |

| توصيات الامتثال | إبلاغ المستخدمين بالقيود بوضوح، وتقديم رسائل خطأ ودودة |

مقترحات للعمل

- المطورون: تخصيص منطق برمجي للتعامل مع قيود الأمان في تصميم التطبيق.

- مديرو المنتجات: إدراج قيود سلامة الأطفال ضمن تخطيط ميزات المنتج.

- مسؤولو العمليات: إعداد نصوص ردود معيارية لاستفسارات المستخدمين.

نوصي باختبار وظائف Nano Banana Pro المختلفة بسرعة عبر APIYI (apiyi.com) لفهم حدود الأمان الفعلية.

المراجع:

-

Google AI Safety Policies: وثائق سياسة الأمان الرسمية

- الرابط:

ai.google.dev/gemini-api/docs/safety-policies

- الرابط:

-

Thorn – Safety by Design: مبادرة تقنية لسلامة الأطفال

- الرابط:

thorn.org/safety-by-design

- الرابط:

-

NCMEC Reports: تقارير المركز الوطني للأطفال المفقودين والمستغلين

- الرابط:

missingkids.org/gethelpnow/csam-reports

- الرابط:

📝 الكاتب: فريق APIYI | 🌐 التواصل التقني: apiyi.com

تم إعداد ونشر هذا المقال بواسطة الفريق التقني لـ APIYI. إذا كانت لديك أي استفسارات، فنحن نرحب بزيارتك لـ APIYI (apiyi.com) للحصول على الدعم التقني.