「可以代充 Claude 开发者平台吗?」这是很多国内开发者经常问的问题。答案是:不建议代充,有更好的替代方案。本文将详细分析 Claude 官方平台的限制,并介绍 3 种更优的 Claude API 使用方案。

核心价值: 读完本文,你将了解 Claude API 代充的风险,掌握更安全、更稳定的 API 调用方案,并学会使用 Prompt Caching 缓存功能降低成本。

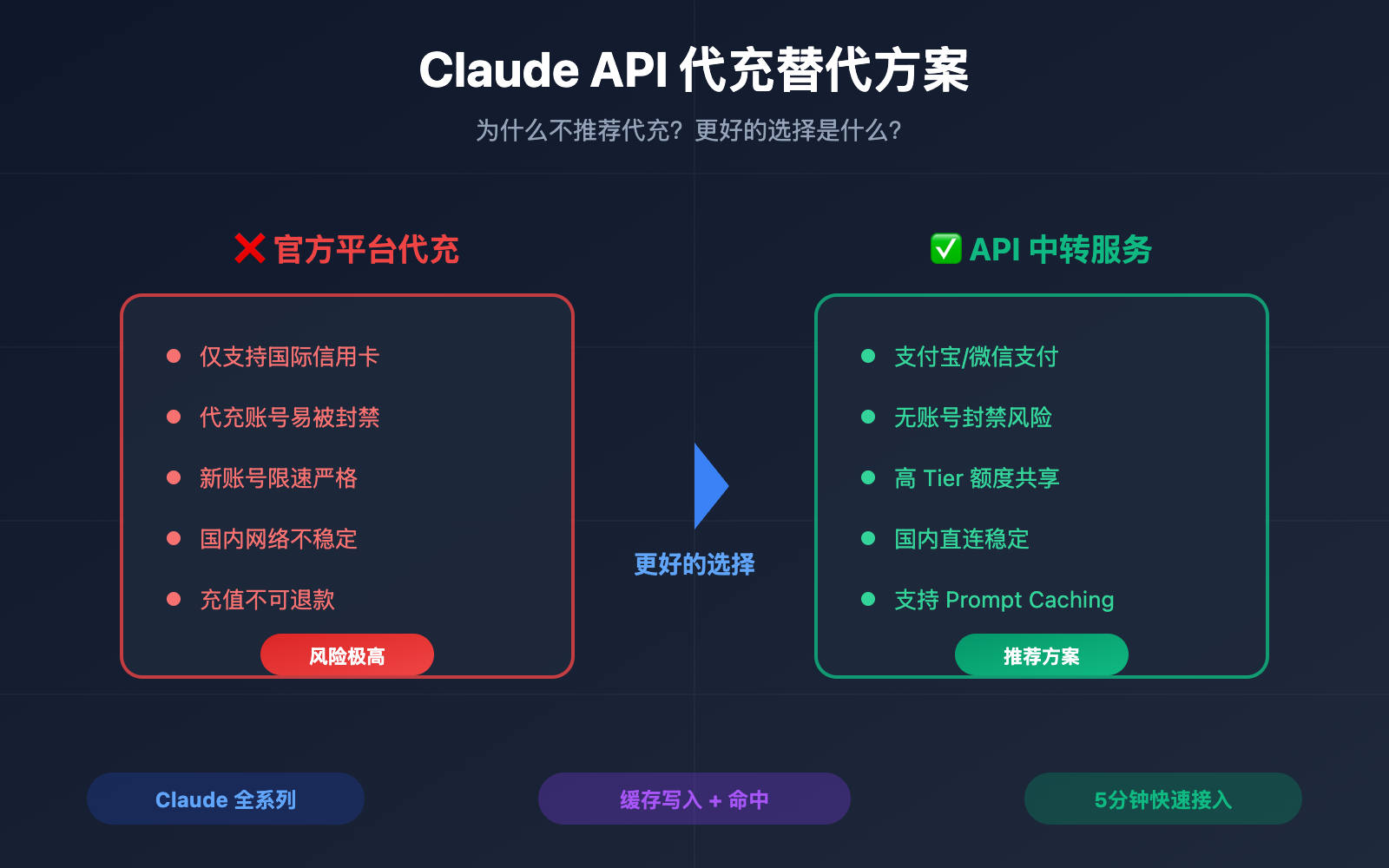

Claude API 代充为什么不推荐

很多开发者想通过代充方式使用 Claude 官方开发者平台 (console.anthropic.com),但这种方式存在多重风险和限制。

| 问题类型 | 具体表现 | 影响程度 |

|---|---|---|

| 支付限制 | 仅支持国际信用卡 (Visa/Mastercard) | 高 |

| 账号风险 | 代充账号可能被封禁 | 极高 |

| 限速严重 | 新账号 Tier 1 限制极低 | 高 |

| 网络问题 | 国内直连不稳定 | 中 |

| 费用问题 | 代充溢价 + 外汇手续费 | 中 |

Claude 官方平台支付方式限制

根据 Anthropic 官方说明,Claude API 使用预付费额度 (Credits) 模式:

- 支持的支付方式: Visa、Mastercard、American Express、Discover

- 交易货币: 仅支持美元 (USD)

- 额度有效期: 购买后 1 年内有效,不可延期

- 退款政策: 所有充值均不可退款

🚨 风险提示: 代充本质上是使用他人账号或支付渠道,Anthropic 明确禁止账号共享和转售行为。一旦被检测到异常,账号会被直接封禁,充值的额度将全部损失。

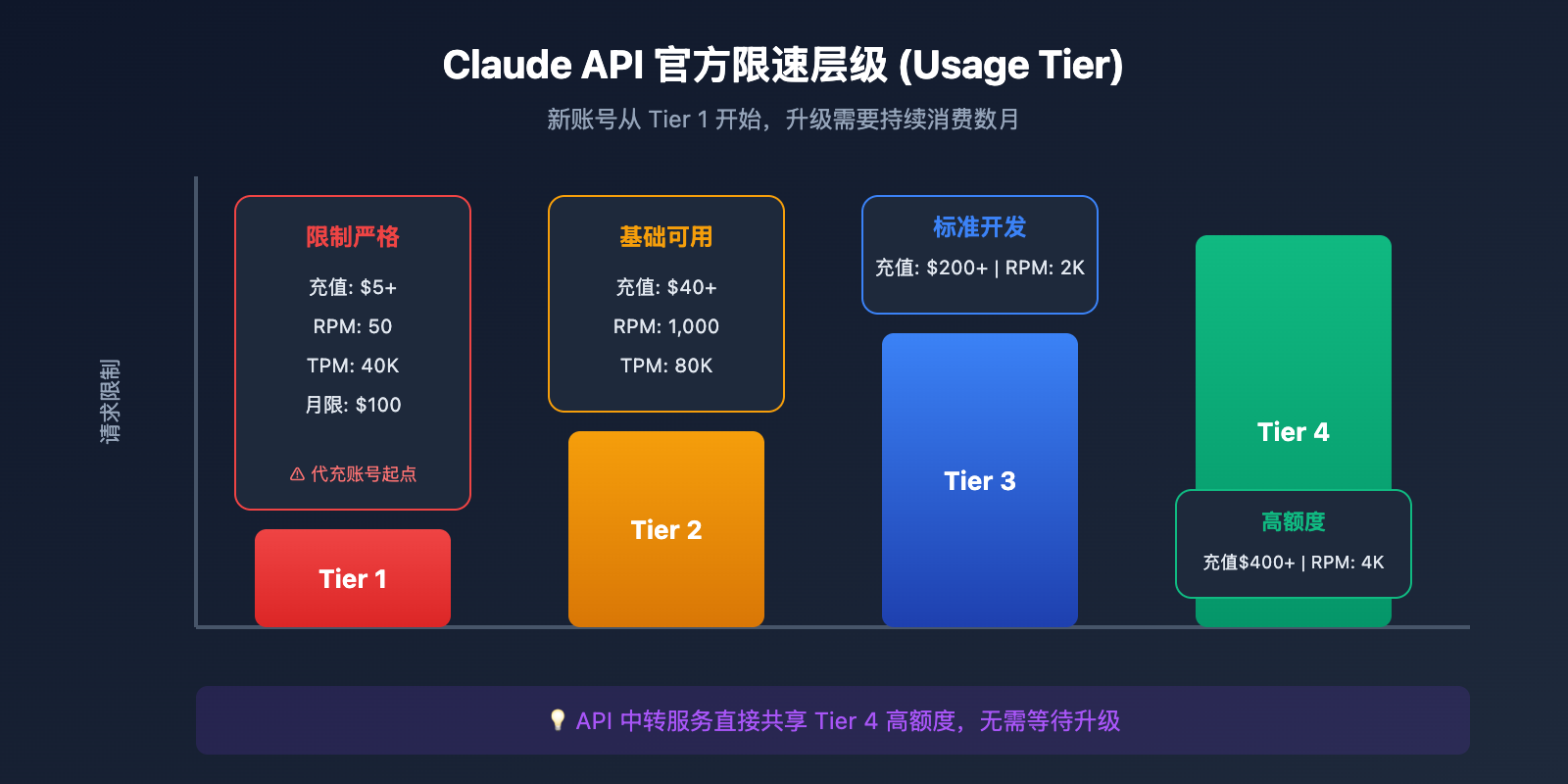

Claude API 官方限速机制

Claude API 采用分层限速机制 (Usage Tier),新账号从 Tier 1 开始:

| 层级 | 充值要求 | RPM 限制 | TPM 限制 | 月消费上限 |

|---|---|---|---|---|

| Tier 1 | $5+ | 50 | 40K | $100 |

| Tier 2 | $40+ | 1,000 | 80K | $500 |

| Tier 3 | $200+ | 2,000 | 160K | $1,000 |

| Tier 4 | $400+ | 4,000 | 400K | $5,000 |

问题: 即使代充成功,新账号也会面临严格的限速,无法满足正常开发需求。升级到高层级需要持续消费数月,时间成本极高。

3 种 Claude API 替代方案对比

针对国内开发者的实际需求,我们推荐以下 3 种替代方案:

| 方案 | 优势 | 劣势 | 推荐场景 |

|---|---|---|---|

| API 中转服务 | 无需信用卡、高额度、支持缓存 | 需选择可靠服务商 | 个人开发者、中小团队 |

| AWS Bedrock | 企业级稳定、合规 | 配置复杂、成本较高 | 大型企业 |

| Google Vertex AI | GCP 生态集成 | 需 GCP 账号 | 已使用 GCP 的团队 |

方案一:API 中转服务(推荐)

API 中转服务是目前最适合国内开发者的方案,通过合规的中转节点调用 Claude API,无需处理支付和网络问题。

核心优势:

- 支付便捷: 支持支付宝、微信等国内支付方式

- 无限速困扰: 中转服务商已完成 Tier 升级,共享高额度

- 网络稳定: 优化的国内访问线路

- 功能完整: 支持 Prompt Caching、Extended Thinking 等全部功能

🎯 技术建议: 我们建议通过 API易 apiyi.com 平台调用 Claude API。该平台提供 OpenAI 兼容格式接口,支持 Claude 全系列模型,包括最新的 Prompt Caching 缓存功能。

快速接入示例:

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # API易 统一接口

)

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(response.choices[0].message.content)

方案二:AWS Bedrock

Amazon Bedrock 是 AWS 提供的托管 AI 服务,支持 Claude 全系列模型。

适用场景:

- 已有 AWS 基础设施的企业

- 对合规性有严格要求的项目

- 需要与 AWS 其他服务深度集成

注意事项:

- 需要 AWS 账号和配置

- 定价与 Anthropic 官方相同

- 部分新功能上线会有延迟

方案三:Google Vertex AI

Google Cloud 的 Vertex AI 也提供 Claude 模型访问。

适用场景:

- 已使用 GCP 生态的团队

- 需要与 Google Cloud 服务集成

Claude API Prompt Caching 缓存功能详解

Prompt Caching 是 Claude API 的重要功能,可以显著降低成本和延迟。选择替代方案时,确保支持此功能非常重要。

Prompt Caching 核心原理

| 概念 | 说明 |

|---|---|

| 缓存写入 | 首次请求时,将 Prompt 内容写入缓存 |

| 缓存命中 | 后续请求复用缓存,大幅降低成本 |

| 缓存时长 | 5 分钟(默认)或 1 小时(扩展) |

| 最小 Token | 至少 1,024 tokens 才能启用缓存 |

Prompt Caching 价格对比

| 操作类型 | 价格倍率 | 说明 |

|---|---|---|

| 普通输入 | 1x | 基础价格 |

| 缓存写入 (5分钟) | 1.25x | 首次写入略贵 |

| 缓存写入 (1小时) | 2x | 延长缓存时间 |

| 缓存读取 | 0.1x | 节省 90% 成本 |

性能提升: Anthropic 官方数据显示,启用 Prompt Caching 后:

- 延迟降低最高 85%(100K token 场景:11.5s → 2.4s)

- 成本降低最高 90%

使用 Prompt Caching 的代码示例

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1" # API易 支持缓存功能

)

# 系统提示词(会被缓存)

system_prompt = """

你是一个专业的技术文档助手。以下是产品文档内容:

[此处放置大量文档内容,建议 1024+ tokens]

...

"""

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{

"role": "system",

"content": system_prompt,

# 标记缓存断点

"cache_control": {"type": "ephemeral"}

},

{"role": "user", "content": "请总结文档的核心功能"}

]

)

# 检查缓存状态

usage = response.usage

print(f"缓存写入: {usage.cache_creation_input_tokens} tokens")

print(f"缓存命中: {usage.cache_read_input_tokens} tokens")

查看完整缓存配置示例

import openai

from typing import List, Dict

class ClaudeCacheClient:

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

self.system_cache = None

def set_system_prompt(self, content: str):

"""设置带缓存的系统提示词"""

self.system_cache = {

"role": "system",

"content": content,

"cache_control": {"type": "ephemeral"}

}

def chat(self, user_message: str) -> str:

"""发送消息,自动复用缓存"""

messages = []

if self.system_cache:

messages.append(self.system_cache)

messages.append({"role": "user", "content": user_message})

response = self.client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=messages

)

# 打印缓存统计

usage = response.usage

if hasattr(usage, 'cache_read_input_tokens'):

hit_rate = usage.cache_read_input_tokens / (

usage.cache_read_input_tokens +

usage.cache_creation_input_tokens + 1

) * 100

print(f"缓存命中率: {hit_rate:.1f}%")

return response.choices[0].message.content

# 使用示例

client = ClaudeCacheClient("sk-your-apiyi-key")

client.set_system_prompt("你是技术文档助手..." * 100) # 长文本

# 多次调用会复用缓存

print(client.chat("问题1"))

print(client.chat("问题2")) # 缓存命中,成本降低 90%

💡 选择建议: API易 apiyi.com 平台完整支持 Claude Prompt Caching 功能,包括缓存写入和缓存命中。无需额外配置,使用标准接口即可享受缓存带来的成本和性能优化。

Claude API 中转方案快速上手

步骤 1:获取 API Key

- 访问 API易 apiyi.com 注册账号

- 进入控制台创建 API Key

- 充值余额(支持支付宝、微信)

步骤 2:配置开发环境

Python 环境:

pip install openai

环境变量配置:

export OPENAI_API_KEY="sk-your-apiyi-key"

export OPENAI_BASE_URL="https://api.apiyi.com/v1"

步骤 3:测试 API 连接

import openai

client = openai.OpenAI(

api_key="sk-your-apiyi-key",

base_url="https://api.apiyi.com/v1"

)

# 测试 Claude Sonnet 4

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[{"role": "user", "content": "你好,请介绍一下你自己"}],

max_tokens=500

)

print(response.choices[0].message.content)

支持的 Claude 模型列表

| 模型名称 | 模型 ID | 特点 | 可用平台 |

|---|---|---|---|

| Claude Opus 4 | claude-opus-4-20250514 | 最强推理能力 | API易 apiyi.com |

| Claude Sonnet 4 | claude-sonnet-4-20250514 | 平衡性能成本 | API易 apiyi.com |

| Claude Haiku 3.5 | claude-3-5-haiku-20241022 | 快速响应 | API易 apiyi.com |

| Claude Sonnet 3.5 | claude-3-5-sonnet-20241022 | 经典稳定版 | API易 apiyi.com |

官方平台 vs 中转方案详细对比

| 对比维度 | Claude 官方平台 | API 中转方案 |

|---|---|---|

| 支付方式 | 国际信用卡 | 支付宝/微信 |

| 网络访问 | 需要代理 | 国内直连 |

| 限速机制 | Tier 分层限制 | 高额度共享 |

| 账号风险 | 代充可能封号 | 无风险 |

| 功能支持 | 完整 | 完整 (含缓存) |

| 技术支持 | 英文工单 | 中文客服 |

| 计费方式 | 预充值 | 按量付费 |

| 上手难度 | 复杂 | 简单 |

常见问题

Q1: Claude API 代充真的不行吗?

确实不建议。代充存在几个核心问题:

- 账号安全: Anthropic 会检测异常登录和支付行为,代充账号被封风险极高

- 限速问题: 即使充值成功,新账号 Tier 1 限制非常严格,难以正常使用

- 资金风险: 账号一旦被封,充值金额无法退回

通过 API易 apiyi.com 等正规中转服务,可以避免这些问题,同时享受更高的额度和更稳定的服务。

Q2: 中转服务支持 Prompt Caching 吗?

支持。API易 apiyi.com 完整支持 Claude 的 Prompt Caching 功能,包括:

- 5 分钟标准缓存

- 1 小时扩展缓存

- 缓存写入和命中统计

- 最高 90% 成本节省

使用方式与官方 API 完全一致,在消息中添加 cache_control 参数即可。

Q3: 中转服务的延迟会比官方高吗?

实际体验中,优质中转服务的延迟与官方基本持平,有时甚至更快。原因是:

- 中转服务商在多地部署了优化节点

- 国内直连避免了代理带来的延迟

- 高级别 Tier 享受更高的处理优先级

建议实际测试对比,选择延迟最低的方案。

Q4: 如何保证数据安全?

选择正规中转服务商时,注意以下几点:

- 查看服务商的隐私政策和数据处理说明

- 确认是否支持 HTTPS 加密传输

- 了解日志保留策略

- 敏感数据可考虑在本地预处理

API易 apiyi.com 承诺不存储用户对话数据,仅保留必要的计费日志。

Q5: 中转价格和官方相比如何?

中转服务通常与官方价格持平或略有优惠,同时省去了:

- 国际信用卡手续费

- 外汇转换损失

- 代理工具成本

综合计算,使用中转服务的实际成本往往更低。

总结

Claude API 代充存在账号风险、限速严格、支付不便等问题,不是国内开发者的理想选择。更推荐的方案是使用正规的 API 中转服务:

- 支付便捷: 支持国内支付方式,无需国际信用卡

- 高额度: 共享高 Tier 额度,无限速困扰

- 功能完整: 支持 Prompt Caching 缓存写入和命中

- 稳定可靠: 国内直连,中文技术支持

推荐通过 API易 apiyi.com 快速接入 Claude API,平台支持全系列 Claude 模型,完整兼容官方功能,5 分钟即可完成集成。

参考资料

-

Anthropic API 计费说明: Claude API 预付费额度使用规则

- 链接:

support.claude.com/en/articles/8977456-how-do-i-pay-for-my-claude-api-usage

- 链接:

-

Claude API 限速文档: 官方 Usage Tier 分层说明

- 链接:

docs.claude.com/en/api/rate-limits

- 链接:

-

Prompt Caching 文档: 缓存功能使用指南

- 链接:

docs.claude.com/en/docs/build-with-claude/prompt-caching

- 链接:

作者: APIYI Team

技术支持: 如需 Claude API 接入帮助,请访问 API易 apiyi.com