在使用 Nano Banana Pro 進行圖像編輯時,遇到 IMAGE_SAFETY 錯誤 是很多開發者困惑的問題。本文將深度解析 Nano Banana Pro 的 5 大未成年人保護機制,幫助你理解爲什麼包含疑似未成年人的圖片會被系統拒絕處理。

核心價值: 讀完本文,你將全面瞭解 Nano Banana Pro 的兒童安全防護體系,理解 IMAGE_SAFETY 錯誤的觸發機制,並掌握合規使用圖像編輯 API 的最佳實踐。

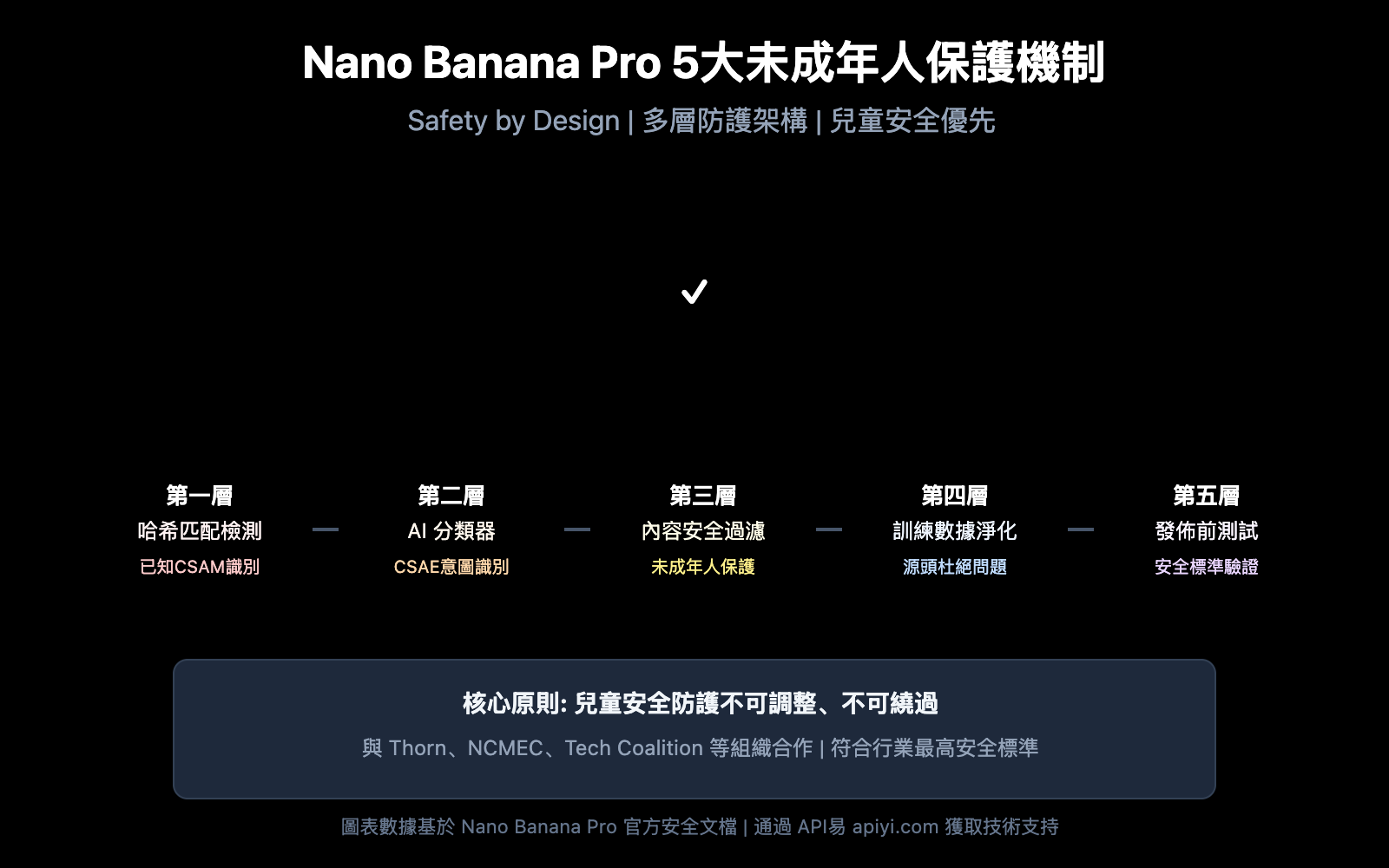

Nano Banana Pro 未成年人保護機制 核心要點

在深入技術細節之前,讓我們先了解 Nano Banana Pro 兒童安全機制的核心架構。

| 保護層級 | 技術手段 | 防護目標 | 觸發時機 |

|---|---|---|---|

| 第一層 | 哈希匹配檢測 | 識別已知 CSAM 內容 | 圖片上傳時 |

| 第二層 | AI 分類器 | 識別 CSAE 尋求提示 | 請求解析時 |

| 第三層 | 內容安全過濾 | 阻止涉及未成年人的編輯 | 處理執行時 |

| 第四層 | 訓練數據淨化 | 從源頭杜絕問題內容 | 模型訓練時 |

| 第五層 | 發佈前測試 | 確保兒童安全標準 | 版本發佈時 |

Nano Banana Pro 兒童安全防護的核心原則

Nano Banana Pro 採用 Safety by Design 設計理念,這是 Google 與 Thorn、All Tech Is Human 等兒童保護組織合作制定的行業標準。

核心防護原則包括:

- 零容忍政策: 與兒童性虐待或剝削相關的內容始終被阻止,無法通過任何參數調整

- 主動識別: 系統主動檢測可能涉及未成年人的內容,而非被動響應

- 多重驗證: 多層級安全機制協同工作,確保無漏洞

- 持續更新: 安全模型持續迭代,應對新型威脅

🎯 技術建議: 在實際開發中,理解這些保護機制有助於設計更合規的應用流程。我們建議通過 API易 apiyi.com 平臺進行 API 調用測試,該平臺提供詳細的錯誤碼文檔和技術支持。

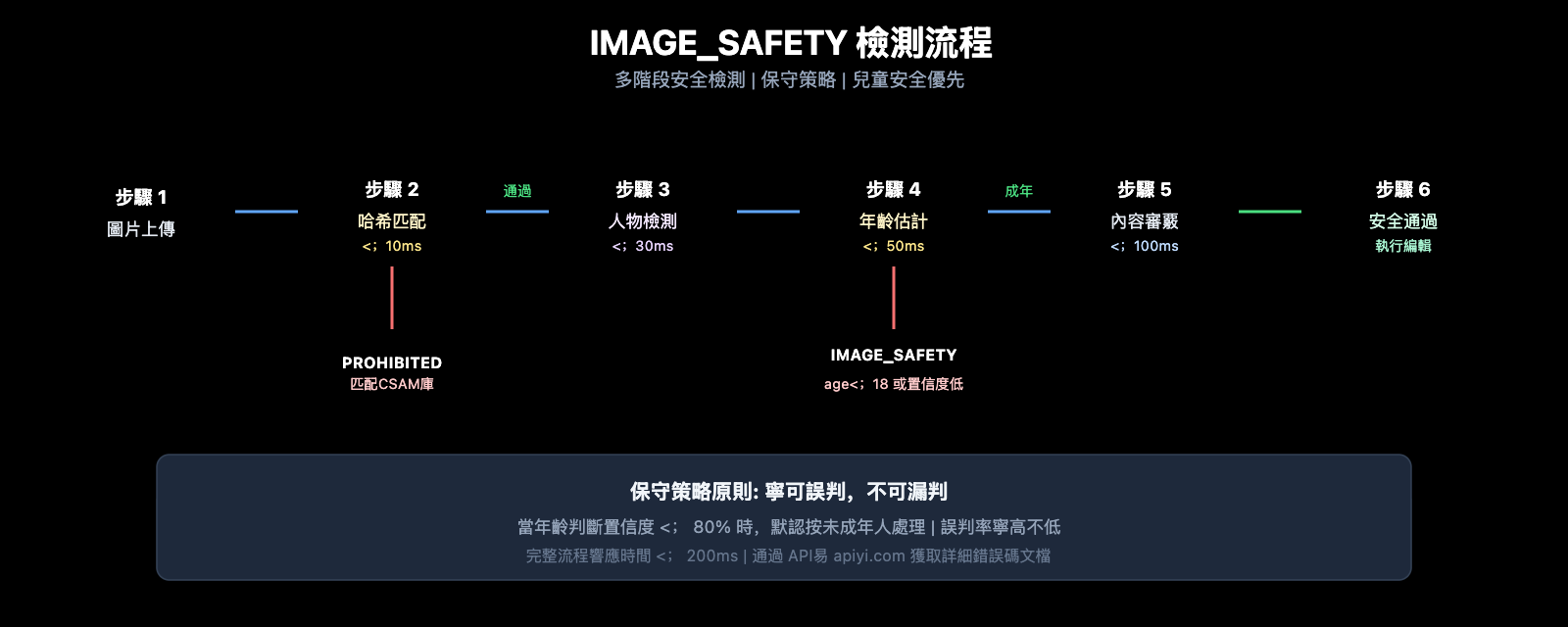

IMAGE_SAFETY 錯誤 深度解析

當 Nano Banana Pro 檢測到圖片中包含疑似未成年人時,會返回 IMAGE_SAFETY 錯誤。讓我們深入分析這一機制。

IMAGE_SAFETY 錯誤觸發條件詳解

| 錯誤類型 | 觸發條件 | 錯誤碼 | 是否可規避 |

|---|---|---|---|

| PROHIBITED_CONTENT | 檢測到已知 CSAM 哈希 | 400 | 否 |

| IMAGE_SAFETY | 圖片包含疑似未成年人 | 400 | 否 |

| SAFETY_BLOCK | 提示詞涉及未成年人相關內容 | 400 | 否 |

| CONTENT_FILTER | 組合觸發多重安全規則 | 400 | 否 |

IMAGE_SAFETY 錯誤的技術原理

Nano Banana Pro 的 IMAGE_SAFETY 檢測系統採用多模態分析技術:

1. 面部特徵分析

系統會分析圖片中人物的面部特徵,評估其是否可能爲未成年人:

# 僞代碼示意: IMAGE_SAFETY 檢測流程

def check_image_safety(image_data):

"""

Nano Banana Pro IMAGE_SAFETY 檢測邏輯示意

注意: 這是簡化的流程說明,實際實現更復雜

"""

# 第一步: 哈希匹配檢測

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# 第二步: 人物檢測

persons = detect_persons(image_data)

# 第三步: 年齡估計

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# 保守策略: 寧可誤判也不漏判

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. 保守策略原則

爲確保兒童安全,系統採用保守策略:

- 當年齡判斷置信度不足時,默認按未成年人處理

- 任何可能涉及未成年人的場景都會被阻止

- 誤判率寧高不低,保護兒童安全是第一優先級

常見 IMAGE_SAFETY 錯誤場景

根據開發者社區反饋,以下場景最容易觸發 IMAGE_SAFETY 錯誤:

| 場景 | 觸發原因 | 解決建議 |

|---|---|---|

| 家庭照片編輯 | 圖中包含兒童 | 移除兒童後再編輯 |

| 校園場景處理 | 可能包含學生 | 使用無人物的背景 |

| 年輕面孔修圖 | 年齡判斷保守 | 確認被拍攝者已成年 |

| 卡通/動漫風格 | AI 誤判爲真實兒童 | 使用明顯非真實的風格 |

| 歷史照片修復 | 照片中有未成年人 | 選擇僅含成年人的部分 |

💡 選擇建議: 在設計圖像編輯功能時,建議提前告知用戶這些限制。通過 API易 apiyi.com 平臺可以獲取完整的錯誤碼列表和處理建議。

CSAM 防護技術 完整解析

CSAM (Child Sexual Abuse Material) 防護是 Nano Banana Pro 安全體系的核心組成部分。

CSAM 防護技術架構

Nano Banana Pro 採用行業領先的 CSAM 防護技術:

1. 哈希匹配技術

# 示例: 哈希匹配檢測邏輯

import hashlib

def compute_perceptual_hash(image):

"""

計算圖片的感知哈希

用於匹配已知 CSAM 數據庫

"""

# 調整圖片大小和顏色

normalized = normalize_image(image)

# 計算感知哈希

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

檢查是否匹配已知 CSAM

"""

# 模糊匹配,允許一定的變體

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. AI 分類器技術

AI 分類器專門訓練用於識別:

- CSAE (Child Sexual Abuse or Exploitation) 尋求提示

- 試圖繞過安全檢測的變體請求

- 可疑的圖文組合模式

3. 多層級防護協同

| 檢測層級 | 技術實現 | 檢測目標 | 響應時間 |

|---|---|---|---|

| 輸入層 | 哈希匹配 | 已知違規內容 | < 10ms |

| 理解層 | AI 分類器 | 意圖識別 | < 50ms |

| 執行層 | 內容過濾器 | 輸出審覈 | < 100ms |

| 監控層 | 行爲分析 | 異常模式 | 實時 |

行業合作與標準

Nano Banana Pro 的 CSAM 防護體系與多個行業組織合作:

- Thorn: 反兒童剝削技術組織

- All Tech Is Human: 科技倫理倡議組織

- NCMEC: 美國失蹤和被剝削兒童中心

- Tech Coalition: 科技公司反 CSAM 聯盟

🔒 安全說明: NCMEC 報告顯示,兩年內已確認超過 7,000 例 GAI (生成式 AI) 相關 CSAM 案例。Nano Banana Pro 的嚴格防護正是應對這一嚴峻形勢的必要措施。

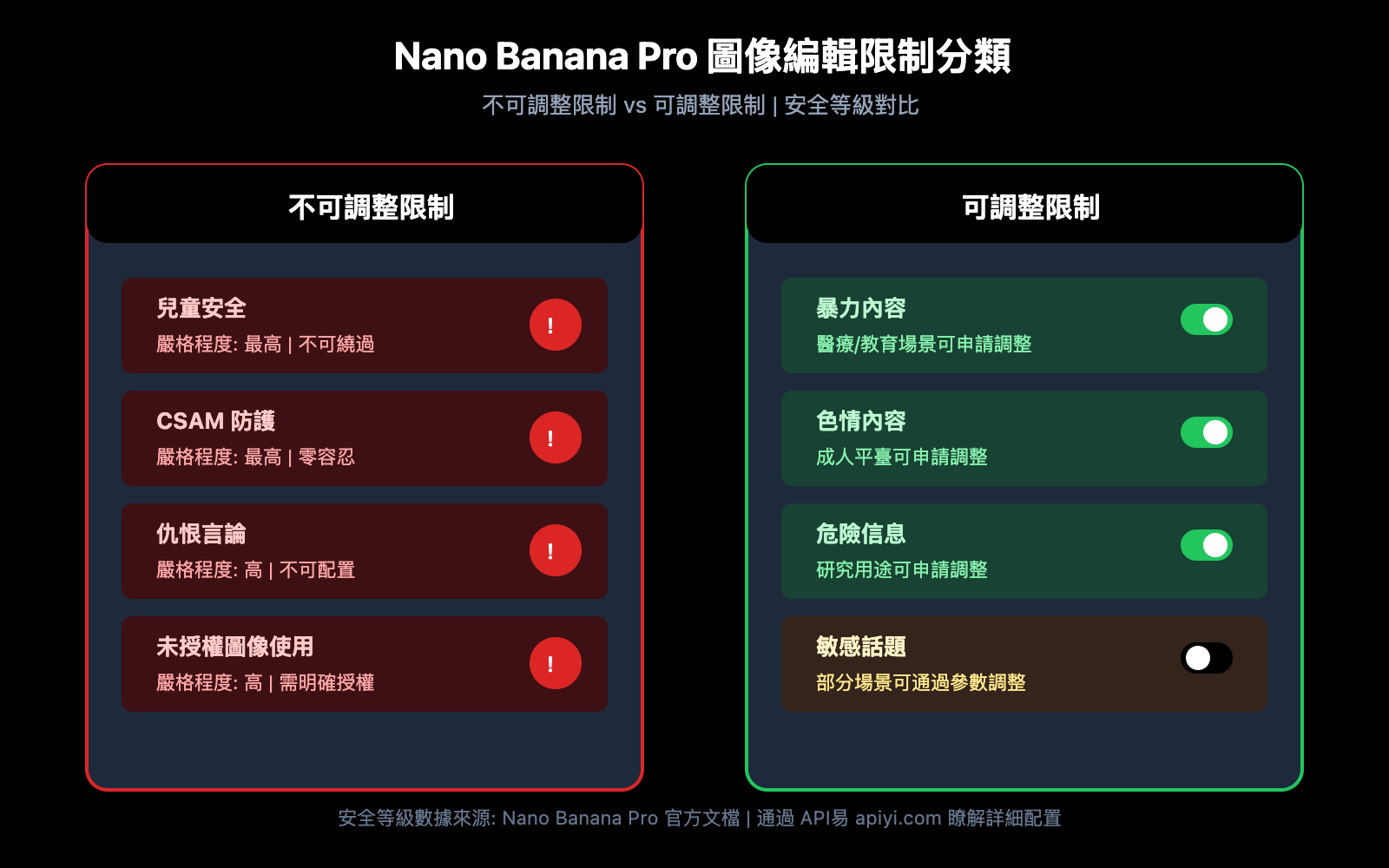

Nano Banana Pro 圖像編輯限制 完整列表

除了未成年人保護,Nano Banana Pro 還有其他圖像編輯限制。

圖像編輯限制分類

| 限制類別 | 嚴格程度 | 是否可調整 | 適用場景 |

|---|---|---|---|

| 兒童安全 | 最高 | 否 | 所有場景 |

| CSAM 防護 | 最高 | 否 | 所有場景 |

| 暴力內容 | 高 | 部分可調 | 醫療、教育 |

| 色情內容 | 高 | 部分可調 | 成人平臺 |

| 危險信息 | 中 | 部分可調 | 研究用途 |

| 仇恨言論 | 高 | 否 | 所有場景 |

不可調整的核心防護

Nano Banana Pro 明確規定,以下傷害類別始終被阻止,無法通過任何 API 參數或設置調整:

-

CSAM 相關內容

- 禁止生成任何與兒童性虐待相關的內容

- 禁止使用 AI 生成涉及未成年人的不當內容

- CSAM 輸入會被標記爲 PROHIBITED_CONTENT

-

未經同意的圖像使用

- 禁止未經授權使用他人圖像

- 禁止深度僞造他人面部

- 涉及真實人物時需有明確授權

-

兒童剝削內容

- 禁止任何形式的兒童剝削內容生成

- 包括但不限於性剝削、勞動剝削等

- 涵蓋真實和虛構的未成年人形象

安全參數配置說明

雖然核心兒童安全防護不可調整,但 Nano Banana Pro 提供其他安全參數的配置選項:

from openai import OpenAI

# 初始化客戶端

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 統一接口

)

# 圖像編輯請求示例

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="修改背景顏色爲藍色",

# 安全參數 (注意: 兒童安全相關不可調整)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# 以下設置對兒童安全無效,始終最高級別

# "child_safety": 不可配置

}

)

查看完整的安全配置代碼

"""

Nano Banana Pro 完整安全配置示例

演示可配置和不可配置的安全參數

"""

from openai import OpenAI

import base64

# 初始化客戶端

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 統一接口

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

安全的圖像編輯函數

包含完整的錯誤處理

"""

try:

# 讀取圖片

with open(image_path, "rb") as f:

image_data = f.read()

# 發送編輯請求

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# 處理 IMAGE_SAFETY 錯誤

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "圖片包含疑似未成年人,無法處理",

"suggestion": "請使用僅包含成年人的圖片"

}

# 處理 PROHIBITED_CONTENT 錯誤

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "檢測到違禁內容",

"suggestion": "請檢查圖片內容是否合規"

}

# 其他錯誤

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# 使用示例

result = safe_image_edit("photo.jpg", "將背景改爲海灘")

if result["success"]:

print(f"編輯成功: {result['url']}")

else:

print(f"編輯失敗: {result['message']}")

print(f"建議: {result.get('suggestion', '請重試')}")

🚀 快速開始: 推薦使用 API易 apiyi.com 平臺快速體驗 Nano Banana Pro。該平臺提供開箱即用的 API 接口,無需複雜配置,並有完善的錯誤處理文檔。

Nano Banana Pro 合規使用 最佳實踐

瞭解了安全機制後,讓我們學習如何合規使用 Nano Banana Pro。

開發前檢查清單

在集成 Nano Banana Pro 到應用之前,請確認以下事項:

| 檢查項 | 必要性 | 檢查方法 | 合規建議 |

|---|---|---|---|

| 用戶年齡驗證 | 必須 | 註冊時驗證 | 18+ 限制 |

| 圖片來源確認 | 必須 | 上傳協議 | 要求用戶確認版權 |

| 使用場景限定 | 建議 | 功能設計 | 明確告知用途限制 |

| 錯誤處理機制 | 必須 | 代碼實現 | 友好提示用戶 |

| 內容審覈流程 | 建議 | 後臺系統 | 人工複覈機制 |

用戶提示最佳實踐

爲避免用戶困惑,建議在應用中添加以下提示:

上傳提示:

溫馨提示: 爲保護未成年人安全,包含兒童形象的圖片將無法進行編輯處理。

請確保上傳的圖片中所有人物均爲成年人。

錯誤提示:

抱歉,該圖片無法處理。

原因: 系統檢測到圖片可能包含未成年人形象。

建議: 請使用僅包含成年人的圖片,或移除圖片中的未成年人部分後重試。

應用設計建議

-

明確使用場景

- 在產品文檔中說明不支持處理兒童照片

- 在用戶協議中包含相關條款

-

優化用戶體驗

- 提供友好的錯誤提示

- 解釋限制原因而非僅顯示錯誤碼

- 給出可行的替代建議

-

合規文檔準備

- 保留 API 調用日誌

- 記錄安全過濾觸發情況

- 建立異常情況上報機制

💰 成本優化: 對於需要頻繁調用圖像編輯 API 的項目,可以考慮通過 API易 apiyi.com 平臺調用,該平臺提供靈活的計費方式和更優惠的價格,適合中小團隊和個人開發者。

常見問題

Q1: 爲什麼明顯是成年人的照片也觸發 IMAGE_SAFETY?

Nano Banana Pro 採用保守策略進行年齡判斷。當系統對年齡判斷置信度不足時,會默認按未成年人處理以確保安全。

可能觸發的原因包括:

- 面部特徵年輕化 (如娃娃臉)

- 照片光線或角度導致判斷不準

- 卡通或動漫風格的濾鏡效果

建議使用清晰展示面部特徵的照片。通過 API易 apiyi.com 平臺可以獲取更詳細的錯誤診斷信息。

Q2: IMAGE_SAFETY 錯誤能通過調整參數解決嗎?

不能。兒童安全相關的防護是 Nano Banana Pro 的核心安全機制,屬於不可調整的保護類別。

這是 Google 與兒童保護組織合作制定的行業標準,任何 API 參數或配置都無法綁過此限制。這不是 bug,而是有意爲之的安全設計。

如需處理大量圖片,建議先進行預篩選,通過 API易 apiyi.com 平臺的測試額度驗證圖片合規性。

Q3: 如何判斷圖片是否會觸發安全限制?

建議在正式處理前進行預檢測:

- 確認圖片中無明顯的未成年人形象

- 避免使用校園、遊樂場等兒童常見場景

- 使用低分辨率預覽版本先測試

- 建立內部審覈流程篩選敏感圖片

Q4: CSAM 檢測會誤報正常內容嗎?

哈希匹配技術針對的是已知 CSAM 數據庫,誤報率極低。但 AI 年齡判斷可能存在誤判。

如果確信圖片內容合規但仍被拒絕,可能是年齡判斷的保守策略導致。系統設計寧可誤拒正常內容,也不放過任何可能涉及未成年人的情況。

Q5: 使用動漫或虛擬角色會受限制嗎?

是的,Nano Banana Pro 的保護機制同樣適用於動漫、插畫和虛擬角色。

如果虛擬角色呈現爲未成年人形象,同樣會觸發 IMAGE_SAFETY 限制。建議使用明顯成年的虛擬角色形象,或避免涉及人物的編輯操作。

總結與建議

Nano Banana Pro 的 5 大未成年人保護機制體現了 AI 行業對兒童安全的高度重視:

| 關鍵點 | 說明 |

|---|---|

| 核心原則 | Safety by Design,兒童安全優先於一切 |

| 技術架構 | 哈希檢測 + AI 分類器 + 內容過濾多層防護 |

| 不可綁過 | 兒童安全限制無法通過任何參數調整 |

| 行業標準 | 與 Thorn、NCMEC 等組織合作制定 |

| 合規建議 | 明確告知用戶限制,提供友好錯誤提示 |

行動建議

- 開發者: 在應用設計中預留安全限制的處理邏輯

- 產品經理: 將兒童安全限制納入產品功能規劃

- 運營人員: 準備用戶諮詢的標準答覆話術

推薦通過 API易 apiyi.com 快速測試 Nano Banana Pro 的各項功能,瞭解實際的安全邊界。

參考資料:

-

Google AI Safety Policies: 官方安全政策文檔

- 鏈接:

ai.google.dev/gemini-api/docs/safety-policies

- 鏈接:

-

Thorn – Safety by Design: 兒童安全技術倡議

- 鏈接:

thorn.org/safety-by-design

- 鏈接:

-

NCMEC Reports: 失蹤和被剝削兒童中心報告

- 鏈接:

missingkids.org/gethelpnow/csam-reports

- 鏈接:

📝 作者: APIYI Team | 🌐 技術交流: apiyi.com

本文由 APIYI 技術團隊整理發佈。如有疑問,歡迎訪問 API易 apiyi.com 獲取技術支持。