Bei der Bildbearbeitung mit Nano Banana Pro ist der IMAGE_SAFETY-Fehler ein Problem, das viele Entwickler vor Rätsel stellt. In diesem Artikel analysieren wir die fünf zentralen Jugendschutzmechanismen von Nano Banana Pro, damit Sie verstehen, warum Bilder, die mutmaßlich Minderjährige enthalten, vom System abgelehnt werden.

Kernvorteil: Nach der Lektüre dieses Artikels werden Sie das Kinderschutzsystem von Nano Banana Pro vollständig verstehen, die Auslösemechanismen des IMAGE_SAFETY-Fehlers nachvollziehen können und Best Practices für die konforme Nutzung der Bildbearbeitungs-API beherrschen.

Kernpunkte der Jugendschutzmechanismen von Nano Banana Pro

Bevor wir in die technischen Details eintauchen, werfen wir einen Blick auf die Kernarchitektur des Kindersicherheitssystems von Nano Banana Pro.

| Schutzebene | Technische Methode | Schutzziel | Auslösezeitpunkt |

|---|---|---|---|

| Ebene 1 | Hash-Matching | Erkennung bekannter CSAM-Inhalte | Beim Bild-Upload |

| Ebene 2 | KI-Klassifikator | Erkennung von CSAE-Eingabeaufforderungen | Bei der Anfrage-Analyse |

| Ebene 3 | Inhaltsfilter | Blockieren von Bearbeitungen mit Minderjährigen | Während der Ausführung |

| Ebene 4 | Datenbereinigung | Problematische Inhalte an der Quelle eliminieren | Während des Modelltrainings |

| Ebene 5 | Pre-Release-Tests | Sicherstellung von Kindersicherheitsstandards | Bei der Versionsveröffentlichung |

Die Kernprinzipien des Kinderschutzes bei Nano Banana Pro

Nano Banana Pro verfolgt den Safety by Design-Ansatz. Dies ist ein Industriestandard, der von Google in Zusammenarbeit mit Kinderschutzorganisationen wie Thorn und All Tech Is Human entwickelt wurde.

Die zentralen Schutzprinzipien umfassen:

- Null-Toleranz-Politik: Inhalte im Zusammenhang mit sexuellem Missbrauch oder der Ausbeutung von Kindern werden ausnahmslos blockiert und können durch keine Parameteranpassung umgangen werden.

- Proaktive Identifizierung: Das System erkennt aktiv Inhalte, die Minderjährige betreffen könnten, anstatt nur passiv zu reagieren.

- Mehrfache Validierung: Mehrstufige Sicherheitsmechanismen arbeiten Hand in Hand, um Sicherheitslücken auszuschließen.

- Kontinuierliche Aktualisierung: Die Sicherheitsmodelle werden ständig weiterentwickelt, um auf neue Bedrohungen zu reagieren.

🎯 Technischer Rat: In der Praxis hilft das Verständnis dieser Mechanismen dabei, konformere Anwendungsabläufe zu gestalten. Wir empfehlen, API-Tests über die Plattform APIYI (apiyi.com) durchzuführen, die detaillierte Dokumentationen zu Fehlercodes und technischen Support bietet.

IMAGE_SAFETY-Fehler: Tiefenanalyse

Wenn Nano Banana Pro erkennt, dass ein Bild mutmaßlich Minderjährige enthält, wird ein IMAGE_SAFETY-Fehler zurückgegeben. Lassen Sie uns diesen Mechanismus im Detail analysieren.

Details zu den Auslösebedingungen des IMAGE_SAFETY-Fehlers

| Fehlertyp | Auslösebedingung | Fehlercode | Umgehbar? |

|---|---|---|---|

| PROHIBITED_CONTENT | Bekannter CSAM-Hash erkannt | 400 | Nein |

| IMAGE_SAFETY | Bild enthält mutmaßlich Minderjährige | 400 | Nein |

| SAFETY_BLOCK | Eingabeaufforderung enthält Inhalte mit Bezug zu Minderjährigen | 400 | Nein |

| CONTENT_FILTER | Kombination löst mehrere Sicherheitsregeln aus | 400 | Nein |

Technische Hintergründe des IMAGE_SAFETY-Fehlers

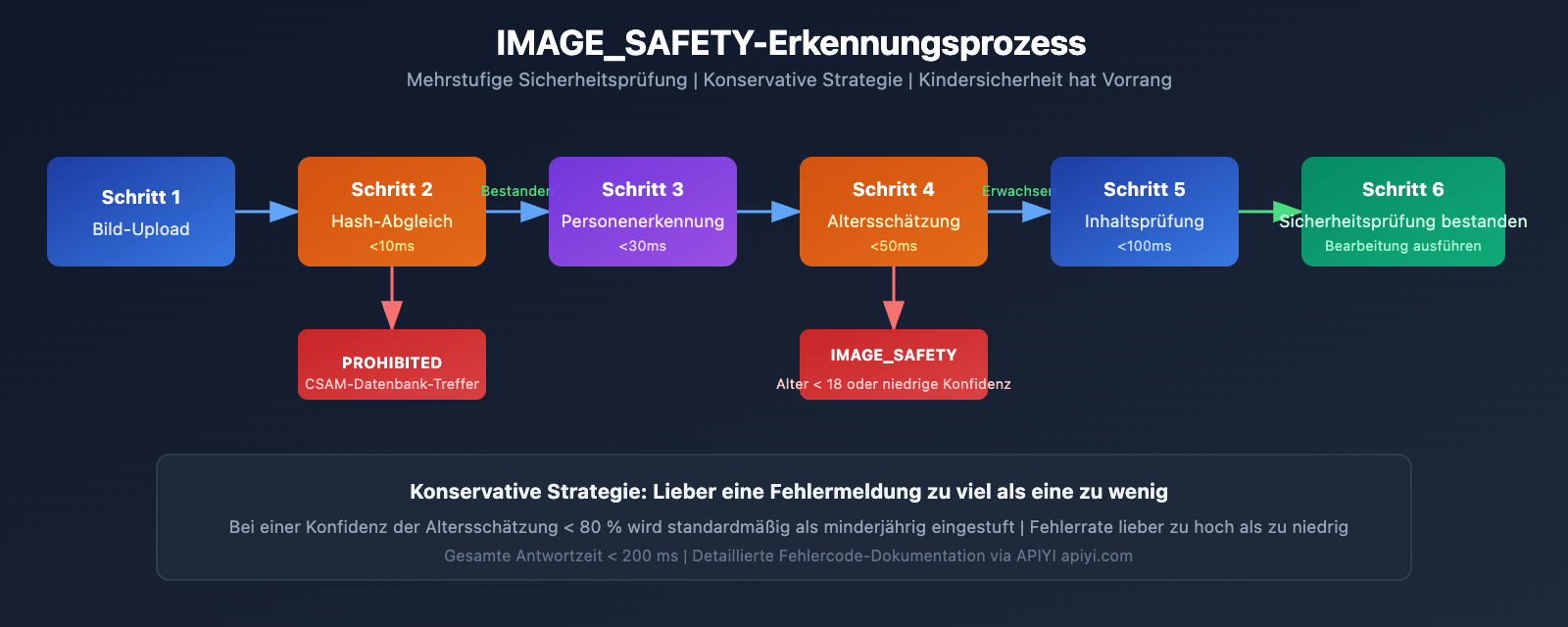

Das IMAGE_SAFETY-Erkennungssystem von Nano Banana Pro nutzt multimodale Analysetechniken:

1. Analyse von Gesichtsmerkmalen

Das System analysiert die Gesichtsmerkmale der Personen im Bild, um zu bewerten, ob es sich um Minderjährige handeln könnte:

# Pseudocode-Beispiel: IMAGE_SAFETY-Erkennungsprozess

def check_image_safety(image_data):

"""

Schematische Darstellung der IMAGE_SAFETY-Erkennungslogik von Nano Banana Pro.

Hinweis: Dies ist eine vereinfachte Darstellung, die tatsächliche Implementierung ist komplexer.

"""

# Schritt 1: Hash-Abgleich

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# Schritt 2: Personenerkennung

persons = detect_persons(image_data)

# Schritt 3: Altersschätzung

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# Konservative Strategie: Lieber eine Fehlermeldung zu viel als eine zu wenig

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. Prinzip der konservativen Strategie

Um die Sicherheit von Kindern zu gewährleisten, verfolgt das System eine konservative Strategie:

- Wenn die Konfidenz der Altersschätzung nicht ausreicht, wird standardmäßig von einem Minderjährigen ausgegangen.

- Jedes Szenario, das Minderjährige betreffen könnte, wird blockiert.

- Die Rate der Fehlalarme (False Positives) wird bewusst höher in Kauf genommen – der Schutz von Kindern hat oberste Priorität.

Häufige IMAGE_SAFETY-Fehlerszenarien

Basierend auf dem Feedback der Entwickler-Community lösen folgende Szenarien am häufigsten den IMAGE_SAFETY-Fehler aus:

| Szenario | Ursache | Lösungsvorschlag |

|---|---|---|

| Bearbeitung von Familienfotos | Bild enthält Kinder | Kinder vor der Bearbeitung entfernen |

| Verarbeitung von Schul-Szenen | Könnte Schüler enthalten | Hintergrund ohne Personen verwenden |

| Retusche junger Gesichter | Konservative Altersschätzung | Sicherstellen, dass die Person volljährig ist |

| Cartoon/Anime-Stil | KI stuft fälschlicherweise als echtes Kind ein | Deutlich unrealistische Stile verwenden |

| Restaurierung historischer Fotos | Minderjährige auf dem Foto | Nur Bereiche mit Erwachsenen auswählen |

💡 Empfehlung: Bei der Gestaltung von Bildbearbeitungsfunktionen wird empfohlen, die Nutzer vorab über diese Einschränkungen zu informieren. Über die Plattform APIYI (apiyi.com) erhalten Sie eine vollständige Liste der Fehlercodes und entsprechende Handlungsempfehlungen.

Vollständige Analyse der CSAM-Schutztechnologie

Der Schutz vor CSAM (Child Sexual Abuse Material) ist eine Kernkomponente des Sicherheitssystems von Nano Banana Pro.

CSAM-Schutzarchitektur

Nano Banana Pro setzt branchenführende CSAM-Schutztechnologien ein:

1. Hash-Matching-Technologie

# Beispiel: Logik zur Erkennung durch Hash-Matching

import hashlib

def compute_perceptual_hash(image):

"""

Berechnet den Wahrnehmungshash (Perceptual Hash) eines Bildes.

Wird zum Abgleich mit bekannten CSAM-Datenbanken verwendet.

"""

# Bildgröße und Farben normalisieren

normalized = normalize_image(image)

# Wahrnehmungshash berechnen

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

Prüft auf Übereinstimmung mit bekanntem CSAM-Material.

"""

# Fuzzy-Matching, um gewisse Varianten zuzulassen

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. KI-Klassifikatoren

KI-Klassifikatoren sind speziell darauf trainiert, Folgendes zu identifizieren:

- CSAE-Anfragen (Child Sexual Abuse or Exploitation)

- Versuche, Sicherheitsprüfungen durch Varianten der Anfrage zu umgehen

- Verdächtige Muster in der Kombination von Bild und Text

3. Mehrstufige Schutzsynergie

| Erkennungsebene | Technische Umsetzung | Erkennungsziel | Reaktionszeit |

|---|---|---|---|

| Eingabeebene | Hash-Matching | Bekannte Verstöße | < 10ms |

| Verstehensebene | KI-Klassifikator | Absichtserkennung | < 50ms |

| Ausführungsebene | Inhaltsfilter | Output-Prüfung | < 100ms |

| Überwachungsebene | Verhaltensanalyse | Anormale Muster | Echtzeit |

Branchenkooperationen und Standards

Das CSAM-Schutzsystem von Nano Banana Pro arbeitet mit mehreren Branchenorganisationen zusammen:

- Thorn: Organisation für Technologien gegen Kinderausbeutung

- All Tech Is Human: Initiative für Ethik in der Technologie

- NCMEC: National Center for Missing & Exploited Children (USA)

- Tech Coalition: Allianz von Technologieunternehmen gegen CSAM

🔒 Sicherheitshinweis: Berichte des NCMEC zeigen, dass innerhalb von zwei Jahren über 7.000 Fälle von CSAM im Zusammenhang mit GAI (Generativer KI) bestätigt wurden. Die strengen Schutzmaßnahmen von Nano Banana Pro sind eine notwendige Reaktion auf diese ernste Lage.

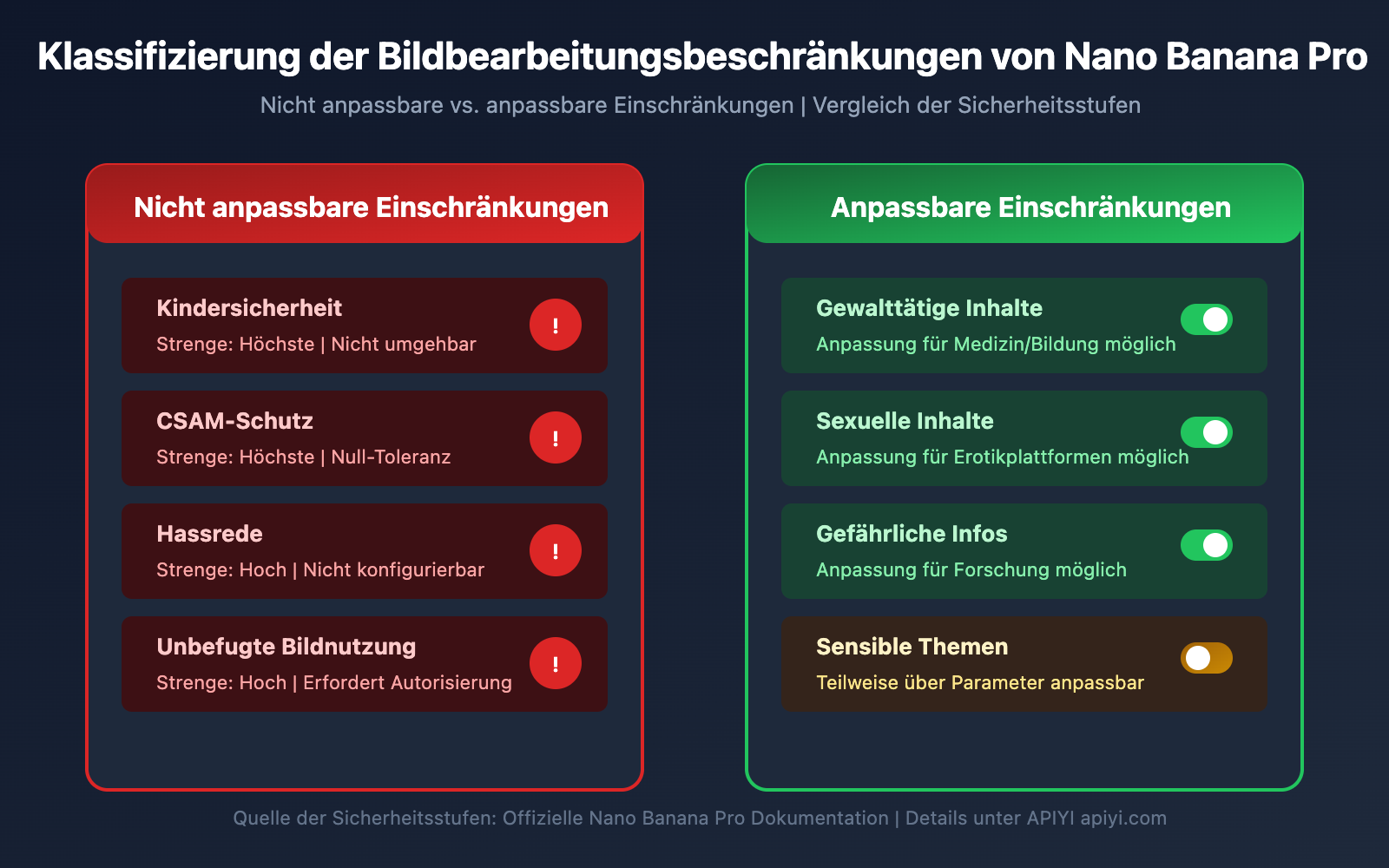

Vollständige Liste der Bildbearbeitungsbeschränkungen von Nano Banana Pro

Neben dem Jugendschutz gibt es bei Nano Banana Pro weitere Einschränkungen für die Bildbearbeitung.

Klassifizierung der Bildbearbeitungsbeschränkungen

| Kategorie der Einschränkung | Strenge | Anpassbar? | Anwendungsbereich |

|---|---|---|---|

| Kindersicherheit | Höchste | Nein | Alle Szenarien |

| CSAM-Schutz | Höchste | Nein | Alle Szenarien |

| Gewalttätige Inhalte | Hoch | Teilweise | Medizin, Bildung |

| Sexuelle Inhalte | Hoch | Teilweise | Erotikplattformen |

| Gefährliche Informationen | Mittel | Teilweise | Forschungszwecke |

| Hassrede | Hoch | Nein | Alle Szenarien |

Nicht anpassbare Kernschutzmaßnahmen

Nano Banana Pro legt ausdrücklich fest, dass die folgenden Schadenskategorien stets blockiert werden und nicht über API-Parameter oder Einstellungen angepasst werden können:

-

CSAM-bezogene Inhalte

- Das Generieren von Inhalten im Zusammenhang mit sexuellem Kindesmissbrauch ist untersagt.

- Die Nutzung von KI zur Erstellung unangemessener Inhalte mit Minderjährigen ist verboten.

- CSAM-Eingaben werden als

PROHIBITED_CONTENTmarkiert.

-

Unbefugte Bildnutzung

- Die unbefugte Verwendung von Bildern anderer Personen ist untersagt.

- Deepfakes von Gesichtern anderer Personen sind verboten.

- Bei realen Personen ist eine ausdrückliche Autorisierung erforderlich.

-

Inhalte zur Ausbeutung von Kindern

- Jede Form von Inhalten zur Ausbeutung von Kindern ist verboten.

- Dies umfasst unter anderem sexuelle Ausbeutung und Arbeitsausbeutung.

- Dies gilt sowohl für reale als auch für fiktive Darstellungen von Minderjährigen.

Konfiguration der Sicherheitsparameter

Obwohl der Kernschutz für die Kindersicherheit nicht anpassbar ist, bietet Nano Banana Pro Konfigurationsoptionen für andere Sicherheitsparameter:

from openai import OpenAI

# Client initialisieren

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Verwendung der einheitlichen APIYI-Schnittstelle

)

# Beispiel für eine Bildbearbeitungsanfrage

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="Hintergrundfarbe in Blau ändern",

# Sicherheitsparameter (Hinweis: Kindersicherheit ist nicht anpassbar)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# Folgende Einstellung ist für Kindersicherheit wirkungslos, da immer auf höchster Stufe

# "child_safety": nicht konfigurierbar

}

)

Vollständigen Sicherheitskonfigurations-Code anzeigen

"""

Nano Banana Pro Beispiel für vollständige Sicherheitskonfiguration

Demonstriert konfigurierbare und nicht konfigurierbare Sicherheitsparameter

"""

from openai import OpenAI

import base64

# Client initialisieren

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Verwendung der einheitlichen APIYI-Schnittstelle

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

Sichere Bildbearbeitungsfunktion

Inklusive vollständiger Fehlerbehandlung

"""

try:

# Bild einlesen

with open(image_path, "rb") as f:

image_data = f.read()

# Bearbeitungsanfrage senden

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# Fehler IMAGE_SAFETY behandeln

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "Bild enthält mutmaßlich Minderjährige, Verarbeitung nicht möglich",

"suggestion": "Bitte verwenden Sie Bilder, die nur Erwachsene zeigen"

}

# Fehler PROHIBITED_CONTENT behandeln

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "Unzulässiger Inhalt erkannt",

"suggestion": "Bitte prüfen Sie, ob der Bildinhalt den Richtlinien entspricht"

}

# Sonstige Fehler

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# Anwendungsbeispiel

result = safe_image_edit("photo.jpg", "Hintergrund in Strand ändern")

if result["success"]:

print(f"Bearbeitung erfolgreich: {result['url']}")

else:

print(f"Bearbeitung fehlgeschlagen: {result['message']}")

print(f"Empfehlung: {result.get('suggestion', 'Bitte versuchen Sie es erneut')}")

🚀 Schnellstart: Wir empfehlen die Plattform APIYI (apiyi.com), um Nano Banana Pro schnell auszuprobieren. Die Plattform bietet sofort einsatzbereite API-Schnittstellen ohne komplexe Konfiguration sowie eine umfassende Dokumentation zur Fehlerbehandlung.

Best Practices für die regelkonforme Nutzung von Nano Banana Pro

Nachdem wir die Sicherheitsmechanismen kennengelernt haben, schauen wir uns nun an, wie Sie Nano Banana Pro regelkonform einsetzen.

Checkliste vor der Entwicklung

Bevor Sie Nano Banana Pro in Ihre Anwendung integrieren, stellen Sie bitte Folgendes sicher:

| Prüfpunkt | Notwendigkeit | Prüfmethode | Compliance-Empfehlung |

|---|---|---|---|

| Altersverifizierung der Nutzer | Erforderlich | Verifizierung bei Registrierung | 18+ Beschränkung |

| Bestätigung der Bildquelle | Erforderlich | Upload-Vereinbarung | Nutzer zur Bestätigung des Urheberrechts auffordern |

| Einschränkung der Nutzungsszenarien | Empfohlen | Funktionsdesign | Eindeutige Information über Nutzungsbeschränkungen |

| Fehlerbehandlungsmechanismus | Erforderlich | Code-Implementierung | Benutzerfreundliche Hinweise |

| Inhaltsmoderationsprozess | Empfohlen | Backend-System | Manueller Überprüfungsmechanismus |

Best Practices für Benutzerhinweise

Um Verwirrung bei den Nutzern zu vermeiden, empfehlen wir, die folgenden Hinweise in Ihre Anwendung aufzunehmen:

Upload-Hinweis:

Hinweis: Zum Schutz von Minderjährigen können Bilder, die Kinder darstellen, nicht bearbeitet werden.

Bitte stellen Sie sicher, dass alle Personen auf den hochgeladenen Bildern Erwachsene sind.

Fehlermeldung:

Entschuldigung, dieses Bild kann nicht verarbeitet werden.

Grund: Das System hat erkannt, dass das Bild möglicherweise Darstellungen von Minderjährigen enthält.

Empfehlung: Bitte verwenden Sie Bilder, die ausschließlich Erwachsene zeigen, oder entfernen Sie die Teile mit Minderjährigen und versuchen Sie es erneut.

Empfehlungen zum Anwendungsdesign

-

Eindeutige Nutzungsszenarien

- Stellen Sie in der Produktdokumentation klar, dass die Bearbeitung von Kinderfotos nicht unterstützt wird.

- Nehmen Sie entsprechende Klauseln in die Nutzungsbedingungen auf.

-

Optimierung der Benutzererfahrung

- Bieten Sie freundliche Fehlermeldungen an.

- Erklären Sie den Grund für die Einschränkung, anstatt nur einen Fehlercode anzuzeigen.

- Geben Sie praktikable Alternativvorschläge.

-

Vorbereitung der Compliance-Dokumentation

- Bewahren Sie Protokolle der API-Aufrufe auf.

- Dokumentieren Sie Fälle, in denen Sicherheitsfilter ausgelöst wurden.

- Etablieren Sie einen Meldemechanismus für außergewöhnliche Vorkommnisse.

💰 Kostenoptimierung: Für Projekte, die häufige Aufrufe der Bildbearbeitungs-API erfordern, empfiehlt sich die Nutzung über die Plattform APIYI (apiyi.com). Diese bietet flexible Abrechnungsmodelle und günstigere Preise, was ideal für kleine bis mittlere Teams sowie Einzelentwickler ist.

Häufig gestellte Fragen (FAQ)

Q1: Warum lösen Fotos von offensichtlich Erwachsenen IMAGE_SAFETY aus?

Nano Banana Pro verfolgt eine konservative Strategie bei der Altersbestimmung. Wenn das System keine ausreichende Sicherheit bei der Altersschätzung hat, stuft es das Bild standardmäßig als minderjährig ein, um die Sicherheit zu gewährleisten.

Mögliche Gründe für das Auslösen sind:

- Jugendliches Aussehen (z. B. "Babyface")

- Lichtverhältnisse oder Kamerawinkel, die die Bestimmung erschweren

- Cartoon- oder Anime-Filtereffekte

Wir empfehlen die Verwendung von Fotos, auf denen die Gesichtszüge klar erkennbar sind. Über die Plattform APIYI (apiyi.com) können Sie zudem detailliertere Informationen zur Fehlerdiagnose erhalten.

Q2: Kann der IMAGE_SAFETY-Fehler durch Anpassen von Parametern behoben werden?

Nein. Der Schutz von Kindern ist ein Kernsicherheitsmechanismus von Nano Banana Pro und gehört zu einer Schutzkategorie, die nicht angepasst werden kann.

Dies ist ein Industriestandard, der von Google in Zusammenarbeit mit Kinderschutzorganisationen entwickelt wurde. Weder API-Parameter noch Konfigurationen können diese Einschränkung umgehen. Dies ist kein Bug, sondern ein bewusstes Sicherheitsdesign.

Wenn Sie eine große Anzahl von Bildern verarbeiten müssen, empfehlen wir eine Vorabprüfung und die Nutzung des Testguthabens auf APIYI (apiyi.com), um die Konformität der Bilder zu verifizieren.

Q3: Wie kann ich beurteilen, ob ein Bild Sicherheitsbeschränkungen auslösen wird?

Wir empfehlen eine Vorabprüfung vor der eigentlichen Verarbeitung:

- Stellen Sie sicher, dass keine offensichtlichen Darstellungen von Minderjährigen im Bild sind.

- Vermeiden Sie Szenen wie Schulen oder Spielplätze, die typisch für Kinder sind.

- Testen Sie zuerst mit einer niedrig aufgelösten Vorschaversion.

- Etablieren Sie einen internen Überprüfungsprozess, um sensible Bilder auszusortieren.

Q4: Gibt es bei der CSAM-Erkennung Fehlalarme bei normalen Inhalten?

Die Hash-Matching-Technologie basiert auf bekannten CSAM-Datenbanken, die Fehlalarmrate ist extrem niedrig. Die KI-basierte Altersbestimmung kann jedoch zu Fehleinschätzungen führen.

Wenn Sie sicher sind, dass der Bildinhalt regelkonform ist, er aber dennoch abgelehnt wird, liegt dies wahrscheinlich an der konservativen Strategie der Altersbestimmung. Das System ist so konzipiert, dass es im Zweifelsfall eher normale Inhalte ablehnt, als eine potenzielle Darstellung von Minderjährigen zuzulassen.

Q5: Unterliegen Anime oder virtuelle Charaktere ebenfalls Einschränkungen?

Ja, die Schutzmechanismen von Nano Banana Pro gelten gleichermaßen für Anime, Illustrationen und virtuelle Charaktere.

Wenn ein virtueller Charakter als Minderjähriger dargestellt wird, löst dies ebenfalls die IMAGE_SAFETY-Beschränkung aus. Wir empfehlen, virtuelle Charaktere zu verwenden, die eindeutig erwachsen sind, oder Bearbeitungen zu vermeiden, die Personen betreffen.

Zusammenfassung und Empfehlungen

Die 5 wichtigsten Jugendschutzmechanismen von Nano Banana Pro spiegeln den hohen Stellenwert wider, den die KI-Branche der Kindersicherheit beimisst:

| Kernpunkt | Beschreibung |

|---|---|

| Grundprinzip | Safety by Design, Kindersicherheit hat oberste Priorität |

| Technische Architektur | Mehrschichtiger Schutz durch Hash-Erkennung + KI-Klassifikatoren + Inhaltsfilterung |

| Nicht umgehbar | Kindersicherheitsbeschränkungen können durch keinerlei Parameteranpassungen umgangen werden |

| Branchenstandards | In Zusammenarbeit mit Organisationen wie Thorn und NCMEC entwickelt |

| Compliance-Empfehlungen | Nutzer klar über Einschränkungen informieren und benutzerfreundliche Fehlermeldungen bereitstellen |

Handlungsempfehlungen

- Entwickler: Berücksichtigen Sie die Verarbeitungslogik für Sicherheitsbeschränkungen bereits im Anwendungsdesign.

- Produktmanager: Integrieren Sie Kindersicherheitsbeschränkungen in die Produktfunktionsplanung.

- Operations-Teams: Bereiten Sie Standardantworten für Nutzeranfragen vor.

Wir empfehlen, die verschiedenen Funktionen von Nano Banana Pro über APIYI (apiyi.com) schnell zu testen, um die tatsächlichen Sicherheitsgrenzen zu verstehen.

Referenzen:

-

Google AI Safety Policies: Offizielle Dokumentation zu Sicherheitsrichtlinien

- Link:

ai.google.dev/gemini-api/docs/safety-policies

- Link:

-

Thorn – Safety by Design: Initiative für Kindersicherheitstechnologie

- Link:

thorn.org/safety-by-design

- Link:

-

NCMEC Reports: Berichte des National Center for Missing & Exploited Children

- Link:

missingkids.org/gethelpnow/csam-reports

- Link:

📝 Autor: APIYI Team | 🌐 Technischer Austausch: apiyi.com

Dieser Artikel wurde vom APIYI-Technikteam zusammengestellt und veröffentlicht. Bei Fragen besuchen Sie bitte APIYI (apiyi.com) für technischen Support.