在使用 Nano Banana Pro 进行图像编辑时,遇到 IMAGE_SAFETY 错误 是很多开发者困惑的问题。本文将深度解析 Nano Banana Pro 的 5 大未成年人保护机制,帮助你理解为什么包含疑似未成年人的图片会被系统拒绝处理。

核心价值: 读完本文,你将全面了解 Nano Banana Pro 的儿童安全防护体系,理解 IMAGE_SAFETY 错误的触发机制,并掌握合规使用图像编辑 API 的最佳实践。

Nano Banana Pro 未成年人保护机制 核心要点

在深入技术细节之前,让我们先了解 Nano Banana Pro 儿童安全机制的核心架构。

| 保护层级 | 技术手段 | 防护目标 | 触发时机 |

|---|---|---|---|

| 第一层 | 哈希匹配检测 | 识别已知 CSAM 内容 | 图片上传时 |

| 第二层 | AI 分类器 | 识别 CSAE 寻求提示 | 请求解析时 |

| 第三层 | 内容安全过滤 | 阻止涉及未成年人的编辑 | 处理执行时 |

| 第四层 | 训练数据净化 | 从源头杜绝问题内容 | 模型训练时 |

| 第五层 | 发布前测试 | 确保儿童安全标准 | 版本发布时 |

Nano Banana Pro 儿童安全防护的核心原则

Nano Banana Pro 采用 Safety by Design 设计理念,这是 Google 与 Thorn、All Tech Is Human 等儿童保护组织合作制定的行业标准。

核心防护原则包括:

- 零容忍政策: 与儿童性虐待或剥削相关的内容始终被阻止,无法通过任何参数调整

- 主动识别: 系统主动检测可能涉及未成年人的内容,而非被动响应

- 多重验证: 多层级安全机制协同工作,确保无漏洞

- 持续更新: 安全模型持续迭代,应对新型威胁

🎯 技术建议: 在实际开发中,理解这些保护机制有助于设计更合规的应用流程。我们建议通过 API易 apiyi.com 平台进行 API 调用测试,该平台提供详细的错误码文档和技术支持。

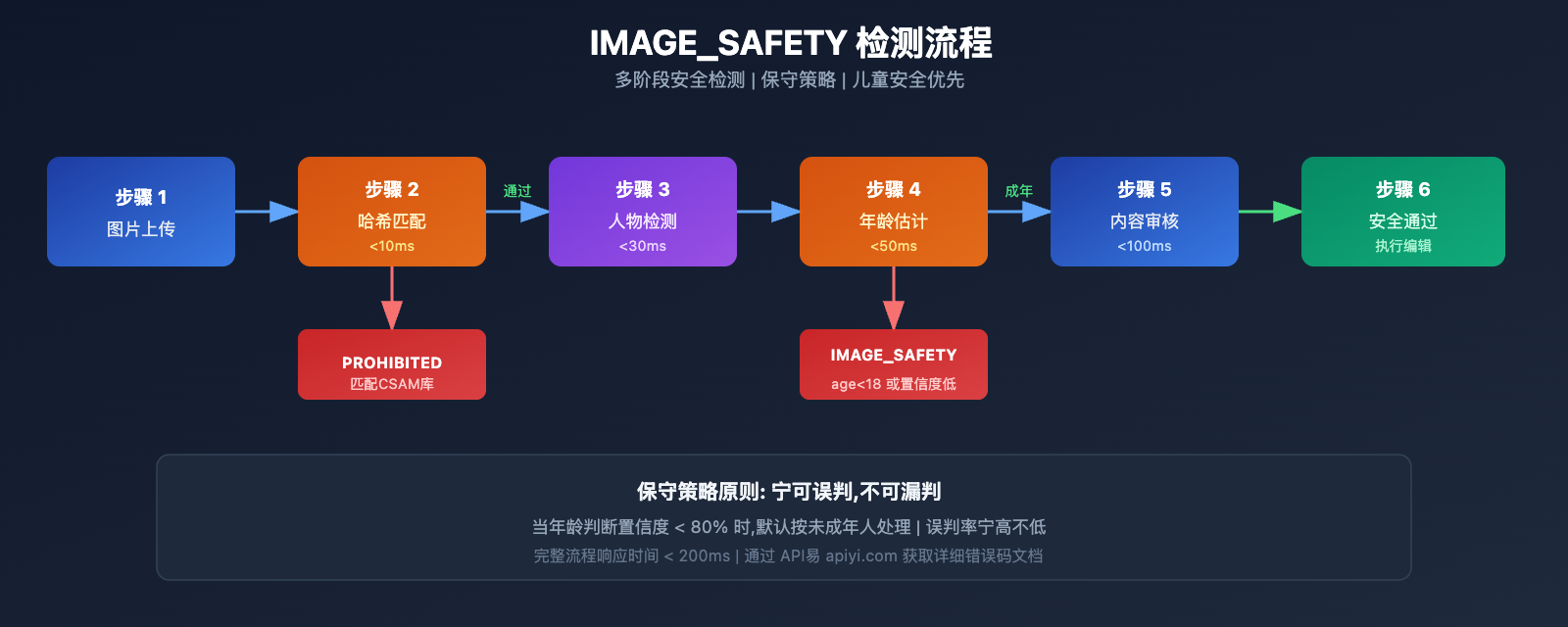

IMAGE_SAFETY 错误 深度解析

当 Nano Banana Pro 检测到图片中包含疑似未成年人时,会返回 IMAGE_SAFETY 错误。让我们深入分析这一机制。

IMAGE_SAFETY 错误触发条件详解

| 错误类型 | 触发条件 | 错误码 | 是否可规避 |

|---|---|---|---|

| PROHIBITED_CONTENT | 检测到已知 CSAM 哈希 | 400 | 否 |

| IMAGE_SAFETY | 图片包含疑似未成年人 | 400 | 否 |

| SAFETY_BLOCK | 提示词涉及未成年人相关内容 | 400 | 否 |

| CONTENT_FILTER | 组合触发多重安全规则 | 400 | 否 |

IMAGE_SAFETY 错误的技术原理

Nano Banana Pro 的 IMAGE_SAFETY 检测系统采用多模态分析技术:

1. 面部特征分析

系统会分析图片中人物的面部特征,评估其是否可能为未成年人:

# 伪代码示意: IMAGE_SAFETY 检测流程

def check_image_safety(image_data):

"""

Nano Banana Pro IMAGE_SAFETY 检测逻辑示意

注意: 这是简化的流程说明,实际实现更复杂

"""

# 第一步: 哈希匹配检测

if hash_match_csam_database(image_data):

return {"error": "PROHIBITED_CONTENT", "code": 400}

# 第二步: 人物检测

persons = detect_persons(image_data)

# 第三步: 年龄估计

for person in persons:

estimated_age = estimate_age(person)

confidence = get_confidence_score(person)

# 保守策略: 宁可误判也不漏判

if estimated_age < 18 or confidence < 0.8:

return {"error": "IMAGE_SAFETY", "code": 400}

return {"status": "safe", "code": 200}

2. 保守策略原则

为确保儿童安全,系统采用保守策略:

- 当年龄判断置信度不足时,默认按未成年人处理

- 任何可能涉及未成年人的场景都会被阻止

- 误判率宁高不低,保护儿童安全是第一优先级

常见 IMAGE_SAFETY 错误场景

根据开发者社区反馈,以下场景最容易触发 IMAGE_SAFETY 错误:

| 场景 | 触发原因 | 解决建议 |

|---|---|---|

| 家庭照片编辑 | 图中包含儿童 | 移除儿童后再编辑 |

| 校园场景处理 | 可能包含学生 | 使用无人物的背景 |

| 年轻面孔修图 | 年龄判断保守 | 确认被拍摄者已成年 |

| 卡通/动漫风格 | AI 误判为真实儿童 | 使用明显非真实的风格 |

| 历史照片修复 | 照片中有未成年人 | 选择仅含成年人的部分 |

💡 选择建议: 在设计图像编辑功能时,建议提前告知用户这些限制。通过 API易 apiyi.com 平台可以获取完整的错误码列表和处理建议。

CSAM 防护技术 完整解析

CSAM (Child Sexual Abuse Material) 防护是 Nano Banana Pro 安全体系的核心组成部分。

CSAM 防护技术架构

Nano Banana Pro 采用行业领先的 CSAM 防护技术:

1. 哈希匹配技术

# 示例: 哈希匹配检测逻辑

import hashlib

def compute_perceptual_hash(image):

"""

计算图片的感知哈希

用于匹配已知 CSAM 数据库

"""

# 调整图片大小和颜色

normalized = normalize_image(image)

# 计算感知哈希

phash = compute_phash(normalized)

return phash

def check_csam_database(image_hash, csam_database):

"""

检查是否匹配已知 CSAM

"""

# 模糊匹配,允许一定的变体

for known_hash in csam_database:

if hamming_distance(image_hash, known_hash) < threshold:

return True

return False

2. AI 分类器技术

AI 分类器专门训练用于识别:

- CSAE (Child Sexual Abuse or Exploitation) 寻求提示

- 试图绕过安全检测的变体请求

- 可疑的图文组合模式

3. 多层级防护协同

| 检测层级 | 技术实现 | 检测目标 | 响应时间 |

|---|---|---|---|

| 输入层 | 哈希匹配 | 已知违规内容 | < 10ms |

| 理解层 | AI 分类器 | 意图识别 | < 50ms |

| 执行层 | 内容过滤器 | 输出审核 | < 100ms |

| 监控层 | 行为分析 | 异常模式 | 实时 |

行业合作与标准

Nano Banana Pro 的 CSAM 防护体系与多个行业组织合作:

- Thorn: 反儿童剥削技术组织

- All Tech Is Human: 科技伦理倡议组织

- NCMEC: 美国失踪和被剥削儿童中心

- Tech Coalition: 科技公司反 CSAM 联盟

🔒 安全说明: NCMEC 报告显示,两年内已确认超过 7,000 例 GAI (生成式 AI) 相关 CSAM 案例。Nano Banana Pro 的严格防护正是应对这一严峻形势的必要措施。

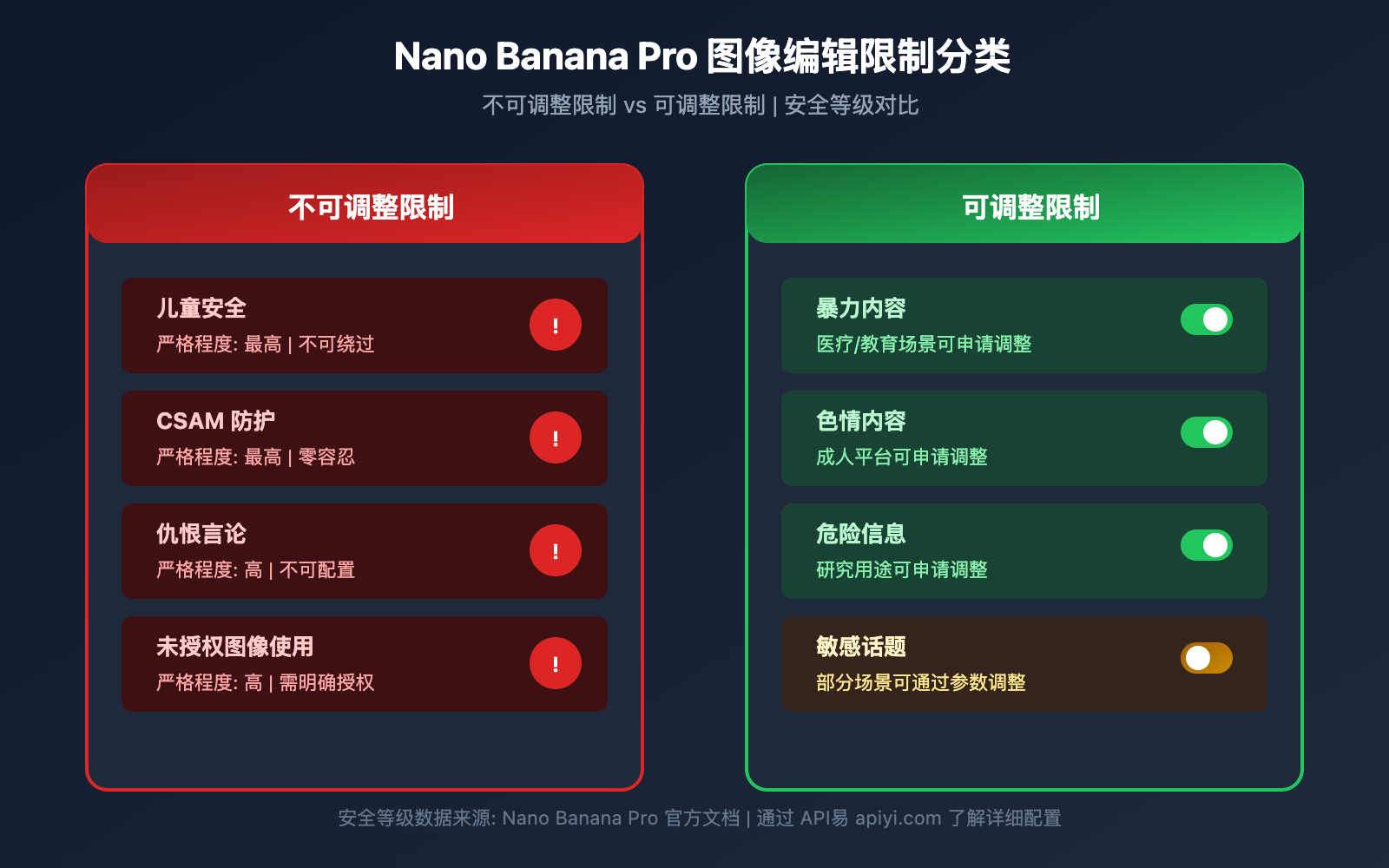

Nano Banana Pro 图像编辑限制 完整列表

除了未成年人保护,Nano Banana Pro 还有其他图像编辑限制。

图像编辑限制分类

| 限制类别 | 严格程度 | 是否可调整 | 适用场景 |

|---|---|---|---|

| 儿童安全 | 最高 | 否 | 所有场景 |

| CSAM 防护 | 最高 | 否 | 所有场景 |

| 暴力内容 | 高 | 部分可调 | 医疗、教育 |

| 色情内容 | 高 | 部分可调 | 成人平台 |

| 危险信息 | 中 | 部分可调 | 研究用途 |

| 仇恨言论 | 高 | 否 | 所有场景 |

不可调整的核心防护

Nano Banana Pro 明确规定,以下伤害类别始终被阻止,无法通过任何 API 参数或设置调整:

-

CSAM 相关内容

- 禁止生成任何与儿童性虐待相关的内容

- 禁止使用 AI 生成涉及未成年人的不当内容

- CSAM 输入会被标记为 PROHIBITED_CONTENT

-

未经同意的图像使用

- 禁止未经授权使用他人图像

- 禁止深度伪造他人面部

- 涉及真实人物时需有明确授权

-

儿童剥削内容

- 禁止任何形式的儿童剥削内容生成

- 包括但不限于性剥削、劳动剥削等

- 涵盖真实和虚构的未成年人形象

安全参数配置说明

虽然核心儿童安全防护不可调整,但 Nano Banana Pro 提供其他安全参数的配置选项:

from openai import OpenAI

# 初始化客户端

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 统一接口

)

# 图像编辑请求示例

response = client.images.edit(

model="nano-banana-pro",

image=open("input.png", "rb"),

prompt="修改背景颜色为蓝色",

# 安全参数 (注意: 儿童安全相关不可调整)

safety_settings={

"harm_block_threshold": "BLOCK_MEDIUM_AND_ABOVE",

# 以下设置对儿童安全无效,始终最高级别

# "child_safety": 不可配置

}

)

查看完整的安全配置代码

"""

Nano Banana Pro 完整安全配置示例

演示可配置和不可配置的安全参数

"""

from openai import OpenAI

import base64

# 初始化客户端

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 统一接口

)

def safe_image_edit(image_path: str, prompt: str) -> dict:

"""

安全的图像编辑函数

包含完整的错误处理

"""

try:

# 读取图片

with open(image_path, "rb") as f:

image_data = f.read()

# 发送编辑请求

response = client.images.edit(

model="nano-banana-pro",

image=image_data,

prompt=prompt,

n=1,

size="1024x1024",

response_format="url"

)

return {

"success": True,

"url": response.data[0].url

}

except Exception as e:

error_message = str(e)

# 处理 IMAGE_SAFETY 错误

if "IMAGE_SAFETY" in error_message:

return {

"success": False,

"error": "IMAGE_SAFETY",

"message": "图片包含疑似未成年人,无法处理",

"suggestion": "请使用仅包含成年人的图片"

}

# 处理 PROHIBITED_CONTENT 错误

if "PROHIBITED_CONTENT" in error_message:

return {

"success": False,

"error": "PROHIBITED_CONTENT",

"message": "检测到违禁内容",

"suggestion": "请检查图片内容是否合规"

}

# 其他错误

return {

"success": False,

"error": "UNKNOWN",

"message": error_message

}

# 使用示例

result = safe_image_edit("photo.jpg", "将背景改为海滩")

if result["success"]:

print(f"编辑成功: {result['url']}")

else:

print(f"编辑失败: {result['message']}")

print(f"建议: {result.get('suggestion', '请重试')}")

🚀 快速开始: 推荐使用 API易 apiyi.com 平台快速体验 Nano Banana Pro。该平台提供开箱即用的 API 接口,无需复杂配置,并有完善的错误处理文档。

Nano Banana Pro 合规使用 最佳实践

了解了安全机制后,让我们学习如何合规使用 Nano Banana Pro。

开发前检查清单

在集成 Nano Banana Pro 到应用之前,请确认以下事项:

| 检查项 | 必要性 | 检查方法 | 合规建议 |

|---|---|---|---|

| 用户年龄验证 | 必须 | 注册时验证 | 18+ 限制 |

| 图片来源确认 | 必须 | 上传协议 | 要求用户确认版权 |

| 使用场景限定 | 建议 | 功能设计 | 明确告知用途限制 |

| 错误处理机制 | 必须 | 代码实现 | 友好提示用户 |

| 内容审核流程 | 建议 | 后台系统 | 人工复核机制 |

用户提示最佳实践

为避免用户困惑,建议在应用中添加以下提示:

上传提示:

温馨提示: 为保护未成年人安全,包含儿童形象的图片将无法进行编辑处理。

请确保上传的图片中所有人物均为成年人。

错误提示:

抱歉,该图片无法处理。

原因: 系统检测到图片可能包含未成年人形象。

建议: 请使用仅包含成年人的图片,或移除图片中的未成年人部分后重试。

应用设计建议

-

明确使用场景

- 在产品文档中说明不支持处理儿童照片

- 在用户协议中包含相关条款

-

优化用户体验

- 提供友好的错误提示

- 解释限制原因而非仅显示错误码

- 给出可行的替代建议

-

合规文档准备

- 保留 API 调用日志

- 记录安全过滤触发情况

- 建立异常情况上报机制

💰 成本优化: 对于需要频繁调用图像编辑 API 的项目,可以考虑通过 API易 apiyi.com 平台调用,该平台提供灵活的计费方式和更优惠的价格,适合中小团队和个人开发者。

常见问题

Q1: 为什么明显是成年人的照片也触发 IMAGE_SAFETY?

Nano Banana Pro 采用保守策略进行年龄判断。当系统对年龄判断置信度不足时,会默认按未成年人处理以确保安全。

可能触发的原因包括:

- 面部特征年轻化 (如娃娃脸)

- 照片光线或角度导致判断不准

- 卡通或动漫风格的滤镜效果

建议使用清晰展示面部特征的照片。通过 API易 apiyi.com 平台可以获取更详细的错误诊断信息。

Q2: IMAGE_SAFETY 错误能通过调整参数解决吗?

不能。儿童安全相关的防护是 Nano Banana Pro 的核心安全机制,属于不可调整的保护类别。

这是 Google 与儿童保护组织合作制定的行业标准,任何 API 参数或配置都无法绑过此限制。这不是 bug,而是有意为之的安全设计。

如需处理大量图片,建议先进行预筛选,通过 API易 apiyi.com 平台的测试额度验证图片合规性。

Q3: 如何判断图片是否会触发安全限制?

建议在正式处理前进行预检测:

- 确认图片中无明显的未成年人形象

- 避免使用校园、游乐场等儿童常见场景

- 使用低分辨率预览版本先测试

- 建立内部审核流程筛选敏感图片

Q4: CSAM 检测会误报正常内容吗?

哈希匹配技术针对的是已知 CSAM 数据库,误报率极低。但 AI 年龄判断可能存在误判。

如果确信图片内容合规但仍被拒绝,可能是年龄判断的保守策略导致。系统设计宁可误拒正常内容,也不放过任何可能涉及未成年人的情况。

Q5: 使用动漫或虚拟角色会受限制吗?

是的,Nano Banana Pro 的保护机制同样适用于动漫、插画和虚拟角色。

如果虚拟角色呈现为未成年人形象,同样会触发 IMAGE_SAFETY 限制。建议使用明显成年的虚拟角色形象,或避免涉及人物的编辑操作。

总结与建议

Nano Banana Pro 的 5 大未成年人保护机制体现了 AI 行业对儿童安全的高度重视:

| 关键点 | 说明 |

|---|---|

| 核心原则 | Safety by Design,儿童安全优先于一切 |

| 技术架构 | 哈希检测 + AI 分类器 + 内容过滤多层防护 |

| 不可绑过 | 儿童安全限制无法通过任何参数调整 |

| 行业标准 | 与 Thorn、NCMEC 等组织合作制定 |

| 合规建议 | 明确告知用户限制,提供友好错误提示 |

行动建议

- 开发者: 在应用设计中预留安全限制的处理逻辑

- 产品经理: 将儿童安全限制纳入产品功能规划

- 运营人员: 准备用户咨询的标准答复话术

推荐通过 API易 apiyi.com 快速测试 Nano Banana Pro 的各项功能,了解实际的安全边界。

参考资料:

-

Google AI Safety Policies: 官方安全政策文档

- 链接:

ai.google.dev/gemini-api/docs/safety-policies

- 链接:

-

Thorn – Safety by Design: 儿童安全技术倡议

- 链接:

thorn.org/safety-by-design

- 链接:

-

NCMEC Reports: 失踪和被剥削儿童中心报告

- 链接:

missingkids.org/gethelpnow/csam-reports

- 链接:

📝 作者: APIYI Team | 🌐 技术交流: apiyi.com

本文由 APIYI 技术团队整理发布。如有疑问,欢迎访问 API易 apiyi.com 获取技术支持。